Sprache und Reden sind die Art und Weise, wie wir unsere inneren Gedanken ausdrücken. Aber Neurowissenschaftler haben die Notwendigkeit hörbarer Sprache einfach umgangen, zumindest im Labor. Stattdessen zapften sie direkt die biologische Maschine an, die Sprache und Ideen erzeugt: das Gehirn.

Mithilfe von Gehirnscans und einer kräftigen Dosis maschinellen Lernens entwickelte ein Team der University of Texas in Austin einen „Sprachdecoder“, der das Wesentliche dessen erfasst, was eine Person allein auf der Grundlage ihrer Gehirnaktivierungsmuster hört. Weit entfernt von einem One-Trick-Pony kann der Decoder auch imaginäre Sprache übersetzen und mithilfe neuronaler Aktivität sogar beschreibende Untertitel für Stummfilme generieren.

Hier ist der Kicker: Die Methode erfordert keine Operation. Anstatt sich auf implantierte Elektroden zu verlassen, die elektrische Ausbrüche direkt von Neuronen abhören, verwendet die Neurotechnologie die funktionelle Magnetresonanztomographie (fMRI), ein völlig nicht-invasives Verfahren, um Gehirnkarten zu erstellen, die der Sprache entsprechen.

Um es klar zu sagen, die Technologie ist kein Gedankenlesen. In jedem Fall erzeugt der Decoder Paraphrasen, die die allgemeine Idee eines Satzes oder Absatzes erfassen. Es wiederholt nicht jedes einzelne Wort. Doch das ist auch die Stärke des Decoders.

„Wir glauben, dass der Decoder etwas Tieferes als Sprachen darstellt“, sagte der Hauptautor der Studie, Dr. Alexander Huth, in einer Pressekonferenz. „Wir können die Gesamtidee wiederherstellen … und sehen, wie sich die Idee entwickelt, selbst wenn die genauen Worte verloren gehen.“

Die Studie, erschienen diese Woche in Nature Neuroscience, stellt einen starken ersten Schub bei der nicht-invasiven Behandlung dar Gehirn-Maschine-Schnittstellen für die Dekodierung von Sprache – ein notorisch schwieriges Problem. Mit der Weiterentwicklung der Technologie könnte die Technologie denen helfen, die die Fähigkeit zu sprechen verloren haben, ihre Fähigkeit zur Kommunikation mit der Außenwelt wiederzuerlangen.

Die Arbeit eröffnet auch neue Wege, um zu lernen, wie Sprache im Gehirn kodiert wird, und für KI-Wissenschaftler, um in die „Black Box“ von maschinellen Lernmodellen einzutauchen, die Sprache und Sprache verarbeiten.

„Es hat lange gedauert … wir waren irgendwie schockiert, dass das so gut funktioniert hat“, sagte Huth.

Dekodiersprache

Die Übersetzung von Gehirnaktivität in Sprache ist nicht neu. Eine frühere Studie verwendeten Elektroden, die direkt im Gehirn von Patienten mit Lähmungen platziert wurden. Durch das Abhören des elektrischen Geschwätzes der Neuronen konnte das Team die vollständigen Worte des Patienten rekonstruieren.

Huth entschied sich für einen alternativen, wenn auch gewagten Weg. Anstatt auf die Neurochirurgie zu setzen, entschied er sich für einen nicht-invasiven Ansatz: fMRT.

„Die Erwartung unter Neurowissenschaftlern im Allgemeinen, dass man so etwas mit fMRT machen kann, ist ziemlich gering“, sagt Huth.

Es gibt viele Gründe. Im Gegensatz zu Implantaten, die direkt in die neurale Aktivität eingreifen, misst die fMRT, wie sich der Sauerstoffgehalt im Blut verändert. Dies wird als BOLD-Signal bezeichnet. Da aktivere Gehirnregionen mehr Sauerstoff benötigen, fungieren BOLD-Antworten als zuverlässiger Proxy für neurale Aktivität. Aber es bringt Probleme mit sich. Die Signale sind im Vergleich zum Messen elektrischer Bursts träge und die Signale können verrauscht sein.

Dennoch hat fMRI einen enormen Vorteil im Vergleich zu Gehirnimplantaten: Es kann das gesamte Gehirn mit hoher Auflösung überwachen. Im Vergleich zum Sammeln von Daten aus einem Nugget in einer Region bietet es eine Vogelperspektive auf übergeordnete kognitive Funktionen – einschließlich der Sprache.

Bei der Dekodierung von Sprache haben die meisten früheren Studien den motorischen Kortex angezapft, einen Bereich, der steuert, wie sich Mund und Kehlkopf bewegen, um Sprache zu erzeugen, oder mehr „Oberflächenebene“ in der Sprachverarbeitung für die Artikulation. Huths Team entschied sich, eine Abstraktion nach oben zu gehen: in den Bereich der Gedanken und Ideen.

In das Unbekannte

Das Team erkannte, dass es von Anfang an zwei Dinge brauchte. Zum einen ein Datensatz mit hochwertigen Gehirnscans, die zum Trainieren des Decoders verwendet werden. Zweitens ein Framework für maschinelles Lernen zur Verarbeitung der Daten.

Um die Brain-Map-Datenbank zu erstellen, wurde das Gehirn von sieben Freiwilligen wiederholt gescannt, während sie Podcast-Geschichten hörten, während ihre neuronale Aktivität in einem MRT-Gerät gemessen wurde. Es macht niemandem Spaß, sich in einen riesigen, lauten Magneten zu legen, und das Team achtete darauf, die Freiwilligen interessiert und aufmerksam zu halten, da die Aufmerksamkeit beim Entschlüsseln eine Rolle spielt.

Für jede Person wurde der resultierende riesige Datensatz in ein Framework eingespeist, das auf maschinellem Lernen basiert. Dank der jüngsten Explosion von Modellen für maschinelles Lernen, die bei der Verarbeitung natürlicher Sprache helfen, konnte das Team diese Ressourcen nutzen und den Decoder problemlos bauen.

Es hat mehrere Komponenten. Das erste ist ein Codierungsmodell, das das ursprüngliche GPT verwendet, den Vorgänger des äußerst beliebten ChatGPT. Das Modell nimmt jedes Wort und sagt voraus, wie das Gehirn reagieren wird. Hier optimierte das Team GPT anhand von insgesamt über 200 Millionen Wörtern aus Reddit-Kommentaren und Podcasts.

Dieser zweite Teil verwendet eine beliebte Technik des maschinellen Lernens namens Bayes'sche Dekodierung. Der Algorithmus errät das nächste Wort basierend auf einer vorherigen Sequenz und verwendet das erratene Wort, um die tatsächliche Reaktion des Gehirns zu überprüfen.

Zum Beispiel hatte eine Podcast-Episode „Mein Vater braucht es nicht …“ als Storyline. Wenn es als Eingabeaufforderung in den Decoder eingespeist wurde, gab es mögliche Antworten: „viel“, „richtig“, „seit“ und so weiter. Der Vergleich der vorhergesagten Gehirnaktivität mit jedem Wort mit der aus dem tatsächlichen Wort generierten half dem Decoder, die Gehirnaktivitätsmuster jeder Person zu verfeinern und Fehler zu korrigieren.

Nach dem Wiederholen des Vorgangs mit den am besten vorhergesagten Wörtern folgt der Dekodierungsaspekt des Programms

lernte schließlich den einzigartigen „neuronalen Fingerabdruck“ jeder Person, wie sie Sprache verarbeitet.

Ein Neuro-Übersetzer

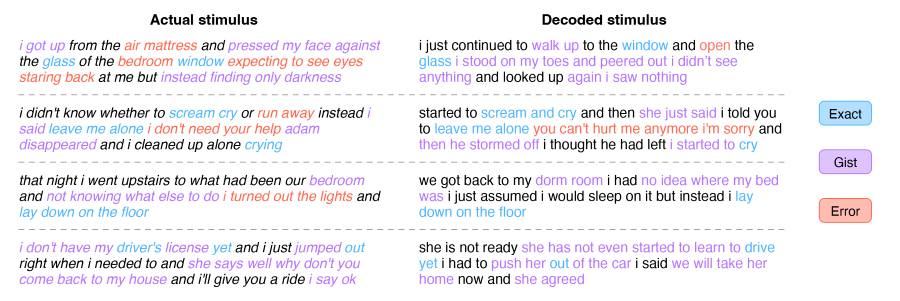

Als Machbarkeitsnachweis stellte das Team die entschlüsselten Antworten dem eigentlichen Text der Geschichte gegenüber.

Es kam überraschend nahe, aber nur für das allgemeine Wesentliche. Zum Beispiel wurde eine Storyline, „wir fangen an, Geschichten über unser Leben auszutauschen, wir kommen beide aus dem hohen Norden“, entschlüsselt als „wir begannen, über unsere Erfahrungen in der Gegend zu sprechen, in der er geboren wurde, ich war aus dem Norden.“

Diese Paraphrasierung sei zu erwarten, erklärte Huth. Da fMRI ziemlich laut und träge ist, ist es fast unmöglich, jedes Wort zu erfassen und zu entschlüsseln. Der Decoder wird mit einem Wirrwarr von Wörtern gefüttert und muss ihre Bedeutungen mithilfe von Merkmalen wie Wendungen entwirren.

Im Gegensatz dazu sind Ideen dauerhafter und ändern sich relativ langsam. Da fMRI bei der Messung der neuronalen Aktivität eine Verzögerung aufweist, erfasst es abstrakte Konzepte und Gedanken besser als bestimmte Wörter.

Dieser High-Level-Ansatz hat Vorteile. Obwohl es ihm an Wiedergabetreue mangelt, erfasst der Decoder ein höheres Maß an Sprachdarstellung als frühere Versuche, einschließlich für Aufgaben, die nicht nur auf Sprache beschränkt sind. In einem Test sahen sich die Freiwilligen ohne Ton einen animierten Clip eines Mädchens an, das von Drachen angegriffen wurde. Allein durch Gehirnaktivität beschrieb der Decoder die Szene aus der Perspektive des Protagonisten als textbasierte Geschichte. Mit anderen Worten, der Decoder war in der Lage, visuelle Informationen direkt in eine Erzählung zu übersetzen, die auf einer in Gehirnaktivität codierten Darstellung von Sprache basiert.

In ähnlicher Weise rekonstruierte der Decoder auch einminütige Fantasiegeschichten der Freiwilligen.

Nach über einem Jahrzehnt Arbeit an der Technologie „war es schockierend und aufregend, als es endlich funktionierte“, sagte Huth.

Obwohl der Decoder nicht gerade Gedanken lesen kann, achtete das Team sorgfältig darauf, die geistige Privatsphäre zu prüfen. In einer Versuchsreihe stellten sie fest, dass der Decoder nur bei aktiver geistiger Beteiligung der Probanden funktionierte. Die Aufforderung an die Teilnehmer, in einer Reihenfolge von sieben zu zählen, verschiedene Tiere zu benennen oder im Geiste ihre eigenen Geschichten zu konstruieren, verschlechterte den Decoder schnell, sagte der Erstautor Jerry Tang. Mit anderen Worten, dem Decoder kann „bewusst widerstanden“ werden.

Die Technologie funktioniert vorerst nur nach monatelangen sorgfältigen Gehirnscans in einer laut brummenden Maschine, während sie völlig still liegt – kaum machbar für den klinischen Einsatz. Das Team arbeitet daran, die Technologie auf fNIRS (funktionelle Nahinfrarotspektroskopie) zu übertragen, die den Blutsauerstoffgehalt im Gehirn misst. Obwohl es eine niedrigere Auflösung als fMRI hat, ist fNIRS weitaus tragbarer, da die Haupthardware ein schwimmkappenähnliches Gerät ist, das problemlos unter einen Hoodie passt.

„Mit Optimierungen sollten wir in der Lage sein, das aktuelle Setup auf fNIRS-Wholesale zu übertragen“, sagte Huth.

Das Team plant auch die Verwendung neuerer Sprachmodelle, um die Genauigkeit des Decoders zu verbessern und möglicherweise verschiedene Sprachen zu überbrücken. Da Sprachen eine gemeinsame neuronale Repräsentation im Gehirn haben, könnte der Decoder theoretisch eine Sprache codieren und die neuronalen Signale verwenden, um sie in eine andere zu decodieren.

Es sei eine „spannende Zukunftsrichtung“, sagte Huth.

Bild-Kredit: Jerry Tang/Martha Morales/Die Universität von Texas in Austin

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoAiStream. Web3-Datenintelligenz. Wissen verstärkt. Hier zugreifen.

- Die Zukunft prägen mit Adryenn Ashley. Hier zugreifen.

- Quelle: https://singularityhub.com/2023/05/02/this-brain-activity-decoder-translates-ideas-into-text-using-only-scans/