See ÄNDERUNGSPROTOKOLL für die neuesten Funktionen und Fehlerbehebungen.

Sie haben wahrscheinlich schon einmal die Herausforderung erlebt, sich während eines Meetings Notizen zu machen und gleichzeitig zu versuchen, dem Gespräch Aufmerksamkeit zu schenken. Sie haben wahrscheinlich auch schon das Bedürfnis verspürt, etwas Gesagtes schnell auf Fakten zu überprüfen oder Informationen nachzuschlagen, um eine Frage zu beantworten, die gerade im Telefonat gestellt wurde. Oder vielleicht haben Sie ein Teammitglied, das immer zu spät zu Besprechungen kommt und von Ihnen erwartet, dass Sie ihm per Chat eine kurze Zusammenfassung schicken, um auf dem Laufenden zu bleiben.

Dann gibt es Zeiten, in denen andere in einer Sprache sprechen, die nicht Ihre Muttersprache ist, und Sie möchten gerne eine Live-Übersetzung dessen, was die Leute sagen, um sicherzustellen, dass Sie es richtig verstehen.

Und nachdem der Anruf beendet ist, möchten Sie normalerweise eine Zusammenfassung für Ihre Unterlagen erfassen oder diese an die Teilnehmer senden, mit einer Liste aller Aktionspunkte, Eigentümer und Fälligkeitstermine.

All dies und noch mehr ist jetzt mit unserer neuesten Beispiellösung, dem Live Meeting Assistant (LMA), möglich.

Schauen Sie sich die folgende Demo an, um zu sehen, wie es funktioniert.

In diesem Beitrag zeigen wir Ihnen, wie Sie LMA verwenden Amazon Transcribe, Amazonas Grundgestein und Wissensdatenbanken für Amazon Bedrock.

Lösungsüberblick

Die LMA-Beispiellösung erfasst Sprecheraudio und -metadaten von Ihrer browserbasierten Meeting-App (zum jetzigen Zeitpunkt werden Zoom und Chime unterstützt) oder nur Audio von jeder anderen browserbasierten Meeting-App, Softphone oder Audioquelle. Es verwendet Amazon Transcribe für die Sprachausgabe in Text, Knowledge Bases für Amazon Bedrock für kontextbezogene Abfragen der Dokumente und Wissensquellen Ihres Unternehmens sowie Amazon Bedrock-Modelle für anpassbare Transkriptionseinblicke und Zusammenfassungen.

Alles, was Sie brauchen, wird in unserem als Open Source bereitgestellt GitHub Repo. Die Bereitstellung in Ihrem AWS-Konto ist unkompliziert. Wenn Sie fertig sind, werden Sie sich fragen, wie Sie jemals ohne ausgekommen sind!

Im Folgenden sind einige der Dinge aufgeführt, die LMA tun kann:

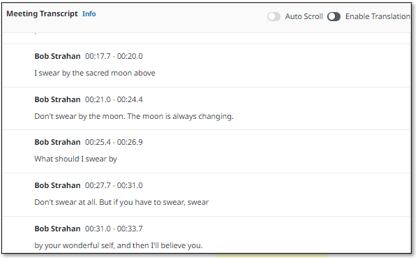

- Live-Transkription mit Sprecherzuordnung – LMA basiert auf Amazon Transcribe ASR-Modellen für eine geringe Latenz und hohe Genauigkeit bei der Sprachausgabe in Text. Sie können ihm bei Bedarf Markennamen und domänenspezifische Terminologie beibringen, indem Sie benutzerdefiniertes Vokabular und benutzerdefinierte Sprachmodellfunktionen in Amazon Transcribe verwenden.

- Live-Übersetzung – Es verwendet Amazon Translate, um optional jedes Segment der Konversation in die Sprache Ihrer Wahl aus einer Auswahl von 75 Sprachen übersetzt anzuzeigen.

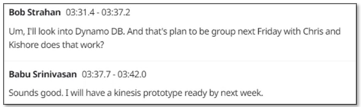

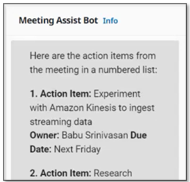

- Kontextbezogener Besprechungsassistent – Es nutzt Wissensdatenbanken für Amazon Bedrock, um Antworten aus Ihren vertrauenswürdigen Quellen bereitzustellen, wobei das Live-Transkript als Kontext für Faktenprüfungen und Folgefragen verwendet wird. Um den Assistenten zu aktivieren, sagen Sie einfach „Okay, Assistent“ und wählen Sie das aus FRAGEN SIE DEN ASSISTENTEN! Klicken Sie auf die Schaltfläche oder geben Sie Ihre eigene Frage in die Benutzeroberfläche ein.

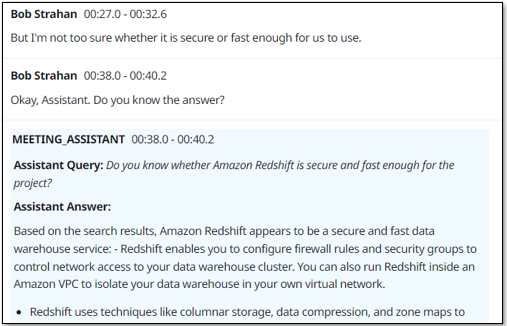

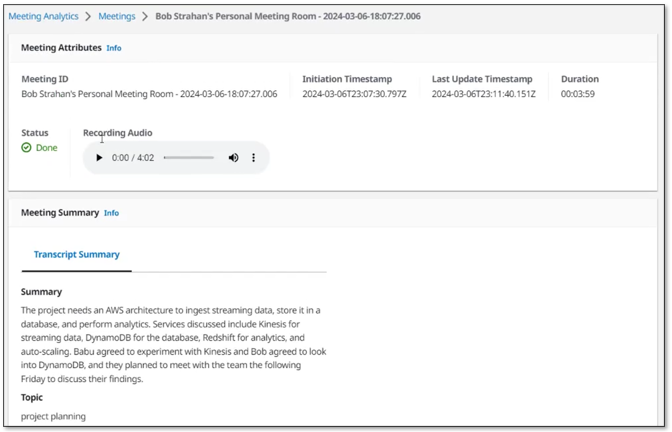

- Zusammenfassungen des Meetings auf Abruf – Mit einem Klick auf eine Schaltfläche auf der Benutzeroberfläche können Sie eine Zusammenfassung erstellen, die nützlich ist, wenn jemand zu spät kommt und nachgeholt werden muss. Die Zusammenfassungen werden aus dem Transkript von Amazon Bedrock generiert. LMA bietet außerdem Optionen zum Identifizieren des aktuellen Besprechungsthemas und zum Erstellen einer Liste von Aktionspunkten mit Eigentümern und Fälligkeitsterminen. Sie können auch Ihre eigenen benutzerdefinierten Eingabeaufforderungen und entsprechenden Optionen erstellen.

- Automatisierte Zusammenfassung und Einblicke – Wenn das Meeting beendet ist, führt LMA automatisch eine Reihe von LLM-Eingabeaufforderungen (Large Language Model) auf Amazon Bedrock aus, um das Meeting-Transkript zusammenzufassen und Erkenntnisse zu gewinnen. Sie können diese Eingabeaufforderungen auch anpassen.

- Besprechungsaufzeichnung – Der Ton wird (optional) für Sie gespeichert, sodass Sie wichtige Abschnitte des Meetings später noch einmal abspielen können.

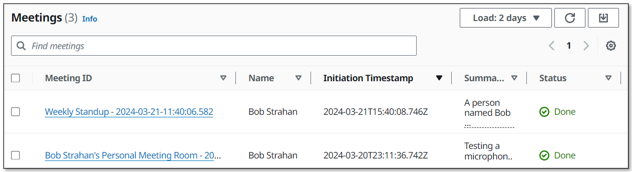

- Inventarliste der Sitzungen – LMA verfolgt alle Ihre Besprechungen in einer durchsuchbaren Liste.

- Die Browsererweiterung erfasst Audio- und Meeting-Metadaten aus beliebten Meeting-Apps – Die Browser-Erweiterung erfasst Meeting-Metadaten – den Meeting-Titel und die Namen der aktiven Redner – sowie Audio von Ihnen (Ihrem Mikrofon) und anderen (von der Browser-Registerkarte des Meetings). Zum jetzigen Zeitpunkt unterstützt LMA Chrome für die Browsererweiterung sowie Zoom und Chime für Meeting-Apps (Teams und WebEx folgen in Kürze). Eigenständige Meeting-Apps funktionieren nicht mit LMA – starten Sie Ihre Meetings stattdessen im Browser.

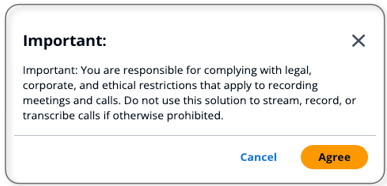

Sie sind für die Einhaltung gesetzlicher, unternehmensbezogener und ethischer Beschränkungen verantwortlich, die für die Aufzeichnung von Besprechungen und Anrufen gelten. Verwenden Sie diese Lösung nicht zum Streamen, Aufzeichnen oder Transkribieren von Anrufen, wenn dies anderweitig verboten ist.

Voraussetzungen:

Sie benötigen ein AWS-Konto und ein AWS Identity and Access Management and (IAM)-Rolle und Benutzer mit Berechtigungen zum Erstellen und Verwalten der erforderlichen Ressourcen und Komponenten für diese Anwendung. Wenn Sie kein AWS-Konto haben, lesen Sie Wie erstelle und aktiviere ich ein neues Amazon Web Services-Konto?

Sie benötigen außerdem eine bestehende Wissensdatenbank in Amazon Bedrock. Wenn Sie noch keins eingerichtet haben, lesen Sie Erstellen Sie eine Wissensbasis. Füllen Sie Ihre Wissensdatenbank mit Inhalten, um den kontextsensitiven Besprechungsassistenten von LMA zu unterstützen.

Schließlich verwendet LMA Amazon Bedrock LLMs für seine Funktionen zur Zusammenfassung von Besprechungen. Bevor Sie fortfahren, müssen Sie dies tun, sofern Sie dies noch nicht getan haben Anfrage Zugang zu den folgenden Amazon Bedrock-Modellen:

- Titan Embeddings G1 – Text

- Anthropic: Alle Claude-Modelle

Stellen Sie die Lösung mit AWS CloudFormation bereit

Wir haben vorgefertigte Produkte bereitgestellt AWS CloudFormation Vorlagen, die alles bereitstellen, was Sie in Ihrem AWS-Konto benötigen.

Wenn Sie Entwickler sind und die Lösung aus Code erstellen, bereitstellen oder veröffentlichen möchten, lesen Sie die Entwickler-README.

Führen Sie die folgenden Schritte aus, um den CloudFormation-Stack zu starten:

- Melden Sie sich bei der AWS-Managementkonsole.

- Auswählen Stack starten für Ihre gewünschte AWS-Region, um die AWS CloudFormation-Konsole zu öffnen und einen neuen Stack zu erstellen.

| Region | Stack starten |

|---|---|

| US-Ost (N. Virginia) | |

| USA Westen (Oregon) |

- Aussichten für Stapelname, verwenden Sie den Standardwert LMA.

- Aussichten für E-Mail-Adresse des Administrators, verwenden Sie eine gültige E-Mail-Adresse – Ihr temporäres Passwort wird während der Bereitstellung per E-Mail an diese Adresse gesendet.

- Aussichten für E-Mail-Domäne des autorisierten Kontos, verwenden Sie den Domänennamenteil Ihrer Unternehmens-E-Mail-Adresse, um Benutzern mit E-Mail-Adressen in derselben Domäne die Erstellung ihrer eigenen neuen UI-Konten zu ermöglichen, oder lassen Sie das Feld leer, um zu verhindern, dass Benutzer direkt ihre eigenen Konten erstellen. Sie können mehrere Domänen als durch Kommas getrennte Liste eingeben.

- Aussichten für MeetingAssistService, wählen

BEDROCK_KNOWLEDGE_BASE(die einzige verfügbare Option zum Zeitpunkt dieses Schreibens). - Aussichten für Meeting Assist Bedrock-Wissensdatenbank-ID (vorhanden), geben Sie Ihre vorhandene Wissensdatenbank-ID ein (z. B.

JSXXXXX3D8). Sie können es von der Amazon Bedrock-Konsole kopieren.

- Verwenden Sie für alle anderen Parameter die Standardwerte.

Wenn Sie die Einstellungen später anpassen möchten, um beispielsweise Ihre eigenen hinzuzufügen AWS Lambda Funktionen nutzen, benutzerdefinierte Vokabulare und Sprachmodelle verwenden, um die Genauigkeit zu verbessern, die Schwärzung persönlich identifizierbarer Informationen (PII) ermöglichen und vieles mehr. Sie können den Stapel für diese Parameter aktualisieren.

- Aktivieren Sie die Kontrollkästchen für die Bestätigung und wählen Sie dann Stapel erstellen.

Der Hauptstapel von CloudFormation verwendet verschachtelte Stapel, um die folgenden Ressourcen in Ihrem AWS-Konto zu erstellen:

- Amazon Simple Storage-Service (Amazon S3) Buckets zur Aufnahme von Build-Artefakten und Anrufaufzeichnungen

- An AWS Fargate Aufgabe mit einem Anwendungs-Load-Balancer Bereitstellung eines WebSocket-Servers, auf dem Code ausgeführt wird, um Stereo-Audiostreams zu konsumieren und an Amazon Transcribe weiterzuleiten, Transkriptionssegmente zu veröffentlichen Amazon Kinesis-Datenströme, und erstellen und speichern Sie Stereo-Anrufaufzeichnungen

- Ein Kinesis-Datenstrom zur Weiterleitung von Anrufereignissen und Transkriptionssegmenten an die Anreicherungsverarbeitungsfunktion

- LMA-Ressourcen, einschließlich der QnABot auf AWS-Lösung Stapel, der mit interagiert Amazon OpenSearch-Dienst und Amazonas-Grundgestein

- Das AWS AppSync API, die einen GraphQL-Endpunkt zur Unterstützung von Abfragen und Aktualisierungen in Echtzeit bereitstellt

- Website-Komponenten, einschließlich eines S3-Buckets, Amazon CloudFront Verteilung und Amazon Cognito Benutzerpool

- Eine herunterladbare vorkonfigurierte Browser-Erweiterungsanwendung für Chrome-Browser

- Andere unterstützende Ressourcen, einschließlich IAM-Rollen und -Richtlinien (unter Verwendung von Best Practices für die geringste Berechtigung), Amazon Virtual Private Cloud (Amazon VPC)-Ressourcen, Amazon EventBridge Veranstaltungsregeln und Amazon CloudWatch Protokollgruppen.

Die Bereitstellung der Stacks dauert etwa 35–40 Minuten. Der Hauptstapelstatus wird angezeigt CREATE_COMPLETE wenn alles bereitgestellt ist.

Lege ein Passwort fest

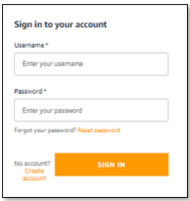

Nachdem Sie den Stack bereitgestellt haben, öffnen Sie die LMA-Webbenutzeroberfläche und legen Sie Ihr Passwort fest, indem Sie die folgenden Schritte ausführen:

- Öffnen Sie die E-Mail, die Sie erhalten haben, an die von Ihnen angegebene E-Mail-Adresse mit dem Betreff „Willkommen beim Live Meeting Assistant!“

- Öffnen Sie Ihren Webbrowser mit der in der E-Mail angezeigten URL. Sie werden zur Anmeldeseite weitergeleitet.

- Die E-Mail enthält ein generiertes temporäres Passwort, mit dem Sie sich anmelden und Ihr eigenes Passwort erstellen können. Ihr Benutzername ist Ihre E-Mail-Adresse.

- Legen Sie ein neues Passwort fest.

Ihr neues Passwort muss mindestens acht Zeichen lang sein und Groß- und Kleinbuchstaben sowie Zahlen und Sonderzeichen enthalten.

- Befolgen Sie die Anweisungen, um Ihre E-Mail-Adresse zu bestätigen, oder wählen Sie überspringen um es später zu machen.

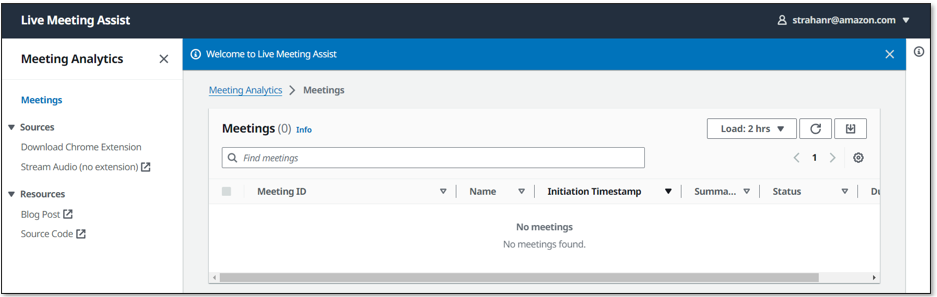

Sie sind jetzt bei LMA angemeldet.

Sie haben auch eine ähnliche E-Mail mit dem Betreff „QnABot-Anmeldebestätigungscode“ erhalten. Diese E-Mail enthält ein generiertes temporäres Passwort, mit dem Sie sich anmelden und im QnABot-Designer Ihr eigenes Passwort erstellen können. Sie verwenden QnABot Designer nur, wenn Sie LMA-Optionen und Eingabeaufforderungen anpassen möchten. Ihr Benutzername für QnABot ist Admin. Sie können jetzt Ihr permanentes QnABot-Administratorkennwort festlegen oder diese E-Mail sicher aufbewahren, falls Sie die Dinge später anpassen möchten.

Laden Sie die Chrome-Browsererweiterung herunter und installieren Sie sie

Für das beste Meeting-Streaming-Erlebnis installieren Sie das LMA-Browser-Plugin (derzeit für Chrome verfügbar):

- Auswählen

Laden Sie die Chrome-Erweiterung herunter um die ZIP-Datei mit der Browsererweiterung herunterzuladen (

lma-chrome-extension.zip).

- Wählen Sie (Rechtsklick) und erweitern Sie die ZIP-Datei (

lma-chrome-extension.zip), um einen lokalen Ordner mit dem Namen zu erstellenlma-chrome-extension. - Öffnen Sie Chrome und geben Sie den Link ein

chrome://extensionsin die Adressleiste.

- Ermöglichen Entwicklermodus.

- Auswählen

Laden Sie unverpackt, navigiere zum

lma-chrome-extensionOrdner (den Sie aus dem Download entpackt haben) und wählen Sie Auswählen. Dadurch wird Ihre Erweiterung geladen. - Hängen Sie die neue LMA-Erweiterung für einen einfachen Zugriff an die Browser-Symbolleiste an – Sie werden sie häufig zum Streamen Ihrer Meetings verwenden!

Beginnen Sie mit der Verwendung von LMA

LMA bietet zwei Streaming-Optionen:

- Chrome-Browsererweiterung – Verwenden Sie dies, um Audio- und Sprechermetadaten aus Ihrer Meeting-Browser-App zu streamen. Derzeit funktioniert es mit Zoom und Chime, wir hoffen jedoch, weitere Meeting-Apps hinzufügen zu können.

- Registerkarte „LMA-Stream-Audio“. – Verwenden Sie dies, um Audio von Ihrem Mikrofon und einer beliebigen Chrome-Browser-basierten Meeting-App, einem Softphone oder einer Audioanwendung zu streamen.

Wie Sie beide Möglichkeiten nutzen, zeigen wir Ihnen in den folgenden Abschnitten.

Verwenden Sie die Chrome-Browsererweiterung, um einen Zoom-Anruf zu streamen

Führen Sie die folgenden Schritte aus, um die Browsererweiterung zu verwenden:

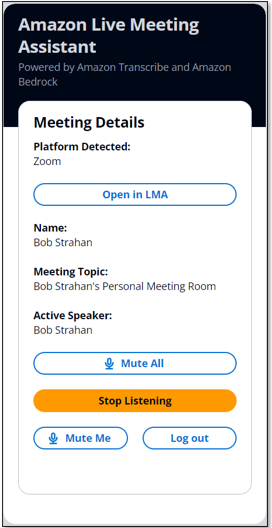

- Öffnen Sie die LMA-Erweiterung und melden Sie sich mit Ihren LMA-Zugangsdaten an.

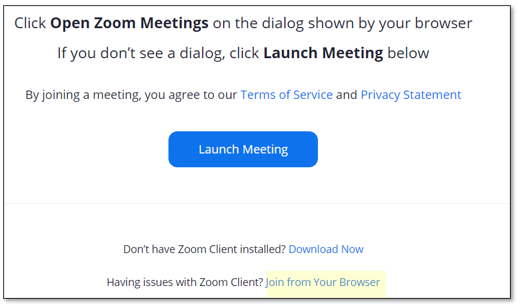

- Nehmen Sie in Ihrem Webbrowser an einem Zoom-Meeting teil oder starten Sie es (verwenden Sie nicht den separaten Zoom-Client).

Wenn Sie die Zoom-Meeting-Seite bereits geladen haben, laden Sie sie erneut.

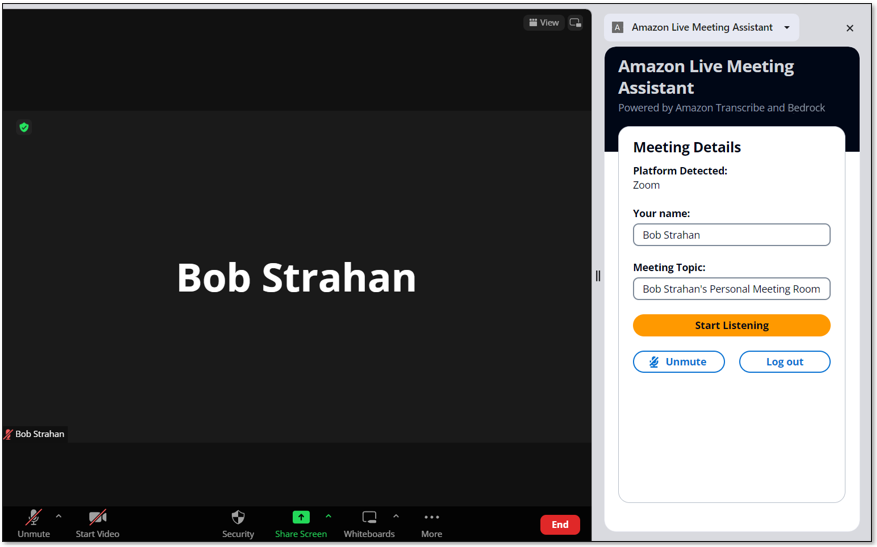

Die LMA-Erweiterung erkennt automatisch, dass Zoom im Browser-Tab ausgeführt wird, und trägt Ihren Namen und den Besprechungsnamen ein.

- Sagen Sie den anderen Teilnehmern des Anrufs, dass Sie mit der Aufzeichnung des Anrufs mit LMA beginnen werden, und holen Sie deren Erlaubnis ein. Fahren Sie nicht fort, wenn Teilnehmer Einwände erheben.

- Auswählen

Beginne zuzuhören.

- Lesen und akzeptieren Sie den Haftungsausschluss und wählen Sie Erlauben um den Browser-Tab freizugeben.

Die LMA-Erweiterung erkennt automatisch den aktiven Sprecher des Anrufs und zeigt ihn an. Wenn Sie alleine an der Besprechung teilnehmen, laden Sie einige Freunde zur Teilnahme ein und achten Sie darauf, dass die Namen, mit denen sie dem Anruf beigetreten sind, in der Erweiterung angezeigt werden, wenn sie sprechen, und ihren Worten im LMA-Transkript zugeordnet werden.

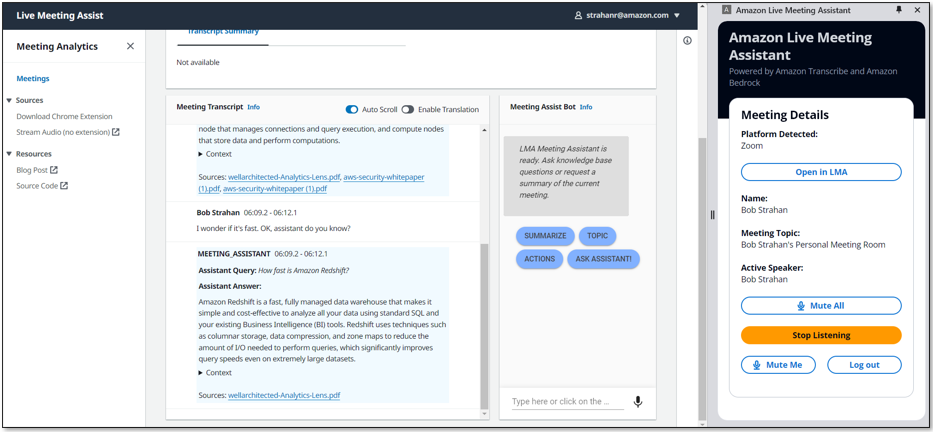

- Auswählen In LMA öffnen um Ihr Live-Transkript in einem neuen Tab anzuzeigen.

- Wählen Sie Ihre bevorzugte Transkriptsprache und interagieren Sie mit dem Besprechungsassistenten, indem Sie die Aktivierungsphrase „OK Assistent!“ verwenden. oder der Meeting-Assist-Bot Feld.

Das FRAGEN SIE DEN ASSISTENTEN Mit der Schaltfläche wird der Besprechungsassistentendienst (Wissensdatenbank von Amazon Bedrock) gebeten, eine gute Antwort basierend auf dem Protokoll der letzten Interaktionen in der Besprechung vorzuschlagen. Ihr Kilometerstand kann variieren, also experimentieren Sie!

- Wenn Sie fertig sind, wählen Sie Stoppen Sie das Streaming um das Treffen in LMA zu beenden.

Innerhalb weniger Sekunden werden die automatischen Zusammenfassungen zum Ende des Meetings angezeigt und die Audioaufzeichnung ist verfügbar. Sie können den Bot auch nach Beendigung des Anrufs weiter nutzen.

Verwenden Sie die Registerkarte „Audio streamen“ der LMA-Benutzeroberfläche, um von Ihrem Mikrofon und einer beliebigen browserbasierten Audioanwendung zu streamen

Die Browsererweiterung ist die bequemste Möglichkeit, Metadaten und Audio von unterstützten Meeting-Web-Apps zu streamen. Sie können LMA jedoch auch verwenden, um einfach nur den Ton von einem beliebigen browserbasierten Softphone, einer Meeting-App oder einer anderen Audioquelle zu streamen, die in Ihrem Chrome-Browser abgespielt wird Audio streamen Registerkarte, die in die LMA-Benutzeroberfläche integriert ist.

- Öffnen Sie eine beliebige Audioquelle in einem Browser-Tab.

Dies könnte beispielsweise ein Softphone sein (z Google Voice), einer anderen Meeting-App oder zu Demozwecken können Sie einfach eine lokale Audioaufnahme oder ein YouTube-Video in Ihrem Browser abspielen, um einen anderen Meeting-Teilnehmer zu emulieren. Wenn Sie es einfach ausprobieren möchten, öffnen Sie Folgendes YouTube-Video in einem neuen Tab.

- Wählen Sie in der Benutzeroberfläche der LMA-App aus Audio streamen (keine Erweiterung) , um die Registerkarte „Audio streamen“ zu öffnen.

- Aussichten für Konferenz-ID, geben Sie eine Besprechungs-ID ein.

- Aussichten für Name und Vorname, geben Sie einen Namen für sich selbst ein (wird auf Audio von Ihrem Mikrofon angewendet).

- Aussichten für Teilnehmername(n)Geben Sie die Namen der Teilnehmer ein (angewendet auf die eingehende Audioquelle).

- Auswählen

Streaming starten.

- Wählen Sie die Browser-Registerkarte aus, die Sie zuvor geöffnet haben, und wählen Sie Erlauben zu teilen.

- Wählen Sie erneut die Registerkarte „LMA-Benutzeroberfläche“, um Ihre neue Meeting-ID anzuzeigen und das Meeting als anzuzeigen In Bearbeitung.

- Wählen Sie die Meeting-ID aus, um die Detailseite zu öffnen, und sehen Sie sich das Transkript des eingehenden Audios an, das den von Ihnen eingegebenen Teilnehmernamen zugeordnet ist. Wenn Sie sprechen, sehen Sie die Transkription Ihrer eigenen Stimme.

Verwenden Sie das Audio streamen Mit dieser Funktion können Sie von jeder Softphone-App, Meeting-App oder jedem anderen Streaming-Audio, das im Browser abgespielt wird, zusammen mit Ihrem eigenen Audio, das von Ihrem ausgewählten Mikrofon aufgenommen wurde, streamen. Holen Sie immer die Erlaubnis anderer ein, bevor Sie sie mit LMA oder einer anderen Aufnahmeanwendung aufnehmen.

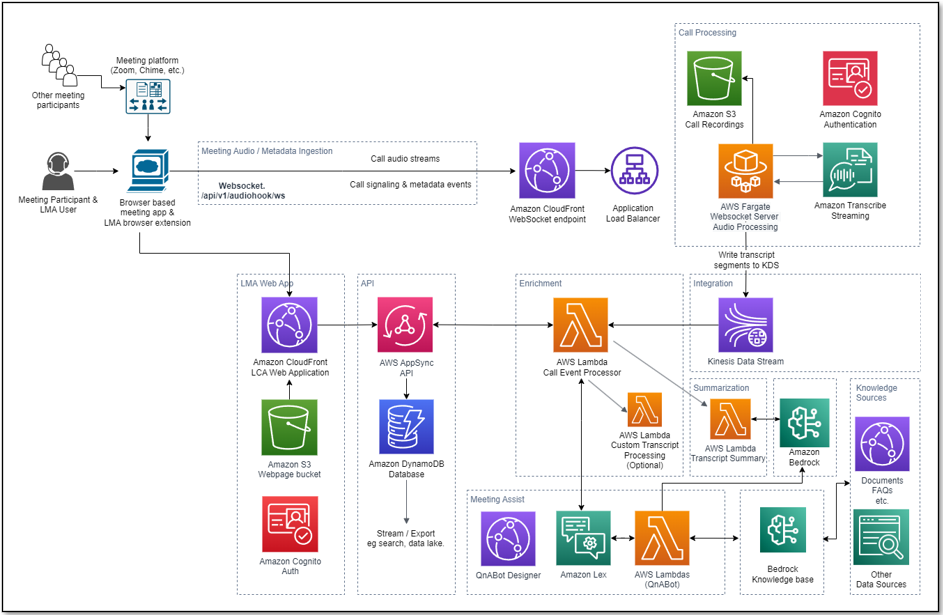

Überblick über den Verarbeitungsablauf

Wie hat LMA Ihr Meeting transkribiert und analysiert? Schauen wir uns an, wie es funktioniert. Das folgende Diagramm zeigt die wichtigsten Architekturkomponenten und wie sie auf hoher Ebene zusammenpassen.

Der LMA-Benutzer nimmt in seinem Browser an einem Meeting teil, aktiviert die LMA-Browsererweiterung und authentifiziert sich mit seinen LMA-Anmeldeinformationen. Wenn die Meeting-App (z. B. Zoom.us) von der LMA-Erweiterung unterstützt wird, werden der Name des Benutzers, der Meeting-Name und die Namen der aktiven Sprecher automatisch von der Erweiterung erkannt. Wenn die Meeting-App von der Erweiterung nicht unterstützt wird, kann der LMA-Benutzer seinen Namen und das Meeting-Thema manuell eingeben – die Namen aktiver Sprecher werden nicht erkannt.

Nachdem er die Erlaubnis anderer Teilnehmer eingeholt hat, wählt der LMA-Benutzer im LMA-Erweiterungsbereich Start Listening aus. Es wird eine sichere WebSocket-Verbindung zur vorkonfigurierten WebSocket-URL des LMA-Stacks hergestellt und das Authentifizierungstoken des Benutzers validiert. Die LMA-Browsererweiterung sendet eine START-Nachricht mit den Meeting-Metadaten (Name, Thema usw.) an den WebSocket und beginnt mit dem Streamen von Zweikanal-Audio vom Mikrofon des Benutzers und dem eingehenden Audiokanal, der die Stimmen der anderen Meeting-Teilnehmer enthält. Die Erweiterung überwacht die Meeting-App, um aktive Sprecherwechsel während des Anrufs zu erkennen, und sendet diese Metadaten an den WebSocket, sodass LMA Sprachsegmente mit dem Namen des Sprechers kennzeichnen kann.

Der in Fargate laufende WebSocket-Server konsumiert die Echtzeit-Zweikanal-Audiofragmente aus dem eingehenden WebSocket-Stream. Das Audio wird an Amazon Transcribe gestreamt und die Transkriptionsergebnisse werden in Echtzeit in Kinesis Data Streams geschrieben.

Jede Besprechungsverarbeitungssitzung wird ausgeführt, bis der Benutzer im LMA-Erweiterungsbereich „Zuhören beenden“ auswählt oder die Besprechung beendet und die Registerkarte schließt. Am Ende des Aufrufs erstellt die Funktion eine Stereoaufzeichnungsdatei in Amazon S3 (sofern die Aufzeichnung bei der Bereitstellung des Stacks aktiviert war).

Eine Lambda-Funktion namens Call Event Processor, die von Kinesis Data Streams gespeist wird, verarbeitet und bereichert optional Besprechungsmetadaten und Transkriptionssegmente. Der Call Event Processor lässt sich in die Meeting-Assistenzdienste integrieren. LMA wird betrieben von Amazon Lex, Wissensdatenbanken für Amazon Bedrock und Amazon Bedrock LLMs unter Verwendung der Open Source QnABot auf AWS-Lösung für Antworten auf Basis von FAQs und als Orchestrator für die Weiterleitung von Anfragen an den entsprechenden KI-Dienst. Der Call Event Processor ruft außerdem die Lambda-Funktion „Transcript Summarization“ auf, wenn der Anruf endet, um aus dem vollständigen Transkript eine Zusammenfassung des Anrufs zu generieren.

Die Call Event Processor-Funktion ist mit AWS AppSync verbunden, um Änderungen (Mutationen) beizubehalten Amazon DynamoDB und Echtzeitaktualisierungen an die angemeldeten Webclients des LMA-Benutzers senden (bequem zu öffnen, indem Sie in der Browsererweiterung die Option „In LMA öffnen“ auswählen).

Die LMA-Web-UI-Assets werden auf Amazon S3 gehostet und über CloudFront bereitgestellt. Die Authentifizierung erfolgt durch Amazon Cognito.

Wenn der Benutzer authentifiziert ist, stellt die Webanwendung eine sichere GraphQL-Verbindung zur AWS AppSync-API her und abonniert den Empfang von Echtzeitereignissen wie neuen Anrufen und Anrufstatusänderungen für die Besprechungslistenseite sowie neue oder aktualisierte Transkriptionssegmente und berechnete Daten Analysen für die Besprechungsdetailseite. Wenn die Übersetzung aktiviert ist, interagiert die Webanwendung auch sicher mit Amazon Translate, um die Besprechungstranskription in die ausgewählte Sprache zu übersetzen.

Der gesamte Verarbeitungsablauf, von der aufgenommenen Sprache bis hin zu Live-Webseitenaktualisierungen, ist ereignisgesteuert und die End-to-End-Latenz ist kurz – normalerweise nur wenige Sekunden.

Überwachung und Fehlerbehebung

AWS CloudFormation meldet Bereitstellungsfehler und -ursachen auf den relevanten Stacks Events Tab. Sehen Fehlerbehebung bei CloudFormation für Hilfe bei häufigen Bereitstellungsproblemen. Achten Sie auf Bereitstellungsfehler, die durch Fehler bei der Überschreitung des Grenzwerts verursacht werden. Die LMA-Stacks erstellen Ressourcen, die Standardkonto- und Regionsdienstkontingenten unterliegen, wie z. B. elastische IP-Adressen und NAT-Gateways. Navigieren Sie bei der Fehlerbehebung bei CloudFormation-Stack-Ausfällen immer zu allen ausgefallenen verschachtelten Stacks, um den ersten gemeldeten verschachtelten Ressourcenfehler zu finden – dies ist fast immer die Grundursache.

Amazon Transcribe hat ein Standardlimit von 25 gleichzeitigen Transkriptions-Streams, wodurch LMA auf 25 gleichzeitige Meetings in einem bestimmten AWS-Konto oder einer bestimmten AWS-Region beschränkt ist. Fordern Sie eine Erhöhung der Anzahl gleichzeitiger HTTP/2-Streams für die Streaming-Transkription an, wenn Sie viele Benutzer haben und eine größere Anzahl gleichzeitiger Besprechungen in Ihrem Konto verwalten müssen.

LMA bietet Laufzeitüberwachung und Protokolle für jede Komponente mithilfe von CloudWatch:

- WebSocket-Aufgabe zur Verarbeitung und Transkription von Fargate - Auf der Amazon Elastic Container-Service (Amazon ECS)-Konsole, navigieren Sie zu Cluster Seite und öffnen Sie die LMA-

WEBSOCKETSTACK-xxxx-TranscribingClusterFunktion. Wählen Sie das Aufträge Klicken Sie auf die Registerkarte und öffnen Sie die Aufgabenseite. Wählen Logs machen In CloudWatch anzeigen um die WebSocket-Transcriber-Aufgabenprotokolle zu überprüfen. - Rufen Sie die Lambda-Funktion des Ereignisprozessors auf – Öffnen Sie auf der Lambda-Konsole die

LMA-AISTACK-CallEventProcessorFunktion. Wählen Sie das Überwachen Registerkarte, um Funktionsmetriken anzuzeigen. Wählen Anzeigen von Protokollen in CloudWatch Funktionsprotokolle einsehen. - AWS AppSync-API – Öffnen Sie in der AWS AppSync-Konsole die

CallAnalytics-LMAAPI. Wählen Netzwerk Performance im Navigationsbereich, um API-Metriken anzuzeigen. Wählen Anzeigen von Protokollen in CloudWatch um AWS AppSync-API-Protokolle zu überprüfen.

Informationen zu QnABot auf AWS für Meeting Assist finden Sie im Meeting Assist READMEund der Leitfaden zur Implementierung der QnABot-Lösung für weitere Informationen.

Kostenschätzung

LMA stellt einen WebSocket-Server mit Fargate- (2vCPU) und VPC-Netzwerkressourcen bereit, der etwa 0.10 $/Stunde (ca. 72 $/Monat) kostet. Weitere Einzelheiten finden Sie unter AWS Fargate-Preise.

LMA wird mithilfe von QnABot und Knowledge Bases für Amazon Bedrock aktiviert. Sie erstellen Ihre eigene Wissensdatenbank, die Sie für LMA und möglicherweise andere Anwendungsfälle verwenden. Weitere Einzelheiten finden Sie unter Amazon Bedrock-Preise. Zusätzliche AWS-Dienste, die von der QnABot-Lösung genutzt werden, kosten etwa 0.77 $/Stunde. Weitere Einzelheiten finden Sie in der Liste von QnABot zu AWS-Lösungskosten.

Die restlichen Lösungskosten richten sich nach der Nutzung.

Die Nutzungskosten belaufen sich auf etwa 0.17 US-Dollar für einen 5-minütigen Anruf, obwohl diese je nach ausgewählten Optionen (z. B. Übersetzung), Anzahl der LLM-Zusammenfassungen und Gesamtnutzung variieren können, da sich die Nutzung auf die Berechtigung zum kostenlosen Kontingent und die volumengestuften Preise für viele Dienste auswirkt . Weitere Informationen zu den Diensten, für die Nutzungskosten anfallen, finden Sie hier:

Um die LMA-Kosten selbst zu erkunden, verwenden Sie AWS-Kosten-Explorer oder wählen Sie Rechnungsdetails auf dem AWS-Abrechnungs-Dashboard, um Ihre monatlichen Ausgaben nach Service anzuzeigen.

Passen Sie Ihre Bereitstellung an

Verwenden Sie die folgenden CloudFormation-Vorlagenparameter beim Erstellen oder Aktualisieren Ihres Stacks, um Ihre LCA-Bereitstellung anzupassen:

- Um Ihren eigenen S3-Bucket für Besprechungsaufzeichnungen zu verwenden, verwenden Sie Rufen Sie den Bucket-Namen für Audioaufnahmen auf machen Audiodatei-Präfix.

- Um PII aus den Transkriptionen zu entfernen, set Aktivieren Sie die Inhaltsschwärzung für Transkripte auf wahr setzen und anpassen Transkriptions-PII-Redaktions-Entitätstypen wie benötigt. Weitere Informationen finden Sie unter Schwärzen oder Identifizieren von PII in einem Echtzeit-Stream.

- Zur Verbesserung der Transkriptionsgenauigkeit für technische und domänenspezifische Akronyme und Jargon, set Benutzerdefinierter Vokabularname für die Transkription auf den Namen eines benutzerdefinierten Vokabulars, das Sie bereits in Amazon Transcribe erstellt oder festgelegt haben Name des benutzerdefinierten Transkriptionssprachenmodells auf den Namen eines zuvor erstellten benutzerdefinierten Sprachmodells. Weitere Informationen finden Sie unter Verbesserung der Transkriptionsgenauigkeit.

- Um Besprechungen in einer anderen unterstützten Sprache als US-Englisch zu transkribieren, wählen Sie den gewünschten Wert für aus Sprache für die Transkription.

- Optional festlegen, um die Transkriptverarbeitung anzupassen Lambda-Hook-Funktion ARN für die Verarbeitung benutzerdefinierter Transkriptsegmente zum ARN Ihrer eigenen Lambda-Funktion. Weitere Informationen finden Sie unter Verwenden einer Lambda-Funktion, um optional benutzerdefinierte Logik für die Transkriptverarbeitung bereitzustellen.

- Informationen zum Anpassen der Besprechungsunterstützungsfunktionen basierend auf der QnABot-on-AWS-Lösung, Amazon Lex, Amazon Bedrock und Knowledge Bases für die Amazon Bedrock-Integration finden Sie unter Meeting Assist README.

- Informationen zum Anpassen der Transkriptzusammenfassung durch Konfigurieren von LMA zum Aufrufen Ihrer eigenen Lambda-Funktion finden Sie unter LAMBDA-Option „Transkriptzusammenfassung“..

- Informationen zum Anpassen der Transkriptzusammenfassung durch Ändern der Standardaufforderungen oder Hinzufügen neuer Eingabeaufforderungen finden Sie unter Zusammenfassung des Transkripts.

- Um den Aufbewahrungszeitraum zu ändern, legen Sie fest Ablauf in Tagen aufzeichnen auf den gewünschten Wert. Alle Anrufdaten werden nach diesem Zeitraum dauerhaft aus dem LMA DynamoDB-Speicher gelöscht. Änderungen an dieser Einstellung gelten nur für neue Anrufe, die nach dem Update eingehen.

LMA ist ein Open-Source-Projekt. Sie können das LMA-GitHub-Repository forken, den Code verbessern und uns Pull-Requests senden, damit wir Ihre Verbesserungen integrieren und teilen können!

Aktualisieren Sie einen vorhandenen LMA-Stack

Sie können Ihren vorhandenen LMA-Stack auf die neueste Version aktualisieren. Weitere Einzelheiten finden Sie unter Aktualisieren Sie einen vorhandenen Stapel.

Aufräumen

Glückwunsch! Sie haben alle Schritte zum Einrichten Ihrer Live-Anrufanalyse-Beispiellösung mithilfe von AWS-Services abgeschlossen.

Wenn Sie mit dem Experimentieren mit dieser Beispiellösung fertig sind, bereinigen Sie Ihre Ressourcen, indem Sie die von Ihnen bereitgestellten LMA-Stacks mithilfe der AWS CloudFormation-Konsole löschen. Dadurch werden Ressourcen gelöscht, die durch die Bereitstellung der Lösung erstellt wurden. Die Aufzeichnungs-S3-Buckets, die DynamoDB-Tabelle und die CloudWatch-Protokollgruppen bleiben nach dem Löschen des Stapels erhalten, um ein Löschen Ihrer Daten zu vermeiden.

Live Call Analytics: Begleitlösung

Unsere Begleitlösung, Live-Anrufanalyse und Agent Assist (LCA) bietet Echtzeit-Transkription und -Analyse für Contact Center (Telefonanrufe) statt für Besprechungen. Es gibt viele Ähnlichkeiten – tatsächlich wurde LMA mit einer Architektur und vielen Komponenten erstellt, die von LCA abgeleitet wurden.

Zusammenfassung

Die Beispiellösung „Live Meeting Assistant“ bietet einen flexiblen, funktionsreichen und anpassbaren Ansatz zur Bereitstellung von Live-Meeting-Unterstützung, um Ihre Produktivität während und nach Meetings zu verbessern. Es nutzt Amazon AI/ML-Dienste wie Amazon Transcribe, Amazon Lex, Knowledge Bases for Amazon Bedrock und Amazon Bedrock LLMs, um Ihre Meeting-Audiodaten zu transkribieren und Echtzeit-Einblicke zu extrahieren.

Die LMA-Beispielanwendung wird als Open Source bereitgestellt – nutzen Sie sie als Ausgangspunkt für Ihre eigene Lösung und helfen Sie uns, sie zu verbessern, indem Sie über GitHub-Pull-Requests Korrekturen und Funktionen beisteuern. Navigieren Sie zu LMA GitHub-Repository Um den Code zu erkunden, wählen Sie Ansehen um über Neuerscheinungen informiert zu werden, und überprüfen Sie die README für die neuesten Dokumentationsaktualisierungen.

Für fachkundige Unterstützung, Professionelle AWS-Services und andere AWS-Partner sind hier um zu helfen.

Wir würden uns freuen, von Ihnen zu hören. Teilen Sie uns Ihre Meinung im Kommentarbereich mit oder nutzen Sie das Themenforum im LMA GitHub-Repository.

Über die Autoren

Bob Strahan ist Principal Solutions Architect im AWS Language AI Services-Team.

Bob Strahan ist Principal Solutions Architect im AWS Language AI Services-Team.

Chris Lotte ist Principal Solutions Architect im AWS AI Language Services-Team. Er verfügt über 20 Jahre Erfahrung in der Entwicklung von Unternehmenssoftware. Chris lebt in Sacramento, Kalifornien und liebt Gartenarbeit, Luft- und Raumfahrt und Reisen um die Welt.

Chris Lotte ist Principal Solutions Architect im AWS AI Language Services-Team. Er verfügt über 20 Jahre Erfahrung in der Entwicklung von Unternehmenssoftware. Chris lebt in Sacramento, Kalifornien und liebt Gartenarbeit, Luft- und Raumfahrt und Reisen um die Welt.

Babu Srinivasan ist Sr. Specialist SA – Language AI Services in der World Wide Specialist Organisation bei AWS, mit über 24 Jahren Erfahrung in der IT und den letzten 6 Jahren mit Schwerpunkt auf der AWS Cloud. Er hat eine Leidenschaft für KI/ML. Außerhalb der Arbeit beschäftigt er sich gerne mit Holz und unterhält Freunde und Familie (manchmal auch Fremde) mit geschickter Kartenmagie.

Babu Srinivasan ist Sr. Specialist SA – Language AI Services in der World Wide Specialist Organisation bei AWS, mit über 24 Jahren Erfahrung in der IT und den letzten 6 Jahren mit Schwerpunkt auf der AWS Cloud. Er hat eine Leidenschaft für KI/ML. Außerhalb der Arbeit beschäftigt er sich gerne mit Holz und unterhält Freunde und Familie (manchmal auch Fremde) mit geschickter Kartenmagie.

Kishore Dhamodaran ist Senior Solutions Architect bei AWS.

Kishore Dhamodaran ist Senior Solutions Architect bei AWS.

Gillian Armstrong ist ein Builder Solutions Architect. Sie ist begeistert, wie die Cloud mehr Menschen Möglichkeiten eröffnet, Technologie zur Lösung von Problemen einzusetzen, und besonders begeistert, wie kognitive Technologien, wie Konversations-KI, es uns ermöglichen, auf menschlichere Weise mit Computern zu interagieren.

Gillian Armstrong ist ein Builder Solutions Architect. Sie ist begeistert, wie die Cloud mehr Menschen Möglichkeiten eröffnet, Technologie zur Lösung von Problemen einzusetzen, und besonders begeistert, wie kognitive Technologien, wie Konversations-KI, es uns ermöglichen, auf menschlichere Weise mit Computern zu interagieren.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/live-meeting-assistant-with-amazon-transcribe-amazon-bedrock-and-knowledge-bases-for-amazon-bedrock/