Introducción

En los últimos años, el campo de la inteligencia artificial (IA) ha sido testigo de un aumento notable en el desarrollo de modelos de IA generativa. Estos modelos pueden generar texto similar al humano, imágenes e incluso audio, superando los límites de lo que antes se consideraba imposible. Entre estos modelos, el Transformador Generativo Preentrenado (GPT) destaca como un avance pionero en el procesamiento del lenguaje natural (PLN). Exploremos la intrincada arquitectura de los GPT y descubramos cómo manejan con facilidad las tareas de IA generativa y PNL.

Índice del contenido

El auge de los modelos de IA generativa

Los modelos de IA generativa son una clase de máquina de aprendizaje Modelos que pueden crear nuevos datos, como texto, imágenes o audio, desde cero. Estos modelos se entrenan con grandes cantidades de datos existentes, lo que les permite aprender los patrones y estructuras subyacentes. Una vez capacitados, pueden generar contenido nuevo y original que imite las características de los datos de entrenamiento.

El auge de los modelos generativos de IA se ha visto impulsado por los avances en las técnicas de aprendizaje profundo, particularmente en las redes neuronales. Aprendizaje profundo Los algoritmos han demostrado ser notablemente eficaces a la hora de capturar patrones complejos en los datos, lo que los hace muy adecuados para tareas generativas. A medida que ha aumentado la potencia computacional y el acceso a grandes conjuntos de datos, los investigadores han podido entrenar modelos generativos cada vez más sofisticados.

Los misterios de GPT

Los modelos GPT son un tipo de modelo de lenguaje grande (LLM) que aprovecha el poder de redes neuronales para comprender y generar texto similar al humano. Estos modelos son "generativos" porque pueden producir texto nuevo y coherente basado en los patrones aprendidos de conjuntos de datos masivos. Están "preentrenados" porque pasan por una fase de entrenamiento inicial con grandes cantidades de datos de texto. Esto les permite adquirir una amplia base de conocimientos antes de perfeccionarse para tareas específicas.

La arquitectura "transformadora" es la innovación central que ha impulsado los modelos GPT a niveles de rendimiento sin precedentes. Transformers son un tipo de red neuronal diseñada para manejar datos secuenciales, como texto, de manera más efectiva que los modelos tradicionales. Emplean un novedoso mecanismo de atención que permite al modelo sopesar la importancia de diferentes partes de la entrada al generar resultados. Esto le permite capturar dependencias de largo alcance y producir texto más coherente y contextualmente relevante.

Diseccionando la arquitectura GPT

La arquitectura GPT es una poderosa combinación de tres componentes clave: sus capacidades generativas, su enfoque de preentrenamiento y su red neuronal transformadora. Cada uno de estos pilares juega un papel crucial para permitir que los modelos GPT logren su notable desempeño en tareas de PNL.

Los tres pilares: generativo, preentrenado y transformador

El aspecto "generativo" de los modelos GPT se refiere a su capacidad para generar texto nuevo y coherente basado en los patrones que han aprendido de grandes cantidades de datos de entrenamiento. Los modelos de lenguaje tradicionales se centran principalmente en comprender y analizar texto. A diferencia de ellos, los modelos GPT están diseñados para producir resultados de texto similares a los humanos, lo que los hace muy versátiles para una variedad de aplicaciones.

El componente "preentrenado" de los modelos GPT implica una fase de entrenamiento inicial en la que el modelo se expone a un corpus masivo de datos de texto. Durante esta etapa previa al entrenamiento, el modelo aprende a capturar los patrones, estructuras y relaciones subyacentes dentro de los datos. Esto le ayuda a construir eficazmente una amplia base de conocimientos. La fase previa al entrenamiento es crucial ya que permite que el modelo adquiera una comprensión general del lenguaje antes de perfeccionarlo.

La arquitectura "transformadora" es la columna vertebral de la red neuronal de los modelos GPT. Los transformadores son modelos de aprendizaje profundo diseñados específicamente para manejar datos secuenciales, como texto, de manera más efectiva que los modelos tradicionales. Emplean un novedoso mecanismo de atención que permite al modelo sopesar la importancia de diferentes partes de la entrada al generar resultados. Esto le permite capturar dependencias de largo alcance y producir texto más coherente y contextualmente relevante.

Cómo los GPT producen oraciones coherentes

Los modelos GPT generan texto prediciendo la siguiente palabra o token en una secuencia en función del contexto proporcionado por las palabras o tokens anteriores. Este proceso se logra mediante una serie de cálculos dentro de la arquitectura del transformador. Comienza tokenizando el texto de entrada y transformándolo en representaciones numéricas (incrustaciones). Estas incrustaciones luego pasan a través de múltiples capas del transformador. Aquí, el mecanismo de atención permite que el modelo capture las relaciones entre diferentes partes de la entrada y genere resultados contextualmente relevantes.

La salida del modelo es una Distribución de probabilidad sobre todo el vocabulario, indicando la probabilidad de que cada palabra o ficha sea la siguiente en la secuencia. Durante la inferencia, el modelo toma muestras de esta distribución para generar el siguiente token, que se agrega a la secuencia de entrada. Este proceso se repite hasta que se alcanza la longitud de salida deseada o se cumple una condición de parada.

Aprovechar conjuntos de datos masivos para un mejor rendimiento

Una de las ventajas clave de los modelos GPT es su capacidad para aprovechar conjuntos de datos masivos durante la fase previa al entrenamiento. Estos conjuntos de datos pueden constar de miles de millones de palabras de diversas fuentes, como libros, artículos, sitios web y redes sociales. Esto proporciona al modelo una exposición diversa y completa al lenguaje natural.

Durante el entrenamiento previo, el modelo tiene que predecir la siguiente palabra o token en la secuencia, de manera similar al proceso de generación de texto. Sin embargo, en lugar de generar texto nuevo, el modelo aprende a capturar los patrones y relaciones subyacentes dentro de los datos de entrenamiento. Esta fase de preentrenamiento es computacionalmente intensiva pero crucial. Permite que el modelo desarrolle una comprensión amplia del lenguaje, que luego puede ajustarse para tareas específicas.

Al aprovechar conjuntos de datos masivos durante el entrenamiento previo, los modelos GPT pueden adquirir una amplia base de conocimientos. También pueden desarrollar una comprensión profunda de las estructuras del lenguaje, las expresiones idiomáticas y los matices contextuales. Este extenso entrenamiento previo proporciona una base sólida para el modelo. Permite que el modelo funcione bien en una amplia gama de tareas posteriores con relativamente pocos ajustes específicos de la tarea.

La red neuronal detrás de la magia

La arquitectura del transformador es la innovación central que impulsa los modelos GPT y ha revolucionado el campo de la PNL. A diferencia de lo tradicional redes neuronales recurrentes (RNN), que procesan secuencialmente datos secuenciales, los transformadores emplean un novedoso mecanismo de atención que les permite capturar dependencias de largo alcance y procesar eficientemente secuencias de entrada en paralelo.

La arquitectura del transformador consta de múltiples capas, cada una de las cuales comprende dos componentes principales: el mecanismo de atención de múltiples cabezales y la red neuronal de retroalimentación. El mecanismo de atención es responsable de ponderar la importancia de diferentes partes de la secuencia de entrada al generar resultados, lo que permite al modelo capturar el contexto y las relaciones entre elementos distantes en la secuencia.

Las capas de la red neuronal de retroalimentación son responsables de procesar y refinar aún más la salida del mecanismo de atención, lo que permite que el modelo aprenda representaciones más complejas de los datos de entrada.

El mecanismo de atención y procesamiento en paralelo de la arquitectura del transformador ha demostrado ser muy eficaz en el manejo de secuencias largas y la captura de dependencias de largo alcance, que son cruciales para las tareas de PNL. Esta arquitectura ha permitido que los modelos GPT alcancen un rendimiento de última generación. También ha influido en el desarrollo de otros modelos basados en transformadores en diversos ámbitos, como la visión por computadora y el reconocimiento de voz.

Dentro del transformador

La arquitectura del transformador es el componente central que permite que los modelos GPT alcancen su notable rendimiento en tareas de PNL. Echemos un vistazo más de cerca a los pasos clave involucrados en el procesamiento de datos de texto por parte del transformador.

Tokenización: dividir el texto en fragmentos digeribles

Antes de que el transformador pueda procesar texto, los datos de entrada deben dividirse en unidades más pequeñas llamadas tokens. Tokenization es el proceso de dividir el texto en estos tokens, que pueden ser palabras, subpalabras o incluso caracteres individuales. Este paso es crucial porque permite que el transformador maneje secuencias de diferentes longitudes y represente palabras raras o fuera de vocabulario de manera efectiva. El proceso de tokenización suele implicar técnicas como la segmentación de palabras, el manejo de la puntuación y el manejo de caracteres especiales.

Incrustaciones de palabras: asignación de palabras a vectores numéricos

Una vez que el texto ha sido tokenizado, cada token se asigna a una representación vectorial numérica llamada incrustación de palabras. Estas incrustaciones de palabras son vectores densos que capturan información semántica y sintáctica sobre las palabras que representan. El transformador utiliza estas incrustaciones como entrada, lo que le permite procesar datos de texto en un formato numérico que puede ser manipulado eficientemente por su arquitectura de red neuronal. Las incrustaciones de palabras se aprenden durante el proceso de entrenamiento, donde las palabras con significados similares tienden a tener representaciones vectoriales similares, lo que permite que el modelo capture relaciones semánticas y contexto.

El mecanismo de atención: el corazón del transformador

El mecanismo de atención es la innovación clave que distingue a los transformadores de las arquitecturas de redes neuronales tradicionales. Permite que el modelo se centre selectivamente en partes relevantes de la secuencia de entrada al generar resultados, capturando eficazmente las dependencias y el contexto de largo alcance. El mecanismo de atención funciona calculando puntuaciones de atención que representan la importancia de cada elemento de entrada para un elemento de salida determinado y luego utilizando estas puntuaciones para ponderar las representaciones de entrada correspondientes. Este mecanismo permite al transformador procesar eficazmente secuencias de diferentes longitudes y capturar relaciones entre elementos distantes en la entrada, lo cual es crucial para tareas como la traducción automática y la generación de lenguaje.

Perceptrones multicapa: mejora de las representaciones vectoriales

Además del mecanismo de atención, los transformadores también incorporan perceptrones multicapa (MLP), que son redes neuronales de retroalimentación. Estos MLP se utilizan para procesar y refinar aún más las representaciones vectoriales producidas por el mecanismo de atención, lo que permite que el modelo capture patrones y relaciones más complejos en los datos. Los MLP toman la salida del mecanismo de atención como entrada y aplican una serie de transformaciones lineales y funciones de activación no lineales para mejorar las representaciones vectoriales. Este paso es crucial para que el modelo aprenda características y representaciones de nivel superior que sean útiles para la tarea posterior.

Entrenando un modelo GPT

Entrenar un modelo GPT es un proceso complejo y computacionalmente intensivo que involucra varios componentes y técnicas clave.

Retropropagación: el algoritmo que hace que los GPT sean más inteligentes

En el centro del entrenamiento de modelos GPT se encuentra el algoritmo de retropropagación, que es una técnica ampliamente utilizada en el aprendizaje profundo para actualizar los pesos y parámetros del modelo en función de los errores que comete durante el entrenamiento. Durante propagación hacia atrás, las predicciones del modelo se comparan con las etiquetas de verdad del terreno y los errores se propagan hacia atrás a través de la red para ajustar las ponderaciones y minimizar el error general. Este proceso implica calcular los gradientes de la función de pérdida con respecto a los parámetros del modelo y actualizar los parámetros en la dirección que minimice la pérdida. La retropropagación es un componente esencial del proceso de formación, ya que permite que el modelo aprenda de sus errores y mejore gradualmente su rendimiento.

Ajuste fino supervisado

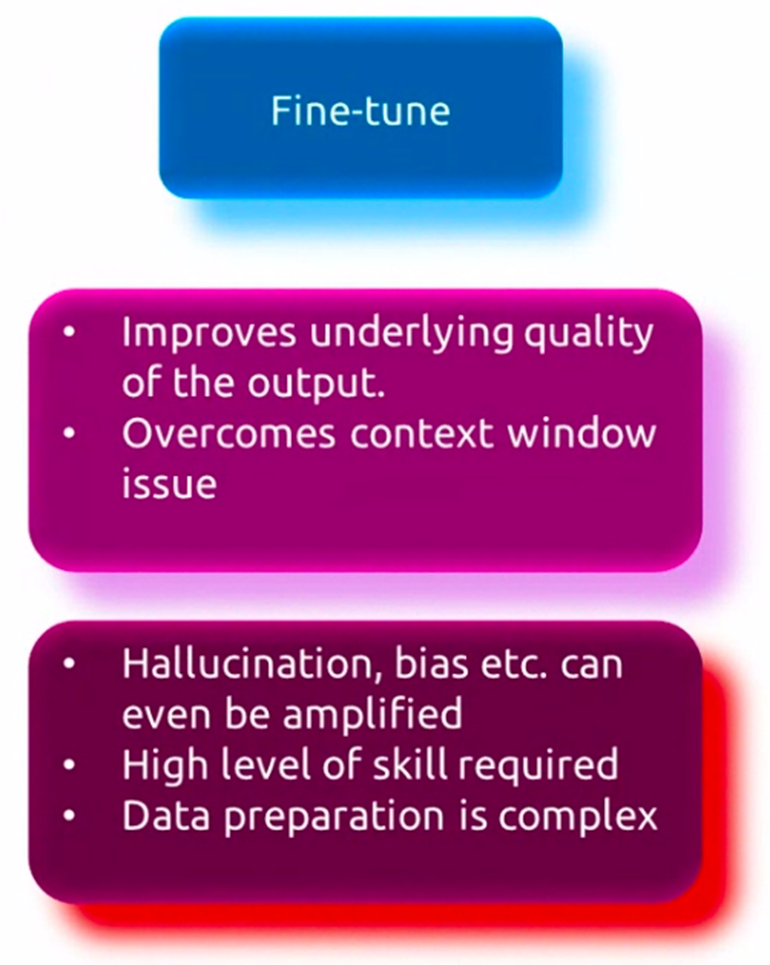

Si bien los modelos GPT están previamente entrenados en conjuntos de datos masivos para adquirir una comprensión amplia del lenguaje, a menudo necesitan ser ajustados en datos de tareas específicas para funcionar bien en aplicaciones específicas. Este proceso, conocido como ajuste fino supervisado, implica entrenar aún más el modelo previamente entrenado en un conjunto de datos más pequeño que sea relevante para la tarea objetivo, como la respuesta a preguntas, el resumen de texto o la traducción automática. Durante sintonia FINA, las ponderaciones del modelo se ajustan para capturar mejor los patrones y matices específicos de la tarea en cuestión, manteniendo al mismo tiempo el conocimiento general del lenguaje adquirido durante la capacitación previa. Este proceso de ajuste permite que el modelo se especialice y se adapte a los requisitos específicos de la tarea objetivo, lo que resulta en un mejor rendimiento.

Preentrenamiento no supervisado

Antes del ajuste fino, los modelos GPT se someten a una fase inicial de preentrenamiento no supervisado, donde se exponen a grandes cantidades de datos de texto de diversas fuentes, como libros, artículos y sitios web. Durante esta fase, el modelo aprende a capturar los patrones y relaciones subyacentes en los datos prediciendo la siguiente palabra o token en una secuencia, un proceso conocido como modelado del lenguaje. Este entrenamiento previo no supervisado permite que el modelo desarrolle una amplia comprensión del lenguaje, incluida la sintaxis, la semántica y el contexto. El modelo se entrena con un corpus masivo de datos de texto, lo que le permite aprender de una amplia gama de temas, estilos y dominios. Esta fase de preentrenamiento no supervisada es computacionalmente intensiva pero crucial, ya que proporciona al modelo una base sólida para el ajuste posterior de tareas específicas.

Aplicaciones y casos de uso de GPT

Los modelos GPT han demostrado una notable versatilidad y se han aplicado a una amplia gama de tareas y aplicaciones de PNL. Exploremos algunos de los casos de uso clave de estos poderosos modelos de lenguaje.

Romper las barreras del idioma

Una de las primeras y más destacadas aplicaciones de los modelos GPT es el campo de la traducción automática. Al aprovechar su capacidad para comprender y generar texto similar al humano, los modelos GPT se pueden entrenar para traducir entre diferentes idiomas con alta precisión y fluidez. Estos modelos pueden capturar los matices y las complejidades del lenguaje, permitiéndoles producir traducciones que no solo sean precisas sino que también mantengan el significado y el contexto previstos del texto original.

Resumen de texto

Con la cantidad cada vez mayor de datos textuales disponibles, la capacidad de resumir Convertir documentos o artículos extensos en resúmenes concisos y significativos se ha vuelto cada vez más importante. Los modelos GPT han demostrado ser efectivos en esta tarea, ya que pueden analizar y comprender el contexto y los puntos clave de un texto determinado, para luego generar un resumen condensado que capture la esencia del contenido original. Esta aplicación tiene numerosos casos de uso, que van desde resumir artículos de noticias y trabajos de investigación hasta generar informes concisos y resúmenes ejecutivos.

Chatbots e IA conversacional

Una de las aplicaciones más visibles y ampliamente adoptadas de los modelos GPT es el desarrollo de chatbots y AI conversacional sistemas. Estos modelos pueden entablar un diálogo humano, comprender y responder a las consultas y aportes de los usuarios de una manera natural y contextualmente apropiada. Los chatbots con tecnología GPT se utilizan en diversas industrias, como la atención al cliente, el comercio electrónico y la atención médica, para brindar asistencia personalizada y eficiente a los usuarios.

El potencial imaginativo de los GPT

Si bien los modelos GPT se diseñaron inicialmente para tareas de generación y comprensión del lenguaje, su capacidad para producir texto coherente e imaginativo ha abierto nuevas posibilidades en el ámbito de la escritura creativa. Estos modelos se pueden ajustar para generar historias, poemas, guiones e incluso letras de canciones, ofreciendo una poderosa herramienta para que escritores y artistas exploren nuevas vías creativas. Además, los modelos GPT pueden ayudar en el proceso de escritura al sugerir desarrollos de la trama y descripciones de los personajes, e incluso generar pasajes completos basados en indicaciones o esquemas.

El futuro de las GPT y la IA generativa

Por muy prometedores que hayan sido los modelos GPT, todavía existen limitaciones y desafíos que superar, así como consideraciones éticas que abordar. Además, el campo de la IA generativa está evolucionando rápidamente, con nuevas tendencias e investigaciones de vanguardia que dan forma al futuro de estos modelos.

Limitaciones y desafíos de los modelos GPT actuales

A pesar de sus impresionantes capacidades, los modelos GPT actuales tienen ciertas limitaciones. Uno de los principales desafíos es su incapacidad para comprender verdaderamente el significado subyacente y el contexto del texto que generan. Si bien pueden producir textos coherentes y fluidos, a veces pueden generar información sin sentido o objetivamente incorrecta, especialmente cuando se trata de temas complejos o especializados. Además, estos modelos pueden presentar sesgos presentes en sus datos de entrenamiento, lo que genera preocupaciones sobre la equidad y resultados potencialmente dañinos.

Consideraciones éticas y desarrollo responsable de la IA

A medida que los modelos GPT se vuelven más poderosos y generalizados, es crucial abordar consideraciones éticas y garantizar el desarrollo y la implementación responsable de estas tecnologías. Se deben examinar cuidadosamente cuestiones como la privacidad, la seguridad y la posibilidad de uso indebido o aplicaciones maliciosas. Los investigadores y desarrolladores deben trabajar para desarrollar directrices éticas, marcos de gobernanza y salvaguardias sólidas para mitigar los riesgos potenciales y garantizar el uso seguro y beneficioso de los modelos GPT.

Tendencias emergentes e investigaciones de vanguardia

El campo de la IA generativa está evolucionando rápidamente y los investigadores exploran nuevas arquitecturas, métodos de capacitación y aplicaciones. Una de las tendencias emergentes es modelos multimodales que pueden procesar y generar datos a través de diferentes modalidades (texto, imágenes, audio, etc.). Los enfoques de aprendizaje por refuerzo para la generación de lenguajes son otro. La integración de modelos GPT con otras tecnologías de IA, como visión de computadora y robótica es otra tendencia más. Además, se están realizando investigaciones para mejorar la interpretabilidad, controlabilidad y solidez de estos modelos. Los investigadores también están explorando su potencial en áreas como los descubrimientos científicos, la educación y la atención sanitaria.

Conclusión

Los modelos GPT han revolucionado el campo de la PNL. Han demostrado capacidades notables en tareas como traducción de idiomas, resumen de textos, inteligencia artificial conversacional y escritura creativa. El núcleo de estos modelos es la arquitectura del transformador. Esto emplea un mecanismo de atención novedoso para capturar dependencias y contexto de largo alcance en datos de texto. El entrenamiento de modelos GPT implica un proceso complejo de entrenamiento previo no supervisado en conjuntos de datos masivos, seguido de un ajuste supervisado para tareas específicas.

Si bien los modelos GPT han logrado resultados impresionantes, todavía existen limitaciones y desafíos que superar. Esto incluye la falta de una verdadera comprensión, posibles sesgos y preocupaciones éticas. Además, el campo de la IA generativa está evolucionando rápidamente y los investigadores exploran nuevas arquitecturas, aplicaciones y técnicas para ampliar los límites de estos modelos.

A medida que los modelos GPT continúan avanzando, es fundamental abordar consideraciones éticas y desarrollar prácticas responsables de IA. También es importante explorar las tendencias emergentes y la investigación de vanguardia para aprovechar todo el potencial de estos poderosos modelos. Mientras tanto, debemos garantizar su uso seguro y beneficioso mitigando los riesgos potenciales.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.analyticsvidhya.com/blog/2024/04/what-is-gpt-you-wont-believe-whats-inside/