Marley Stevens publicado un vídeo en tiktok el semestre pasado que ella describió como un anuncio de servicio público para cualquier estudiante universitario. Su mensaje: no utilice software de revisión gramatical si su profesor podría pasar su trabajo a través de un sistema de detección de inteligencia artificial.

Stevens es estudiante de tercer año en la Universidad de North Georgia y ha sido inusualmente pública sobre lo que ella llama una “debacle”, en la que fue acusada de usar IA para escribir un artículo que, según ella, compuso ella misma excepto por el uso de gramática estándar. y funciones de revisión ortográfica de Grammarly, que instaló como una extensión en su navegador web.

Ese video de advertencia inicial que publicó ha sido visto más de 5.5 millones de veces y desde entonces ha realizado más de 25 videos de seguimiento respondiendo a los comentarios de sus seguidores y documentando su batalla con la universidad sobre el tema, incluido el intercambio de fotografías de los correos electrónicos que le enviaron. desde decanos académicos e imágenes de su trabajo estudiantil para tratar de probar su caso, para crear conciencia sobre lo que ella considera herramientas de detección de IA defectuosas que son cada vez más aprobadas por las universidades y utilizadas por los profesores.

Stevens dice que un profesor en un curso de justicia penal que tomó el año pasado le dio un cero en un trabajo porque dijo que el sistema de detección de IA en Turnitin lo marcó como escrito por robots. Stevens insiste en que el trabajo es enteramente suyo y que no utilizó ChatGPT ni ningún otro chatbot para componer ninguna parte de su artículo.

@m.stevens03 #granmerly #ai #inteligencia artificial #fyp #psa ♬ sonido original - Marley Stevens

Como resultado del cero en el examen, dice, su calificación final en la clase cayó a una calificación tan baja que le impidió calificar para un Becas de ESPERANZA, que requiere que los estudiantes mantengan un GPA de 3.0. Y dice que la universidad la puso en período de prueba académica por violar sus políticas sobre mala conducta académica, y le exigieron pagar 105 dólares para asistir a un seminario sobre las trampas.

La universidad rechazó repetidas solicitudes de EdSurge para hablar sobre sus políticas para el uso de la detección de IA. En cambio, los funcionarios enviaron una declaración diciendo que las leyes federales de privacidad de los estudiantes les impiden comentar sobre cualquier incidente de trampa individual, y que: “Nuestra facultad comunica pautas específicas sobre el uso de IA para varias clases, y esas pautas se incluyen en el programa de estudios de la clase. El uso inadecuado de la IA también se aborda en nuestro Código de Conducta Estudiantil."

La sección de ese código de conducta estudiantil define el plagio como: “Uso de ideas o expresiones de otra persona o agencia (para incluir la Inteligencia Artificial) sin reconocer la fuente. Los temas, ensayos, trabajos finales, exámenes y otros requisitos similares deben ser trabajo del Estudiante que los presenta. Cuando se utilicen citas directas o paráfrasis, deberán indicarse, y cuando se incorporen al artículo las ideas de otro, deberán reconocerse adecuadamente. Todo el trabajo de un Estudiante debe ser original o citado de acuerdo con los requisitos del instructor o de lo contrario se considerará plagio. El plagio incluye, entre otros, el uso, mediante paráfrasis o cita directa, del trabajo publicado o no publicado de otra persona sin un reconocimiento completo y claro. También incluye el uso no reconocido de materiales preparados por otra persona o agencia en la venta de trabajos finales u otros materiales académicos”.

El incidente plantea preguntas complejas sobre dónde trazar límites con respecto a las nuevas herramientas de inteligencia artificial. ¿Cuándo simplemente ayudan de manera aceptable y cuándo su uso significa mala conducta académica? Después de todo, muchas personas utilizan funciones de autocorrección de gramática y ortografía en sistemas como Google Docs y otros programas que sugieren una palabra o frase a medida que los usuarios escriben. ¿Eso es trampa?

Y a medida que estas características gramaticales se vuelven más sólidas a medida que las herramientas de IA generativa se vuelven más comunes, ¿pueden las herramientas de detección de IA distinguir entre el uso aceptable de la IA y las trampas?

"Otros profesores de esta misma universidad me recomendaron que usara [Grammarly] para los trabajos", dijo Stevens en otro video. “¿Entonces están tratando de decirnos que no podemos usar autocorrección ni correctores ortográficos ni nada por el estilo? ¿Qué quieren que hagamos, escribirlo en una aplicación de Notas y convertirlo de esa manera?

En una entrevista con EdSurge, el estudiante lo expresó de esta manera:

"Lo único que pienso es que los detectores de IA son basura y no hay mucho que nosotros, como estudiantes, podamos hacer al respecto", afirma. "Y eso no es justo porque hacemos todo este trabajo y pagamos todo este dinero para ir a la universidad, y luego un detector de IA puede arruinar toda tu carrera universitaria".

Giros y vueltas

En el camino, la historia de este estudiante de la Universidad del Norte de Georgia ha dado algunos giros sorprendentes.

Por un lado, la universidad envió un correo electrónico a todos los estudiantes sobre la IA poco después de que Stevens publicara su primer vídeo viral.

Ese correo electrónico recordaba a los estudiantes que debían seguir el código de conducta académica de la universidad y también tenía una advertencia inusual: “Tengan en cuenta que algunas herramientas en línea utilizadas para ayudar a los estudiantes con gramática, puntuación, estructura de oraciones, etc., utilizan inteligencia artificial generativa (IA). ); que Turnitin puede marcar. Uno de los sitios web de IA generativa más utilizados y señalados por Turnitin.com es Grammarly. Tenga cuidado al considerar estos sitios web”.

Más tarde, el profesor le dijo a la estudiante que también revisó su trabajo con otra herramienta, Copyleaks, y también marcó su trabajo como escrito por un robot. Y dice que cuando revisó su artículo recientemente en Copyleaks, consideró que el trabajo estaba escrito por humanos. Le envió a este periodista una captura de pantalla de ese proceso, en la que la herramienta concluye, en texto verde, "Este es texto humano".

"Si lo reviso ahora y obtengo un resultado diferente, eso demuestra que estas cosas no siempre son precisas", dice sobre los detectores de IA.

Los funcionarios de Copyleaks no respondieron a las solicitudes de comentarios. Stevens se negó a compartir el texto completo de su artículo, explicando que no quería que terminara en Internet, donde otros estudiantes pudieran copiarlo y posiblemente causarle más problemas con su universidad. "Ya estoy en período de prueba académica", dice.

Stevens dice que ha escuchado de estudiantes de todo el país que dicen que también han sido acusados falsamente de hacer trampa debido al software de detección de inteligencia artificial.

“Una estudiante dijo que quería ser médica, pero la acusaron y luego ninguna de las escuelas la aceptó debido a su cargo de mala conducta”, dice Stevens.

Stevens dice que le ha sorprendido la cantidad de apoyo que ha recibido de las personas que ven sus vídeos. Sus seguidores en las redes sociales la animaron a montar una Campaña GoFundMe, lo que hizo para cubrir la pérdida de su beca y pagar a un abogado para potencialmente emprender acciones legales contra la universidad. Hasta ahora ha recaudado más de $6,100 de más de 90 personas.

También se sorprendió al ser contactada por funcionarios de Grammarly, quienes donaron $4,000 a su GoFundMe y la contrataron como embajadora estudiantil. Como resultado, Stevens ahora planea hacer tres videos promocionales para Grammarly, por los cuales se le pagará una pequeña tarifa por cada uno.

"En este momento estamos tratando de trabajar juntos para lograr que las universidades reconsideren sus políticas de IA", dice Stevens.

Para Grammarly, parece claro que el objetivo es cambiar la narrativa de ese primer video de Stevens, en el que dijo: "Si tienes un artículo, ensayo, publicación de discusión o cualquier cosa que se envíe a TurnItIn, desinstala Grammarly ahora mismo". .”

La directora de educación de Grammarly, Jenny Maxwell, dice que espera difundir el mensaje sobre lo imprecisos que son los detectores de IA.

"Muchas instituciones a nivel docente desconocen con qué frecuencia estos servicios de detección de IA fallan", dice. "Queremos asegurarnos de que las instituciones sean conscientes de lo peligroso que puede ser tener estos detectores de IA como única fuente de verdad".

Tales defectos han sido bien identificada, y varios investigadores han dicho que los profesores no deberían utilizar estas herramientas. Incluso Turnitin ha declarado públicamente que su herramienta de detección de IA no siempre es confiable.

Annie Chechitelli, directora de productos de Turnitin, dice que sus herramientas de detección de IA tienen alrededor de un 1 por ciento de tasa de falsos positivos según las pruebas de la compañía, y que está trabajando para reducirla lo más posible.

"Probablemente dejamos que alrededor del 15 por ciento [del texto escrito por robots] pase sin marcar", dice. "Preferiríamos reducir nuestra precisión que aumentar nuestra tasa de falsos positivos".

Chechitelli enfatiza que los educadores deben usar el sistema de detección de Turnitin como punto de partida para una conversación con un estudiante, no como una decisión final sobre la integridad académica del trabajo del estudiante. Y dice que ese también ha sido el consejo de la empresa para su sistema de detección de plagio.

"Tuvimos que enseñar a los profesores que esto no es prueba de que el estudiante haya hecho trampa", afirma. "Siempre hemos dicho que el maestro necesita tomar una decisión".

Sin embargo, la IA coloca a los educadores en una posición más desafiante para esa conversación, reconoce Chechitelli. En los casos en que la herramienta de Turnitin detecta plagio, el sistema señala el material fuente que el estudiante pudo haber copiado. En el caso de la detección de IA, no existe un material fuente claro al que recurrir, ya que herramientas como ChatGPT arrojan respuestas diferentes cada vez que un usuario ingresa un mensaje, lo que hace mucho más difícil demostrar que la fuente es un bot.

El responsable de Turnitin afirma que en las pruebas internas de la empresa, las herramientas tradicionales de revisión gramatical no hacen saltar las alarmas.

Maxwell, de Grammarly, señala que incluso si un sistema de detección de IA es correcto el 98 por ciento de las veces, eso significa que detecta falsamente, digamos, el 2 por ciento de los artículos. Y dado que una sola universidad puede tener 50,000 trabajos de estudiantes entregados cada año, eso significa que si todos los profesores usaran un sistema de detección de IA, 1,000 trabajos serían falsamente llamados casos de trampa.

¿Le preocupa a Maxwell que las universidades puedan desalentar el uso de su producto? Después de todo, la Universidad de North Georgia eliminó recientemente Grammarly de una lista de recursos recomendados después de que los videos de TikTok de Stevens se volvieran virales, aunque luego lo volvieron a agregar.

"Nos reunimos con la Universidad de North Georgia y nos dijeron que esto no tiene nada que ver con Grammarly", dice Maxwell. “Estamos encantados de ver cuántos profesores y estudiantes más se están inclinando en el sentido contrario, diciendo: 'Este es el nuevo mundo del trabajo y necesitamos descubrir el uso apropiado de estas herramientas'. No se puede volver a poner la pasta de dientes en el tubo”.

Para Tricia Bertram Gallant, directora de la Oficina de Integridad Académica de la Universidad de California en San Diego y experta nacional en trampas, el tema más importante en el caso de este estudiante no es la tecnología. Ella dice que la pregunta más importante es si las universidades tienen sistemas efectivos para manejar los cargos de mala conducta académica.

"Dudo mucho que un estudiante sea acusado de hacer trampa simplemente con un corrector gramatical y ortográfico", dice, "pero si eso es cierto, los chatbots de IA no son el problema, sino la política y el proceso".

“Si un miembro de la facultad puede usar una herramienta, acusar a un estudiante y darle un cero y listo, eso es un problema”, dice. "Ese no es un problema de herramientas".

Ella dice que conceptualmente, las herramientas de IA no son diferentes de otras formas en que los estudiantes han hecho trampa durante años, como contratar a otros estudiantes para que escriban sus trabajos por ellos.

"Me resulta extraño que las universidades estén generando una política completamente separada para el uso de la IA", afirma. “Todo lo que hicimos en nuestra política fue agregar la palabra 'máquina'”, agrega, señalando que ahora la política de integridad académica prohíbe explícitamente el uso de una máquina para realizar trabajos que debe realizar el estudiante.

Ella sugiere que los estudiantes se aseguren de mantener registros de cómo utilizan cualquier herramienta que les ayude, incluso si un profesor permite el uso de IA en la tarea. "Deben asegurarse de mantener su historial de chat" en ChatGPT, dice, "para poder tener una conversación sobre su proceso" si surge alguna pregunta más adelante.

Un panorama que cambia rápidamente

Si bien los correctores gramaticales y ortográficos existen desde hace años, muchos de ellos ahora están agregando nuevas funciones de inteligencia artificial que complican las cosas para los profesores que intentan comprender si los estudiantes pensaron detrás del trabajo que entregaron.

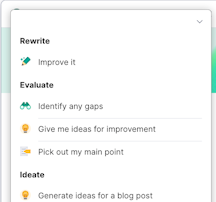

Por ejemplo, Grammarly ahora tiene nuevas opciones, la mayoría de ellas en una versión paga a la que Stevens no se suscribió, que utilizan IA generativa para hacer cosas como "ayudar a generar ideas sobre temas para una tarea" o "construir un plan de investigación", como un reciente comunicado de prensa De la empresa lo puso.

Maxwell, de Grammarly, dice que la compañía está tratando de implementar esas nuevas funciones con cuidado y está tratando de incorporar medidas de seguridad para evitar que los estudiantes simplemente le pidan al robot que haga su trabajo por ellos. Y dice que cuando las escuelas adopten su herramienta, podrán desactivar las funciones de IA generativa. “Soy madre de un niño de 14 años”, dice, y agrega que los estudiantes más jóvenes que todavía están aprendiendo lo básico tienen necesidades diferentes a las de los estudiantes mayores.

Chechitelli, de Turnitin, dice que es un problema para los estudiantes que Grammarly y otras herramientas de productividad ahora integren ChatGPT y hagan mucho más que simplemente arreglar la sintaxis de la escritura. Esto se debe a que, según ella, es posible que los estudiantes no comprendan las nuevas características y sus implicaciones.

"Un día inician sesión y tienen nuevas opciones y opciones diferentes", dice. "Creo que es confuso".

Para el líder de Turnitin, el mensaje más importante para los educadores de hoy es la transparencia sobre qué ayuda proporciona la IA, si la hay.

"Mi consejo sería que pienses bien en las herramientas que estás utilizando y te asegures de poder mostrarles a los profesores la evolución de tus tareas o poder responder preguntas", dice.

Gallant, el experto nacional en integridad académica, dice que los profesores deben ser conscientes del creciente número de herramientas de IA generativa a las que tienen acceso los estudiantes.

"Grammarly va mucho más allá de la revisión gramatical y ortográfica", dice. “Grammarly es como cualquier otra herramienta: puede usarse de manera ética o no ética. Es cómo se usan o cómo se oscurecen sus usos”.

Gallant dice que incluso los profesores topan con estos límites éticos en sus propios escritos y publicaciones en revistas académicas. Ella dice que ha oído hablar de profesores que usan ChatGPT para redactar artículos de revistas y luego "se olvidan de participar en las partes en las que la IA sugiere ideas".

Hay algo seductor en la facilidad con la que estas nuevas herramientas de IA generativa pueden generar textos bien formateados, añade, y eso puede hacer que las personas piensen que están trabajando cuando lo único que están haciendo es poner un mensaje en una máquina.

"Existe una falta de autorregulación (para todos los humanos, pero especialmente para los novatos y los jóvenes) entre el momento en que me ayuda y el momento en que hace el trabajo por mí", dice Gallant.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.edsurge.com/news/2024-04-04-can-using-a-grammar-checker-set-off-ai-detection-software