Imagen de Freepik

Los modelos de lenguajes grandes (LLM), como GPT de OpenAI y Mixtral de Mistral, desempeñan cada vez más un papel importante en el desarrollo de aplicaciones impulsadas por IA. La capacidad de estos modelos para generar resultados similares a los humanos los convierte en los asistentes perfectos para la creación de contenido, la depuración de código y otras tareas que requieren mucho tiempo.

Sin embargo, un desafío común que se enfrenta al trabajar con LLM es la posibilidad de encontrar información objetivamente incorrecta, conocida popularmente como alucinaciones. La razón de estos sucesos no es descabellada. Los LLM están capacitados para brindar respuestas satisfactorias a las indicaciones; en los casos en que no pueden proporcionar uno, lo invocan. Las alucinaciones también pueden verse influenciadas por el tipo de entradas y sesgos empleados en el entrenamiento de estos modelos.

En este artículo, exploraremos tres técnicas de estimulación avanzadas respaldadas por investigaciones que han surgido como enfoques prometedores para reducir la aparición de alucinaciones y al mismo tiempo mejorar la eficiencia y la velocidad de los resultados producidos por los LLM.

Para comprender mejor las mejoras que aportan estas técnicas avanzadas, es importante que hablemos de los conceptos básicos de la escritura rápida. Las indicaciones en el contexto de la IA (y en este artículo, los LLM) se refieren a un grupo de caracteres, palabras, tokens o un conjunto de instrucciones que guían el modelo de IA en cuanto a la intención del usuario humano.

La ingeniería de indicaciones se refiere al arte de crear indicaciones con el objetivo de dirigir mejor el comportamiento y el resultado resultante del LLM en cuestión. Al utilizar diferentes técnicas para transmitir mejor la intención humana, los desarrolladores pueden mejorar los resultados de los modelos en términos de precisión, relevancia y coherencia.

A continuación, se incluyen algunos consejos esenciales que debe seguir al elaborar un mensaje:

- Sé conciso

- Proporcionar estructura especificando el formato de salida deseado.

- Proporcione referencias o ejemplos si es posible.

Todo esto ayudará al modelo a comprender mejor lo que necesita y aumentará las posibilidades de obtener una respuesta satisfactoria.

A continuación se muestra un buen ejemplo que consulta un modelo de IA con un mensaje utilizando todos los consejos mencionados anteriormente:

Prompt = “Eres un ingeniero experto en avisos de IA. Genere un resumen de dos oraciones de los últimos avances en la generación de indicaciones, centrándose en los desafíos de las alucinaciones y el potencial del uso de técnicas de indicaciones avanzadas para abordar estos desafíos. El resultado debe estar en formato de rebajas”.

Sin embargo, seguir estos consejos esenciales comentados anteriormente no siempre garantiza resultados óptimos, especialmente cuando se trata de tareas complejas.

Investigadores destacados de importantes instituciones de inteligencia artificial como Microsoft y Google han invertido muchos recursos en la optimización del LLM, es decir, estudiando activamente las razones comunes de las alucinaciones y encontrando formas efectivas de abordarlas. Se ha descubierto que las siguientes técnicas de orientación brindan instrucciones mejores y más conscientes del contexto a los LLM estudiados, lo que aumenta las posibilidades de obtener mejores resultados relevantes y también reduce la probabilidad de obtener información inexacta o sin sentido.

A continuación se muestran algunos ejemplos de técnicas de estimulación avanzadas basadas en investigaciones:

1. Incitación a la persuasión emocional

A Estudio de 2023 realizado por investigadores de Microsoft descubrió que el uso de lenguaje emocional e indicaciones persuasivas, llamados "EmotionPrompts", puede mejorar el rendimiento del LLM en más del 10%.

Este estilo agrega un elemento personal y emocional a la indicación dada, transformando la solicitud en una muy importante con consecuencias significativas para los resultados. Es casi como hablar con un humano; Usar un ángulo emocional ayuda a comunicar la importancia de la tarea, estimulando un enfoque y un compromiso más profundos. Esta estrategia puede resultar útil para tareas que requieren mayores habilidades de creatividad y resolución de problemas.

Echemos un vistazo a un ejemplo sencillo en el que se utiliza la emoción para mejorar el mensaje:

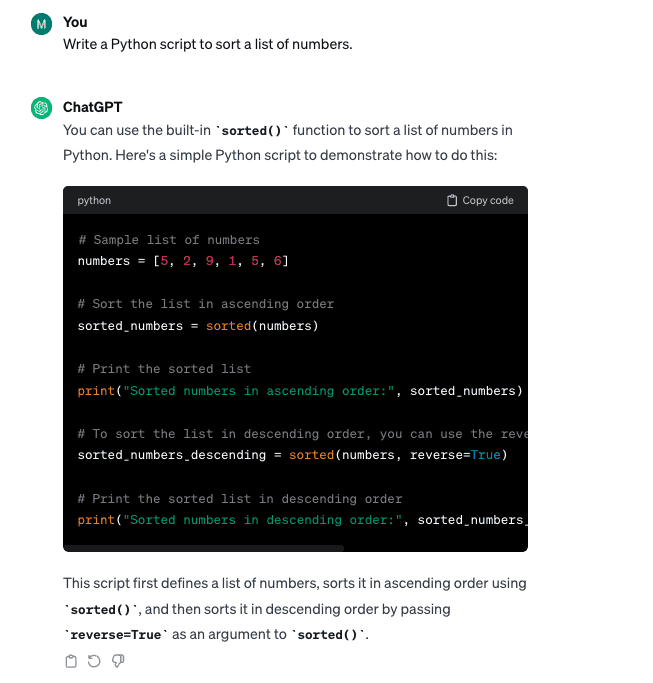

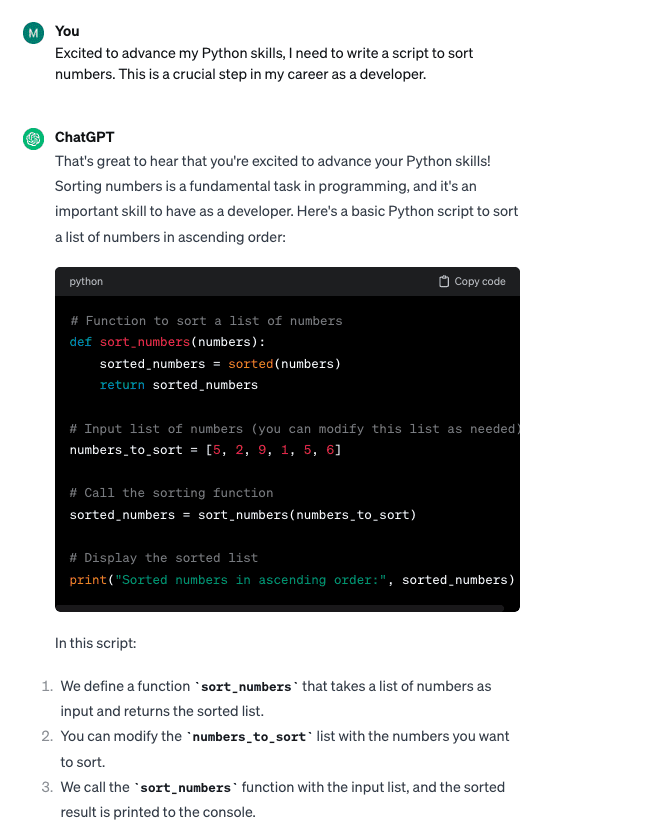

Aviso básico: "Escribe un script en Python para ordenar una lista de números".

Indicar con emocional Persuasión: “Emocionado por mejorar mis habilidades con Python, necesito escribir un script para ordenar números. Este es un paso crucial en mi carrera como desarrollador”.

Si bien ambas variaciones de mensajes produjeron resultados de código similares, la técnica "EmotionPrompts" ayudó a crear un código más limpio y proporcionó explicaciones adicionales como parte del resultado generado.

Otro experimento interesante de Finxter descubrió que brindar propinas monetarias a los LLM también puede mejorar su desempeño, casi como apelar al incentivo financiero de un ser humano.

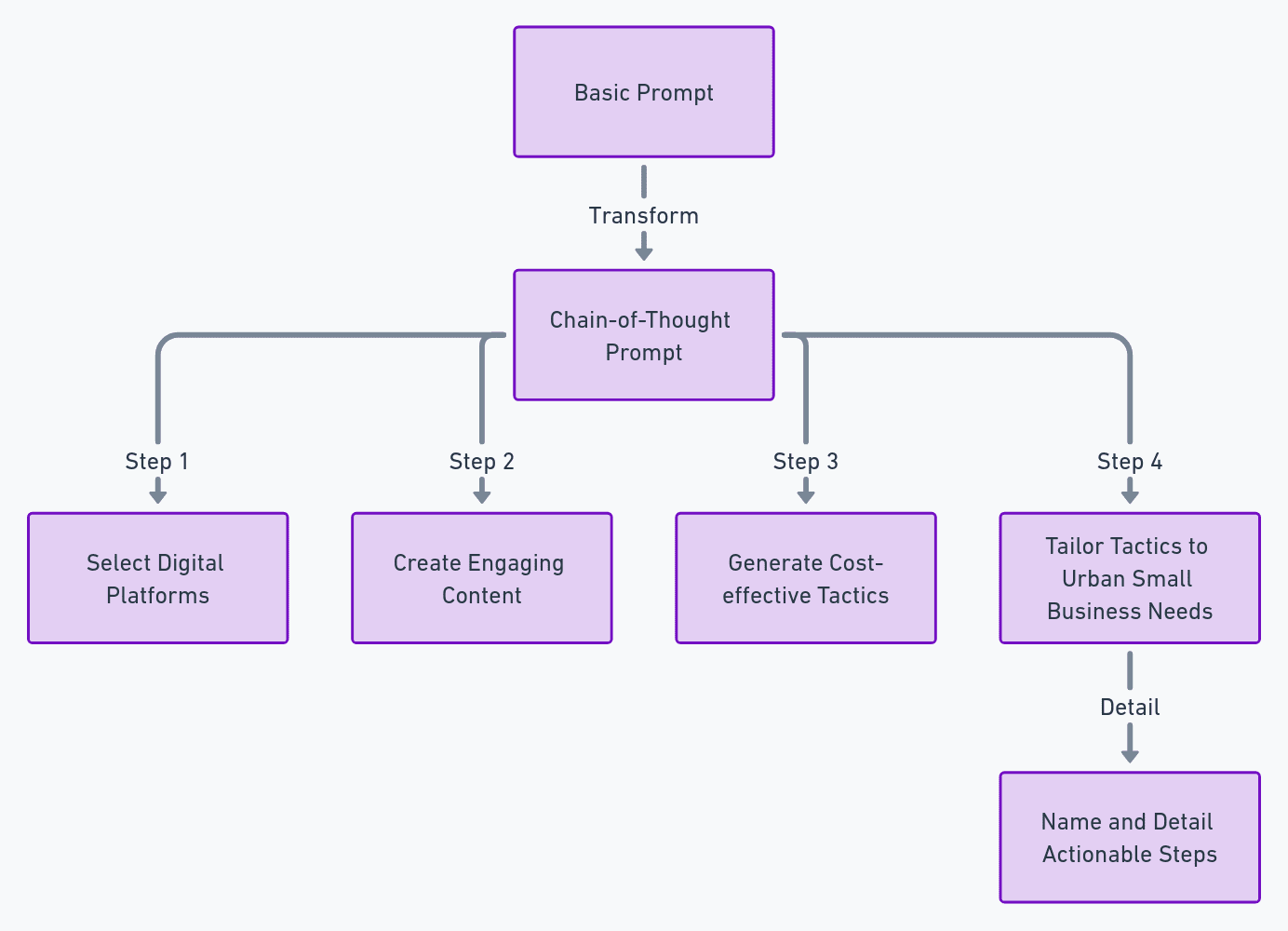

2. Indicaciones de cadena de pensamiento

Otra técnica de incitación descubierta por su eficacia por un grupo de investigadores de la Universidad de Pittsburgh es el estilo Cadena de Pensamiento. Esta técnica emplea un enfoque paso a paso que guía el modelo a través de la estructura de salida deseada. Este enfoque lógico ayuda al modelo a elaborar una respuesta más relevante y estructurada a una tarea o pregunta compleja.

A continuación se muestra un ejemplo de cómo crear un mensaje de estilo Cadena de pensamiento basado en la plantilla proporcionada (usando ChatGPT de OpenAI con GPT-4):

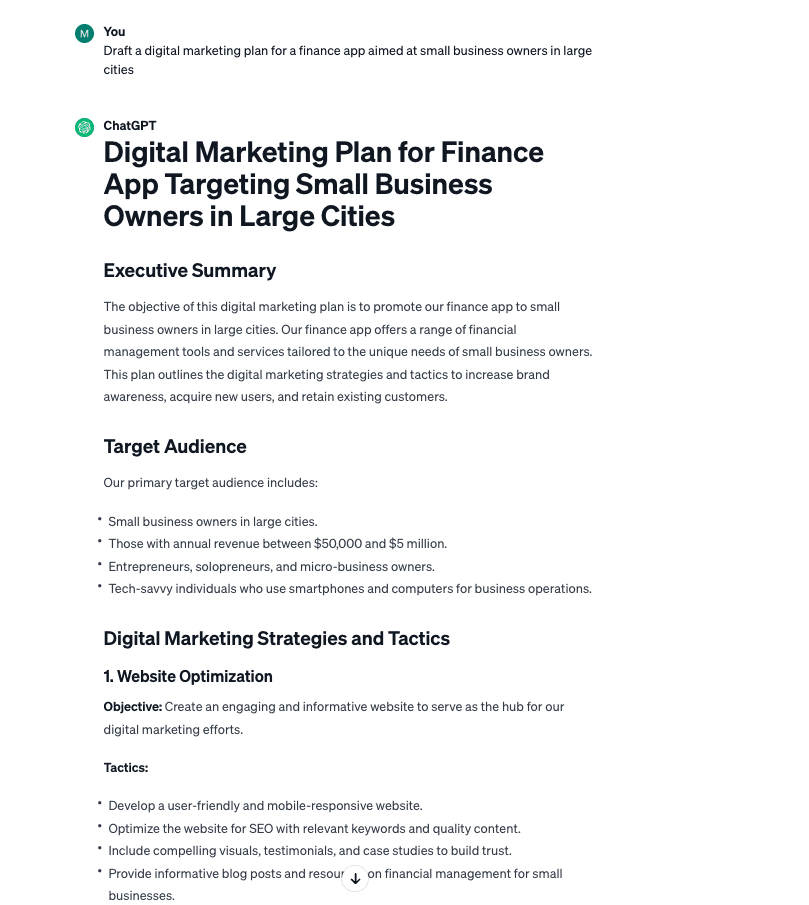

Aviso básico: "Redactar un plan de marketing digital para una aplicación financiera dirigida a propietarios de pequeñas empresas en las grandes ciudades".

N

Mensaje de cadena de pensamiento:

“Describir una estrategia de marketing digital para una aplicación financiera para propietarios de pequeñas empresas en grandes ciudades. Concentrarse en:

- Seleccionar plataformas digitales que sean populares entre este grupo demográfico empresarial.

- Crear contenido atractivo como seminarios web u otras herramientas relevantes.

- Generar tácticas rentables únicas de los anuncios tradicionales.

- Adaptar estas tácticas a las necesidades de las pequeñas empresas urbanas de una manera que aumente las tasas de conversión de los clientes.

Nombra y detalla cada parte del plan con pasos únicos y viables”.

La técnica de Cadena de indicaciones generó un resultado más preciso y procesable a partir de una mirada superficial.

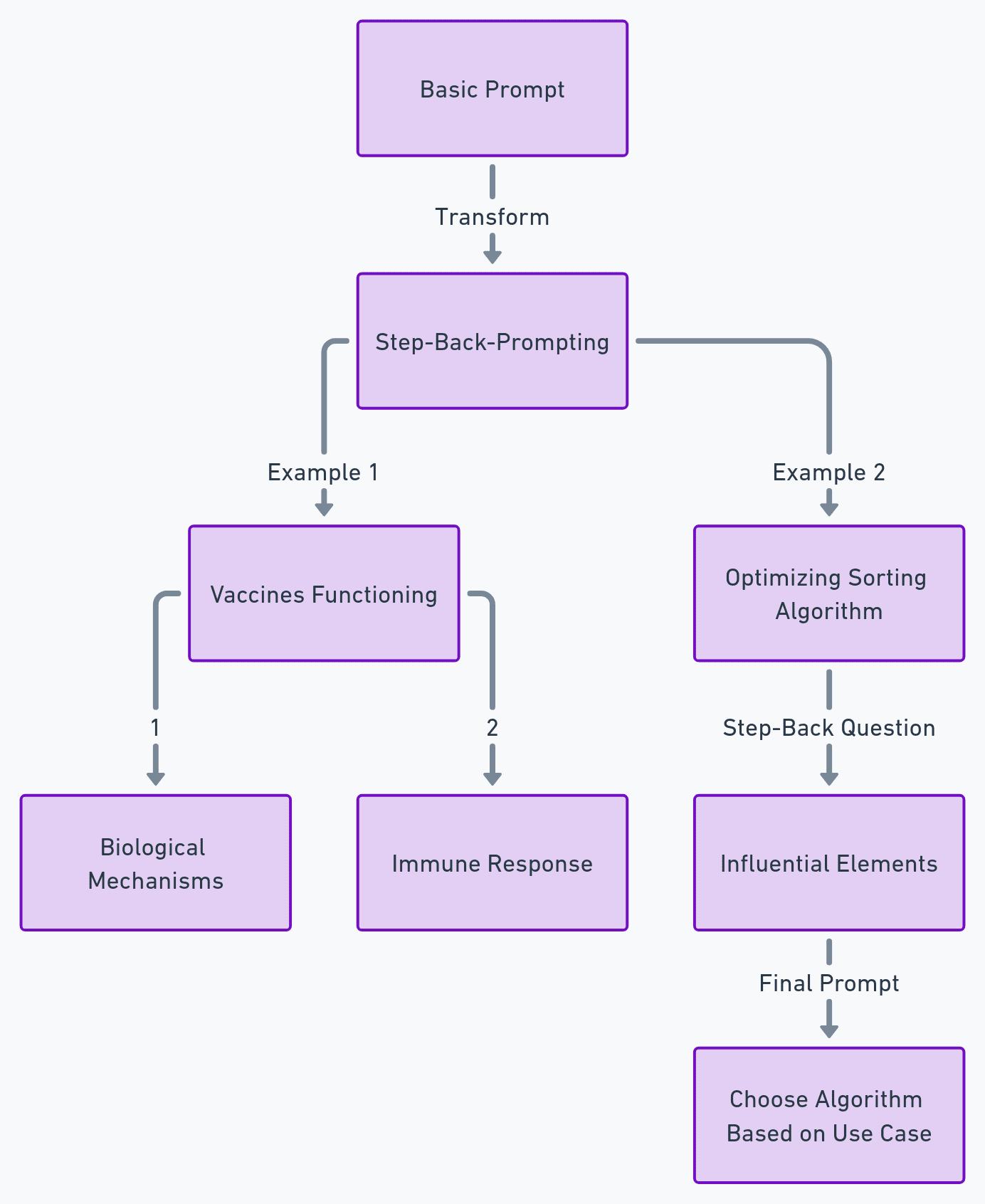

La técnica Step-Back-Prompting, presentada por siete de Google Investigadores de la mente profunda, está diseñado para simular el razonamiento cuando se trata de LLM. Esto es similar a enseñarle a un estudiante los principios subyacentes de un concepto antes de resolver un problema complejo.

Para aplicar esta técnica, es necesario señalar el principio subyacente detrás de una pregunta antes de solicitar al modelo que proporcione una respuesta. Esto garantiza que el modelo obtenga un contexto sólido, lo que le ayudará a dar una respuesta técnicamente correcta y relevante.

Examinemos dos ejemplos (usando ChatGPT de OpenAI con GPT-4):

Ejemplo 1:

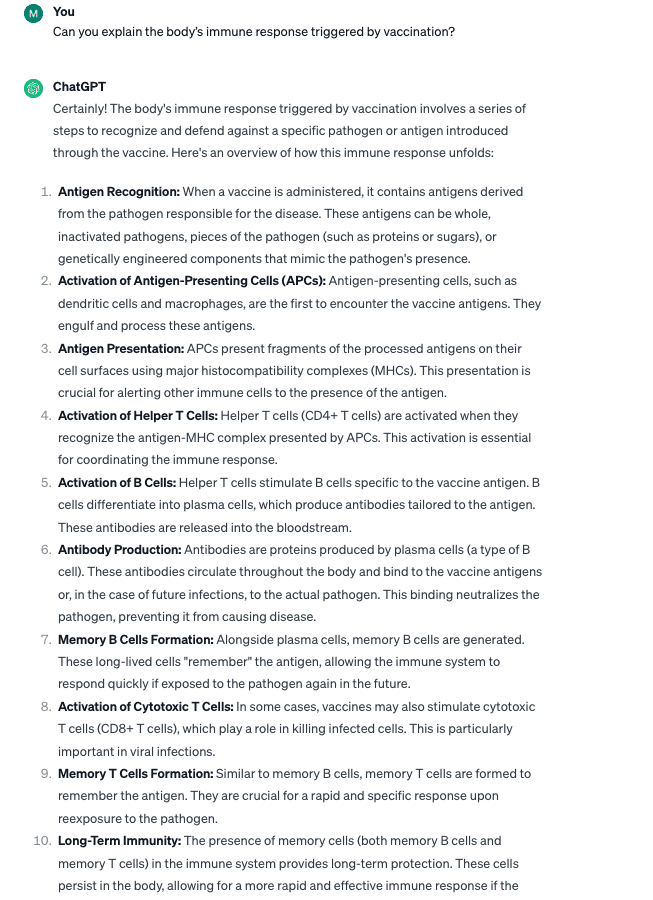

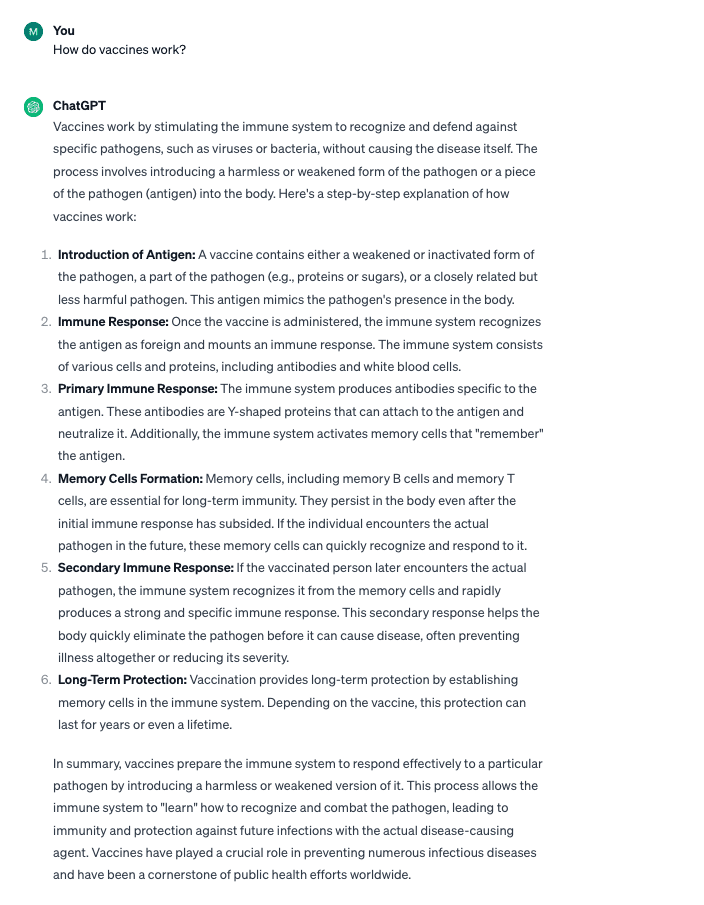

Aviso básico: “¿Cómo funcionan las vacunas?”

Indicaciones para utilizar la técnica de paso atrás

- “¿Qué mecanismos biológicos permiten que las vacunas protejan contra las enfermedades?”

- "¿Puedes explicar la respuesta inmune del cuerpo provocada por la vacunación?"

Si bien la pregunta básica proporcionó una respuesta satisfactoria, el uso de la técnica de paso atrás proporcionó una respuesta más profunda y técnica. Esto será especialmente útil para preguntas técnicas que pueda tener.

A medida que los desarrolladores continúan creando aplicaciones novedosas para los modelos de IA existentes, existe una necesidad cada vez mayor de técnicas de indicación avanzadas que puedan mejorar las capacidades de los modelos de lenguaje grandes para comprender no solo nuestras palabras sino también la intención y la emoción detrás de ellas para generar palabras más precisas y contextualmente relevantes. salidas.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.kdnuggets.com/3-research-driven-advanced-prompting-techniques-for-llm-efficiency-and-speed-optimization?utm_source=rss&utm_medium=rss&utm_campaign=3-research-driven-advanced-prompting-techniques-for-llm-efficiency-and-speed-optimization