Introducción

La crisis financiera mundial de 2007 ha tenido un efecto duradero en las economías de muchos países. En el colapso financiero y económico épico, muchos perdieron sus trabajos, ahorros y mucho más. Cuando se restringe demasiado riesgo a muy pocos jugadores, se considera una falla notable del marco de gestión de riesgos. Desde la crisis financiera mundial, ha habido un rápido aumento en la popularidad de términos como “quiebra”, “incumplimiento” y “angustia financiera”. El proceso de previsión de dificultades/incumplimiento/quiebra se considera ahora una herramienta importante para la toma de decisiones financieras y el principal impulsor del riesgo crediticio. La Gran Depresión de 1932, la Crisis de Suez de 1956, la Crisis de la Deuda Internacional de 1982 y la última recesión de 2007 han empujado al mundo a tratar de averiguar la predicción de la caída lo antes posible.

Fuente: Imagen de pikisuperestrella on Freepik

Predecir dificultades financieras y quiebras es una aplicación que ha recibido mucha atención en los últimos años, gracias al entusiasmo que rodea a la tecnología financiera (FinTech) y al rápido progreso continuo de la IA. Las instituciones financieras pueden usar puntajes de crédito para ayudarse a decidir si conceder o no crédito a un prestatario, lo que aumenta la probabilidad de que se nieguen las solicitudes de los prestatarios riesgosos. Además de las dificultades causadas por los datos ruidosos y muy desequilibrados, ahora hay nuevas reformas regulatorias que deben cumplirse, como Reglamento General de Protección de Datos (GDPR). Los reguladores esperan que la interpretabilidad del modelo esté ahí para garantizar que los hallazgos algorítmicos sean comprensibles y consistentes. Como la pandemia de COVID-19 daño los mercados financieros, se requiere una mejor comprensión de los préstamos para evitar una situación como la de 2007.

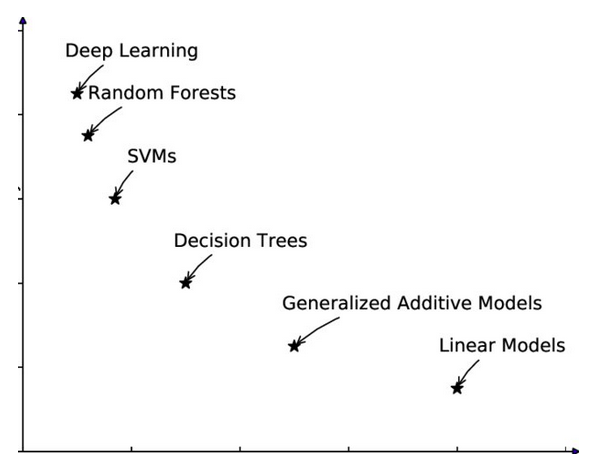

Balance: Interpretabilidad y Precisión

Los modelos de calificación crediticia o los modelos de predicción de bancarrota, que predicen si un individuo devolverá el dinero del prestamista o si una empresa se declarará en bancarrota, deben abordar la alta precisión y la interpretabilidad. Dos amigos míos de la misma universidad en los EE. UU., con aproximadamente el mismo salario, la misma edad y muchos más parámetros equivalentes, solicitaron un préstamo hipotecario. Uno obtuvo la aprobación de su préstamo, mientras que el otro enfrentó un rechazo. ¿No crees que el rechazado merece una respuesta? ¿Qué pasa si una corporación solicitó un préstamo para expansión, pero el banco decidió no ofrecer crédito?

Interpretación

Con el crecimiento de varias variables independientes relevantes (puntuación de sentimiento de estados financieros y ratios), ha surgido una evidente dificultad de interpretación. En el pasado, un número mínimo de variables independientes y un modelo básico eran suficientes para que el modelo se interpretara fácilmente. Como resultado, la investigación que apuntaba a seleccionar las variables más significativas y simular la insolvencia en función de las características elegidas y un modelo estadístico simple ganó mucha popularidad. El uso de algoritmos de aprendizaje automático es otro método para manejar características que no siempre están limitadas en número.

Fuente: Imagen de Guo et al. (2019) – Puerta de la investigación

Exactitud

La técnica convencional basada en la selección de funciones y el enfoque basado en el aprendizaje automático tienen ventajas y desventajas. Los enfoques basados en la selección de características son fácilmente interpretables ya que utilizan un pequeño número de variables que han sido seleccionadas como significativas para la predicción de un evento, quiebra/incumplimiento, en el contexto de este artículo. Los enfoques basados en la selección de características suelen utilizar un modelo de predicción básico, como una función multivariada. Sin embargo, la precisión es mucho menor en comparación con los modelos basados en aprendizaje automático. Por el contrario, aunque los enfoques basados en el aprendizaje automático logran una mayor precisión, estos modelos son demasiado complejos para comprenderlos fácilmente.

IA explicable para humanos – XAI

Fuente: Imagen de Caltech

La inteligencia artificial explicable (XAI) intenta simplificar los modelos de caja negra y hacerlos más interpretables. Permite a los humanos comprender y confiar en la salida del algoritmo de aprendizaje automático. Describe la precisión, la transparencia y los resultados del modelo de toma de decisiones impulsado por IA. La explicabilidad y la transparencia tan necesarias ayudan a las organizacionesenfoque IA de manera diferente. El éxito del aprendizaje automático ha provocado una avalancha de aplicaciones de IA. Sin embargo, la incapacidad de la máquina para explicar sus acciones a los humanos limita la eficacia de estos sistemas. A medida que avanza la IA, los humanos luchan por comprender y rastrear los resultados del algoritmo.

Fuente: Imagen de freepik en Freepik

Cuando se presenta un modelo basado en ML, las técnicas XAI se pueden usar para auditar el modelo y ponerlo a prueba para ver si puede proporcionar resultados precisos de manera consistente en diferentes casos de uso relacionados con la calificación crediticia y la predicción de dificultades. Estas técnicas, por ejemplo, evalúan la consistencia de las reglas de predicción del modelo con la información previa sobre el problema de negocios, que puede ayudar a revelar desafíos que pueden obstaculizar la precisión del modelo cuando se aplica a datos fuera de la muestra. Problemas en el conjunto de datos que se utilizan para entrenar el modelo, como un incompleto o sesgado la representación de la población de interés o las condiciones de entrenamiento que llevan al modelo a aprender reglas de pronóstico defectuosas, pueden ser descubiertas por las técnicas XAI.

Después de Covid, XAI ha dado grandes pasos para abordar los problemas comerciales relacionados con el crédito:

- Zest's La tecnología basada en inteligencia artificial permite a los prestamistas ajustar los modelos para que sean justos al reducir el impacto de los datos crediticios discriminatorios sin comprometer el rendimiento.

- FICO ha declarado públicamente su intención de complementar la comprensión del dominio humano con inteligencia artificial para permitir el rápido desarrollo de modelos de calificación de riesgo crediticio altamente predictivos y explicables.

- Orcolo libera a los prestamistas de conjuntos de datos sesgados y los ayuda a analizar los datos financieros de manera más eficiente. El software de Ocrolus analiza extractos bancarios, talones de pago, documentos fiscales, formularios de hipotecas, facturas y otros documentos para determinar la elegibilidad del préstamo para una hipoteca, empresa, consumo, calificación crediticia y KYC.

- Suscribir.ai utilizó modelos algorítmicos no lineales para estimar el riesgo crediticio en áreas con un uso mínimo o nulo del buró de crédito.

- Temenos lanzó modelos XAI transparentes entregados como SaaS para ayudar a los bancos y cooperativas de crédito a acelerar la incorporación digital y el procesamiento de préstamos para enfrentar los desafíos Post Covid sobre la industria crediticia.

Modelos: Moderno vs. Convencional

Las técnicas modernas de aplicación de modelos de aprendizaje automático a la calificación crediticia para la predicción de incumplimiento en el sector financiero sin duda han dado como resultado mayor rendimiento predictivo que los modelos clásicos como las regresiones logísticas. Las nuevas tecnologías digitales han impulsado la adopción de modelos de aprendizaje automático, lo que permite a las instituciones financieras adquirir y utilizar conjuntos de datos más grandes que comprende muchas características y observaciones para el entrenamiento del modelo. Los enfoques de aprendizaje automático, a diferencia de los modelos convencionales como el modelo logit, pueden descubrir experimentalmente no linealidades en las conexiones entre la variable de resultado y sus predictores y los efectos de interacción entre estos últimos. Como resultado, cuando el conjunto de datos de entrenamiento es lo suficientemente grande, se cree que los modelos ML superan a los modelos estadísticos clásicos que se usan regularmente en la evaluación crediticia. Como resultado, una mayor precisión en el pronóstico de incumplimiento puede beneficiar a las instituciones crediticias a través de menos pérdidas crediticias y ahorros relacionados con el capital regulatorio.

Papel de los reguladores

Los reguladores financieros recientemente expresaron un fuerte apoyo para que las instituciones financieras usen modelos de aprendizaje automático y tradicional simultáneamente, con humanos asignados para manejar cualquier discrepancia significativa. La mayoría de los reguladores financieros no limitan dónde o cómo las instituciones crediticias pueden usar cajas negras. Aún así, Alemania Autoridad Federal de Supervisión Financiera ha recomendado que las instituciones consideren las ventajas de utilizar un modelo más complejo y registren por qué optaron por alternativas interpretables. En palabras de muchos formuladores de políticas, no existe un método universal para evaluar costos y beneficios. Sugieren que los bancos consideren la justificación del modelo, el contexto de implementación y el objetivo antes de implementarlo. El trabajo patentado ha sido realizado por Equifax, que utiliza redes neuronales para analizar el riesgo crediticio del consumidor y ofrece códigos de razón que ayudan a las empresas a cumplir con las obligaciones regulatorias.

Fuente: Imagen de freepik en Freepik

Información procesable para los clientes

Las técnicas XAI para modelos relacionados con el crédito se adaptan fácilmente a las decisiones binarias de los consumidores, incluidos "prestar" y "no prestar". Las explicaciones proporcionadas por las técnicas XAI pueden no considerar aspectos cruciales de los préstamos, como la tasa de interés, el calendario de reembolso, los cambios en el límite de crédito o las preferencias de préstamo del cliente. Sin embargo, las instituciones financieras que utilicen XAI deberán informar a los clientes por qué se denegaron sus solicitudes de préstamo y cómo mejorar sus credenciales. Imagine que se le sugiere al cliente que obtenga un aumento en su salario o en sus calificaciones educativas o se le pide que pague las facturas de su tarjeta de crédito a tiempo durante algunos meses para obtener la aprobación del préstamo. Esto no es más que información procesable que un cliente puede utilizar y volver a solicitar el préstamo.

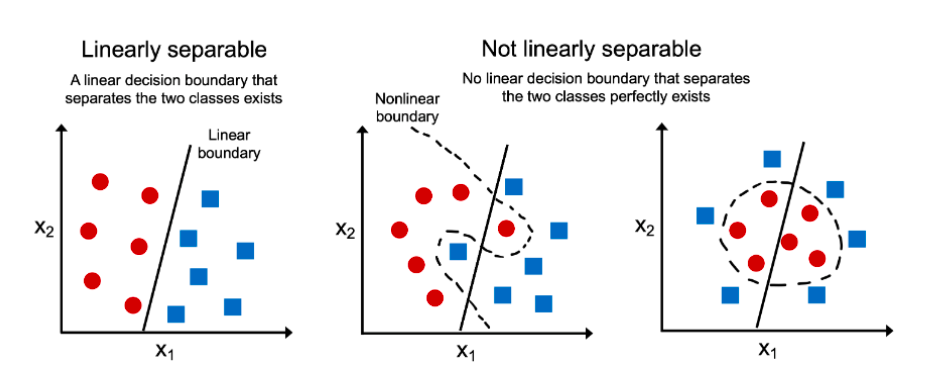

El éxito no es lineal, ¿o sí?

Numerosas instituciones financieras ahora están investigando algoritmos inherentemente interpretables, como regresión lineal, regresión logística, aumento de gradiente explicable y redes neuronales. Consistentemente, existe el deseo de investigar nuevas técnicas para desarrollar modelos que sean transparentes por diseño y que no requieran una explicación post-hoc. Explicación de modelos preconstruidos de manera post hoc es la otra parte de la historia. Una red neuronal profunda con, digamos, 200 capas o un modelo de caja negra pasa las entradas al algoritmo explicativo, que divide aún más el modelo complejo en piezas más pequeñas y simples que son más fáciles de comprender. Estos resultados más simples también consistirían en una lista de características y parámetros que son significativos para el problema comercial. En los dos escenarios anteriores, una compensación entre alta precisión e interpretabilidad es la necesidad de la hora.

Fuente: Imagen de Ajitesh Kumar en flujo vital

SHAP (SHapley Additive exPlanation) y LIME (Local Interpretable Model-agnostic Explanations) son enfoques de explicabilidad ampliamente utilizados. SHAP utiliza los valores de Shapley para calificar la influencia de las características del modelo. Los valores de Shapley consideran todas las predicciones factibles utilizando todas las entradas. El enfoque minucioso de SHAP garantiza la coherencia y la corrección local. Por otro lado, LIME construye modelos lineales dispersos alrededor de cada predicción para describir cómo opera localmente el modelo de caja negra.

Más importante aún, ¿qué es más relevante, un modelo preciso o un modelo que las empresas y los clientes puedan entender fácilmente? Si los datos son linealmente separables, podemos crear un inherentemente interpretable y modelo preciso. Pero si los datos son complicados y los límites de decisión no son rectos, es posible que tengamos que mirar el modelo complicado para asegurarnos de que sea correcto y luego pensar en explicaciones post-hoc.

Conclusión

En un mundo ideal, la explicabilidad ayuda a las personas a comprender cómo funciona un modelo y cuándo usarlo. Las instituciones crediticias, los organismos reguladores y el gobierno deben colaborar para desarrollar pautas de IA que protejan los intereses de los clientes. Si los diferentes grupos no aclaran los objetivos de la explicabilidad, la IA servirá a los intereses de unos pocos, como sucedió durante la crisis financiera mundial de 2007. Una solución XAI bien diseñada considera las necesidades de las partes interesadas y personaliza la explicación. Los algoritmos de IA y Machine Learning ya han revolucionado las operaciones de instituciones crediticias. Algunas de las conclusiones clave sobre XAI son las siguientes:

- Precisión/rendimiento del modelo frente a interpretabilidad: XAI tiene como objetivo hacer que los modelos de IA sean más intuitivos y comprensibles sin sacrificar la precisión/el rendimiento.

- Implementación y escalado de XAI: la inexplicabilidad ha impedido durante mucho tiempo que las instituciones crediticias utilicen completamente la IA. Sin embargo, XAI ha ayudado a las instituciones no solo con una incorporación fluida, sino también con la personalización.

- AITransparency responsable: cómo el modelo de crédito alcanzó un resultado y utilizando qué parámetros.

- Informatividad (brindar a los humanos nueva información para ayudarlos a tomar decisiones) y Estimación de incertidumbre (descubrir qué tan incierto es un resultado) (cuantificar qué tan confiable es una predicción).

Relacionado:

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://www.analyticsvidhya.com/blog/2022/12/xai-accuracy-vs-interpretability-for-credit-related-model/