Exclusiva En julio, la Casa Blanca anunció que siete grandes actores tecnológicos se habían comprometido a adoptar medidas de seguridad de la IA, incluida la implementación de marcas de agua para garantizar que el contenido generado algorítmicamente pueda distinguirse del trabajo de personas reales.

Entre esos gigantes, Amazon, Googley OpenAI Todos han citado específicamente las marcas de agua (técnicas para agregar información a texto e imágenes que dan fe de la procedencia del contenido) como una forma de defenderse contra la desinformación, el fraude y los deepfakes producidos por sus modelos generativos de IA.

El objetivo aquí es que el material generado por IA se marque sutilmente para que pueda ser detectado e identificado como tal si alguien intenta hacer pasar el contenido como creado por humanos.

Pero los académicos han advertido que las marcas de agua digitales en las imágenes (agregar ruido cuando se crea el contenido y luego detectar la presencia de ese patrón de ruido dentro de los conjuntos de datos de imágenes) pueden no ofrecer mucha garantía de seguridad.

Un equipo de la Universidad de Maryland, en Estados Unidos, investigó la confiabilidad de las técnicas de marcas de agua para imágenes digitales y descubrió que pueden eliminarse con bastante facilidad. Ellos describir sus hallazgos en un artículo preimpreso cuya publicación está prevista para esta tarde en ArXiv, "Robustitud de los detectores de imágenes de IA: límites fundamentales y ataques prácticos".

Los enfoques adoptados por Google y otros gigantes tecnológicos para marcar con agua la salida de sus imágenes generativas como defensa no van a funcionar.

"En este trabajo, revelamos vulnerabilidades fundamentales y prácticas de las marcas de agua de imágenes como defensa contra los deepfakes", dijo Soheil Feizi, profesor asociado de ciencias de la computación en la Universidad de Maryland, en un correo electrónico a El registro.

"Esto muestra que los enfoques actuales adoptados por Google y otros gigantes tecnológicos para marcar con agua la salida de sus imágenes generativas como defensa no van a funcionar".

Los hallazgos de los expertos de la Universidad de Maryland –Mehrdad Saberi, Vinu Sankar Sadasivan, Keivan Rezaei, Aounon Kumar, Atoosa Chegini, Wenxiao Wang y Soheil Feizi– indican que existe una compensación fundamental entre la tasa de error de evasión (el porcentaje de marcas de agua imágenes detectadas como sin marcar, es decir, falsos negativos) y la tasa de error de suplantación de identidad (el porcentaje de imágenes sin marcar detectadas como con marca de agua, falsos positivos).

Para decirlo de otra manera, los esquemas de detección de marcas de agua pueden tener un alto rendimiento (pocos falsos negativos) o una gran solidez (pocos falsos positivos), pero no ambas cosas a la vez.

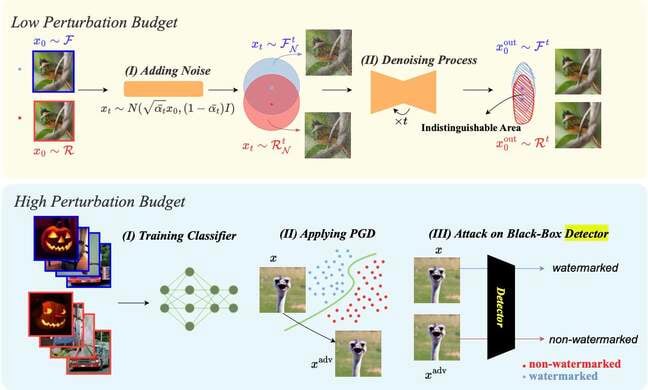

Los autores del artículo han ideado una técnica de ataque para imágenes de baja perturbación (con marcas de agua imperceptibles) llamada purificación por difusión que se propuso originalmente como defensa contra ejemplos adversos – entrada que deliberadamente hace que un modelo cometa errores. Implica agregar ruido gaussiano a las imágenes y luego utilizar el proceso de eliminación de ruido de los modelos de difusión para eliminar los datos agregados.

Gráfico de Robustez de los detectores de imágenes de IA: límites fundamentales y ataques prácticos... Haga clic para ampliar

Y para las imágenes de alta perturbación (marcas de agua perceptibles) que no están abiertas al ataque de purificación por difusión, los investigadores desarrollaron un mecanismo de suplantación de identidad que tiene el potencial de hacer que las imágenes sin marcas de agua parezcan tener marcas de agua. Ese escenario, dicen los autores, podría tener consecuencias financieras o de relaciones públicas adversas para las empresas que venden modelos de IA.

"Nuestro ataque [de alta perturbación] funciona ordenando a los modelos de marca de agua que coloquen una marca de agua en una imagen de ruido blanco y luego mezclando esta imagen ruidosa con marca de agua con otras sin marca de agua para engañar al detector para que las marque como marca de agua", explica el artículo.

Cuando se les preguntó si existen paralelos en la cada vez menor brecha entre humanos y máquinas en el rompecabezas de imágenes CAPTCHA para detectar diferencias entre contenido generado por humanos y máquinas, Feizi y Mehrdad Saberi, estudiante de doctorado en la Universidad de Maryland y autor principal del artículo, dijeron que la máquina El aprendizaje es cada vez más capaz.

"Es innegable que el aprendizaje automático avanza día a día, demostrando el potencial de igualar o incluso superar el desempeño humano", dijeron Feizi y Saberi en un correo electrónico a El registro.

“Esto sugiere que tareas como descifrar imágenes CAPTCHA o generar texto pueden ya estar dentro de las capacidades de la IA, rivalizando con la competencia humana.

“En el caso de generar imágenes y vídeos, el contenido generado por IA se está volviendo cada vez más parecido al contenido real, y la tarea de distinguirlos entre sí podría resultar imposible en un futuro próximo, independientemente de la técnica que se utilice. De hecho, en nuestro trabajo mostramos una compensación entre robustez y confiabilidad para los detectores de deepfake basados en clasificación”.

El registro pidió a Google y OpenAI que comentaran, y ninguno respondió.

Feizi y Saberi dijeron que no analizaron específicamente Google o los mecanismos de marca de agua de OpenAI porque ninguna de las empresas había hecho público su código fuente de marca de agua.

"Pero nuestros ataques son capaces de romper todas las marcas de agua existentes que hemos encontrado", dijeron.

“Al igual que otros problemas en la visión por computadora (por ejemplo, la robustez del adversario), creemos que la marca de agua en las imágenes será una carrera entre defensas y ataques en el futuro. Entonces, si bien en el futuro podrían proponerse nuevos métodos sólidos de marcas de agua, también se propondrán nuevos ataques para romperlas”. ®

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://go.theregister.com/feed/www.theregister.com/2023/10/02/watermarking_security_checks/