Introducción

Un equipo de informáticos ha creado un tipo más ágil y flexible del modelo de aprendizaje automático. El truco: debe olvidar periódicamente lo que sabe. Y si bien este nuevo enfoque no desplazará los enormes modelos que sustentan las aplicaciones más grandes, podría revelar más sobre cómo estos programas entienden el lenguaje.

La nueva investigación marca "un avance significativo en el campo", dijo Jea Kwon, ingeniero de inteligencia artificial del Instituto de Ciencias Básicas de Corea del Sur.

Los motores de lenguaje de IA que se utilizan hoy en día funcionan principalmente con redes neuronales artificiales. Cada "neurona" de la red es una función matemática que recibe señales de otras neuronas similares, ejecuta algunos cálculos y envía señales a través de múltiples capas de neuronas. Inicialmente el flujo de información es más o menos aleatorio, pero a través del entrenamiento, el flujo de información entre neuronas mejora a medida que la red se adapta a los datos del entrenamiento. Si un investigador de IA quiere crear un modelo bilingüe, por ejemplo, entrenaría el modelo con una gran pila de texto de ambos idiomas, lo que ajustaría las conexiones entre las neuronas de tal manera que relacionara el texto en un idioma con equivalente. palabras en el otro.

Pero este proceso de formación requiere mucha potencia informática. Si el modelo no funciona muy bien, o si las necesidades del usuario cambian posteriormente, es complicado adaptarlo. "Supongamos que tiene un modelo que tiene 100 idiomas, pero imagine que un idioma que desea no está cubierto", dijo mikel artetxe, coautor de la nueva investigación y fundador de la startup de IA Reka. "Se podría empezar de cero, pero no es lo ideal".

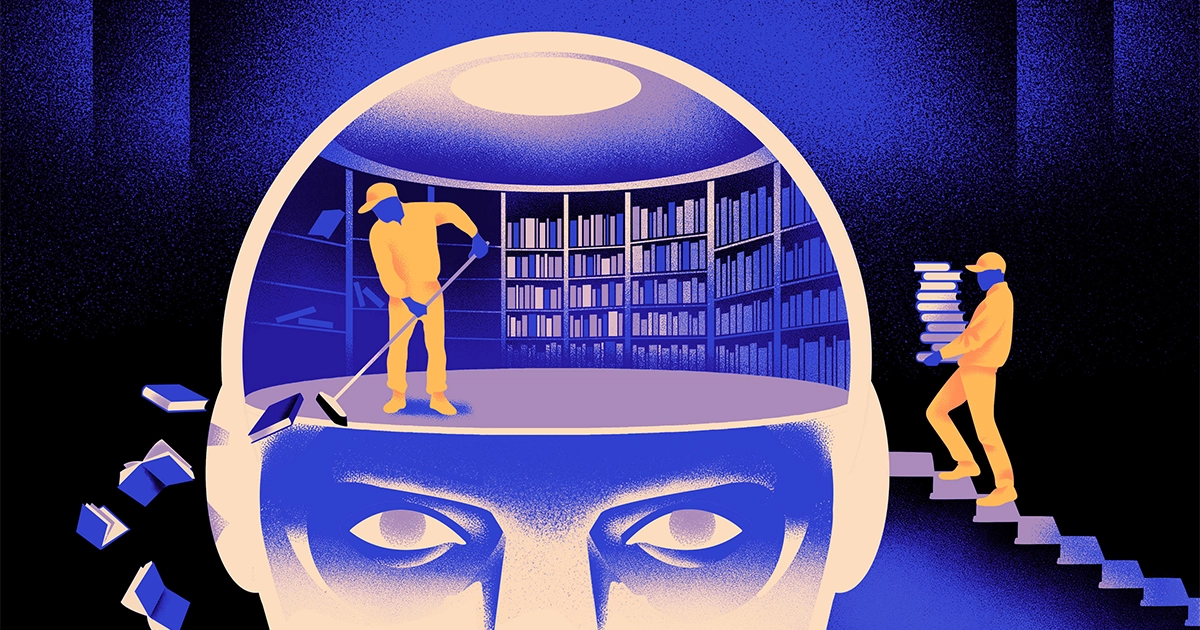

Artetxe y sus compañeros han intentado sortear estas limitaciones. Hace unos pocos años, Artetxe y otros entrenaron una red neuronal en un idioma y luego borraron lo que sabía sobre los componentes básicos de las palabras, llamados tokens. Estos se almacenan en la primera capa de la red neuronal, llamada capa de incrustación. Dejaron todas las demás capas del modelo en paz. Después de borrar los tokens del primer idioma, volvieron a entrenar el modelo en el segundo idioma, lo que llenó la capa de incrustación con nuevos tokens de ese idioma.

Aunque el modelo contenía información que no coincidía, el reentrenamiento funcionó: el modelo pudo aprender y procesar el nuevo lenguaje. Los investigadores supusieron que mientras la capa de incrustación almacenaba información específica de las palabras utilizadas en el idioma, los niveles más profundos de la red almacenaban información más abstracta sobre los conceptos detrás de los idiomas humanos, lo que luego ayudaba al modelo a aprender el segundo idioma.

“Vivimos en el mismo mundo. Conceptualizamos las mismas cosas con diferentes palabras” en diferentes idiomas, dijo Yi Hong Chen, autor principal del artículo reciente. “Es por eso que el modelo tiene el mismo razonamiento de alto nivel. Una manzana es algo dulce y jugoso, en lugar de sólo una palabra”.

Introducción

Si bien este enfoque de olvido era una forma efectiva de agregar un nuevo lenguaje a un modelo ya entrenado, el reentrenamiento aún era exigente: requería una gran cantidad de datos lingüísticos y capacidad de procesamiento. Chen sugirió un ajuste: en lugar de entrenar, borrar la capa de incrustación y luego volver a entrenar, deberían restablecer periódicamente la capa de incrustación durante la ronda inicial de entrenamiento. “Al hacer esto, todo el modelo se acostumbra al reseteo”, afirmó Artetxe. "Eso significa que cuando quieres extender el modelo a otro idioma, es más fácil, porque eso es lo que has estado haciendo".

Los investigadores tomaron un modelo de lenguaje de uso común llamado Roberta, lo entrenaron utilizando su técnica de olvido periódico y lo compararon con el rendimiento del mismo modelo cuando fue entrenado con el enfoque estándar sin olvido. El modelo de olvido obtuvo un resultado ligeramente peor que el convencional, recibiendo una puntuación de 85.1 en comparación con 86.1 en una medida común de precisión del lenguaje. Luego volvieron a entrenar los modelos en otros lenguajes, utilizando conjuntos de datos mucho más pequeños, de sólo 5 millones de tokens, en lugar de los 70 mil millones que usaron durante el primer entrenamiento. La precisión del modelo estándar disminuyó a 53.3 en promedio, pero el modelo de olvido cayó sólo a 62.7.

Al modelo de olvido también le fue mucho mejor si el equipo impusiera límites computacionales durante el reentrenamiento. Cuando los investigadores redujeron la duración del entrenamiento de 125,000 pasos a sólo 5,000, la precisión del modelo de olvido disminuyó a 57.8, en promedio, mientras que el modelo estándar cayó a 37.2, que no es mejor que las conjeturas aleatorias.

Introducción

El equipo concluyó que el olvido periódico parece hacer que el modelo sea mejor en el aprendizaje de idiomas en general. "Debido a que [ellos] siguen olvidando y volviendo a aprender durante la capacitación, enseñarle a la red algo nuevo más adelante se vuelve más fácil", dijo Evgueni Nikishin, investigador de Mila, un centro de investigación de aprendizaje profundo en Quebec. Sugiere que cuando los modelos lingüísticos entienden un idioma, lo hacen en un nivel más profundo que el de los significados de palabras individuales.

El enfoque es similar a cómo funciona nuestro propio cerebro. “La memoria humana en general no es muy buena para almacenar con precisión grandes cantidades de información detallada. En cambio, los humanos tendemos a recordar la esencia de nuestras experiencias, abstrayendo y extrapolando”, dijo Benjamín Levy, neurocientífico de la Universidad de San Francisco. "Habilitar la IA con procesos más humanos, como el olvido adaptativo, es una forma de lograr un rendimiento más flexible".

Además de lo que podría decir sobre cómo funciona la comprensión, Artetxe espera que modelos más flexibles de olvido del lenguaje también puedan ayudar a llevar los últimos avances de la IA a más idiomas. Aunque los modelos de IA son buenos para manejar el español y el inglés, dos idiomas con amplios materiales de capacitación, los modelos no son tan buenos con su vasco nativo, el idioma local específico del noreste de España. "La mayoría de los modelos de las grandes empresas tecnológicas no lo hacen bien", afirmó. “Adaptar los modelos existentes al euskera es el camino a seguir”.

Chen también espera un mundo donde florezcan más flores de IA. “Estoy pensando en una situación en la que el mundo no necesita un gran modelo lingüístico. Tenemos muchísimos”, dijo. “Si hay una fábrica que fabrica modelos lingüísticos, se necesita este tipo de tecnología. Tiene un modelo base que puede adaptarse rápidamente a nuevos dominios”.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/