Tabla de contenidos.

- Las principales preguntas de la entrevista de PNL

- Preguntas de entrevista de PNL para estudiantes de primer año

- Preguntas de la entrevista de PNL para experimentados

- 13. ¿Cuál de las siguientes técnicas se puede usar para la normalización de palabras clave en NLP, el proceso de convertir una palabra clave en su forma base?

- 14. ¿Cuál de las siguientes técnicas se puede usar para calcular la distancia entre vectores de dos palabras en PNL?

- 15. ¿Cuáles son las posibles características de un corpus de texto en PNL?

- 16. Creó una matriz de términos de documentos en los datos de entrada de 20 XNUMX documentos para un modelo de aprendizaje automático. ¿Cuál de los siguientes se puede utilizar para reducir las dimensiones de los datos?

- 17. ¿Cuál de las técnicas de análisis de texto se puede usar para la detección de frases nominales, frases verbales, sujetos y objetos en NLP?

- 18. La disimilitud entre palabras expresada mediante similitud de coseno tendrá valores significativamente superiores a 0.5

- 19. ¿Cuál de las siguientes es una palabra clave Técnicas de normalización en PNL

- 20. ¿Cuáles de los siguientes son casos de uso de PNL?

- 21. En un corpus de N documentos, un documento elegido al azar contiene un total de T términos y el término “hola” aparece K veces.

- 22. En NLP, el algoritmo disminuye el peso de las palabras de uso común y aumenta el peso de las palabras que no se usan mucho en una colección de documentos.

- 23. En PNL, el proceso de eliminar palabras como "y", "es", "un", "un", "el" de una oración se denomina como

- 24. En PNL, el proceso de convertir una oración o párrafo en tokens se conoce como Stemming.

- 25. En NLP, los tokens se convierten en números antes de entregarlos a cualquier red neuronal

- 26. Identifica el extraño

- 27. TF-IDF le ayuda a establecer?

- 28. En PNL, el proceso de identificar personas, una organización a partir de una oración dada, párrafo se llama

- 29. ¿Cuál de las siguientes no es una técnica de preprocesamiento en PNL?

- 30. En la minería de texto, la conversión de texto en tokens y luego su conversión en vectores enteros o de coma flotante se puede hacer usando

- 31. En PNL, las palabras representadas como vectores se denominan incrustaciones de palabras neuronales.

- 32. En PNL, ¿cuál de las siguientes incrustaciones de palabras admite el modelado de contexto?

- 33. En PNL, ¿cuál de las siguientes incrustaciones respalda el contexto bidireccional?

- 34. ¿Cuál de las siguientes incrustaciones de Word se puede entrenar a la medida para un tema específico en NLP?

- 35. Las incrustaciones de palabras capturan múltiples dimensiones de datos y se representan como vectores

- 36. En NLP, los vectores de incrustación de Word ayudan a establecer la distancia entre dos tokens

- 37. Los sesgos de idioma se introducen debido a los datos históricos utilizados durante el entrenamiento de incrustaciones de palabras, cuál de los siguientes no es un ejemplo de sesgo

- 38. ¿Cuál de las siguientes será una mejor opción para abordar los casos de uso de PNL, como la similitud semántica, la comprensión de lectura y el razonamiento de sentido común?

- 39. ¿La arquitectura de transformadores se introdujo por primera vez con?

- 40. ¿Cuál de las siguientes arquitecturas se puede entrenar más rápido y necesita menos cantidad de datos de entrenamiento?

- 41. ¿La misma palabra puede tener múltiples incrustaciones de palabras posibles con ____________?

- 42. Para un token dado, su representación de entrada es la suma de la incrustación del token, el segmento y la posición

- 43. Entrena dos modelos de lenguaje LSTM independientes de izquierda a derecha y de derecha a izquierda y los concatena superficialmente.

- 44. Utiliza un modelo de lenguaje unidireccional para producir incrustaciones de palabras.

- 45. En esta arquitectura, la relación entre todas las palabras en una oración se modela independientemente de su posición. ¿Qué arquitectura es esta?

- 46. Enumere 10 casos de uso para ser resueltos utilizando técnicas de PNL.

- 47. El modelo de transformador presta atención a la palabra más importante en Oración.

- 48. ¿Qué modelo de PNL ofrece la mejor precisión entre los siguientes?

- 49. Los modelos de lenguaje de permutación son una característica de

- 50. El transformador XL utiliza la incrustación posicional relativa

- Preguntas frecuentes sobre el procesamiento del lenguaje natural

- 1. ¿Por qué necesitamos PNL?

- 2. ¿Qué debe decidir un programa de lenguaje natural?

- 3. ¿Dónde puede ser útil la PNL?

- 4. ¿Cómo prepararse para una entrevista de PNL?

- 5. ¿Cuáles son los principales retos de la PNL?

- 6. ¿Qué modelo de PNL ofrece la mejor precisión?

- 7. ¿Cuáles son las principales tareas de la PNL?

El procesamiento del lenguaje natural ayuda a las máquinas a comprender y analizar los lenguajes naturales. NLP es un proceso automatizado que ayuda a extraer la información requerida de los datos mediante la aplicación de algoritmos de aprendizaje automático. Aprender PNL lo ayudará a conseguir un trabajo bien remunerado, ya que lo utilizan varios profesionales, como científicos de datos, ingenieros de aprendizaje automático, etc.

Hemos compilado una lista completa de preguntas y respuestas de entrevistas de PNL que lo ayudarán a prepararse para sus próximas entrevistas. También puede consultar estos gratuitos cursos de PNL para ayudar con su preparación. Una vez que haya preparado las siguientes preguntas frecuentes, puede ingresar al puesto de trabajo que está buscando.

Las principales preguntas de la entrevista de PNL

- ¿Qué es el algoritmo Naive Bayes, cuando podemos usar este algoritmo en NLP?

- ¿Explicar el análisis de dependencia en NLP?

- ¿Qué es el resumen de texto?

- ¿Qué es NLTK? ¿En qué se diferencia de Spacy?

- ¿Qué es la extracción de información?

- ¿Qué es Bolsa de Palabras?

- ¿Qué es la ambigüedad pragmática en la PNL?

- ¿Qué es el modelo de lenguaje enmascarado?

- ¿Cuál es la diferencia entre PNL y CI (interfaz conversacional)?

- ¿Cuáles son las mejores herramientas de PNL?

Sin más preámbulos, empecemos tu viaje de aprendizaje de PNL.

- Preguntas de entrevista de PNL para estudiantes de primer año

- Preguntas de la entrevista de PNL para experimentados

- Preguntas frecuentes sobre el procesamiento del lenguaje natural

Preguntas de entrevista de PNL para estudiantes de primer año

¿Estás listo para poner en marcha tu carrera en la PNL? Comience su carrera profesional con estas preguntas de la entrevista de procesamiento del lenguaje natural para estudiantes de primer año. Comenzaremos con lo básico y avanzaremos hacia preguntas más avanzadas. Si eres un profesional experimentado, esta sección te ayudará a refrescar tus habilidades de PNL.

1. ¿Qué es el algoritmo Naive Bayes? ¿Cuándo podemos usar este algoritmo en PNL?

Algoritmo bayesiano ingenuo es una colección de clasificadores que trabaja sobre los principios del teorema de Bayes. Esta serie de modelos NLP forma una familia de algoritmos que se pueden usar para una amplia gama de tareas de clasificación, incluida la predicción de sentimientos, el filtrado de spam, la clasificación de documentos y más.

El algoritmo Naive Bayes converge más rápido y requiere menos datos de entrenamiento. Comparado con otros modelos discriminativos como la regresión logística, el modelo Naive Bayes toma menos tiempo para entrenar. Este algoritmo es perfecto para usar mientras se trabaja con múltiples clases y clasificación de texto donde los datos son dinámicos y cambian con frecuencia.

2. ¿Explicar el análisis de dependencia en NLP?

El análisis de dependencia, también conocido como análisis sintáctico en NLP, es un proceso de asignación de estructura sintáctica a una oración e identificación de sus análisis de dependencia. Este proceso es crucial para entender las correlaciones entre las palabras “cabeza” en la estructura sintáctica.

El proceso de análisis de dependencia puede ser un poco complejo considerando cómo cualquier oración puede tener más de un análisis de dependencia. Los árboles de análisis múltiples se conocen como ambigüedades. El análisis de dependencia necesita resolver estas ambigüedades para poder asignar efectivamente una estructura sintáctica a una oración.

El análisis de dependencia se puede utilizar en el análisis semántico de una oración además de la estructuración sintáctica.

3. ¿Qué es el resumen de texto?

Resumen de texto es el proceso de acortar un fragmento largo de texto con su significado y efecto intactos. El resumen de texto tiene la intención de crear un resumen de cualquier parte del texto y describe los puntos principales del documento. Esta técnica ha mejorado en los últimos tiempos y es capaz de resumir volúmenes de texto con éxito.

El resumen de texto ha demostrado ser una bendición, ya que las máquinas pueden resumir grandes volúmenes de texto en muy poco tiempo, lo que de otro modo llevaría mucho tiempo. Hay dos tipos de resumen de texto:

- Resumen basado en extracción

- Resumen basado en abstracción

4. ¿Qué es NLTK? ¿En qué se diferencia de Spacy?

NLTK o Natural Language Toolkit es una serie de bibliotecas y programas que se utilizan para el procesamiento simbólico y estadístico del lenguaje natural. Este conjunto de herramientas contiene algunas de las bibliotecas más poderosas que pueden funcionar en diferentes técnicas de ML para desglosar y comprender el lenguaje humano. NLTK se utiliza para lematización, puntuación, recuento de caracteres, tokenización y lematización. La diferencia entre NLTK y Spacey es la siguiente:

- Si bien NLTK tiene una colección de programas para elegir, Spacey contiene solo el algoritmo más adecuado para un problema en su conjunto de herramientas.

- NLTK admite una gama más amplia de idiomas en comparación con Spacey (Spacey solo admite 7 idiomas)

- Mientras que Spacey tiene una biblioteca orientada a objetos, NLTK tiene una biblioteca de procesamiento de cadenas

- Spacey puede admitir vectores de palabras mientras que NLTK no puede

La extracción de información en el contexto del procesamiento del lenguaje natural se refiere a la técnica de extraer información estructurada automáticamente de fuentes no estructuradas para atribuirle un significado. Esto puede incluir la extracción de información sobre los atributos de las entidades, la relación entre diferentes entidades y más. Los diversos modelos de extracción de información incluyen:

- Módulo etiquetador

- Módulo de extracción de relaciones

- Módulo de extracción de hechos

- Módulo de extracción de entidades

- Módulo de análisis de sentimiento

- Módulo de gráfico de red

- Módulo de clasificación de documentos y modelado de lenguaje

6. ¿Qué es Bolsa de Palabras?

Bolsa de palabras es un modelo de uso común que depende de las frecuencias de las palabras o de las ocurrencias para entrenar un clasificador. Este modelo crea una matriz de ocurrencia para documentos u oraciones independientemente de su estructura gramatical o el orden de las palabras.

7. ¿Qué es la ambigüedad pragmática en la PNL?

La ambigüedad pragmática se refiere a aquellas palabras que tienen más de un significado y su uso en cualquier oración puede depender completamente del contexto. La ambigüedad pragmática puede resultar en múltiples interpretaciones de la misma oración. La mayoría de las veces, nos encontramos con oraciones que tienen palabras con múltiples significados, lo que hace que la oración esté abierta a la interpretación. Esta interpretación múltiple provoca ambigüedad y se conoce como ambigüedad pragmática en PNL.

8. ¿Qué es el modelo de lenguaje enmascarado?

Los modelos de lenguaje enmascarado ayudan a los alumnos a comprender representaciones profundas en tareas posteriores al tomar una salida de la entrada corrupta. Este modelo se usa a menudo para predecir las palabras que se usarán en una oración.

9. ¿Cuál es la diferencia entre PNL y CI (interfaz conversacional)?

La diferencia entre PNL y CI es la siguiente:

| Procesamiento del lenguaje natural (PNL) | Interfaz conversacional (CI) |

|---|---|

| La PNL intenta ayudar a las máquinas a comprender y aprender cómo funcionan los conceptos del lenguaje. | CI se enfoca solo en proporcionar a los usuarios una interfaz para interactuar. |

| NLP utiliza tecnología de inteligencia artificial para identificar, comprender e interpretar las solicitudes de los usuarios a través del lenguaje. | CI usa voz, chat, videos, imágenes y más ayuda conversacional para crear la interfaz de usuario. |

10. ¿Cuáles son las mejores herramientas de PNL?

Algunas de las mejores herramientas de PNL de fuentes abiertas son:

- ESPACIO

- Blob de texto

- Textacidad

- Kit de herramientas de lenguaje natural (NLTK)

- Retexto

- PNL.js

- PNL de Stanford

- CogcompNLP

11. ¿Qué es el etiquetado de POS?

Etiquetado de partes del discurso mejor conocido como Etiquetado POS se refieren al proceso de identificar palabras específicas en un documento y agruparlas como parte del discurso, según su contexto. El etiquetado POS también se conoce como etiquetado gramatical, ya que implica comprender las estructuras gramaticales e identificar el componente respectivo.

El etiquetado de POS es un proceso complicado ya que la misma palabra puede ser diferentes partes del discurso según el contexto. El mismo proceso general utilizado para el mapeo de palabras es bastante ineficaz para el etiquetado de POS por la misma razón.

12. ¿Qué es NES?

El reconocimiento de entidades de nombre se conoce más comúnmente como NER y es el proceso de identificar entidades específicas en un documento de texto que son más informativos y tienen un contexto único. Estos a menudo denotan lugares, personas, organizaciones y más. Aunque parece que estas entidades son nombres propios, el proceso NER está lejos de identificar solo los nombres. De hecho, NER implica la fragmentación o extracción de entidades en las que las entidades se segmentan para categorizarlas en diferentes clases predefinidas. Este paso ayuda aún más en la extracción de información.

Preguntas de la entrevista de PNL para experimentados

13. ¿Cuál de las siguientes técnicas se puede usar para la normalización de palabras clave en NLP, el proceso de convertir una palabra clave en su forma base?

una. lematización

b. sonidoex

C. Semejanza del coseno

d. N-gramas

Respuesta a)

La lematización ayuda a llegar a la forma básica de una palabra, por ejemplo, jugando -> jugar, comiendo -> comer, etc. Otras opciones están pensadas para diferentes propósitos.

14. ¿Cuál de las siguientes técnicas se puede usar para calcular la distancia entre vectores de dos palabras en PNL?

una. lematización

b. distancia euclidiana

C. Semejanza del coseno

d. N-gramas

Respuesta b) y c)

Distancia entre dos palabras los vectores se pueden calcular utilizando la similitud del coseno y la distancia euclidiana. La similitud de coseno establece un ángulo de coseno entre el vector de dos palabras. Un ángulo de coseno cercano entre dos vectores de dos palabras indica que las palabras son similares y viceversa.

Por ejemplo, el ángulo coseno entre dos palabras "Fútbol" y "Cricket" estará más cerca de 1 en comparación con el ángulo entre las palabras "Fútbol" y "Nueva Delhi".

El código de Python para implementar la función CosineSimlarity se vería así:

def cosine_similarity(x,y): return np.dot(x,y)/( np.sqrt(np.dot(x,x)) * np.sqrt(np.dot(y,y)) )

q1 = wikipedia.page(‘Strawberry’)

q2 = wikipedia.page(‘Pineapple’)

q3 = wikipedia.page(‘Google’)

q4 = wikipedia.page(‘Microsoft’)

cv = CountVectorizer()

X = np.array(cv.fit_transform([q1.content, q2.content, q3.content, q4.content]).todense())

print (“Strawberry Pineapple Cosine Distance”, cosine_similarity(X[0],X[1]))

print (“Strawberry Google Cosine Distance”, cosine_similarity(X[0],X[2]))

print (“Pineapple Google Cosine Distance”, cosine_similarity(X[1],X[2]))

print (“Google Microsoft Cosine Distance”, cosine_similarity(X[2],X[3]))

print (“Pineapple Microsoft Cosine Distance”, cosine_similarity(X[1],X[3]))

Strawberry Pineapple Cosine Distance 0.8899200413701714

Strawberry Google Cosine Distance 0.7730935582847817

Pineapple Google Cosine Distance 0.789610214147025

Google Microsoft Cosine Distance 0.8110888282851575Por lo general, la similitud del documento se mide por la proximidad semántica entre sí del contenido (o las palabras) del documento. Cuando están cerca, el índice de similitud es cercano a 1, de lo contrario, cercano a 0.

La distancia euclidiana entre dos puntos es la longitud del camino más corto que los une. Por lo general, se calcula utilizando el teorema de Pitágoras para un triángulo.

15. ¿Cuáles son las posibles características de un corpus de texto en PNL?

una. Recuento de la palabra en un documento

b. Notación vectorial de la palabra

C. Etiqueta de parte del discurso

d. Gramática básica de dependencia

mi. Todo lo anterior

Respuesta e)

Todo lo anterior se puede utilizar como características del corpus de texto.

16. Creó una matriz de términos de documentos en los datos de entrada de 20 XNUMX documentos para un modelo de aprendizaje automático. ¿Cuál de los siguientes se puede utilizar para reducir las dimensiones de los datos?

- Normalización de palabras clave

- Indización Semántica Latente

- Asignación de Dirichlet Latente

una. solo 1

b. 2, 3

C. 1, 3

d. 1, 2, 3

Respuesta d)

17. ¿Cuál de las técnicas de análisis de texto se puede usar para la detección de frases nominales, frases verbales, sujetos y objetos en NLP?

una. Etiquetado de parte del discurso

b. Saltar la extracción de Gram y N-Gram

C. Bolsa continua de palabras

d. Análisis de dependencias y análisis de distritos electorales

Respuesta d)

18. La disimilitud entre palabras expresada mediante similitud de coseno tendrá valores significativamente superiores a 0.5

una verdad

b. Falso

Respuesta a)

19. ¿Cuál de las siguientes es una palabra clave Técnicas de normalización en PNL

una. derivación

b. Parte del discurso

C. Reconocimiento de entidad nombrada

d. lematización

Respuesta: a) y d)

Parte del discurso (POS) y reconocimiento de entidad nombrada (NER) no son técnicas de normalización de palabras clave. Entidad nombrada ayuda extrae Organización, Hora, Fecha, Ciudad, etc., tipo de entidades de la oración dada, mientras que Part of Speech lo ayuda a extraer Sustantivo, Verbo, Pronombre, adjetivo, etc., de las fichas de oración dadas.

20. ¿Cuáles de los siguientes son casos de uso de PNL?

una. Detección de objetos a partir de una imagen

b. Reconocimiento facial

C. Biometría del habla

d. Resumen de texto

Respuesta: d)

a) y b) son casos de uso de Computer Vision, y c) es el Caso de uso del habla.

Solo d) El resumen de texto es un caso de uso de NLP.

21. En un corpus de N documentos, un documento elegido al azar contiene un total de T términos y el término “hola” aparece K veces.

¿Cuál es el valor correcto para el producto de TF (frecuencia de términos) e IDF (frecuencia de documentos inversa), si el término "hola" aparece en aproximadamente un tercio del total de documentos?

una. KT * Registro(3)

b. T * Registro (3) / K

C. K * Registro (3) / T

d. Registro (3) / KT

Respuesta (C)

fórmula para TF es K/T

la fórmula para IDF es log (total de documentos / número de documentos que contienen "datos")

= registro (1 / (⅓))

= registro (3)

Por lo tanto, la elección correcta es Klog(3)/T

22. En NLP, el algoritmo disminuye el peso de las palabras de uso común y aumenta el peso de las palabras que no se usan mucho en una colección de documentos.

una. Plazo Frecuencia (TF)

b. Frecuencia de documento inversa (IDF)

C. Word2Vec

d. Asignación latente de Dirichlet (LDA)

Respuesta b)

23. En PNL, el proceso de eliminar palabras como "y", "es", "un", "un", "el" de una oración se denomina como

a. Stemming

b. lematización

C. palabra de parada

re. Todas las anteriores

Respuesta: c)

En la Lematización, se eliminan todas las palabras vacías como a, an, the, etc. También se pueden definir palabras vacías personalizadas para su eliminación.

24. En PNL, el proceso de convertir una oración o párrafo en tokens se conoce como Stemming.

una verdad

b. Falso

Respuesta b)

La declaración describe el proceso de tokenización y no de derivación, por lo tanto, es Falso.

25. En NLP, los tokens se convierten en números antes de entregarlos a cualquier red neuronal

a. ¿Editas con tu equipo de forma remota?

b. Falso

Respuesta a)

En NLP, todas las palabras se convierten en un número antes de alimentar a una red neuronal.

26. Identifica el extraño

una. nltk

b. aprender

C. Espacioso

d. BERT

Respuesta d)

Todas las mencionadas son bibliotecas NLP excepto BERT, que es una palabra incrustada.

27. TF-IDF le ayuda a establecer?

una. palabra más frecuente en el documento

B. los palabra más importante en el documento

Respuesta b)

TF-IDF ayuda a establecer qué tan importante es una palabra en particular en el contexto del corpus del documento. TF-IDF tiene en cuenta el número de veces que aparece la palabra en el documento y se compensa con el número de documentos que aparecen en el corpus.

- TF es la frecuencia de términos dividida por el número total de términos en el documento.

- IDF se obtiene dividiendo el número total de documentos por el número de documentos que contienen el término y luego tomando el logaritmo de ese cociente.

- Tf.idf es entonces la multiplicación de dos valores TF e IDF.

Supongamos que tenemos tablas de recuento de términos de un corpus que consta de solo dos documentos, como se indica aquí:

| Término | Documento 1 Frecuencia | Documento 2 Frecuencia |

| Este | 1 | 1 |

| is | 1 | 1 |

| a | 2 | |

| Muestra | 1 | |

| una alternativa, | 2 | |

| ejemplo | 3 |

El cálculo de tf–idf para el término “esto” se realiza de la siguiente manera:

for "this"

-----------

tf("this", d1) = 1/5 = 0.2

tf("this", d2) = 1/7 = 0.14

idf("this", D) = log (2/2) =0

hence tf-idf

tfidf("this", d1, D) = 0.2* 0 = 0

tfidf("this", d2, D) = 0.14* 0 = 0

for "example"

------------

tf("example", d1) = 0/5 = 0

tf("example", d2) = 3/7 = 0.43

idf("example", D) = log(2/1) = 0.301

tfidf("example", d1, D) = tf("example", d1) * idf("example", D) = 0 * 0.301 = 0

tfidf("example", d2, D) = tf("example", d2) * idf("example", D) = 0.43 * 0.301 = 0.129En su forma de frecuencia sin procesar, TF es solo la frecuencia del "esto" para cada documento. En cada documento, la palabra “este” aparece una vez; pero como el documento 2 tiene más palabras, su frecuencia relativa es menor.

Un IDF es constante por corpus y da cuenta de la proporción de documentos que incluyen la palabra "esto". En este caso, tenemos un corpus de dos documentos y todos incluyen la palabra “esto”. Entonces TF–IDF es cero para la palabra “esto”, lo que implica que la palabra no es muy informativa como aparece en todos los documentos.

La palabra “ejemplo” es más interesante: aparece tres veces, pero solo en el segundo documento. Para entender más sobre PNL, echa un vistazo a estos proyectos de PNL.

28. En PNL, el proceso de identificar personas, una organización a partir de una oración dada, párrafo se llama

una. derivación

b. lematización

C. Eliminación de palabras de parada

d. Reconocimiento de entidad nombrada

Respuesta d)

29. ¿Cuál de las siguientes no es una técnica de preprocesamiento en PNL?

a. Stemming y Lematización

b. convertir a minúsculas

C. eliminando puntuaciones

d. eliminación de palabras vacías

mi. Análisis de los sentimientos

Respuesta e)

El análisis de sentimiento no es una técnica de preprocesamiento. Se realiza después del preprocesamiento y es un caso de uso de PNL. Todos los demás enumerados se utilizan como parte del preprocesamiento de extractos.

30. En la minería de texto, la conversión de texto en tokens y luego su conversión en vectores enteros o de coma flotante se puede hacer usando

una. ContarVectorizador

b. TF-FDI

C. Bolsa de palabras

d. NER

Respuesta a)

CountVectorizer ayuda a hacer lo anterior, mientras que otros no son aplicables.

text =["Rahul is an avid writer, he enjoys studying understanding and presenting. He loves to play"]

vectorizer = CountVectorizer()

vectorizer.fit(text)

vector = vectorizer.transform(text)

print(vector.toarray())Salida

[[1 1 1 1 2 1 1 1 1 1 1 1 1 1]]

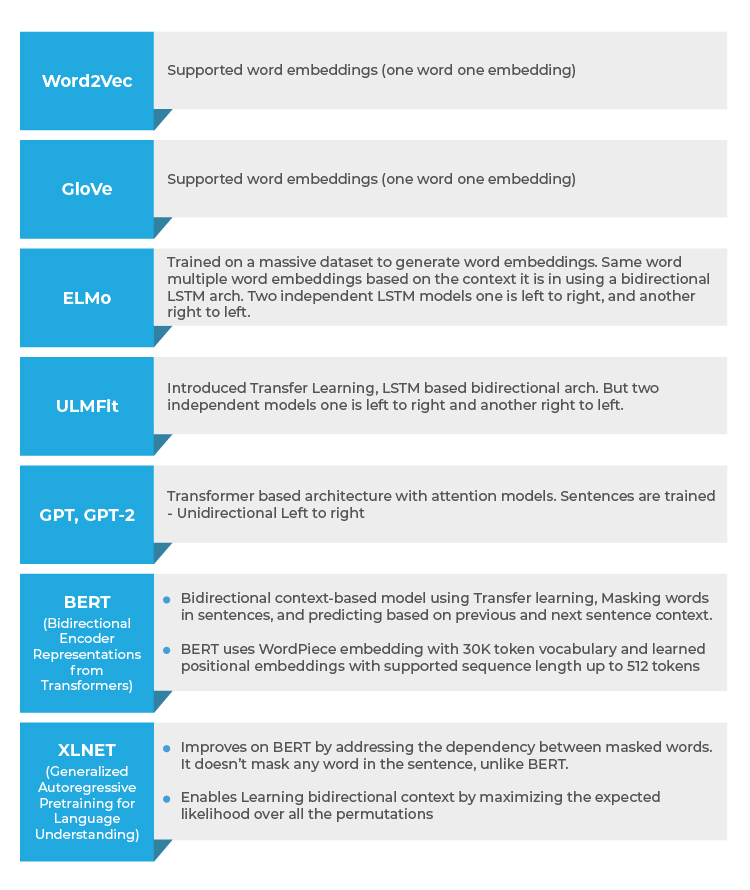

La segunda sección de las preguntas de la entrevista cubre técnicas avanzadas de PNL como Word2Vec, incrustaciones de palabras GloVe y modelos avanzados como GPT, Elmo, BERT, basados en XLNET. preguntas y explicaciones.

31. En PNL, las palabras representadas como vectores se denominan incrustaciones de palabras neuronales.

una verdad

b. Falso

Respuesta a)

Los modelos basados en Word2Vec, GloVe construyen vectores de incrustación de palabras que son multidimensionales.

32. En PNL, ¿cuál de las siguientes incrustaciones de palabras admite el modelado de contexto?

- una. Word2Vec

- b) Guante

- c) BERT

- Todo lo anterior

Respuesta c)

Solo BERT (Representaciones de codificador bidireccional de transformador) admite el modelado de contexto donde se tiene en cuenta el contexto de la oración anterior y siguiente. En Word2Vec, GloVe solo se consideran las incrustaciones de palabras y no se considera el contexto de la oración anterior y siguiente.

33. En PNL, ¿cuál de las siguientes incrustaciones respalda el contexto bidireccional?

una. Word2Vec

b. BERT

C. Guante

d. Todo lo anterior

Respuesta b)

Solo BERT proporciona un contexto bidireccional. El modelo BERT usa la oración anterior y la siguiente para llegar al contexto. Word2Vec y GloVe son incrustaciones de palabras, no proporcionan ningún contexto.

34. ¿Cuál de las siguientes incrustaciones de Word se puede entrenar a la medida para un tema específico en NLP?

una. Word2Vec

b. BERT

C. Guante

d. Todo lo anterior

Respuesta b)

BERT permite Transform Learning en los modelos preentrenados existentes y, por lo tanto, puede entrenarse de forma personalizada para el tema específico dado, a diferencia de Word2Vec y GloVe, donde se pueden usar las incrustaciones de palabras existentes, no es posible transferir el aprendizaje en el texto.

35. Las incrustaciones de palabras capturan múltiples dimensiones de datos y se representan como vectores

a. ¿Editas con tu equipo de forma remota?

b. Falso

Respuesta a)

36. En NLP, los vectores de incrustación de Word ayudan a establecer la distancia entre dos tokens

a. ¿Editas con tu equipo de forma remota?

b. Falso

Respuesta: a)

Uno puede usar la similitud del coseno para establecer la distancia entre dos vectores representados a través de Word Embeddings

37. Los sesgos de idioma se introducen debido a los datos históricos utilizados durante el entrenamiento de incrustaciones de palabras, cuál de los siguientes no es un ejemplo de sesgo

una. Nueva Delhi es para India, Beijing es para China

b. El hombre es para la computadora, la mujer es para el ama de casa

Respuesta a)

La declaración b) es un sesgo, ya que convierte a la mujer en ama de casa, mientras que la declaración a) no es una declaración sesgada.

38. ¿Cuál de las siguientes será una mejor opción para abordar los casos de uso de PNL, como la similitud semántica, la comprensión de lectura y el razonamiento de sentido común?

a. ELMo

b. Abrir GPT de IA

C. ulmfit

Respuesta b)

El GPT de Open AI puede aprender patrones complejos en los datos mediante el uso del mecanismo de atención de los modelos de Transformer y, por lo tanto, es más adecuado para casos de uso complejos, como la similitud semántica, la comprensión de lectura y el razonamiento de sentido común.

39. ¿La arquitectura de transformadores se introdujo por primera vez con?

a. Guante

b. BERT

C. Abrir GPT de IA

d. ulmfit

Respuesta c)

ULMFit tiene una arquitectura de modelado de lenguaje basada en LSTM. Esto se reemplazó en la arquitectura Transformer con GPT de Open AI.

40. ¿Cuál de las siguientes arquitecturas se puede entrenar más rápido y necesita menos cantidad de datos de entrenamiento?

una. Modelado de lenguaje basado en LSTM

b. Arquitectura del transformador

Respuesta b)

Las arquitecturas de transformadores fueron compatibles desde GPT en adelante y fueron más rápidas de entrenar y también necesitaron menos cantidad de datos para el entrenamiento.

41. ¿La misma palabra puede tener múltiples incrustaciones de palabras posibles con ____________?

una. Guante

b. Palabra2Vec

C. ELMo

d. ntk

Respuesta c)

Las incrustaciones de palabras de EMLo admiten la misma palabra con múltiples incrustaciones, esto ayuda a usar la misma palabra en un contexto diferente y, por lo tanto, captura el contexto y no solo el significado de la palabra, a diferencia de GloVe y Word2Vec. Nltk no es una palabra incrustada.

42. Para un token dado, su representación de entrada es la suma de la incrustación del token, el segmento y la posición

incrustación

una. ELMo

b. GPT

C. BERT

d. ulmfit

Respuesta c)

BERT utiliza la incorporación de tokens, segmentos y posiciones.

43. Entrena dos modelos de lenguaje LSTM independientes de izquierda a derecha y de derecha a izquierda y los concatena superficialmente.

una. GPT

b. BERT

C. ulmfit

d. ELMo

Respuesta d)

ELMo intenta entrenar dos modelos de lenguaje LSTM independientes (de izquierda a derecha y de derecha a izquierda) y concatena los resultados para producir incrustaciones de palabras.

44. Utiliza un modelo de lenguaje unidireccional para producir incrustaciones de palabras.

una. BERT

b. GPT

C. ELMo

d. Palabra2Vec

Respuesta b)

GPT es bidireccional el modelo y la incrustación de palabras son producido por la formación sobre el flujo de información de izquierda a derecha. ELMo es bidireccional pero superficial. Word2Vec proporciona incrustaciones de palabras sencillas.

45. En esta arquitectura, la relación entre todas las palabras en una oración se modela independientemente de su posición. ¿Qué arquitectura es esta?

una. OpenAI GPT

b. ELMo

C. BERT

d. ulmfit

Respuesta: c)

La arquitectura BERT Transformer modela la relación entre cada palabra y todas las demás palabras en la oración para generar puntajes de atención. Estos puntajes de atención se usan luego como pesos para un promedio ponderado de las representaciones de todas las palabras que se alimenta a una red completamente conectada para generar una nueva representación.

46. Enumere 10 casos de uso para ser resueltos utilizando técnicas de PNL.

- Análisis de los sentimientos

- Traducción de idiomas (inglés a alemán, chino a inglés, etc.)

- Resumen de documentos

- Respuesta a preguntas

- Completar oraciones

- Extracción de atributos (Extracción de información clave de los documentos)

- Interacciones de chatbots

- Clasificación de temas

- Extracción de intención

- Corrección de gramática o oraciones

- Subtítulos de imagen

- Clasificación de documentos

- Inferencia de lenguaje natural

47. El modelo de transformador presta atención a la palabra más importante en la oración..

una verdad

b. Falso

Respuesta: a) Los mecanismos de atención en el modelo de Transformador se utilizan para modelar la relación entre todas las palabras y también otorgan pesos a la palabra más importante.

48. ¿Qué modelo de PNL ofrece la mejor precisión entre los siguientes?

una. BERT

b. XLNET

C. GPT-2

d. ELMo

Respuesta: b)XLNET

XLNET ha dado la mejor precisión entre todos los modelos. Ha superado a BERT en 20 tareas y logra resultados de última generación en 18 tareas que incluyen análisis de sentimientos, respuesta a preguntas, inferencia de lenguaje natural, etc.

49. Los modelos de lenguaje de permutación son una característica de

una. BERT

b. EMM

C. GPT

d. XLNET

Respuesta: d)

XLNET proporciona modelado de lenguaje basado en permutación y es una diferencia clave de BERT. En el modelado del lenguaje de permutación, los tokens se predicen de manera aleatoria y no secuencial. El orden de predicción no es necesariamente de izquierda a derecha y puede ser de derecha a izquierda. El orden original de las palabras no cambia, pero una predicción puede ser aleatoria. La diferencia conceptual entre BERT y XLNET se puede ver en el siguiente diagrama.

50. El transformador XL utiliza la incrustación posicional relativa

una verdad

b. Falso

Respuesta: a)

En lugar de tener que incrustar para representar la posición absoluta de una palabra, Transformer XL usa una incrustación para codificar la distancia relativa entre las palabras. Esta incrustación se usa para calcular la puntuación de atención entre 2 palabras que podrían estar separadas por n palabras antes o después.

Ahí lo tienes: todas las preguntas probables para tu entrevista de PNL. Ahora ve, haz lo mejor que puedas.

Preguntas frecuentes sobre el procesamiento del lenguaje natural

1. ¿Por qué necesitamos PNL?

Una de las principales razones por las que la PNL es necesaria es porque ayuda a las computadoras a comunicarse con los humanos en lenguaje natural. También escala otras tareas relacionadas con el lenguaje. Gracias a la PNL, es posible que las computadoras escuchen, interpreten este discurso, lo midan y también determinen qué partes del discurso son importantes.

2. ¿Qué debe decidir un programa de lenguaje natural?

Un programa de lenguaje natural debe decidir qué decir y cuándo decir algo.

3. ¿Dónde puede ser útil la PNL?

La PNL puede ser útil para comunicarse con humanos en su propio idioma. Ayuda a mejorar la eficiencia de la traducción automática y también es útil en el análisis emocional. Puede ser útil en análisis de sentimientos usando python también. También ayuda a estructurar datos altamente desestructurados. Puede ser útil para crear chatbots, resúmenes de texto y asistentes virtuales.

4. ¿Cómo prepararse para una entrevista de PNL?

La mejor manera de prepararse para una entrevista de PNL es tener claros los conceptos básicos. Revisa los blogs que te ayudarán a cubrir todos los aspectos clave y recordar los temas importantes. Aprenda específicamente para las entrevistas y tenga confianza al responder todas las preguntas.

5. ¿Cuáles son los principales retos de la PNL?

La división de oraciones en tokens, el etiquetado de partes del discurso, la comprensión del contexto, la vinculación de componentes de un vocabulario creado y la extracción del significado semántico son actualmente algunos de los principales desafíos de la PNL.

6. ¿Qué modelo de PNL ofrece la mejor precisión?

El algoritmo Naive Bayes tiene la máxima precisión cuando se trata de modelos de PNL. Da hasta un 73% de predicciones correctas.

7. ¿Cuáles son las principales tareas de la PNL?

La traducción, el reconocimiento de entidades nombradas, la extracción de relaciones, el análisis de sentimientos, el reconocimiento de voz y la segmentación de temas son algunas de las tareas principales de la PNL. Bajo datos no estructurados, puede haber mucha información sin explotar que puede ayudar a una organización a crecer.

8. ¿Qué son las palabras vacías en la PNL?

Las palabras comunes que aparecen en oraciones que agregan peso a la oración se conocen como palabras vacías. Estas palabras vacías actúan como un puente y aseguran que las oraciones sean gramaticalmente correctas. En términos simples, las palabras que se filtran antes de procesar los datos del lenguaje natural se conocen como palabras vacías y es un método común de preprocesamiento.

9. ¿Qué es stemming en PNL?

El proceso de obtener la raíz de la palabra dada se conoce como derivación. Todas las fichas se pueden cortar para obtener la raíz de la palabra o la raíz con la ayuda de reglas eficientes y bien generalizadas. Es un proceso basado en reglas y es bien conocido por su simplicidad.

10. ¿Por qué la PNL es tan difícil?

Hay varios factores que dificultan el proceso de procesamiento del lenguaje natural. Hay cientos de lenguajes naturales en todo el mundo, las palabras pueden ser ambiguas en su significado, cada lenguaje natural tiene una escritura y una sintaxis diferentes, el significado de las palabras puede cambiar según el contexto, por lo que el proceso de PNL puede ser difícil. Si elige mejorar sus habilidades y continuar aprendiendo, el proceso será más fácil con el tiempo.

11. ¿En qué consiste un pipeline de PNL*?

La arquitectura general de un La canalización de NLP consiste de varias capas: una interfaz de usuario; uno o varios PNL modelos, según el caso de uso; una capa de comprensión del lenguaje natural para describir el el significado de palabras y oraciones; una capa de preprocesamiento; microservicios para vincular los componentes entre sí y, por supuesto.

12. ¿Cuántos pasos hay de PNL?

Las cinco fases de la PNL involucran análisis léxico (estructura), análisis sintáctico, análisis semántico, integración del discurso y análisis pragmático.

OTRAS LECTURAS

- Preguntas y respuestas de la entrevista de Python para 2022

- Preguntas y respuestas de la entrevista de aprendizaje automático para 2022

- Las 100 preguntas más comunes de la entrevista de analista de negocios

- Preguntas de la entrevista de inteligencia artificial para 2022 | Preguntas de la entrevista de IA

- Más de 100 preguntas de entrevistas de ciencia de datos para 2022

- Preguntas comunes de la entrevista

- Coinsmart. El mejor intercambio de Bitcoin y criptografía de Europa.Haga clic aquí

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://www.mygreatlearning.com/blog/nlp-interview-questions/