Las semillas de un cambio de paradigma de aprendizaje automático (ML) han existido durante décadas, pero con la disponibilidad inmediata de capacidad informática escalable, una proliferación masiva de datos y el rápido avance de las tecnologías ML, los clientes de todas las industrias están transformando sus negocios. Recientemente, las aplicaciones generativas de IA como ChatGPT han captado la atención y la imaginación de forma generalizada. Realmente estamos en un punto de inflexión emocionante en la adopción generalizada de ML, y creemos que la mayoría de las experiencias y aplicaciones de los clientes se reinventarán con IA generativa.

AI y ML han sido un enfoque para Amazon durante más de 20 años, y muchas de las capacidades que los clientes usan con Amazon están impulsadas por ML. Nuestro motor de recomendaciones de comercio electrónico está impulsado por ML; los caminos que optimizan las rutas de selección robótica en nuestros centros logísticos están impulsados por ML; y nuestra cadena de suministro, previsión y planificación de la capacidad se basan en ML. Prime Air (nuestros drones) y la tecnología de visión por computadora en Amazon Go (nuestra experiencia minorista física que permite a los consumidores seleccionar artículos de un estante y salir de la tienda sin tener que pagar formalmente) utilizan el aprendizaje profundo. Alexa, con la tecnología de más de 30 sistemas ML diferentes, ayuda a los clientes miles de millones de veces cada semana a administrar hogares inteligentes, comprar, obtener información y entretenimiento, y más. Tenemos miles de ingenieros en Amazon comprometidos con ML, y es una gran parte de nuestra herencia, ética actual y futuro.

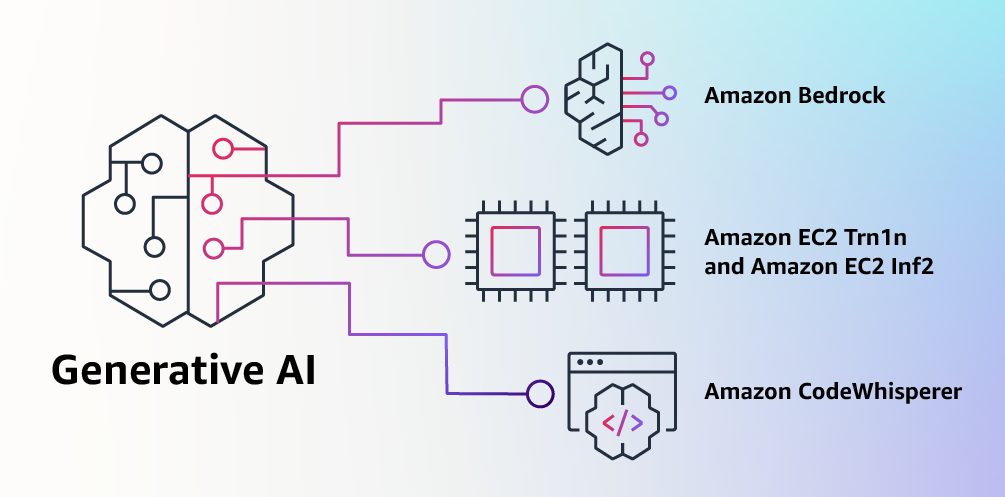

En AWS, hemos desempeñado un papel clave en la democratización del ML y en hacerlo accesible para cualquiera que quiera usarlo, incluidos más de 100,000 3 clientes de todos los tamaños e industrias. AWS tiene la cartera más amplia y profunda de servicios de inteligencia artificial y aprendizaje automático en las tres capas de la pila. Hemos invertido e innovado para ofrecer la infraestructura escalable y de mayor rendimiento para el entrenamiento y la inferencia de ML rentables; desarrolló Amazon SageMaker, que es la forma más fácil para que todos los desarrolladores construyan, entrenen e implementen modelos; y lanzó una amplia gama de servicios que permiten a los clientes agregar capacidades de inteligencia artificial como reconocimiento de imágenes, pronósticos y búsqueda inteligente a las aplicaciones con una simple llamada a la API. Es por eso que clientes como Intuit, Thomson Reuters, AstraZeneca, Ferrari, Bundesliga, XNUMXM y BMW, así como miles de nuevas empresas y agencias gubernamentales de todo el mundo, se están transformando a sí mismos, sus industrias y sus misiones con ML. Adoptamos el mismo enfoque democratizador de la IA generativa: trabajamos para sacar estas tecnologías del ámbito de la investigación y los experimentos y extender su disponibilidad mucho más allá de un puñado de nuevas empresas y grandes empresas tecnológicas bien financiadas. Es por eso que hoy me complace anunciar varias innovaciones nuevas que harán que sea fácil y práctico para nuestros clientes usar IA generativa en sus negocios.

Creación con IA generativa en AWS

IA generativa y modelos básicos

La IA generativa es un tipo de IA que puede crear nuevos contenidos e ideas, incluidas conversaciones, historias, imágenes, videos y música. Como toda IA, la IA generativa está impulsada por modelos ML: modelos muy grandes que se entrenan previamente en grandes cantidades de datos y comúnmente se conocen como modelos básicos (FM). Los avances recientes en ML (específicamente la invención de la arquitectura de red neuronal basada en transformadores) han llevado al surgimiento de modelos que contienen miles de millones de parámetros o variables. Para dar una idea del cambio de escala, el modelo preentrenado más grande en 2019 fue de 330 millones de parámetros. Ahora, los modelos más grandes tienen más de 500B de parámetros, un aumento de tamaño de 1,600 veces en solo unos pocos años. Los FM actuales, como los modelos de lenguaje grande (LLM) GPT3.5 o BLOOM, y el modelo de texto a imagen Stable Diffusion de Stability AI, pueden realizar una amplia gama de tareas que abarcan múltiples dominios, como escribir publicaciones de blog, generar imágenes, resolver problemas matemáticos, entablar diálogos y responder preguntas basadas en un documento. El tamaño y la naturaleza de propósito general de los FM los hacen diferentes de los modelos de ML tradicionales, que normalmente realizan tareas específicas, como analizar texto en busca de sentimiento, clasificar imágenes y pronosticar tendencias.

Los FM pueden realizar muchas más tareas porque contienen una gran cantidad de parámetros que los hacen capaces de aprender conceptos complejos. Y a través de su exposición previa a la capacitación a datos a escala de Internet en todas sus diversas formas y una miríada de patrones, los FM aprenden a aplicar su conocimiento dentro de una amplia gama de contextos. Si bien las capacidades y las posibilidades resultantes de un FM preentrenado son sorprendentes, los clientes se entusiasman mucho porque estos modelos generalmente capaces también se pueden personalizar para realizar funciones específicas de dominio que diferencian a sus negocios, utilizando solo una pequeña fracción de los datos y cómputo requerido para entrenar un modelo desde cero. Los FM personalizados pueden crear una experiencia única para el cliente, encarnando la voz, el estilo y los servicios de la empresa en una amplia variedad de industrias de consumo, como la banca, los viajes y la atención médica. Por ejemplo, una empresa financiera que necesita generar automáticamente un informe de actividad diario para la circulación interna utilizando todas las transacciones relevantes puede personalizar el modelo con datos de propiedad, que incluirán informes anteriores, de modo que el FM aprenda cómo deben leer estos informes y qué se utilizaron datos para generarlos.

El potencial de los FM es increíblemente emocionante. Pero, todavía estamos en los primeros días. Si bien ChatGPT ha sido la primera experiencia amplia de IA generativa en captar la atención de los clientes, la mayoría de las personas que estudian IA generativa se han dado cuenta rápidamente de que varias empresas han estado trabajando en FM durante años y que hay varios FM diferentes disponibles, cada uno con fortalezas y características únicas. características. Como hemos visto a lo largo de los años con tecnologías de rápido movimiento y en la evolución de ML, las cosas cambian rápidamente. Esperamos que surjan nuevas arquitecturas en el futuro, y esta diversidad de FM desencadenará una ola de innovación. Ya estamos viendo nuevas experiencias de aplicaciones nunca antes vistas. Los clientes de AWS nos han preguntado cómo pueden aprovechar rápidamente lo que está disponible hoy (y lo que probablemente vendrá mañana) y comenzar a usar rápidamente FM e IA generativa dentro de sus empresas y organizaciones para impulsar nuevos niveles de productividad y transformar sus ofertas.

Anuncio de los modelos Amazon Bedrock y Amazon Titan, la forma más fácil de crear y escalar aplicaciones de IA generativa con FM

Los clientes nos han dicho que hay algunas cosas importantes que se interponen en su camino hoy. En primer lugar, necesitan una forma sencilla de encontrar y acceder a FM de alto rendimiento que brinden resultados sobresalientes y sean los más adecuados para sus propósitos. En segundo lugar, los clientes quieren que la integración en las aplicaciones sea fluida, sin tener que administrar grandes grupos de infraestructura o incurrir en grandes costos. Finalmente, los clientes quieren que sea fácil tomar la FM base y crear aplicaciones diferenciadas utilizando sus propios datos (pocos o muchos datos). Dado que los datos que los clientes quieren usar para la personalización son IP increíblemente valiosas, necesitan que permanezcan completamente protegidos, seguros y privados durante ese proceso, y quieren controlar cómo se comparten y usan sus datos.

Tomamos todos los comentarios de los clientes y hoy nos complace anunciar lecho rocoso del amazonas, un nuevo servicio que hace que los FM de AI21 Labs, Anthropic, Stability AI y Amazon sean accesibles a través de una API. Bedrock es la forma más fácil para que los clientes creen y escalen aplicaciones generativas basadas en IA mediante FM, lo que democratiza el acceso para todos los desarrolladores. Bedrock ofrecerá la posibilidad de acceder a una variedad de potentes FM para texto e imágenes, incluidos Titan FM de Amazon, que consta de dos nuevos LLM que también anunciamos hoy—a través de un servicio administrado de AWS escalable, confiable y seguro. Con la experiencia sin servidor de Bedrock, los clientes pueden encontrar fácilmente el modelo correcto para lo que están tratando de hacer, comenzar rápidamente, personalizar de forma privada los FM con sus propios datos e integrarlos e implementarlos fácilmente en sus aplicaciones utilizando las herramientas y capacidades de AWS. con los que están familiarizados (incluidas las integraciones con las características de Amazon SageMaker ML, como Experiments para probar diferentes modelos y Pipelines para administrar sus FM a escala) sin tener que administrar ninguna infraestructura.

Los clientes de Bedrock pueden elegir entre algunos de los FM más avanzados disponibles en la actualidad. Esto incluye la familia Jurassic-2 de LLM multilingües de AI21 Labs, que siguen instrucciones de lenguaje natural para generar texto en español, francés, alemán, portugués, italiano y holandés. Claude, LLM de Anthropic, puede realizar una amplia variedad de tareas de procesamiento de texto y conversacionales y se basa en la extensa investigación de Anthropic sobre el entrenamiento de sistemas de IA honestos y responsables. Bedrock también facilita el acceso al conjunto de modelos básicos de texto a imagen de Stability AI, incluido Stable Diffusion (el más popular de su tipo), que es capaz de generar imágenes, arte, logotipos y contenido únicos, realistas y de alta calidad. diseños

Una de las capacidades más importantes de Bedrock es lo fácil que es personalizar un modelo. Los clientes simplemente señalan a Bedrock en algunos ejemplos etiquetados en Amazon S3, y el servicio puede ajustar el modelo para una tarea en particular sin tener que anotar grandes volúmenes de datos (con tan solo 20 ejemplos es suficiente). Imagine un gerente de marketing de contenido que trabaja en un minorista de moda líder y necesita desarrollar un anuncio y una campaña nuevos y específicos para una próxima línea nueva de bolsos. Para hacer esto, proporcionan a Bedrock algunos ejemplos etiquetados de sus eslóganes de mejor rendimiento de campañas anteriores, junto con las descripciones de los productos asociados, y Bedrock automáticamente comenzará a generar medios sociales efectivos, anuncios gráficos y copia web para los nuevos bolsos. Ninguno de los datos del cliente se usa para entrenar los modelos subyacentes, y dado que todos los datos están encriptados y no salen de la nube privada virtual (VPC) de un cliente, los clientes pueden confiar en que sus datos permanecerán privados y confidenciales.

Bedrock está ahora en versión preliminar limitada y a los clientes les gusta Coda están entusiasmados con la rapidez con la que sus equipos de desarrollo se han puesto en marcha. Shishir Mehrotra, cofundador y director ejecutivo de Coda, dice: “Como cliente feliz de AWS desde hace mucho tiempo, estamos entusiasmados con la forma en que Amazon Bedrock puede brindar calidad, escalabilidad y rendimiento a Coda AI. Dado que todos nuestros datos ya están en AWS, podemos incorporar rápidamente IA generativa mediante Bedrock, con toda la seguridad y privacidad que necesitamos para proteger nuestros datos integrados. Con más de decenas de miles de equipos que se ejecutan en Coda, incluidos equipos grandes como Uber, New York Times y Square, la confiabilidad y la escalabilidad son realmente importantes”.

Hemos realizado una vista previa de los nuevos Titan FM de Amazon con algunos clientes antes de que estén disponibles de manera más amplia en los próximos meses. Inicialmente tendremos dos modelos Titan. El primero es un LLM generativo para tareas como resumen, generación de texto (por ejemplo, creación de una publicación de blog), clasificación, preguntas y respuestas abiertas y extracción de información. El segundo es un LLM de incrustaciones que traduce las entradas de texto (palabras, frases o posiblemente grandes unidades de texto) en representaciones numéricas (conocidas como incrustaciones) que contienen el significado semántico del texto. Si bien este LLM no generará texto, es útil para aplicaciones como la personalización y la búsqueda porque al comparar incrustaciones, el modelo producirá respuestas más relevantes y contextuales que la coincidencia de palabras. De hecho, la capacidad de búsqueda de productos de Amazon.com utiliza un modelo de incrustaciones similar, entre otros, para ayudar a los clientes a encontrar los productos que buscan. Para continuar respaldando las mejores prácticas en el uso responsable de la IA, los Titan FM están diseñados para detectar y eliminar contenido dañino en los datos, rechazar contenido inapropiado en la entrada del usuario y filtrar las salidas de los modelos que contienen contenido inapropiado (como discurso de odio, blasfemias y violencia).

Bedrock hace que el poder de los FM sea accesible para empresas de todos los tamaños para que puedan acelerar el uso de ML en sus organizaciones y crear sus propias aplicaciones generativas de IA porque será fácil para todos los desarrolladores. Creemos que Bedrock será un gran paso adelante en la democratización de los FM, y nuestros socios como Accenture, Deloitte, Infosys y Slalom están construyendo prácticas para ayudar a las empresas a ir más rápido con IA generativa. Proveedores de software independientes (ISV) como IA C3 y Pega están emocionados de aprovechar Bedrock para acceder fácilmente a su gran selección de FM con toda la seguridad, privacidad y confiabilidad que esperan de AWS.

Anuncio de la disponibilidad general de las instancias Amazon EC2 Trn1n con tecnología de AWS Trainium y las instancias de Amazon EC2 Inf2 con tecnología de AWS Inferentia2, la infraestructura en la nube más rentable para la IA generativa

Independientemente de lo que los clientes intenten hacer con los FM (ejecutarlos, desarrollarlos, personalizarlos), necesitan la infraestructura más rentable y de mayor rendimiento diseñada específicamente para ML. Durante los últimos cinco años, AWS ha estado invirtiendo en su propio silicio para impulsar el rendimiento y la relación precio-rendimiento para cargas de trabajo exigentes como capacitación e inferencia de aprendizaje automático, y nuestros chips AWS Trainium y AWS Inferentia ofrecen el costo más bajo para modelos de capacitación y ejecución de inferencia. en las nubes. Esta capacidad de maximizar el rendimiento y controlar los costos al elegir la infraestructura de aprendizaje automático óptima es la razón por la cual las empresas emergentes de IA líderes, como AI21 Labs, Anthropic, Cohere, Grammarly, Hugging Face, Runway y Stability AI, se ejecutan en AWS.

Las instancias Trn1, con tecnología de Trainium, pueden ofrecer hasta un 50 % de ahorro en los costos de capacitación en comparación con cualquier otra instancia EC2, y están optimizadas para distribuir la capacitación en varios servidores conectados con 800 Gbps de red Elastic Fabric Adapter (EFA) de segunda generación. Los clientes pueden implementar instancias Trn1 en UltraClusters que pueden escalar hasta 30,000 6 chips Trainium (más de 1 exaflops de cómputo) ubicados en la misma zona de disponibilidad de AWS con redes a escala petabit. Muchos clientes de AWS, incluidos Helixon, Money Forward y el equipo de búsqueda de Amazon, usan instancias Trn800 para ayudar a reducir el tiempo necesario para entrenar los modelos de aprendizaje profundo a mayor escala de meses a semanas o incluso días, al tiempo que reducen sus costos. XNUMX Gbps es mucho ancho de banda, pero hemos seguido innovando para ofrecer más, y hoy anunciamos el disponibilidad general de nuevos, optimizados para la red trn1n instancias, que ofrecen 1600 Gbps de ancho de banda de red y están diseñados para ofrecer un rendimiento un 20 % más alto que Trn1 para modelos grandes que hacen un uso intensivo de la red.

Hoy en día, la mayor parte del tiempo y el dinero gastados en FM se dedican a capacitarlos. Esto se debe a que muchos clientes recién comienzan a implementar FM en producción. Sin embargo, en el futuro, cuando los FM se implementen a escala, la mayoría de los costos estarán asociados con la ejecución de los modelos y la inferencia. Si bien normalmente entrena un modelo periódicamente, una aplicación de producción puede generar constantemente predicciones, conocidas como inferencias, lo que podría generar millones por hora. Y estas predicciones deben ocurrir en tiempo real, lo que requiere redes de muy baja latencia y alto rendimiento. Alexa es un gran ejemplo con millones de solicitudes que ingresan cada minuto, lo que representa el 40% de todos los costos de cómputo.

Debido a que sabíamos que la mayoría de los costos futuros de ML provendrían de la ejecución de inferencias, priorizamos el silicio optimizado por inferencia cuando comenzamos a invertir en nuevos chips hace unos años. En 2018, anunciamos Inferentia, el primer chip especialmente diseñado para inferencia. Cada año, Inferentia ayuda a Amazon a ejecutar billones de inferencias y ya ha ahorrado a empresas como Amazon más de cien millones de dólares en gastos de capital. Los resultados son impresionantes y vemos muchas oportunidades para seguir innovando, ya que las cargas de trabajo solo aumentarán en tamaño y complejidad a medida que más clientes integren IA generativa en sus aplicaciones.

Es por eso que estamos anunciando hoy el disponibilidad general de Inf2 instancias con tecnología de AWS Inferencea2, que están optimizados específicamente para aplicaciones de IA generativa a gran escala con modelos que contienen cientos de miles de millones de parámetros. Las instancias Inf2 ofrecen un rendimiento hasta 4 veces mayor y una latencia hasta 10 veces menor en comparación con las instancias basadas en Inferentia de la generación anterior. También tienen conectividad de ultra alta velocidad entre aceleradores para soportar la inferencia distribuida a gran escala. Estas capacidades impulsan hasta un 40 % más de rendimiento de precio de inferencia que otras instancias comparables de Amazon EC2 y el costo más bajo para la inferencia en la nube. Clientes como Runway obtienen hasta 2 veces más rendimiento con Inf2 que con instancias comparables de Amazon EC2 para algunos de sus modelos. Esta inferencia de alto rendimiento y bajo costo permitirá que Runway introduzca más funciones, implemente modelos más complejos y, en última instancia, brinde una mejor experiencia para los millones de creadores que usan Runway.

Anuncio de la disponibilidad general de Amazon CodeWhisperer, gratis para desarrolladores individuales

Sabemos que construir con los FM correctos y ejecutar aplicaciones de IA generativa a escala en la infraestructura de nube de mayor rendimiento será transformador para los clientes. La nueva ola de experiencias también será transformadora para los usuarios. Con la IA generativa incorporada, los usuarios podrán tener interacciones más naturales y fluidas con las aplicaciones y los sistemas. Piensa en cómo podemos desbloquear nuestros móviles con solo mirarlos, sin necesidad de saber nada de los potentes modelos ML que hacen posible esta función.

Un área en la que prevemos que el uso de la IA generativa crecerá rápidamente es la codificación. Los desarrolladores de software hoy en día dedican una cantidad significativa de su tiempo a escribir código que es bastante sencillo e indiferenciado. También pasan mucho tiempo tratando de mantenerse al día con un panorama tecnológico y de herramientas complejo y en constante cambio. Todo esto deja a los desarrolladores menos tiempo para desarrollar capacidades y servicios nuevos e innovadores. Los desarrolladores intentan superar esto copiando y modificando fragmentos de código de la web, lo que puede resultar en la copia inadvertida de código que no funciona, contiene vulnerabilidades de seguridad o no rastrea el uso de software de código abierto. Y, en última instancia, buscar y copiar todavía le quita tiempo a las cosas buenas.

La IA generativa puede eliminar este trabajo pesado de la ecuación al "escribir" gran parte del código indiferenciado, lo que permite a los desarrolladores crear más rápido mientras los libera para concentrarse en los aspectos más creativos de la codificación. Por eso, el año pasado, anunciamos el avance de Código de Amazon Whisperer, un compañero de codificación de IA que utiliza un FM bajo el capó para mejorar radicalmente la productividad de los desarrolladores al generar sugerencias de código en tiempo real basadas en los comentarios de los desarrolladores en lenguaje natural y código anterior en su entorno de desarrollo integrado (IDE). Los desarrolladores pueden simplemente decirle a CodeWhisperer que realice una tarea, como "analizar una cadena de canciones CSV" y pedirle que devuelva una lista estructurada basada en valores como el artista, el título y la clasificación más alta en la lista. CodeWhisperer proporciona un aumento de la productividad al generar una función completa que analiza la cadena y devuelve la lista como se especifica. La respuesta de los desarrolladores a la vista previa ha sido abrumadoramente positiva y seguimos creyendo que ayudar a los desarrolladores a codificar podría terminar siendo uno de los usos más poderosos de la IA generativa que veremos en los próximos años. Durante la versión preliminar, realizamos un desafío de productividad y los participantes que usaron CodeWhisperer completaron tareas un 57 % más rápido, en promedio, y tenían un 27 % más de probabilidades de completarlas con éxito que aquellos que no usaron CodeWhisperer. Este es un gran paso adelante en la productividad de los desarrolladores, y creemos que esto es solo el comienzo.

Hoy, nos complace anunciar el disponibilidad general de Amazon CodeWhisperer para Python, Java, JavaScript, TypeScript y C#, además de diez nuevos lenguajes, incluidos Go, Kotlin, Rust, PHP y SQL. Se puede acceder a CodeWhisperer desde IDE como VS Code, IntelliJ IDEA, AWS Cloud9 y muchos más a través de las extensiones IDE de AWS Toolkit. CodeWhisperer también está disponible en la consola de AWS Lambda. Además de aprender de los miles de millones de líneas de código disponibles públicamente, CodeWhisperer ha recibido capacitación sobre el código de Amazon. Creemos que CodeWhisperer es ahora la forma más precisa, rápida y segura de generar código para los servicios de AWS, incluidos Amazon EC2, AWS Lambda y Amazon S3.

Los desarrolladores realmente no van a ser más productivos si el código sugerido por su herramienta de IA generativa contiene vulnerabilidades de seguridad ocultas o no maneja el código abierto de manera responsable. CodeWhisperer es el único compañero de codificación de IA con escaneo de seguridad incorporado (impulsado por razonamiento automatizado) para encontrar y sugerir soluciones para vulnerabilidades difíciles de detectar, como las que se encuentran en los diez principales Proyectos de seguridad de aplicaciones mundiales abiertas (OWASP), los que no cumple con las mejores prácticas de la biblioteca criptográfica y otros. Para ayudar a los desarrolladores a codificar de manera responsable, CodeWhisperer filtra las sugerencias de código que podrían considerarse parciales o injustas, y CodeWhisperer es el único compañero de codificación que puede filtrar y marcar las sugerencias de código que se asemejan al código fuente abierto que los clientes pueden querer consultar o licenciar para su uso.

Sabemos que la IA generativa va a cambiar el juego para los desarrolladores, y queremos que sea útil para tantos como sea posible. ¡Es por eso que CodeWhisperer es gratuito para todos los usuarios individuales sin calificaciones ni límites de tiempo para generar código! Cualquiera puede registrarse en CodeWhisperer con solo una cuenta de correo electrónico y ser más productivo en cuestión de minutos. Ni siquiera tiene que tener una cuenta de AWS. Para los usuarios comerciales, ofrecemos un nivel profesional de CodeWhisperer que incluye funciones de administración como inicio de sesión único (SSO) con integración de AWS Identity and Access Management (IAM), así como límites más altos en el escaneo de seguridad.

La creación de aplicaciones potentes como CodeWhisperer es transformadora para los desarrolladores y todos nuestros clientes. Tenemos mucho más por venir y estamos entusiasmados con lo que construirá con IA generativa en AWS. Nuestra misión es hacer posible que los desarrolladores de todos los niveles de habilidad y las organizaciones de todos los tamaños innoven utilizando IA generativa. Este es solo el comienzo de lo que creemos que será la próxima ola de ML que impulsará nuevas posibilidades para usted.

Recursos

Consulte los siguientes recursos para obtener más información sobre la IA generativa en AWS y estos anuncios:

Acerca del autor.

Swami Sivasubramanian es vicepresidente de datos y aprendizaje automático en AWS. En este rol, Swami supervisa todos los servicios de AWS Database, Analytics, AI & Machine Learning. La misión de su equipo es ayudar a las organizaciones a poner sus datos a trabajar con una solución de datos completa e integral para almacenar, acceder, analizar, visualizar y predecir.

Swami Sivasubramanian es vicepresidente de datos y aprendizaje automático en AWS. En este rol, Swami supervisa todos los servicios de AWS Database, Analytics, AI & Machine Learning. La misión de su equipo es ayudar a las organizaciones a poner sus datos a trabajar con una solución de datos completa e integral para almacenar, acceder, analizar, visualizar y predecir.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-for-building-with-generative-ai-on-aws/