Los modelos de lenguaje grandes (LLM) son la fuerza impulsora detrás de la revolución de la IA, pero el juego acaba de dar un giro importante en la trama. Databricks DBRX, un innovador código abierto LLM, está aquí para desafiar el status quo. Superando a los modelos establecidos y compitiendo cara a cara con los líderes de la industria, DBRX cuenta con un rendimiento y una eficiencia superiores. Sumérgete en el mundo de los LLM y explora cómo DBRX está reescribiendo el libro de reglas, ofreciendo una visión del emocionante futuro de procesamiento natural del lenguaje.

Tabla de contenidos.

Comprender los LLM y los LLM de código abierto

Los modelos de lenguaje grande (LLM) son modelos avanzados de procesamiento del lenguaje natural que pueden comprender y generar texto similar al humano. Estos modelos se han vuelto cada vez más importantes en diversas aplicaciones, como la comprensión de lenguajes, la programación y las matemáticas.

Los LLM de código abierto desempeñan un papel crucial en el desarrollo y avance de la tecnología de procesamiento del lenguaje natural. Proporcionan a la comunidad abierta y a las empresas acceso a modelos de lenguaje de vanguardia, lo que les permite crear y personalizar sus modelos para aplicaciones y casos de uso específicos.

¿Qué es Databricks DBRX?

Databricks DBRX es un modelo de lenguaje grande (LLM) abierto y de uso general desarrollado por Databricks. Ha establecido un nuevo estado del arte para LLM abiertos establecidos, superando a GPT-3.5 y rivalizando con Gemini 1.0 Pro. DBRX sobresale en varios puntos de referencia, incluida la comprensión del lenguaje, la programación y las matemáticas. Se entrena utilizando la predicción del siguiente token con una arquitectura de mezcla de expertos (MoE) detallada, lo que resulta en mejoras significativas en el rendimiento del entrenamiento y la inferencia.

El modelo está disponible para los clientes de Databricks a través de API y se puede entrenar previamente o ajustar. Su eficiencia se destaca por el rendimiento de entrenamiento e inferencia, superando a otros modelos establecidos y siendo aproximadamente un 40% del tamaño de modelos similares. DBRX es un componente fundamental de la próxima generación de productos GenAI de Databricks, diseñado para empoderar a las empresas y a la comunidad abierta.

La arquitectura MoE de Databricks DBRX

DBRX de Databricks se destaca como un modelo de lenguaje grande (LLM) de uso general y código abierto con una arquitectura única para lograr eficiencia. Aquí hay un desglose de sus características clave:

- Mezcla detallada de expertos (MoE): Esta arquitectura innovadora utiliza 132 mil millones de parámetros totales, con solo 36 mil millones activos por entrada. Este enfoque en los parámetros activos mejora significativamente la eficiencia en comparación con otros modelos.

- Poder experto: DBRX emplea a 16 expertos y selecciona 4 para cada tarea, lo que ofrece una asombrosa cantidad de 65 veces más combinaciones de expertos posibles, lo que lleva a una calidad superior del modelo.

- Técnicas avanzadas: El modelo aprovecha técnicas de vanguardia como codificaciones de posición rotatoria (RoPE), unidades lineales cerradas (GLU) y atención de consultas agrupadas (GQA), lo que mejora aún más su rendimiento.

- Campeón de eficiencia: DBRX cuenta con velocidades de inferencia hasta dos veces más rápidas que LLaMA2-70B. Además, cuenta con un tamaño compacto, siendo aproximadamente un 40 % más pequeño que Grok-1 en recuentos de parámetros totales y activos.

- Rendimiento en el mundo real: Cuando se aloja en Mosaic AI Model Serving, DBRX ofrece velocidades de generación de texto de hasta 150 tokens por segundo por usuario.

- Líder de Eficiencia en Capacitación: El proceso de formación para DBRX demuestra mejoras significativas en la eficiencia informática. Requiere aproximadamente la mitad de FLOP (operaciones de punto flotante) en comparación con el entrenamiento de modelos densos para obtener el mismo nivel de calidad final.

Entrenamiento DBRX

La formación de un LLM potente como DBRX no está exenta de obstáculos. He aquí un vistazo más de cerca al proceso de formación:

- Desafíos: El desarrollo de modelos mixtos de expertos como DBRX presentó importantes obstáculos científicos y de rendimiento. Databricks necesitaba superar estos desafíos para crear una canalización sólida capaz de entrenar de manera eficiente modelos de clase DBRX.

- Avance en eficiencia: El proceso de capacitación para DBRX ha logrado mejoras notables en la eficiencia informática. Tomemos como ejemplo DBRX MoE-B, un modelo más pequeño de la familia DBRX, que requirió 1.7 veces menos FLOP (operaciones de punto flotante) para alcanzar una puntuación del 45.5 % en Databricks LLM Gauntlet en comparación con otros modelos.

- Líder de Eficiencia: Este logro resalta la efectividad del proceso de capacitación de DBRX. Posiciona a DBRX como líder entre los modelos de código abierto e incluso rivaliza con el GPT-3.5 Turbo en tareas RAG, al mismo tiempo que cuenta con una eficiencia superior.

DBRX frente a otros LLM

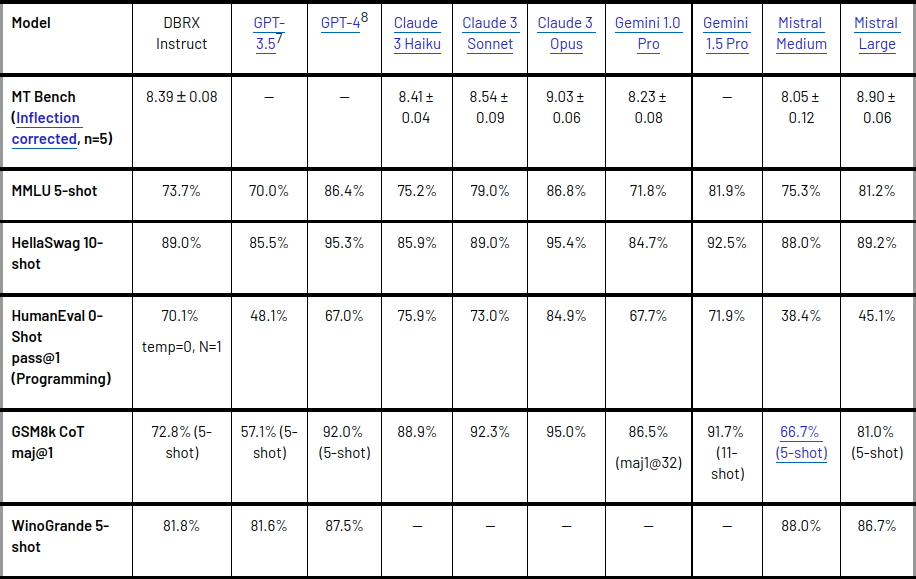

Métricas y resultados

- DBRX se ha medido con respecto a modelos establecidos de código abierto en tareas de comprensión del lenguaje.

- Ha superado a GPT-3.5 y es competitivo con Gemini 1.0 Pro.

- El modelo ha demostrado sus capacidades en varios puntos de referencia, incluidos puntos de referencia compuestos, programación, matemáticas y MMLU.

- Ha superado a todos los modelos ajustados de chat o instrucción en puntos de referencia estándar, obteniendo la puntuación más alta en puntos de referencia compuestos como Hugging Face Open LLM Leaderboard y Databricks Model Gauntlet.

- Además, DBRX Instruct ha demostrado un rendimiento superior en tareas de contexto largo y RAG, superando a GPT-3.5 Turbo en todas las longitudes de contexto y en todas las partes de la secuencia.

Fortalezas y debilidades en comparación con otros modelos

DBRX Instruct ha demostrado su fortaleza en programación y matemáticas, obteniendo una puntuación más alta que otros modelos abiertos en puntos de referencia como HumanEval y GSM8k. También ha mostrado un rendimiento competitivo con Gemini 1.0 Pro y Mistral Medium, superando a Gemini 1.0 Pro en varios puntos de referencia. Sin embargo, es importante tener en cuenta que la calidad del modelo y la eficiencia de la inferencia suelen estar en tensión y, si bien DBRX sobresale en calidad, los modelos más pequeños son más eficientes para la inferencia. A pesar de esto, se ha demostrado que DBRX logra mejores compensaciones entre la calidad del modelo y la eficiencia de la inferencia que las que normalmente logran los modelos densos.

Innovaciones clave en DBRX

DBRX, desarrollado por Databricks, introduce varias innovaciones clave que lo diferencian de los modelos propietarios y de código abierto existentes. El modelo utiliza una arquitectura de mezcla de expertos (MoE) detallada con 132 B de parámetros totales, de los cuales 36 B están activos en cualquier entrada.

Esta arquitectura permite a DBRX proporcionar un proceso de capacitación sólido y eficiente, superando a GPT-3.5 Turbo y desafiando a GPT-4 Turbo en aplicaciones como SQL. Además, DBRX emplea a 16 expertos y elige 4, lo que proporciona 65 veces más combinaciones posibles de expertos, lo que da como resultado una mejor calidad del modelo.

El modelo también incorpora codificaciones de posición rotatoria (RoPE), unidades lineales cerradas (GLU) y atención de consultas agrupadas (GQA), lo que contribuye a su rendimiento excepcional.

Ventajas de DBRX sobre los modelos propietarios y de código abierto existentes

DBRX ofrece varias ventajas sobre los modelos propietarios y de código abierto existentes. Supera a GPT-3.5 y es competitivo con Gemini 1.0 Pro, demostrando sus capacidades en varios puntos de referencia, incluidos puntos de referencia compuestos, programación, matemáticas y MMLU.

- Además, DBRX Instruct, una variante de DBRX, supera a GPT-3.5 en conocimientos generales, razonamiento de sentido común, programación y razonamiento matemático.

- También sobresale en tareas de contexto largo, superando a GPT-3.5 Turbo en todas las longitudes de contexto y en todas las partes de la secuencia.

- Además, DBRX Instruct es competitivo con Gemini 1.0 Pro y Mistral Medium, superando a Gemini 1.0 Pro en varios puntos de referencia.

La eficiencia del modelo se destaca por su rendimiento de entrenamiento e inferencia, superando a otros modelos establecidos y siendo aproximadamente un 40% del tamaño de modelos similares. La arquitectura MoE detallada y el proceso de capacitación de DBRX han demostrado mejoras sustanciales en la eficiencia informática, lo que la hace aproximadamente 2 veces más eficiente en FLOP que el entrenamiento de modelos densos para la misma calidad del modelo final.

Lea también Claude vs GPT: ¿Cuál es mejor LLM?

Conclusión

Databricks DBRX, con su innovadora arquitectura de combinación de expertos, eclipsa a GPT-3.5 y compite con Gemini 1.0 Pro en comprensión del lenguaje. Su MoE detallado, sus técnicas avanzadas y su eficiencia informática superior la convierten en una solución atractiva para las empresas y la comunidad abierta, y promete avances innovadores en el procesamiento del lenguaje natural. El futuro de los LLM es más brillante con DBRX a la cabeza.

Siganos en noticias de Google para mantenerse actualizado con las últimas innovaciones en el mundo de la inteligencia artificial, la ciencia de datos y GenAI.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.analyticsvidhya.com/blog/2024/03/databricks-dbrx/