Las aplicaciones de inteligencia artificial (IA) generativa creadas en torno a grandes modelos de lenguaje (LLM) han demostrado el potencial de crear y acelerar valor económico para las empresas. Ejemplos de aplicaciones incluyen búsqueda conversacional, asistencia del agente de atención al cliente, análisis de atención al cliente, asistentes virtuales de autoservicio, Chatbots, generación de medios enriquecidos, moderación de contenido, Compañeros de codificación para acelerar el desarrollo de software seguro y de alto rendimiento., conocimientos más profundos de fuentes de contenido multimodal, aceleración de las investigaciones y mitigaciones de seguridad de su organización, y mucho más. Muchos clientes buscan orientación sobre cómo gestionar la seguridad, la privacidad y el cumplimiento mientras desarrollan aplicaciones de IA generativa. Comprender y abordar las vulnerabilidades, amenazas y riesgos de LLM durante las fases de diseño y arquitectura ayuda a los equipos a centrarse en maximizar los beneficios económicos y de productividad que la IA generativa puede aportar. Ser consciente de los riesgos fomenta la transparencia y la confianza en las aplicaciones de IA generativa, fomenta una mayor observabilidad, ayuda a cumplir con los requisitos de cumplimiento y facilita la toma de decisiones informadas por parte de los líderes.

El objetivo de esta publicación es capacitar a los ingenieros de IA y aprendizaje automático (ML), científicos de datos, arquitectos de soluciones, equipos de seguridad y otras partes interesadas para que tengan un modelo mental y un marco común para aplicar las mejores prácticas de seguridad, permitiendo que los equipos de AI/ML se muevan. rápido sin sacrificar seguridad por velocidad. Específicamente, esta publicación busca ayudar a los científicos de datos y de IA/ML que quizás no hayan tenido una exposición previa a los principios de seguridad a comprender las mejores prácticas básicas de seguridad y privacidad en el contexto del desarrollo de aplicaciones de IA generativa utilizando LLM. También discutimos preocupaciones de seguridad comunes que pueden socavar la confianza en la IA, como lo identifica el Open Worldwide Application Security Project (OWASP) Top 10 para aplicaciones LLMy muestre formas en que puede utilizar AWS para aumentar su postura de seguridad y su confianza mientras innova con IA generativa.

Esta publicación proporciona tres pasos guiados para diseñar estrategias de gestión de riesgos mientras se desarrollan aplicaciones de IA generativa mediante LLM. Primero, profundizamos en las vulnerabilidades, amenazas y riesgos que surgen de la implementación, el despliegue y el uso de soluciones LLM, y brindamos orientación sobre cómo comenzar a innovar teniendo en cuenta la seguridad. Luego analizamos cómo construir sobre una base segura es esencial para la IA generativa. Por último, los conectamos con una carga de trabajo de LLM de ejemplo para describir un enfoque hacia la arquitectura con seguridad de defensa en profundidad a través de límites de confianza.

Al final de esta publicación, Los ingenieros de IA/ML, los científicos de datos y los tecnólogos preocupados por la seguridad podrán identificar estrategias para diseñar defensas en capas para sus aplicaciones de IA generativa, comprender cómo asignar los 10 principales problemas de seguridad de OWASP para LLM a algunos controles correspondientes y desarrollar conocimientos fundamentales para lograrlo. respondiendo los siguientes temas principales de preguntas de los clientes de AWS sobre sus aplicaciones:

- ¿Cuáles son algunos de los riesgos comunes de seguridad y privacidad al usar IA generativa basada en LLM en mis aplicaciones en los que puedo impactar más con esta guía?

- ¿Cuáles son algunas formas de implementar controles de seguridad y privacidad en el ciclo de vida de desarrollo de aplicaciones LLM de IA generativa en AWS?

- ¿Qué mejores prácticas operativas y técnicas puedo integrar en la forma en que mi organización crea aplicaciones LLM de IA generativa para gestionar el riesgo y aumentar la confianza en las aplicaciones de IA generativa que utilizan LLM?

Mejore los resultados de seguridad mientras desarrolla IA generativa

La innovación con IA generativa mediante el uso de LLM requiere comenzar teniendo en cuenta la seguridad para desarrollar la resiliencia organizacional, construir sobre una base segura e integrar la seguridad con un enfoque de seguridad de defensa en profundidad. La seguridad es un responsabilidad compartida entre AWS y los clientes de AWS. Todos los principios del modelo de responsabilidad compartida de AWS son aplicables a las soluciones de IA generativa. Actualice su comprensión del modelo de responsabilidad compartida de AWS en su aplicación a la infraestructura, los servicios y los datos cuando cree soluciones LLM.

Comience teniendo en cuenta la seguridad para desarrollar la resiliencia organizacional

Comience con la seguridad en mente para desarrollar la resiliencia organizacional para desarrollar aplicaciones de IA generativa que cumplan con sus objetivos de seguridad y cumplimiento. La resiliencia organizacional se basa y extiende la definición de resiliencia en el marco de buena arquitectura de AWS incluir y prepararse para la capacidad de una organización para recuperarse de las interrupciones. Considere su postura de seguridad, gobernanza y excelencia operativa al evaluar la preparación general para desarrollar IA generativa con LLM y la resiliencia de su organización ante cualquier impacto potencial. A medida que su organización avanza en el uso de tecnologías emergentes, como la IA generativa y los LLM, la resiliencia organizacional general debe considerarse como la piedra angular de una estrategia defensiva en capas para proteger los activos y las líneas de negocio de consecuencias no deseadas.

La resiliencia organizacional es muy importante para las solicitudes de LLM

Aunque todos los programas de gestión de riesgos pueden beneficiarse de la resiliencia, la resiliencia organizacional es sustancialmente importante para la IA generativa. Cinco de los 10 riesgos principales identificados por OWASP para las aplicaciones LLM dependen de la definición de controles arquitectónicos y operativos y su aplicación a escala organizacional para gestionar el riesgo. Estos cinco riesgos son el manejo inseguro de la producción, las vulnerabilidades de la cadena de suministro, la divulgación de información confidencial, la agencia excesiva y la dependencia excesiva. Comience a aumentar la resiliencia organizacional socializando a sus equipos para que consideren la seguridad de la IA, el aprendizaje automático y la IA generativa como un requisito comercial central y una prioridad máxima durante todo el ciclo de vida del producto, desde el inicio de la idea hasta la investigación, el desarrollo, la implementación y la implementación de la aplicación. usar. Además de la concientización, sus equipos deben tomar medidas para tener en cuenta la IA generativa en las prácticas de gobernanza, aseguramiento y validación del cumplimiento.

Desarrollar resiliencia organizacional en torno a la IA generativa

Las organizaciones pueden comenzar a adoptar formas de desarrollar su capacidad y capacidades para IA/ML y seguridad de IA generativa dentro de sus organizaciones. Debería comenzar ampliando sus programas existentes de seguridad, garantía, cumplimiento y desarrollo para tener en cuenta la IA generativa.

Las siguientes son las cinco áreas clave de interés para la seguridad de la IA organizacional, el aprendizaje automático y la IA generativa:

- Comprender el panorama de seguridad de IA/ML

- Incluir diversas perspectivas en las estrategias de seguridad.

- Tomar medidas proactivas para asegurar las actividades de investigación y desarrollo.

- Alinear los incentivos con los resultados organizacionales

- Prepárese para escenarios de seguridad realistas en IA/ML e IA generativa

Desarrolle un modelo de amenaza a lo largo de su ciclo de vida de IA generativa

Las organizaciones que construyen con IA generativa deben centrarse en la gestión de riesgos, no en su eliminación, e incluir modelado de amenazas y en Planificación de la Continuidad del Negocio la planificación, el desarrollo y las operaciones de cargas de trabajo de IA generativa. Trabaje hacia atrás desde el uso de producción de IA generativa mediante el desarrollo de un modelo de amenaza para cada aplicación utilizando riesgos de seguridad tradicionales, así como riesgos específicos de IA generativa. Algunos riesgos pueden ser aceptables para su empresa y un ejercicio de modelado de amenazas puede ayudar a su empresa a identificar cuál es su apetito de riesgo aceptable. Por ejemplo, es posible que su empresa no requiera un tiempo de actividad del 99.999 % en una aplicación de IA generativa, por lo que el tiempo de recuperación adicional asociado a la recuperación mediante Copia de seguridad de AWS Glaciar Amazon S3 puede ser un riesgo aceptable. Por el contrario, los datos de su modelo pueden ser extremadamente sensibles y estar altamente regulados, por lo que la desviación de Servicio de administración de claves de AWS (AWS KMS) clave administrada por el cliente (CMK) rotación y uso de Cortafuegos de red de AWS ayudar a aplicar la seguridad de la capa de transporte (TLS) para el tráfico de entrada y salida para proteger contra la filtración de datos puede ser un riesgo inaceptable.

Evalúe los riesgos (inherentes versus residuales) del uso de la aplicación de IA generativa en un entorno de producción para identificar los controles básicos y de nivel de aplicación correctos. Planifique la reversión y recuperación de eventos de seguridad de producción e interrupciones del servicio, como inyección rápida, envenenamiento de datos de capacitación, denegación de servicio de modelo y robo de modelo, y defina las mitigaciones que utilizará al definir los requisitos de la aplicación. Aprender sobre los riesgos y controles que deben implementarse ayudará a definir el mejor enfoque de implementación para crear una aplicación de IA generativa y brindará a las partes interesadas y a los tomadores de decisiones información para tomar decisiones comerciales informadas sobre el riesgo. Si no está familiarizado con el flujo de trabajo general de IA y ML, comience revisando Siete formas de mejorar la seguridad de sus cargas de trabajo de aprendizaje automático para aumentar la familiaridad con los controles de seguridad necesarios para los sistemas tradicionales de IA/ML.

Al igual que crear cualquier aplicación de aprendizaje automático, crear una aplicación de IA generativa implica pasar por una serie de etapas del ciclo de vida de investigación y desarrollo. Es posible que desee revisar el Matriz de alcance de seguridad de IA generativa de AWS para ayudar a construir un modelo mental para comprender las disciplinas de seguridad clave que debe considerar según la solución de IA generativa que seleccione.

Las aplicaciones de IA generativa que utilizan LLM generalmente se desarrollan y operan siguiendo pasos ordenados:

- Requerimientos de aplicacion – Identificar los objetivos comerciales, los requisitos y los criterios de éxito del caso de uso.

- Selección de modelo – Seleccionar un modelo básico que se alinee con los requisitos del caso de uso.

- Adaptación y ajuste del modelo. – Preparar datos, diseñar indicaciones y ajustar el modelo.

- Evaluación modelo – Evaluar los modelos básicos con métricas específicas de casos de uso y seleccionar el modelo con mejor rendimiento.

- Despliegue e integración – Implemente el modelo básico seleccionado en su infraestructura optimizada e intégrelo con su aplicación de IA generativa

- Monitoreo de aplicaciones – Supervisar el rendimiento de la aplicación y del modelo para permitir el análisis de la causa raíz.

Asegúrese de que los equipos comprendan la naturaleza crítica de la seguridad como parte de las fases de diseño y arquitectura del ciclo de vida de desarrollo de software desde el día 1. Esto significa discutir la seguridad en cada capa de su pila y ciclo de vida, y posicionar la seguridad y la privacidad como facilitadores para lograr los objetivos comerciales. Diseñe controles para detectar amenazas antes de iniciar su aplicación LLM y considere si los datos y la información que utilizará para la adaptación y el ajuste del modelo justifican la implementación de controles en los entornos de investigación, desarrollo y capacitación. Como parte de las pruebas de control de calidad, introduzca amenazas de seguridad sintéticas (como intentar envenenar los datos de capacitación o intentar extraer datos confidenciales mediante ingeniería rápida maliciosa) para probar sus defensas y su postura de seguridad de forma regular.

Además, las partes interesadas deben establecer una cadencia de revisión consistente para las cargas de trabajo de producción de IA, ML e IA generativa y establecer una prioridad organizacional para comprender las compensaciones entre el control y el error humano y de la máquina antes del lanzamiento. Validar y garantizar que estas compensaciones se respeten en las aplicaciones LLM implementadas aumentará la probabilidad de éxito en la mitigación de riesgos.

Cree aplicaciones de IA generativa sobre bases seguras en la nube

En AWS, la seguridad es nuestra principal prioridad. AWS está diseñado para ser la infraestructura de nube global más segura sobre la cual construir, migrar y administrar aplicaciones y cargas de trabajo. Esto está respaldado por nuestro amplio conjunto de más de 300 herramientas de seguridad en la nube y la confianza de nuestros millones de clientes, incluidas las organizaciones más sensibles a la seguridad, como el gobierno, la atención médica y los servicios financieros. Al crear aplicaciones de IA generativa utilizando LLM en AWS, obtiene beneficios de seguridad del Entorno de computación en la nube de AWS seguro, confiable y flexible.

Utilice una infraestructura global de AWS para seguridad, privacidad y cumplimiento

Cuando desarrolla aplicaciones con uso intensivo de datos en AWS, puede beneficiarse de una infraestructura de región global de AWS, diseñada para brindar capacidades que cumplan con sus requisitos básicos de seguridad y cumplimiento. Esto se ve reforzado por nuestra Compromiso de soberanía digital de AWS, nuestro compromiso de ofrecerle el conjunto más avanzado de controles y funciones de soberanía disponibles en la nube. Estamos comprometidos a ampliar nuestras capacidades para permitirle cumplir con sus soberanía digital necesidades, sin comprometer el rendimiento, la innovación, la seguridad o la escala de la nube de AWS. Para simplificar la implementación de las mejores prácticas de seguridad y privacidad, considere utilizar infraestructura y diseños de referencia como recursos de código, como el Arquitectura de referencia de seguridad de AWS (AWS SRA) y del Arquitectura de referencia de privacidad de AWS (AWS PRA). Leer más sobre diseñar soluciones de privacidad, soberanía por diseñoy cumplimiento en AWS y utilizar servicios como Configuración de AWS, Artefacto de AWSy Gerente de auditoría de AWS para respaldar sus necesidades de privacidad, cumplimiento, auditoría y observabilidad.

Comprenda su postura de seguridad utilizando los marcos de buena arquitectura y adopción de la nube de AWS

AWS ofrece orientación sobre prácticas recomendadas desarrollada a partir de años de experiencia apoyando a los clientes en la arquitectura de sus entornos de nube con la Marco bien diseñado de AWS y en evolucionar para obtener valor empresarial a partir de tecnologías en la nube con la Marco de adopción de la nube de AWS (AWS CAF). Comprenda la postura de seguridad de sus cargas de trabajo de IA, ML e IA generativa realizando una revisión del marco de buena arquitectura. Las revisiones se pueden realizar utilizando herramientas como la Herramienta de buena arquitectura de AWS, o con la ayuda de su equipo de AWS a través de Soporte empresarial de AWS. La herramienta de buena arquitectura de AWS integra automáticamente insights en Asesor de confianza de AWS evaluar qué mejores prácticas existen y qué oportunidades existen para mejorar la funcionalidad y la optimización de costos. La herramienta de buena arquitectura de AWS también ofrece lentes personalizados con mejores prácticas específicas, como la Lente de aprendizaje automático para que pueda medir periódicamente sus arquitecturas con respecto a las mejores prácticas e identificar áreas de mejora. Controle su recorrido hacia la realización de valor y la madurez de la nube al comprender cómo los clientes de AWS adoptan estrategias para desarrollar capacidades organizacionales en el Marco de adopción de la nube de AWS para inteligencia artificial, aprendizaje automático e IA generativa. También puede resultar beneficioso comprender su preparación general para la nube participando en un Evaluación de preparación de la nube de AWS. AWS ofrece oportunidades adicionales de participación: solicite más información a su equipo de cuentas de AWS sobre cómo comenzar con el Centro de innovación de IA generativa.

Acelere su aprendizaje sobre seguridad y AI/ML con orientación, capacitación y certificación de mejores prácticas

AWS también selecciona recomendaciones de Mejores prácticas para seguridad, identidad y cumplimiento y Documentación de seguridad de AWS para ayudarle a identificar formas de proteger sus entornos operativos, de prueba, de desarrollo y de capacitación. Si recién está comenzando, profundice en la capacitación y certificación de seguridad, considere comenzar con Fundamentos de seguridad de AWS y del Plan de aprendizaje de seguridad de AWS. También puedes usar el Modelo de madurez de seguridad de AWS para ayudarle a encontrar y priorizar las mejores actividades en diferentes fases de madurez en AWS, comenzando con resultados rápidos, pasando por etapas fundamentales, eficientes y optimizadas. Una vez que usted y sus equipos tengan un conocimiento básico de la seguridad en AWS, le recomendamos encarecidamente revisar Cómo abordar el modelado de amenazas y luego liderar un ejercicio de modelado de amenazas con sus equipos comenzando con el Taller de modelado de amenazas para constructores programa de entrenamiento. Hay muchos otros Recursos de certificación y capacitación en seguridad de AWS para todos.

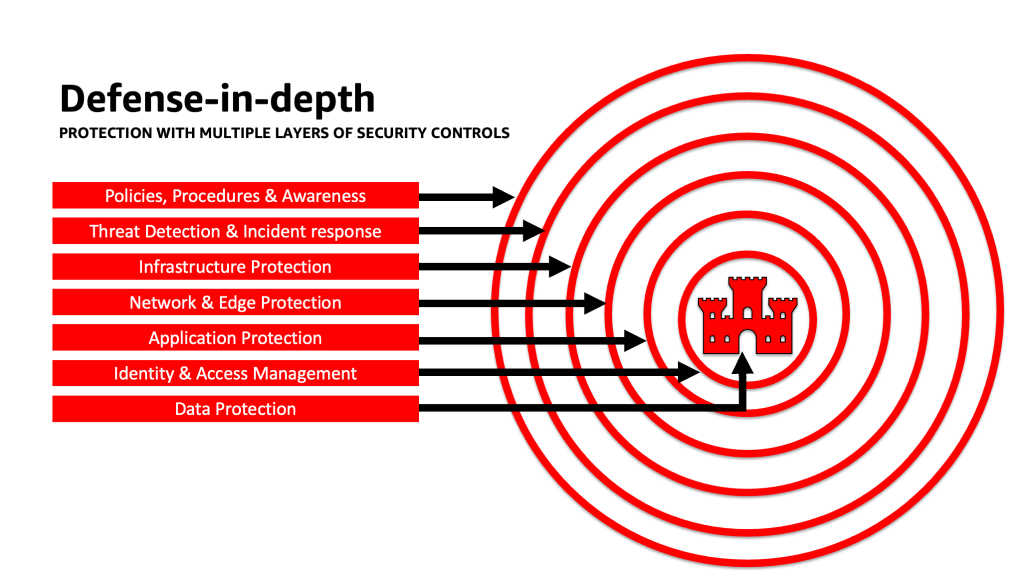

Aplicar un enfoque de defensa en profundidad para proteger las solicitudes de LLM

Aplicar un enfoque de seguridad de defensa en profundidad a sus cargas de trabajo, datos e información de IA generativa puede ayudar a crear las mejores condiciones para lograr sus objetivos comerciales. Las mejores prácticas de seguridad de defensa en profundidad mitigan muchos de los riesgos comunes que enfrenta cualquier carga de trabajo, lo que le ayuda a usted y a sus equipos a acelerar su innovación generativa en IA. Una estrategia de seguridad de defensa en profundidad utiliza múltiples defensas redundantes para proteger sus cuentas, cargas de trabajo, datos y activos de AWS. Ayuda a garantizar que, si algún control de seguridad se ve comprometido o falla, existan capas adicionales para ayudar a aislar las amenazas y prevenir, detectar, responder y recuperarse de eventos de seguridad. Puede utilizar una combinación de estrategias, incluidos servicios y soluciones de AWS, en cada capa para mejorar la seguridad y la resiliencia de sus cargas de trabajo de IA generativa.

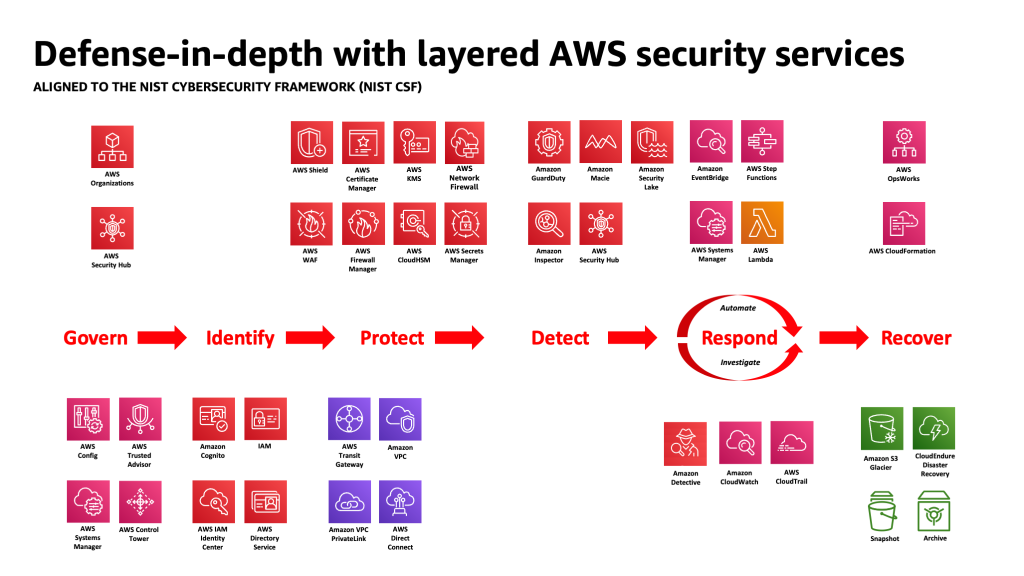

Muchos clientes de AWS se alinean con los marcos estándar de la industria, como el Marco de Ciberseguridad NIST. Este marco ayuda a garantizar que sus defensas de seguridad tengan protección en los pilares de Identificar, Proteger, Detectar, Responder, Recuperar y, más recientemente, Gobernar. Luego, este marco puede asignarse fácilmente a los servicios de seguridad de AWS y a los de terceros integrados para ayudarle a validar la cobertura y las políticas adecuadas para cualquier evento de seguridad que encuentre su organización.

Defensa en profundidad: proteja su entorno y luego agregue capacidades mejoradas de seguridad y privacidad específicas de IA/ML

Una estrategia de defensa en profundidad debe comenzar protegiendo sus cuentas y su organización primero, y luego agregar las características adicionales integradas de seguridad y privacidad mejoradas de servicios como lecho rocoso del amazonas y Amazon SageMaker. Amazon tiene más de 30 servicios en su cartera de seguridad, identidad y cumplimiento que están integrados con los servicios de IA/ML de AWS y se pueden usar juntos para ayudar a proteger sus cargas de trabajo, cuentas y organización. Para defenderse adecuadamente del OWASP Top 10 para LLM, estos deben usarse junto con los servicios de AWS AI/ML.

Comience implementando una política de privilegios mínimos, utilizando servicios como Analizador de acceso de IAM a busque cuentas, roles y recursos demasiado permisivos para restringir el acceso mediante credenciales a corto plazo. A continuación, asegúrese de que todos los datos en reposo estén cifrados con AWS KMS, incluido el uso de CMK, y que todos los datos y modelos estén versionados y respaldados mediante Servicio de almacenamiento simple de Amazon (Amazon S3) control de versiones y aplicación de inmutabilidad a nivel de objeto con Bloqueo de objetos de Amazon S3. Proteja todos los datos en tránsito entre servicios utilizando Administrador de certificados de AWS y/o CA privada de AWSy manténgalo dentro de las VPC usando Enlace privado de AWS. Defina reglas estrictas de entrada y salida de datos para ayudar a proteger contra la manipulación y la exfiltración utilizando VPC con Cortafuegos de red de AWS políticas. Considere insertar Cortafuegos de aplicaciones web de AWS (AWS WAF) delante de proteger aplicaciones web y API en bots maliciosos, Ataques de inyección SQL, scripts entre sitios (XSS), y apropiaciones de cuentas con Control de fraudes. Iniciar sesión con Seguimiento de la nube de AWS, Nube privada virtual de Amazon (Amazon VPC) registros de flujo, y Servicio Amazon Elastic Kubernetes (Amazon EKS) los registros de auditoría ayudarán a proporcionar una revisión forense de cada transacción disponible para servicios como Detective de Amazon. Usted puede utilizar Inspectora de Amazonas para automatizar el descubrimiento y la gestión de vulnerabilidades para Nube informática elástica de Amazon (Amazon EC2) instancias, contenedores, AWS Lambda funciones, y identificar la accesibilidad de la red de sus cargas de trabajo. Proteja sus datos y modelos de actividades sospechosas utilizando Servicio de guardia de AmazonLos modelos de amenazas y fuentes de inteligencia impulsados por ML de ML, y habilitando sus funciones adicionales para EKS Protection, ECS Protection, S3 Protection, RDS Protection, Malware Protection, Lambda Protection y más. Puedes utilizar servicios como Centro de seguridad de AWS para centralizar y automatizar sus controles de seguridad para detectar desviaciones de las mejores prácticas de seguridad y acelerar la investigación y automatizar la corrección de los hallazgos de seguridad con guías. También puedes considerar implementar un cero confianza arquitectura en AWS para aumentar aún más los controles detallados de autenticación y autorización para lo que los usuarios humanos o los procesos de máquina a máquina pueden acceder por solicitud. También considere usar Lago de seguridad de Amazon para centralizar automáticamente los datos de seguridad de los entornos de AWS, los proveedores de SaaS, las instalaciones locales y las fuentes de la nube en un lago de datos especialmente diseñado y almacenado en su cuenta. Con Security Lake, puede obtener una comprensión más completa de sus datos de seguridad en toda su organización.

Una vez que se haya protegido su entorno de carga de trabajo de IA generativa, puede incorporar funciones específicas de IA/ML, como Wrangler de datos de Amazon SageMaker para identificar posibles sesgos durante la preparación de datos y Amazon SageMaker aclarar para detectar sesgos en los datos y modelos de ML. También puedes usar Monitor de modelo de Amazon SageMaker para evaluar la calidad de los modelos de ML de SageMaker en producción y notificarle cuando haya una variación en la calidad de los datos, la calidad del modelo y la atribución de características. Estos servicios de IA/ML de AWS que trabajan juntos (incluido SageMaker que trabaja con Amazon Bedrock) con los servicios de seguridad de AWS pueden ayudarlo a identificar fuentes potenciales de sesgo natural y protegerlo contra la manipulación maliciosa de datos. Repita este proceso para cada una de las 10 principales vulnerabilidades de OWASP para LLM para asegurarse de maximizar el valor de los servicios de AWS para implementar una defensa en profundidad para proteger sus datos y cargas de trabajo.

Como escribió el estratega empresarial de AWS, Clarke Rodgers, en su publicación de blog "CISO Insight: cada servicio de AWS es un servicio de seguridad""Yo diría que prácticamente todos los servicios dentro de la nube de AWS permiten un resultado de seguridad por sí solos o pueden ser utilizados (solos o junto con uno o más servicios) por los clientes para lograr un objetivo de seguridad, riesgo o cumplimiento". Y “los directores de seguridad de la información (CISO) del cliente (o sus respectivos equipos) pueden querer tomarse el tiempo para asegurarse de que conocen bien todos los servicios de AWS porque puede haber un objetivo de seguridad, riesgo o cumplimiento que se pueda cumplir. incluso si un servicio no entra en la categoría 'Seguridad, identidad y cumplimiento'”.

Capas de defensa en límites de confianza en aplicaciones LLM

Al desarrollar sistemas y aplicaciones generativos basados en IA, debe considerar las mismas preocupaciones que con cualquier otra aplicación de ML, como se menciona en el Matriz de amenazas de aprendizaje automático MITRE ATLAS, como tener en cuenta los orígenes de los componentes de datos y software (como realizar una auditoría de software de código abierto, revisar la lista de materiales de software (SBOM) y analizar los flujos de trabajo de datos y las integraciones de API) e implementar las protecciones necesarias contra las amenazas a la cadena de suministro de LLM. Incluya conocimientos de los marcos de la industria y tenga en cuenta las formas de utilizar múltiples fuentes de inteligencia sobre amenazas e información de riesgos para ajustar y ampliar sus defensas de seguridad para tener en cuenta los riesgos de seguridad de IA, ML e IA generativa que son emergentes y no están incluidos en los marcos tradicionales. Busque información complementaria sobre los riesgos específicos de la IA de fuentes industriales, de defensa, gubernamentales, internacionales y académicas, porque surgen y evolucionan nuevas amenazas en este espacio con regularidad y los marcos y guías complementarios se actualizan con frecuencia. Por ejemplo, cuando se utiliza un modelo de generación aumentada de recuperación (RAG), si el modelo no incluye los datos que necesita, puede solicitarlos de una fuente de datos externa para usarlos durante la inferencia y el ajuste. La fuente que consulta puede estar fuera de su control y puede ser una fuente potencial de compromiso en su cadena de suministro. Se debe extender un enfoque de defensa en profundidad hacia fuentes externas para establecer la confianza, autenticación, autorización, acceso, seguridad, privacidad y exactitud de los datos a los que se accede. Para profundizar más, lea “Cree una aplicación empresarial segura con IA generativa y RAG mediante Amazon SageMaker JumpStart"

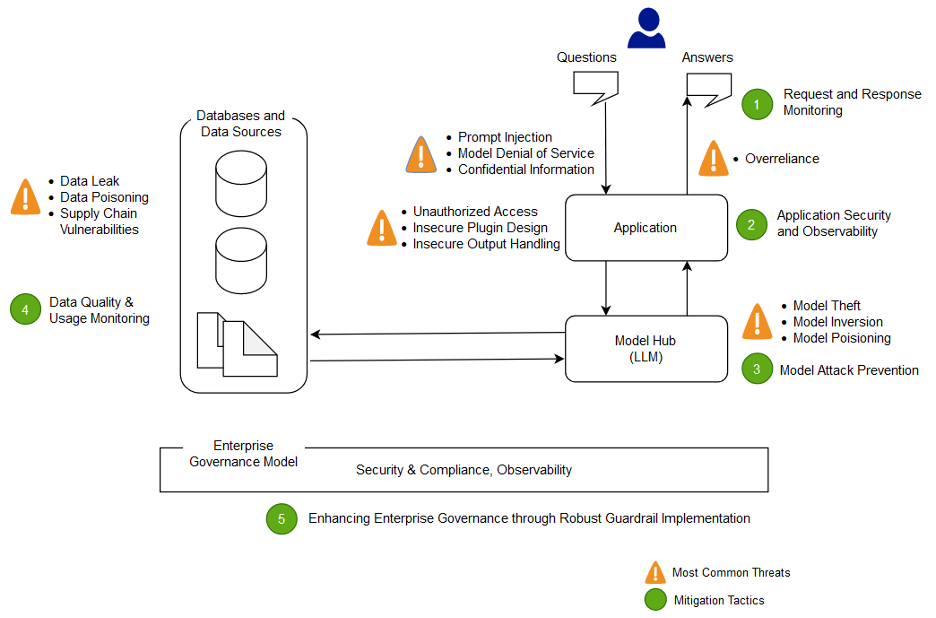

Analice y mitigue el riesgo en sus aplicaciones LLM

En esta sección, analizamos y discutimos algunas técnicas de mitigación de riesgos basadas en límites e interacciones de confianza, o áreas distintas de la carga de trabajo con alcance de controles apropiados y perfil de riesgo similares. En esta arquitectura de muestra de una aplicación de chatbot, hay cinco límites de confianza donde se demuestran los controles, según cómo los clientes de AWS comúnmente crean sus aplicaciones LLM. Su solicitud de LLM puede tener límites de confianza más o menos definibles. En la siguiente arquitectura de ejemplo, estos límites de confianza se definen como:

- Interacciones de la interfaz de usuario (solicitud y respuesta)

- Interacciones de aplicaciones

- Interacciones modelo

- Interacciones de datos

- Interacciones y uso organizacional.

Interacciones de la interfaz de usuario: desarrollar el seguimiento de solicitudes y respuestas

Detectar y responder a incidentes cibernéticos relacionados con la IA generativa de manera oportuna mediante la evaluación de una estrategia para abordar el riesgo de las entradas y salidas de la aplicación de IA generativa. Por ejemplo, es posible que sea necesario instrumentar un monitoreo adicional de comportamientos y salida de datos para detectar la divulgación de información confidencial fuera de su dominio u organización, en el caso de que se utilice en la aplicación LLM.

Las aplicaciones de IA generativa deberían seguir manteniendo las mejores prácticas de seguridad estándar cuando se trata de proteger datos. Establecer un perímetro de datos seguro y almacenes de datos confidenciales seguros. Cifre los datos y la información utilizados para las aplicaciones LLM en reposo y en tránsito. Proteja los datos utilizados para entrenar su modelo contra el envenenamiento de los datos de entrenamiento entendiendo y controlando qué usuarios, procesos y roles pueden contribuir a los almacenes de datos, así como también cómo fluyen los datos en la aplicación, monitoreando las desviaciones de sesgo y usando control de versiones y Almacenamiento inmutable en servicios de almacenamiento como Amazon S3. Establezca controles estrictos de entrada y salida de datos utilizando servicios como AWS Network Firewall y AWS VPC para protegerse contra entradas sospechosas y la posibilidad de filtración de datos.

Durante el proceso de capacitación, reentrenamiento o ajuste, debe tener en cuenta cualquier dato confidencial que se utilice. Después de utilizar los datos durante uno de estos procesos, debe planificar un escenario en el que cualquier usuario de su modelo de repente pueda extraer los datos o la información utilizando técnicas de inyección rápida. Comprenda los riesgos y beneficios de utilizar datos confidenciales en sus modelos e inferencias. Implemente mecanismos sólidos de autenticación y autorización para establecer y administrar permisos de acceso detallados, que no dependen de la lógica de la aplicación LLM para evitar la divulgación. Se ha demostrado que, en algunas condiciones, la entrada controlada por el usuario a una aplicación de IA generativa puede proporcionar un vector para extraer información del modelo o cualquier parte de la entrada no controlada por el usuario. Esto puede ocurrir mediante una inyección rápida, donde el usuario proporciona información que hace que la salida del modelo se desvíe de las barreras de seguridad esperadas de la aplicación LLM, incluido el suministro de pistas sobre los conjuntos de datos en los que se entrenó originalmente el modelo.

Implemente cuotas de acceso a nivel de usuario para los usuarios que proporcionan información y reciben resultados de un modelo. Debe considerar enfoques que no permitan el acceso anónimo en condiciones en las que la información y los datos de entrenamiento del modelo sean confidenciales, o donde exista el riesgo de que un adversario entrene un facsímil de su modelo en función de sus entradas y la salida de su modelo alineado. En general, si parte de la entrada a un modelo consiste en texto arbitrario proporcionado por el usuario, considere que la salida es susceptible de inyección rápida y, en consecuencia, asegúrese de que el uso de las salidas incluya contramedidas técnicas y organizativas implementadas para mitigar el manejo inseguro de la salida, la agencia excesiva y dependencia excesiva. En el ejemplo anterior relacionado con el filtrado de entradas maliciosas mediante AWS WAF, considere crear un filtro delante de su aplicación para ese posible uso indebido de las indicaciones y desarrolle una política sobre cómo manejarlas y evolucionarlas a medida que su modelo y sus datos crecen. Considere también una revisión filtrada del resultado antes de devolverlo al usuario para garantizar que cumpla con los estándares de calidad, precisión o moderación de contenido. Es posible que desee personalizar esto aún más para las necesidades de su organización con una capa adicional de control de entradas y salidas frente a sus modelos para mitigar patrones de tráfico sospechosos.

Interacciones de aplicaciones: seguridad y observabilidad de las aplicaciones

Revise su solicitud de LLM prestando atención a cómo un usuario podría utilizar su modelo para omitir la autorización estándar a una herramienta o cadena de herramientas posterior a la que no tiene autorización para acceder o usar. Otra preocupación en esta capa implica el acceso a almacenes de datos externos mediante el uso de un modelo como mecanismo de ataque que utiliza riesgos LLM técnicos u organizativos absolutos. Por ejemplo, si su modelo está capacitado para acceder a ciertos almacenes de datos que podrían contener datos confidenciales, debe asegurarse de tener verificaciones de autorización adecuadas entre su modelo y los almacenes de datos. Utilice atributos inmutables sobre usuarios que no provengan del modelo al realizar comprobaciones de autorización. El manejo de resultados totalmente inseguro, el diseño de complementos inseguro y la agencia excesiva pueden crear condiciones en las que un actor de amenazas puede usar un modelo para engañar al sistema de autorización para que aumente los privilegios efectivos, lo que lleva a un componente posterior a creer que el usuario está autorizado a recuperar datos o tomar una decisión específica. acción.

Al implementar cualquier complemento o herramienta de IA generativa, es imperativo examinar y comprender el nivel de acceso que se otorga, así como también examinar los controles de acceso que se han configurado. El uso de complementos de IA generativa inseguros y absolutos puede hacer que su sistema sea susceptible a vulnerabilidades y amenazas de la cadena de suministro, lo que podría provocar acciones maliciosas, incluida la ejecución de código remoto.

Interacciones modelo: prevención de ataques modelo

Debe conocer el origen de cualquier modelo, complemento, herramienta o dato que utilice para evaluar y mitigar las vulnerabilidades de la cadena de suministro. Por ejemplo, algunos formatos de modelos comunes permiten incrustar código ejecutable arbitrario en los propios modelos. Utilice duplicaciones de paquetes, escaneos e inspecciones adicionales según sea relevante para los objetivos de seguridad de su organización.

También se deben revisar los conjuntos de datos con los que entrena y ajusta sus modelos. Si ajusta aún más automáticamente un modelo en función de los comentarios de los usuarios (u otra información controlable por el usuario final), debe considerar si un actor de amenazas malintencionado podría cambiar el modelo arbitrariamente basándose en la manipulación de sus respuestas y lograr el envenenamiento de los datos de entrenamiento.

Interacciones de datos: monitorear la calidad y el uso de los datos

Los modelos de IA generativa, como los LLM, generalmente funcionan bien porque han sido entrenados con una gran cantidad de datos. Aunque estos datos ayudan a los LLM a completar tareas complejas, también pueden exponer su sistema al riesgo de envenenamiento de los datos de entrenamiento, lo que ocurre cuando se incluyen u omiten datos inapropiados dentro de un conjunto de datos de entrenamiento que pueden alterar el comportamiento de un modelo. Para mitigar este riesgo, debe observar su cadena de suministro y comprender el proceso de revisión de datos de su sistema antes de usarlo dentro de su modelo. Aunque el proceso de capacitación es una fuente principal de envenenamiento de datos, también debe observar cómo su modelo obtiene los datos, como en un modelo RAG o un lago de datos, y si la fuente de esos datos es confiable y está protegida. Utilice los servicios de seguridad de AWS, como AWS Security Hub, Amazon GuardDuty y Amazon Inspector, para ayudar a monitorear continuamente actividades sospechosas en Amazon EC2, Amazon EKS, Amazon S3. Servicio de base de datos relacional de Amazon (Amazon RDS) y acceso a la red que pueden ser indicadores de amenazas emergentes, y utiliza Detective para visualizar investigaciones de seguridad. Considere también el uso de servicios como Lago de seguridad de Amazon para acelerar las investigaciones de seguridad mediante la creación de un lago de datos diseñado específicamente para centralizar automáticamente los datos de seguridad de entornos de AWS, proveedores de SaaS, fuentes locales y en la nube que contribuyen a sus cargas de trabajo de IA/ML.

Interacciones organizacionales: implementar barreras de gobierno empresarial para la IA generativa

Identifique los riesgos asociados con el uso de IA generativa para sus negocios. Debe crear la taxonomía de riesgos de su organización y realizar evaluaciones de riesgos para tomar decisiones informadas al implementar soluciones de IA generativa. Desarrollar un plan de continuidad del negocio (BCP) que incluye cargas de trabajo de IA, ML e IA generativa y que se pueden implementar rápidamente para reemplazar la funcionalidad perdida de una aplicación LLM afectada o fuera de línea para cumplir con sus SLA.

Identifique brechas, ineficiencias e inconsistencias en procesos y recursos, y mejore el conocimiento y la propiedad en toda su empresa. modelo de amenaza todas las cargas de trabajo generativas de IA para identificar y mitigar posibles amenazas a la seguridad que pueden generar resultados que afecten el negocio, incluido el acceso no autorizado a los datos, la denegación de servicio y el uso indebido de recursos. Aprovecha lo nuevo Herramienta de modelado de AWS Threat Composer para ayudar a reducir el tiempo de obtención de valor al realizar el modelado de amenazas. Más adelante en sus ciclos de desarrollo, considere incluir la introducción ingeniería del caos de seguridad experimentos de inyección de fallas para crear condiciones del mundo real para comprender cómo reaccionará su sistema ante elementos desconocidos y generar confianza en la resiliencia y seguridad del sistema.

Incluir diversas perspectivas en el desarrollo de estrategias de seguridad y mecanismos de gestión de riesgos para garantizar el cumplimiento y la cobertura de AI/ML y la seguridad generativa en todos los roles y funciones laborales. Incorpore una mentalidad de seguridad desde el inicio y la investigación de cualquier aplicación de IA generativa para alinearse con los requisitos. Si necesita asistencia adicional de AWS, solicite a su administrador de cuentas de AWS que se asegure de que haya el mismo soporte solicitando a los arquitectos de soluciones de AWS de AWS Security y AI/ML que le ayuden en conjunto.

Asegúrese de que su organización de seguridad tome medidas de forma rutinaria para fomentar la comunicación en torno a la concienciación y la comprensión de la gestión de riesgos entre las partes interesadas en la IA generativa, como gerentes de productos, desarrolladores de software, científicos de datos y liderazgo ejecutivo, permitiendo que la inteligencia de amenazas y la orientación de controles lleguen a los equipos que puedan verse impactado. Las organizaciones de seguridad pueden respaldar una cultura de divulgación responsable y mejora iterativa participando en debates y aportando nuevas ideas e información a las partes interesadas en la IA generativa que se relacionen con sus objetivos comerciales. Aprender más acerca de nuestro compromiso con la IA responsable y adicional recursos de IA responsables para ayudar a nuestros clientes.

Obtenga ventaja al permitir una mejor postura organizacional para la IA generativa desbloqueando el tiempo para generar valor en los procesos de seguridad existentes de su organización. Evalúe de forma proactiva dónde su organización puede requerir procesos que sean demasiado engorrosos dado el contexto de seguridad generativo de la IA y perfeccionelos para brindar a los desarrolladores y científicos un camino claro para el lanzamiento con los controles correctos implementados.

Evaluar dónde puede haber oportunidades para alinear incentivos, reducir riesgos y proporcionar una línea de visión clara sobre los resultados deseados. Actualice la guía de controles y las defensas para satisfacer las necesidades cambiantes de AI/ML y el desarrollo de aplicaciones de AI generativa para reducir la confusión y la incertidumbre que pueden costar tiempo de desarrollo, aumentar el riesgo y aumentar el impacto.

Asegúrese de que las partes interesadas que no son expertos en seguridad puedan comprender cómo se aplican la gobernanza organizacional, las políticas y los pasos de gestión de riesgos a sus cargas de trabajo, así como aplicar mecanismos de gestión de riesgos. Prepare su organización para responder a eventos y escenarios realistas que puedan ocurrir con aplicaciones de IA generativa, y asegúrese de que los roles de creación de IA generativa y los equipos de respuesta estén al tanto de las rutas y acciones de escalada en caso de preocupación por cualquier actividad sospechosa.

Conclusión

Para comercializar con éxito la innovación con cualquier tecnología nueva y emergente se requiere comenzar con una mentalidad que priorice la seguridad, construir sobre una base de infraestructura segura y pensar en cómo integrar aún más la seguridad en cada nivel de la pila de tecnología desde el principio con una defensa en profundidad. acercarse. Esto incluye interacciones en múltiples capas de su pila tecnológica y puntos de integración dentro de su cadena de suministro digital, para garantizar la resiliencia organizacional. Aunque la IA generativa presenta algunos desafíos nuevos de seguridad y privacidad, si sigue las mejores prácticas de seguridad fundamentales, como el uso de defensa en profundidad con servicios de seguridad en capas, puede ayudar a proteger su organización de muchos problemas comunes y amenazas en evolución. Debe implementar servicios de seguridad de AWS en capas en sus cargas de trabajo de IA generativa y en su organización más amplia, y centrarse en los puntos de integración en sus cadenas de suministro digitales para proteger sus entornos de nube. Luego, puede utilizar las capacidades mejoradas de seguridad y privacidad de los servicios de IA/ML de AWS, como Amazon SageMaker y Amazon Bedrock, para agregar capas adicionales de controles de seguridad y privacidad mejorados a sus aplicaciones de IA generativa. Incorporar la seguridad desde el principio hará que sea más rápido, más fácil y más rentable innovar con IA generativa, al tiempo que simplificará el cumplimiento. Esto le ayudará a aumentar los controles, la confianza y la observabilidad de sus aplicaciones de IA generativa para sus empleados, clientes, socios, reguladores y otras partes interesadas interesadas.

Referencias adicionales

- Marcos estándar de la industria para la seguridad y la gestión de riesgos específicos de IA/ML:

Sobre los autores

cristobal rae es un especialista principal en seguridad de GTM a nivel mundial enfocado en desarrollar y ejecutar iniciativas estratégicas que aceleran y escalan la adopción de los servicios de seguridad de AWS. Le apasiona la intersección de la ciberseguridad y las tecnologías emergentes, y cuenta con más de 20 años de experiencia en roles de liderazgo estratégico global brindando soluciones de seguridad a clientes de medios, entretenimiento y telecomunicaciones. Se recarga leyendo, viajando, comiendo y viniendo, descubriendo nueva música y asesorando a nuevas empresas en sus primeras etapas.

cristobal rae es un especialista principal en seguridad de GTM a nivel mundial enfocado en desarrollar y ejecutar iniciativas estratégicas que aceleran y escalan la adopción de los servicios de seguridad de AWS. Le apasiona la intersección de la ciberseguridad y las tecnologías emergentes, y cuenta con más de 20 años de experiencia en roles de liderazgo estratégico global brindando soluciones de seguridad a clientes de medios, entretenimiento y telecomunicaciones. Se recarga leyendo, viajando, comiendo y viniendo, descubriendo nueva música y asesorando a nuevas empresas en sus primeras etapas.

Elías Invierno es ingeniero de seguridad sénior en seguridad de Amazon, tiene una licenciatura en ingeniería de seguridad cibernética y siente un gran amor por Harry Potter. Elijah se destaca en identificar y abordar vulnerabilidades en sistemas de inteligencia artificial, combinando experiencia técnica con un toque de magia. Elijah diseña protocolos de seguridad personalizados para ecosistemas de IA, aportando un toque mágico a las defensas digitales. Impulsado por la integridad, Elijah tiene experiencia en seguridad en organizaciones del sector público y comercial enfocadas en proteger la confianza.

Elías Invierno es ingeniero de seguridad sénior en seguridad de Amazon, tiene una licenciatura en ingeniería de seguridad cibernética y siente un gran amor por Harry Potter. Elijah se destaca en identificar y abordar vulnerabilidades en sistemas de inteligencia artificial, combinando experiencia técnica con un toque de magia. Elijah diseña protocolos de seguridad personalizados para ecosistemas de IA, aportando un toque mágico a las defensas digitales. Impulsado por la integridad, Elijah tiene experiencia en seguridad en organizaciones del sector público y comercial enfocadas en proteger la confianza.

carnero vital es arquitecto principal de soluciones de aprendizaje automático en AWS. Tiene más de tres décadas de experiencia en la arquitectura y creación de aplicaciones distribuidas, híbridas y en la nube. Le apasiona crear soluciones de IA/ML y big data seguras y escalables para ayudar a los clientes empresariales en su proceso de adopción y optimización de la nube para mejorar sus resultados comerciales. En su tiempo libre, anda en motocicleta y camina con su Sheepadoodle de 3 años.

carnero vital es arquitecto principal de soluciones de aprendizaje automático en AWS. Tiene más de tres décadas de experiencia en la arquitectura y creación de aplicaciones distribuidas, híbridas y en la nube. Le apasiona crear soluciones de IA/ML y big data seguras y escalables para ayudar a los clientes empresariales en su proceso de adopción y optimización de la nube para mejorar sus resultados comerciales. En su tiempo libre, anda en motocicleta y camina con su Sheepadoodle de 3 años.

Navneet Tuteja es especialista en datos en Amazon Web Services. Antes de unirse a AWS, Navneet trabajó como facilitador para organizaciones que buscaban modernizar sus arquitecturas de datos e implementar soluciones integrales de inteligencia artificial y aprendizaje automático. Tiene un título en ingeniería de la Universidad Thapar, así como una maestría en estadística de la Universidad Texas A&M.

Navneet Tuteja es especialista en datos en Amazon Web Services. Antes de unirse a AWS, Navneet trabajó como facilitador para organizaciones que buscaban modernizar sus arquitecturas de datos e implementar soluciones integrales de inteligencia artificial y aprendizaje automático. Tiene un título en ingeniería de la Universidad Thapar, así como una maestría en estadística de la Universidad Texas A&M.

emily soward es un científico de datos con los servicios profesionales de AWS. Tiene una Maestría en Ciencias con distinción en Inteligencia Artificial de la Universidad de Edimburgo en Escocia, Reino Unido, con énfasis en Procesamiento del Lenguaje Natural (PNL). Emily se ha desempeñado en roles de ingeniería y ciencia aplicada centrados en la investigación y el desarrollo de productos habilitados para IA, la excelencia operativa y la gobernanza para las cargas de trabajo de IA que se ejecutan en organizaciones del sector público y privado. Contribuye a la orientación del cliente como oradora sénior de AWS y, recientemente, como autora de AWS Well-Architected in the Machine Learning Lens.

emily soward es un científico de datos con los servicios profesionales de AWS. Tiene una Maestría en Ciencias con distinción en Inteligencia Artificial de la Universidad de Edimburgo en Escocia, Reino Unido, con énfasis en Procesamiento del Lenguaje Natural (PNL). Emily se ha desempeñado en roles de ingeniería y ciencia aplicada centrados en la investigación y el desarrollo de productos habilitados para IA, la excelencia operativa y la gobernanza para las cargas de trabajo de IA que se ejecutan en organizaciones del sector público y privado. Contribuye a la orientación del cliente como oradora sénior de AWS y, recientemente, como autora de AWS Well-Architected in the Machine Learning Lens.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://aws.amazon.com/blogs/machine-learning/architect-defense-in-depth-security-for-generative-ai-applications-using-the-owasp-top-10-for-llms/