El lenguaje y el habla son la forma en que expresamos nuestros pensamientos internos. Pero los neurocientíficos simplemente pasaron por alto la necesidad de un habla audible, al menos en el laboratorio. En cambio, aprovecharon directamente la máquina biológica que genera el lenguaje y las ideas: el cerebro.

Utilizando escáneres cerebrales y una fuerte dosis de aprendizaje automático, un equipo de la Universidad de Texas en Austin desarrolló un "descodificador de lenguaje" que captura la esencia de lo que una persona escucha basándose únicamente en sus patrones de activación cerebral. Lejos de ser un pony de un solo truco, el decodificador también puede traducir el habla imaginada e incluso generar subtítulos descriptivos para películas mudas utilizando la actividad neuronal.

Aquí está el truco: el método no requiere cirugía. En lugar de depender de electrodos implantados, que escuchan las ráfagas eléctricas directamente de las neuronas, la neurotecnología utiliza imágenes de resonancia magnética funcional (fMRI), un procedimiento completamente no invasivo, para generar mapas cerebrales que corresponden al lenguaje.

Para ser claros, la tecnología no es leer la mente. En cada caso, el decodificador produce paráfrasis que capturan la idea general de una oración o párrafo. No reitera cada palabra. Sin embargo, ese es también el poder del decodificador.

“Creemos que el decodificador representa algo más profundo que los idiomas”, dijo el autor principal del estudio, el Dr. Alexander Huth, en una rueda de prensa. “Podemos recuperar la idea general… y ver cómo evoluciona la idea, incluso si se pierden las palabras exactas”.

El estudio, publicado esta semana en Nature Neuroscience, representa un poderoso primer impulso en la no invasiva interfaces cerebro-máquina para decodificar el lenguaje, un problema notoriamente difícil. Con un mayor desarrollo, la tecnología podría ayudar a quienes perdieron la capacidad de hablar a recuperar su capacidad de comunicarse con el mundo exterior.

El trabajo también abre nuevas vías para aprender cómo se codifica el lenguaje en el cerebro y para que los científicos de IA profundicen en la "caja negra" de los modelos de aprendizaje automático que procesan el habla y el lenguaje.

"Tardó mucho en llegar... nos sorprendió un poco que esto funcionara tan bien como lo hace", dijo Huth.

Lenguaje de decodificación

Traducir la actividad cerebral al habla no es nuevo. Un estudio previo utilizó electrodos colocados directamente en el cerebro de pacientes con parálisis. Al escuchar el parloteo eléctrico de las neuronas, el equipo pudo reconstruir palabras completas del paciente.

Huth decidió tomar una ruta alternativa, aunque atrevida. En lugar de depender de la neurocirugía, optó por un enfoque no invasivo: fMRI.

“La expectativa entre los neurocientíficos en general de que se puede hacer este tipo de cosas con fMRI es bastante baja”, dijo Huth.

Hay numerosos motivos. A diferencia de los implantes que aprovechan directamente la actividad neuronal, la fMRI mide cómo cambian los niveles de oxígeno en la sangre. Esto se llama la señal BOLD. Debido a que las regiones cerebrales más activas requieren más oxígeno, las respuestas BOLD actúan como un indicador confiable de la actividad neuronal. Pero viene con problemas. Las señales son lentas en comparación con la medición de ráfagas eléctricas, y las señales pueden ser ruidosas.

Sin embargo, fMRI tiene una gran ventaja en comparación con los implantes cerebrales: puede monitorear todo el cerebro a alta resolución. En comparación con la recopilación de datos de una pepita en una región, proporciona una vista panorámica de las funciones cognitivas de nivel superior, incluido el lenguaje.

Con la decodificación del lenguaje, la mayoría de los estudios previos aprovecharon la corteza motora, un área que controla cómo se mueven la boca y la laringe para generar el habla, o más "nivel superficial" en el procesamiento del lenguaje para la articulación. El equipo de Huth decidió ascender una abstracción: al reino de los pensamientos y las ideas.

Hacia lo desconocido

El equipo se dio cuenta de que necesitaban dos cosas desde el principio. Uno, un conjunto de datos de escaneos cerebrales de alta calidad utilizados para entrenar el decodificador. Dos, un marco de aprendizaje automático para procesar los datos.

Para generar la base de datos del mapa cerebral, se escaneó repetidamente el cerebro de siete voluntarios mientras escuchaban historias de podcasts mientras se medía su actividad neuronal dentro de una máquina de resonancia magnética. Acostarse dentro de un imán gigante y ruidoso no es divertido para nadie, y el equipo se encargó de mantener a los voluntarios interesados y alertas, ya que la atención influye en la decodificación.

Para cada persona, el conjunto de datos masivo resultante se introdujo en un marco impulsado por el aprendizaje automático. Gracias a la reciente explosión de modelos de aprendizaje automático que ayudan a procesar el lenguaje natural, el equipo pudo aprovechar esos recursos y construir fácilmente el decodificador.

Tiene múltiples componentes. El primero es un modelo de codificación que utiliza el GPT original, el predecesor del enormemente popular ChatGPT. El modelo toma cada palabra y predice cómo responderá el cerebro. Aquí, el equipo afinó GPT utilizando más de 200 millones de palabras en total de los comentarios y podcasts de Reddit.

Esta segunda parte utiliza una técnica popular en aprendizaje automático llamada decodificación bayesiana. El algoritmo adivina la siguiente palabra basándose en una secuencia anterior y usa la palabra adivinada para verificar la respuesta real del cerebro.

Por ejemplo, un episodio de podcast tenía "mi papá no lo necesita..." como historia. Cuando se introdujo en el decodificador como un aviso, vino con posibles respuestas: "mucho", "bien", "desde", etc. La comparación de la actividad cerebral predicha con cada palabra con la generada a partir de la palabra real ayudó al decodificador a perfeccionar los patrones de actividad cerebral de cada persona y corregir los errores.

Después de repetir el proceso con las mejores palabras predichas, el aspecto de decodificación del programa

eventualmente aprendió la "huella digital neuronal" única de cada persona sobre cómo procesan el lenguaje.

Un neurotraductor

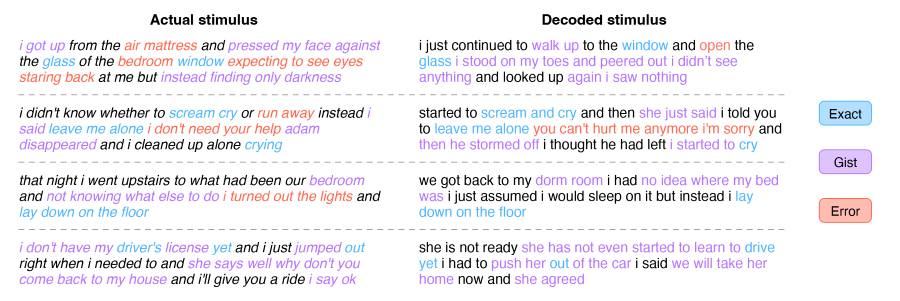

Como prueba de concepto, el equipo comparó las respuestas decodificadas con el texto real de la historia.

Estuvo sorprendentemente cerca, pero solo por la esencia general. Por ejemplo, una línea de la historia, "comenzamos a intercambiar historias sobre nuestras vidas, ambos somos del norte", se decodificó como "comenzamos a hablar sobre nuestras experiencias en el área en la que nació, yo era del norte".

Se esperaba esta paráfrasis, explicó Huth. Debido a que la fMRI es bastante ruidosa y lenta, es casi imposible capturar y decodificar cada palabra. El decodificador se alimenta de una mezcolanza de palabras y necesita desentrañar sus significados usando funciones como giros de frase.

Por el contrario, las ideas son más permanentes y cambian con relativa lentitud. Debido a que fMRI tiene un retraso al medir la actividad neuronal, captura conceptos y pensamientos abstractos mejor que palabras específicas.

Este enfoque de alto nivel tiene ventajas. Si bien carece de fidelidad, el decodificador captura un nivel más alto de representación del lenguaje que los intentos anteriores, incluso para tareas que no se limitan solo al habla. En una prueba, los voluntarios vieron un clip animado de una niña atacada por dragones sin ningún sonido. Usando solo la actividad cerebral, el decodificador describió la escena desde la perspectiva del protagonista como una historia basada en texto. En otras palabras, el decodificador pudo traducir la información visual directamente a una narrativa basada en una representación del lenguaje codificado en la actividad cerebral.

De manera similar, el decodificador también reconstruyó historias imaginarias de un minuto de duración de los voluntarios.

Después de más de una década trabajando en la tecnología, "fue impactante y emocionante cuando finalmente funcionó", dijo Huth.

Aunque el decodificador no lee exactamente la mente, el equipo tuvo cuidado de evaluar la privacidad mental. En una serie de pruebas, encontraron que el decodificador solo funcionaba con la participación mental activa de los voluntarios. Pedir a los participantes que contaran en orden de siete, nombraran diferentes animales o construyeran mentalmente sus propias historias degradó rápidamente el decodificador, dijo el primer autor Jerry Tang. En otras palabras, se puede “resistir conscientemente” al decodificador.

Por ahora, la tecnología solo funciona después de meses de escaneos cerebrales cuidadosos en una máquina que tararea ruidosamente mientras está completamente inmóvil, lo que es difícilmente factible para uso clínico. El equipo está trabajando para traducir la tecnología a fNIRS (espectroscopía de infrarrojo cercano funcional), que mide los niveles de oxígeno en sangre en el cerebro. Aunque tiene una resolución más baja que la fMRI, fNIRS es mucho más portátil ya que el hardware principal es un dispositivo similar a un gorro de natación que cabe fácilmente debajo de una sudadera con capucha.

“Con ajustes, deberíamos poder traducir la configuración actual a la venta completa de fNIRS”, dijo Huth.

El equipo también planea usar modelos de lenguaje más nuevos para aumentar la precisión del decodificador y, potencialmente, unir diferentes idiomas. Debido a que los idiomas tienen una representación neuronal compartida en el cerebro, el decodificador podría, en teoría, codificar un idioma y usar las señales neuronales para decodificarlo en otro.

Es una "dirección futura emocionante", dijo Huth.

Crédito de la imagen: Jerry Tang/Martha Morales/Universidad de Texas en Austin

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoAiStream. Inteligencia de datos Web3. Conocimiento amplificado. Accede Aquí.

- Acuñando el futuro con Adryenn Ashley. Accede Aquí.

- Fuente: https://singularityhub.com/2023/05/02/this-brain-activity-decoder-translates-ideas-into-text-using-only-scans/