Además, una consideración crucial es cómo estas tecnologías de IA pueden adaptarse y revolucionar los ecosistemas existentes dentro de infraestructuras de alto valor y alta demanda, como aeropuertos, aviones y diversos sistemas de movilidad avanzados.

Utilizando tecnologías innovadoras de IA y aprovechando las ventajas de la plataforma de la Universidad de Cranfield, el Curso de Maestría en Inteligencia Artificial Aplicada tiene como objetivo cultivar futuros líderes en IA aplicada en diversos dominios de ingeniería. Su objetivo principal es acelerar el desarrollo y la implementación de tecnologías de IA confiables para aplicaciones críticas para la seguridad en todo el mundo.

El proyecto de diseño grupal (GDP) es un módulo de aprendizaje basado en problemas, y el objetivo del GDP es que los estudiantes diseñen, implementen, validen y prueben sistemas basados en IA en tiempo real para resolver problemas del mundo real. El GDP también tiene como objetivo proporcionar a los estudiantes la experiencia de trabajar en un proyecto de ingeniería colaborativo, satisfaciendo los requisitos de un cliente potencial y respetando los plazos.

En 2022 y 2023, a los estudiantes matriculados en nuestro Máster en Inteligencia Artificial Aplicada se les asignó un proyecto de diseño grupal estimulante y exigente. El objetivo era aprovechar el conocimiento aplicado de la IA adquirido en sus cursos para desarrollar productos aeroportuarios innovadores y más seguros. Trabajando en pequeños equipos de seis personas, a los estudiantes se les asignó la tarea de diseñar soluciones que abarcaran la arquitectura de software y hardware, el desarrollo y las pruebas de modelos de IA, así como aspectos de participación en el mundo real.

El tema del proyecto fue intencionalmente amplio y requirió que los estudiantes colaboraran dentro de sus grupos para explorar y perfeccionar áreas de interés específicas en función de su experiencia e intereses colectivos. Este enfoque fomentó la creatividad, el trabajo en equipo y una comprensión más profunda de la aplicación práctica de las tecnologías de IA en escenarios del mundo real.

Se pidió a cada grupo que desarrollara soluciones de inteligencia artificial en tiempo real para aeropuertos inteligentes para lograr las siguientes funcionalidades:

- El sistema será capaz de detectar usuarios humanos y estimar sus poses y comportamientos basándose en una detección y seguimiento precisos de las poses.

- El sistema deberá poder clasificar diferentes comportamientos de la multitud y aclarar las razones, la importancia y la viabilidad.

- El modelo de IA debe validarse de forma cruzada con diferentes métricas de precisión, computación e inferencia.

- El modelo de IA debería poder implementarse en tiempo real para informar las ventajas y desventajas de las tecnologías de IA actuales en estas aplicaciones críticas para la seguridad.

- El sistema puede depender de diferentes fuentes de sensores como entrada para permitir la fusión de sensores y lograr un rendimiento sólido; sin embargo, también se aceptan soluciones eficientes pero de muy bajo costo.

Estudio de caso 1: Detección de caídas en un entorno de mantenimiento de aeronaves.

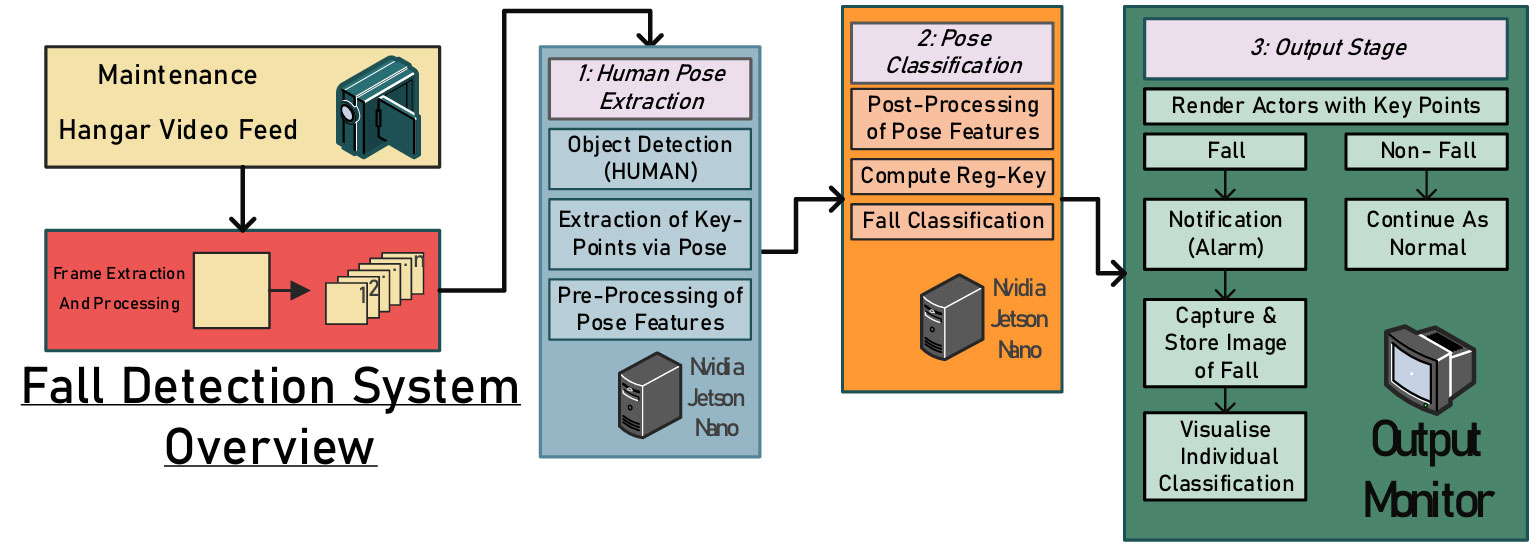

Los entornos de mantenimiento plantean peligros importantes, que incluyen maquinaria desatendida, cercas o guardias físicas inadecuadas cerca de áreas peligrosas y espacios de trabajo desordenados. Entre estos riesgos, las lesiones mortales por caídas son alarmantemente comunes. Detectar y reportar incidentes no fatales con prontitud podría evitar más daños o muertes. Por lo tanto, este trabajo propone un sistema integrado basado en visión para monitorear a los empleados durante las actividades de mantenimiento de aeronaves, mejorando la seguridad y previniendo accidentes (ver la figura a continuación).

.fusion-gallery-1 .fusion-gallery-image {borde:0px sólido #e2e2e2;}

A partir de los resultados iniciales de entrenamiento y validación del modelo diseñado, la aparente ausencia de un conjunto de datos de mantenimiento de hangares de aeropuerto listo para usar presenta una posibilidad de un sesgo hacia las imágenes de videos capturados desde ángulos de cámara perpendiculares tomados desde la proximidad al sujeto. Aprovechando las ventajas de Cranfield, se eligió y utilizó el hangar de mantenimiento de la Universidad de Cranfield para la recopilación de datos en este proyecto.

En total, se grabaron unos 50 vídeos cortos (de dos a cinco minutos) de actividades de mantenimiento simuladas, algunos con caídas y otros sin ellas. Los vídeos capturados se dividieron en fotogramas y se anotaron utilizando la biblioteca de software de estimación de postura MoveNet y se generaron mapas vectoriales de las posiciones articulares clave del sujeto. La siguiente figura muestra algunas instantáneas de los datos experimentales.

.fusion-gallery-2 .fusion-gallery-image {borde:0px sólido #e2e2e2;}

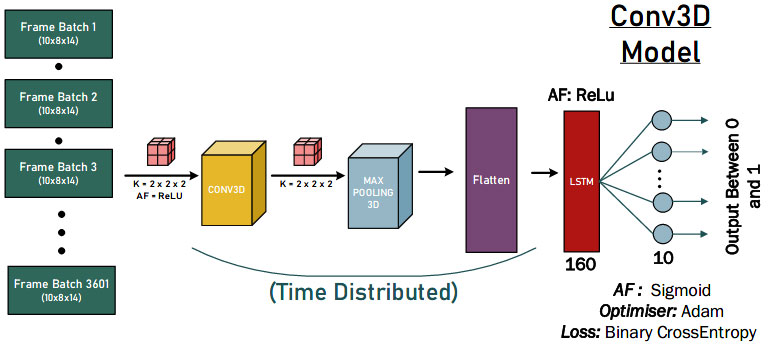

Nuestros estudiantes probaron los enfoques de redes neuronales convolucionales 1-D, 2-D y 3-D para evaluar cuantitativamente el diseño del modelo de IA más potente. La siguiente figura es una demostración de las soluciones de convolución 3-D.

.fusion-gallery-3 .fusion-gallery-image {borde:0px sólido #e2e2e2;}

Finalmente, las soluciones de IA propuestas lograron buenos resultados de detección del comportamiento de caída, como se muestra en la siguiente figura. Se pueden sacar algunas conclusiones. Primero, el modelo tenía 0 clasificaciones de FP, lo que sugiere que el modelo no clasifica erróneamente una caída. En segundo lugar, hay 940 verdaderos negativos para cada modelo, lo que probablemente podría deberse a que los datos de cada prueba contienen una parte de no caídas (clasificadas como 0) antes de que el actor se caiga.

.fusion-gallery-4 .fusion-gallery-image {borde:0px sólido #e2e2e2;}

Estudio de caso 2: Detección de signos vitales de infarto de miocardio mediante visión por computadora e IA de vanguardia

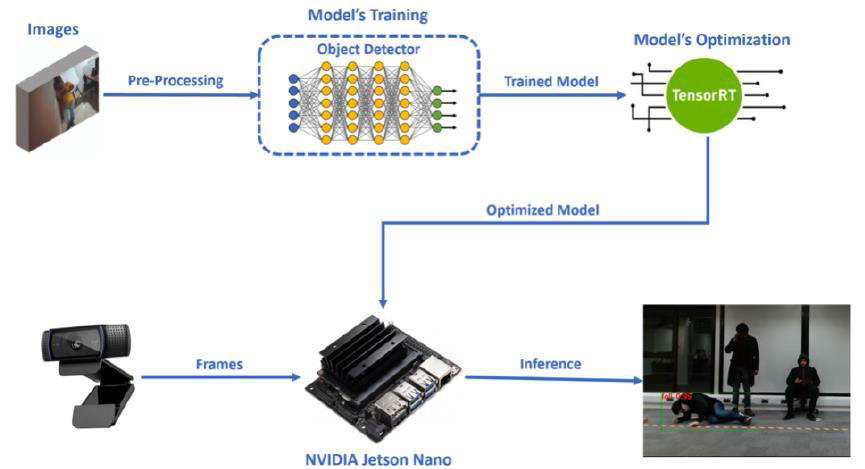

Edge AI se refiere a la implementación de aplicaciones de inteligencia artificial en dispositivos ubicados en el entorno físico. La asequibilidad y la facilidad de uso son factores clave en la adopción de algoritmos de IA en situaciones en las que los usuarios finales enfrentan desafíos del mundo real. En este proyecto, nuestro estudiante propuso un modelo de detección de ataques cardíacos liviano y de bajo costo para una respuesta y rescate rápidos en el aeropuerto. El proceso se compone de cuatro etapas principales, como se muestra en la siguiente figura.

.fusion-gallery-5 .fusion-gallery-image {borde:0px sólido #e2e2e2;}

La primera etapa constituye la selección y preparación adecuada de un conjunto de datos de imágenes, junto con las anotaciones necesarias para los cuadros delimitadores de las clases (dolor de pecho, caída).

Además, como segunda etapa viene el entrenamiento de nuestro modelo de detector de objetos mediante aprendizaje por transferencia. La etapa específica se realizó en Google Colab, utilizando PyTorch. Posteriormente, una vez completada la etapa de capacitación, el modelo se insertó en Jetson Nano de NVIDIA, que fue nuestro dispositivo integrado elegido para usar en nuestra aplicación de visión por computadora Edge AI.

La tercera etapa del diseño de nuestro sistema fue la conversión y optimización apropiada del modelo, para que funcione de manera más eficiente en Jetson Nano. La optimización de nuestro modelo se realizó utilizando el motor de inferencia TensorRT de NVIDIA y el proceso específico se ejecutó en Jetson Nano (como se muestra en la siguiente figura).

.fusion-gallery-6 .fusion-gallery-image {borde:0px sólido #e2e2e2;}

El último paso es la ejecución del modelo optimizado en Jetson Nano, utilizando como entradas los fotogramas que recibe de una cámara web, para realizar el proceso de detección de objetos en tiempo real y detectar nuestras clases (dolor de pecho, caída). Junto con este proceso, en el código de inferencia que se ejecuta en Jetson Nano, había dos escenarios específicos. Los resultados finales de la inferencia se muestran en la siguiente figura.

.fusion-gallery-7 .fusion-gallery-image {borde:0px sólido #e2e2e2;}

Estudio de caso 3: Monitoreo de multitudes y análisis de distanciamiento social

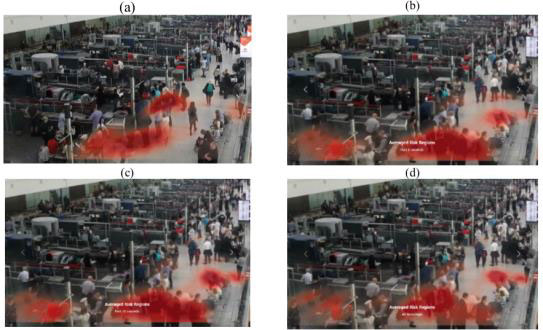

Los aeropuertos tienen enormes afluencias de pasajeros todos los días y, al igual que otros lugares y organizaciones concurridos, deben garantizar la seguridad pública y garantizar que se implementen medidas adecuadas para mitigar los riesgos durante las pandemias. En este proyecto, nuestros estudiantes propusieron un sistema integrado basado en visión por computadora que proporciona monitoreo y análisis de multitudes multifuncional en todos los aeropuertos. Los resultados del sistema están destinados a beneficiar tanto al personal de gestión del aeropuerto como a los pasajeros, proporcionando análisis e inteligencia basados en la multitud.

El sistema consta de una plataforma integrada (consulte la figura siguiente) para analizar y monitorear multitudes en lugares públicos mediante transmisiones de videovigilancia. La atención se centra específicamente en los aeropuertos inteligentes, pero el marco básico es adaptable a cualquier contexto público donde sea útil analizar y monitorear las características de la multitud.

.fusion-gallery-8 .fusion-gallery-image {borde:0px sólido #e2e2e2;}

Los modelos posteriores del sistema utilizan las características de pose extraídas de una escena para realizar tareas únicas. Esto incluye el recuento de personas, la estimación de la distancia interpersonal, la detección de objetos con máscara, la clasificación del estado (sentado, de pie, caminando, acostado, etc.) y la agrupación social. Luego, los resultados se combinan para formar el panel integrado y el sistema de monitoreo. Con excepción del uso común de características de pose, estas tareas representan desafíos únicos con diferentes enfoques de modelado. Afortunadamente, gracias al diseño del sistema modular, fue posible abstraer cada tarea y hacer que diferentes miembros del equipo la desarrollaran.

.fusion-gallery-9 .fusion-gallery-image {borde:0px sólido #e2e2e2;}

Por último, se diseña una interfaz interactiva para integrar todas las salidas posteriores en una única ventana gráfica (consulte la figura siguiente). La aplicación carga archivos de datos creados por los modelos posteriores al tablero en tiempo real para que se pueda realizar un análisis del estado actual de la escena. En cualquier momento, se puede ver el metraje original de la escena, junto con las poses extraídas de cada persona en un reproductor de vídeo adyacente. Quien toma las decisiones puede cambiar entre una vista de diagrama de caja y una vista de mapa de calor y, posteriormente, cambiar en qué metraje se reciben los datos desde dos menús desplegables. Las estadísticas sobre la escena se muestran en el extremo derecho de la ventana gráfica. Estas estadísticas son el estado total de la máscara de la persona, el perfil de riesgo total, el estado total de la postura de las personas, el recuento total de personas, las proporciones de distanciamiento social y el diagrama de caja de proporciones.

.fusion-gallery-10 .fusion-gallery-image {borde:0px sólido #e2e2e2;}

Estudio de caso 4: Detección de violencia en el aeropuerto

Por último, uno de nuestros grupos tiene como objetivo desarrollar un marco de detección de violencia que estime las poses humanas y clasifique el comportamiento violento en imágenes de vigilancia (como se muestra en la siguiente figura). En lugar de extraer directamente características de fotogramas de vídeo, este marco utiliza ViTPose para detectar poses humanas en cada fotograma, luego preprocesa y extrae características de la información de los puntos clave.

.fusion-gallery-11 .fusion-gallery-image {borde:0px sólido #e2e2e2;}

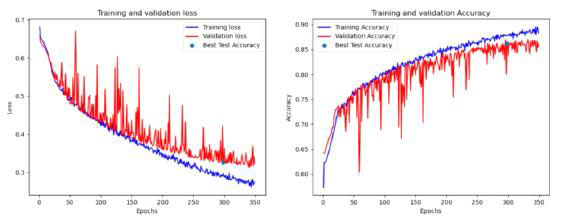

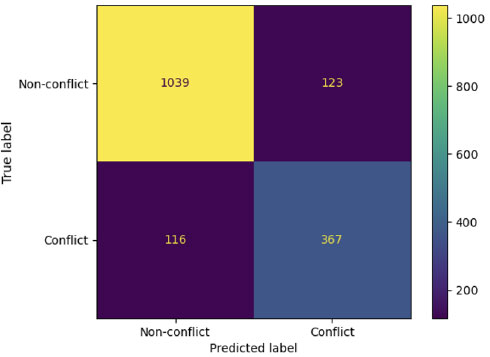

Tras un análisis exhaustivo de varios modelos utilizando múltiples conjuntos de datos (secuencias basadas en ángulos, basadas en distancias, de 1 segundo y 2 segundos) con un total de 162 combinaciones de hiperparámetros, el equipo finalmente identificó varios modelos prometedores que cumplen con criterios de evaluación específicos. Se puede concluir que los modelos pueden extraer información valiosa sobre el comportamiento violento utilizando características de distancia de puntos clave del cuerpo, como se muestra en la siguiente figura.

.fusion-gallery-12 .fusion-gallery-image {borde:0px sólido #e2e2e2;}

Por último, al colaborar con Saab UK, nuestros estudiantes pueden desarrollar e integrar sus modelos de IA con la plataforma de nivel industrial (SAFE), una poderosa plataforma de conocimiento de la situación ampliamente utilizada en muchas comisarías de policía del Reino Unido para vigilancia. La puerta de enlace KAFKA se aplica siguiendo el motor de IA y se reenvía al terminal del cliente para su visualización y alertas. Si se detecta violencia en el video interceptado con cuadros delimitadores, activará la alarma que configuramos específicamente para nuestro modelo mostrando el video interceptado en el diseño del cliente SAFE y nos dará el mensaje de alerta con detalles. Al final, nuestros estudiantes implementaron con éxito el modelo de IA de nuestro centro DARTeC y se comunicaron con el sistema Saab SAFE para aumentar la conciencia de la situación humana.

.fusion-gallery-13 .fusion-gallery-image {borde:0px sólido #e2e2e2;}

Creando los ingenieros de IA aplicada del futuro

Estas son sólo algunas muestras seleccionadas de interesantes proyectos de PIB del curso MSc AAI. Recientemente, nuestros estudiantes actuales han emprendido proyectos de PIB más desafiantes en interfaz explicable con IA, razonamiento causal para la planificación del movimiento autónomo, IA basada en la física para vehículos autónomos y gestión futura del espacio aéreo. Creemos que nuestros estudiantes de maestría pronto realizarán investigaciones más interesantes.

Consulte las siguientes publicaciones de investigación de nuestros estudiantes durante el PIB para ver lo interesantes que parecen las soluciones y los resultados finales:

- Osigbesan, Adeyemi, Solene Barrat, Harkeerat Singh, Dongzi Xia, Siddharth Singh, Yang Xing, Weisi Guo y Antonios Tsourdos. "Detección de caídas basada en la visión en entornos de mantenimiento de aeronaves con estimación de postura". En la Conferencia internacional IEEE de 2022 sobre fusión e integración de multisensores para sistemas inteligentes (MFI), págs. IEEE, 1.

- Fraser, Benjamin, Brendan Copp, Gurpreet Singh, Orhan Keyvan, Tongfei Bian, Valentin Sonntag, Yang Xing, Weisi Guo y Antonios Tsourdos. "Reducción de la transmisión viral mediante monitoreo de multitudes y análisis de distanciamiento social basados en inteligencia artificial". En la Conferencia internacional IEEE de 2022 sobre fusión e integración de multisensores para sistemas inteligentes (MFI), págs. IEEE, 1.

- Üstek, İ., Desai, J., Torrecillas, IL, Abadou, S., Wang, J., Fever, Q., Kasthuri, SR, Xing, Y., Guo, W. y Tsourdos, A., 2023, Agosto. Detección de violencia en dos etapas mediante ViTPose y modelos de clasificación en aeropuertos inteligentes. En 2023 IEEE Smart World Congress (SWC) (págs. 797-802). IEEE.

- Benoit, Paul, Marc Bresson, Yang Xing, Weisi Guo y Antonios Tsourdos. "Detección de acciones violentas basada en visión en tiempo real a través de cámaras CCTV con estimación de pose". En 2023 IEEE Smart World Congress (SWC), págs. 844-849. IEEE, 2023.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://blogs.cranfield.ac.uk/aerospace/exploring-safer-and-smarter-airports-with-the-applied-artificial-intelligence-msc-group-design-project/