En una carrera frenética contra una bomba de tiempo de carbono que se avecina, los gigantes tecnológicos están lidiando con las ramificaciones ambientales de sus centros de datos en expansión en todo el mundo. Estos centros de datos, esenciales para impulsar la infraestructura digital actual, se han convertido en ávidos consumidores de energía, particularmente a medida que la demanda de inteligencia artificial (IA) continúa disparándose.

A medida que la IA se vuelve cada vez más integral para diversas industrias, las demandas de energía de los centros de datos se están disparando. Esto, a su vez, exige medidas urgentes para mitigar su enorme huella ambiental.

El apetito energético de la IA: desencadenando las emisiones de los centros de datos

Entre 2010 y 2018, se estima que hubo Aumento del 550% a nivel mundial en el número de cargas de trabajo de centros de datos e instancias informáticas.

Los centros de datos y las redes de transmisión contribuyen colectivamente hasta 1.5% del consumo mundial de energía. Emiten un volumen de dióxido de carbono comparable a la producción anual de Brasil.

A los hiperescaladores les gusta Google, Microsofty Amazon se han comprometido con objetivos climáticos ambiciosos, con el objetivo de descarbonizar sus operaciones. Los hiperescaladores son instalaciones eficientes, altamente optimizadas y a gran escala.

Sin embargo, la proliferación de la IA plantea un enorme desafío para estos objetivos. La naturaleza intensiva en energía de las unidades de procesamiento de gráficos (GPU), esenciales para el entrenamiento de modelos de IA, magnifica la presión sobre los recursos energéticos.

Según la Agencia Internacional de Energía (IEA), entrenar un único modelo de IA consume más energía que 100 hogares en un año.

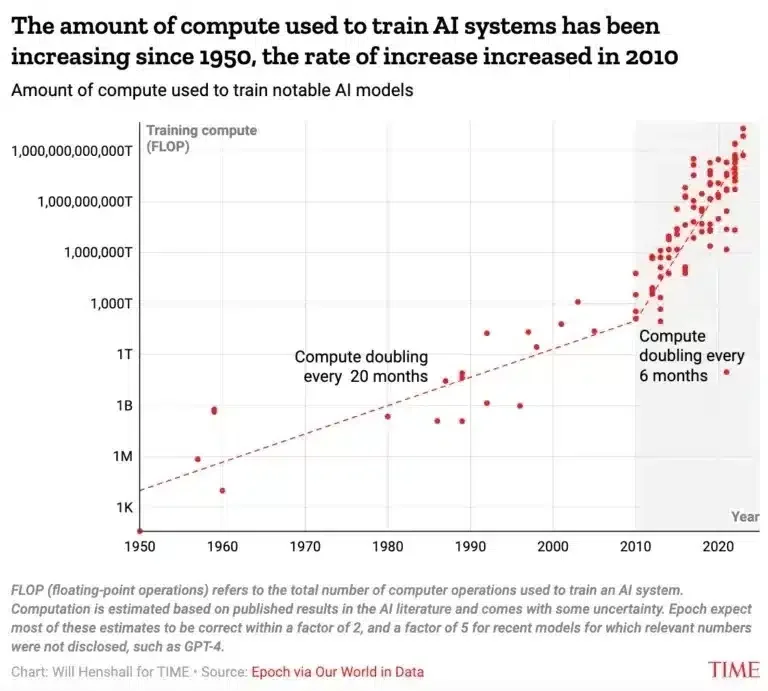

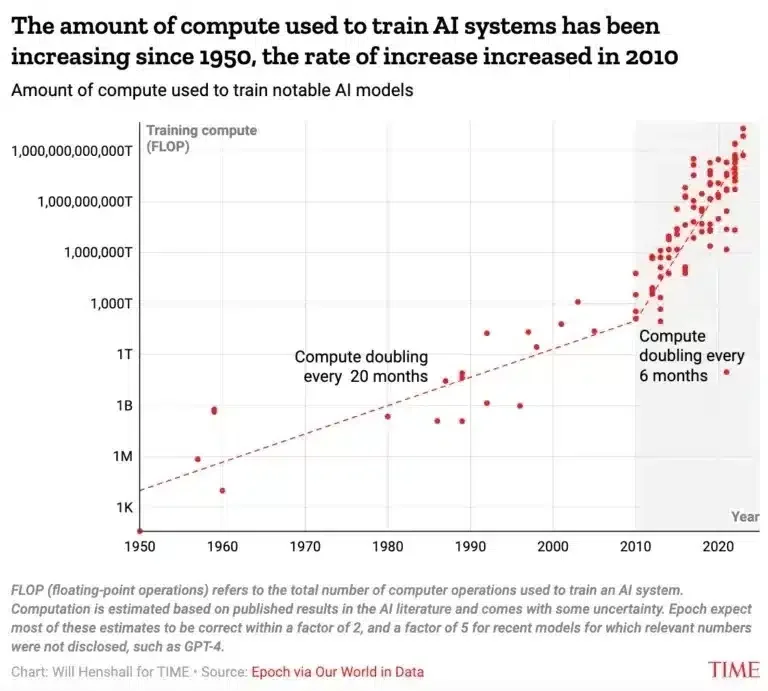

Según otra fuente, la cantidad de potencia informática necesaria para el entrenamiento en IA se duplica cada 6 meses. Hace cincuenta años, eso ocurría cada 20 meses, como se ve en el gráfico siguiente.

Lo más alarmante es que en poco más de una década, la potencia informática utilizada para el desarrollo de modelos de IA ha aumentado en un factor asombroso de 10 mil millones. Y no disminuiría la velocidad.

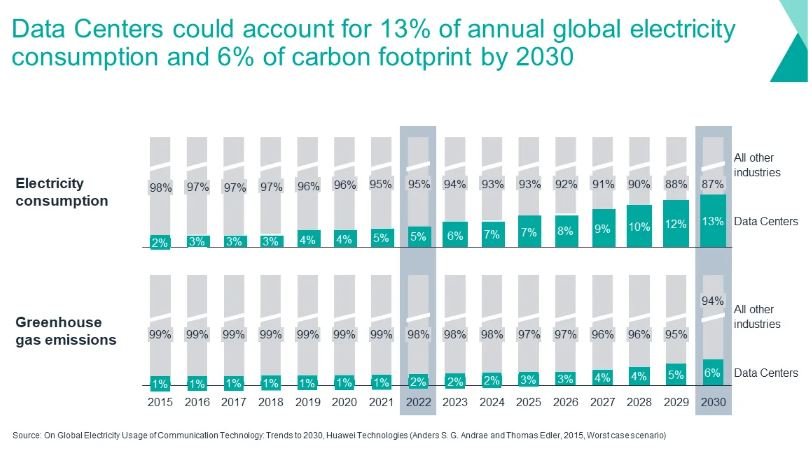

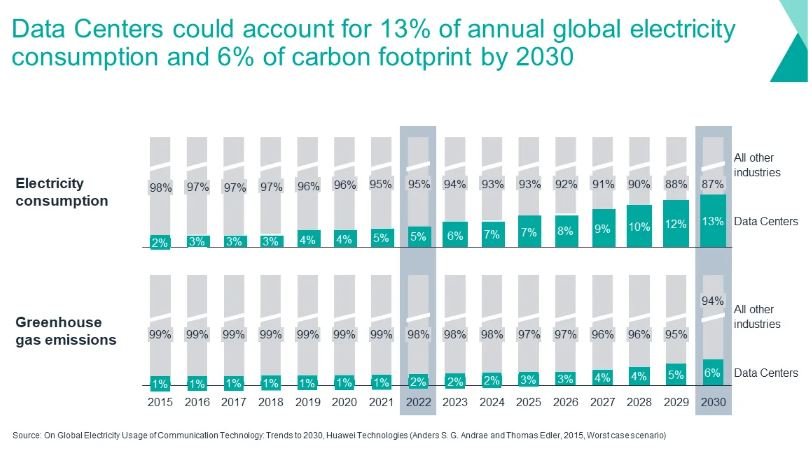

Las estimaciones de la industria pronostican que el uso de energía puede aumentar hasta 13% para 2030, mientras que la proporción de las emisiones globales de carbono sería 6% para el mismo año.

El costo de la IA: equilibrio entre poder y progreso

Los riesgos climáticos que plantea la informática impulsada por la IA son profundos, con Nvidia El director ejecutivo, Jensen Huang, destaca los importantes requisitos energéticos de la IA. Jensen proyectó una duplicación de los costos del centro de datos dentro de cinco años para adaptarse al ecosistema de IA en expansión.

Por ejemplo, los costos de computación para entrenar modelos de IA avanzados como GPT-3, que cuentan con 175B de parámetros, y potencialmente GPT-4 son, como era de esperar, sustanciales. Se estima que el entrenamiento final del GPT-3 osciló entre 500,000 y 4.6 millones de dólares.

El entrenamiento del GPT-4 podría haber generado costos cercanos a los 50 millones de dólares. Sin embargo, al tener en cuenta el cálculo necesario para la prueba y el error antes de la ejecución final del entrenamiento, el El coste total de la formación probablemente supere los 100 millones de dólares..

En promedio, los modelos de IA a gran escala consumen aproximadamente 100x más recursos informáticos que otros modelos de IA contemporáneos. Si la tendencia de aumentar el tamaño de los modelos continúa al ritmo actual, algunas estimaciones proyectan que los costos de computación superarán todo el PIB de los Estados Unidos para 2037.

Según la informática Kate Saenko, el desarrollo de GPT-3 emitió más de 550 toneladas de CO2 y consumido 1,287 MW horas de electricidad. En otras palabras, estas emisiones equivalen a las generadas por un solo individuo tomando 550 vuelos de ida y vuelta entre Nueva York y San Francisco.

Sin mencionar que dichas cifras representan las emisiones directamente asociadas con el desarrollo o la preparación de la IA para su uso. No se incluyen otras fuentes de emisiones.

Soluciones para reducir la huella de carbono de los centros de datos

Para mitigar las emisiones de los centros de datos, los actores de la industria han seguido varias estrategias, incluida la inversión en energía renovable y utilizando créditos de carbon.

Si bien estas iniciativas han producido algunos avances, la creciente adopción de la IA requiere medidas adicionales para lograr reducciones significativas de las emisiones.

La estrategia de cambio de carga de Google ejemplifica un enfoque prometedor para abordar este desafío. Sincroniza las operaciones del centro de datos con la disponibilidad de energía renovable cada hora.

Al implementar sofisticados algoritmos de software, Google identifica regiones con excedentes de energía solar y eólica en la red y aumenta estratégicamente las operaciones de los centros de datos en estas áreas.

- La lógica detrás de este enfoque es simple: reducir las emisiones modificando la forma en que funcionan los centros de datos.

El gigante tecnológico también ha iniciado la primera iniciativa para alinear el consumo de energía de ciertos centros de datos con fuentes de carbono cero cada hora. El objetivo es alimentar las máquinas con energía limpia las 24 horas del día, los 7 días de la semana.

Los centros de datos de Google funcionan con energía libre de carbono aproximadamente el 64% del tiempo, con 13 sitios regionales logrando una dependencia del 85% de dichas fuentes y siete sitios a nivel mundial superando la marca del 90%, según Michael Terrell, quien encabeza el programa 24/7 de Google. Estrategia energética libre de carbono.

Cirrus Nexus monitorea activamente las redes eléctricas globales para identificar regiones con abundante energía renovable. Luego asignan estratégicamente cargas informáticas para minimizar las emisiones de carbono. Al aprovechar las fuentes de energía renovables y optimizar las operaciones del centro de datos, se lograron reducciones significativas en las emisiones de carbono.

La empresa pudo reducir las emisiones informáticas para algunas cargas de trabajo y los clientes en un 34 %. Utiliza servicios en la nube ofrecidos por Amazon, Microsoft y Google.

Navegando por la crisis energética impulsada por la IA

En los últimos años, tanto Google como Amazon han experimentado ajustando los patrones de uso de los centros de datos. Lo hacen tanto para sus operaciones internas como para los clientes que utilizan sus servicios en la nube.

Nvidia ofrece otra solución a esta crisis energética impulsada por la IA: la tecnología de análisis acelerado de computación verde. Puede reducir los costos informáticos y la huella de carbono hasta en un 80%.

La implementación del cambio de carga requiere la colaboración entre los operadores de centros de datos, las empresas de servicios públicos y los operadores de red para mitigar posibles interrupciones en la red. Aún así, esta estrategia es inmensamente prometedora para promover los objetivos de sostenibilidad dentro de la industria de los centros de datos.

A medida que aumenta la demanda de IA, abordar los requisitos energéticos de los centros de datos es fundamental para mitigar las emisiones de carbono. Estrategias innovadoras como el cambio de carga ofrecen un camino para lograr la neutralidad de carbono y al mismo tiempo garantizar la confiabilidad y eficiencia de las operaciones del centro de datos en un panorama cada vez más impulsado por la IA.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://carboncredits.com/carbon-countdown-ais-10-billion-rise-in-power-use-explodes-data-center-emission/