Introducción

El paisaje de inteligencia artificial ha sido remodelado dramáticamente en los últimos años con la llegada de Modelos de lenguaje grande (LLM). Estas poderosas herramientas han evolucionado desde simples procesadores de texto hasta sistemas complejos capaces de comprender y generar texto similar al humano, logrando avances significativos tanto en capacidades como en aplicaciones. A la vanguardia de esta evolución se encuentra la última oferta de Meta, Llama 3, que promete ampliar los límites de lo que los modelos abiertos pueden lograr en términos de accesibilidad y rendimiento.

Tabla de contenidos.

Características clave de Llama 3

- Llama 3 mantiene una arquitectura transformadora solo decodificadora con mejoras significativas, incluido un tokenizador que admite 128,000 tokens, lo que mejora la eficiencia de codificación del lenguaje.

- Integrado en modelos de 8 mil millones y 70 mil millones de parámetros, lo que mejora la eficiencia de la inferencia para un procesamiento enfocado y efectivo.

- Llama 3 supera a sus predecesores y competidores en varios puntos de referencia, sobresaliendo en tareas como MMLU y HumanEval.

- Entrenado en un conjunto de datos de más de 15 billones de tokens, siete veces más grande que llamas 2Conjunto de datos de, que incorpora representaciones lingüísticas diversas y datos no ingleses de más de 30 idiomas.

- Las leyes de escala detalladas optimizan la combinación de datos y los recursos computacionales, lo que garantiza un rendimiento sólido en diversas aplicaciones y, al mismo tiempo, triplica la eficiencia del proceso de capacitación en comparación con Llama 2.

- Una fase mejorada posterior a la capacitación combina ajuste supervisado, muestreo de rechazo y optimización de políticas para mejorar la calidad del modelo y las capacidades de toma de decisiones.

- Disponible en las principales plataformas, presenta características mejoradas de eficiencia y seguridad del tokenizador, lo que permite a los desarrolladores personalizar las aplicaciones y garantizar una implementación responsable de la IA.

Hablando de la ciudad de la IA

Clement Delangue, cofundador y director ejecutivo de HuggingFace

Yann LeCun, profesor de la Universidad de Nueva York | Científico jefe de IA en Meta | Investigador en IA, Machine Learning, Robótica, etc. | Galardonado con el Premio ACM Turing.

Andrej Karpathy, equipo fundador de OpenAI

metallama 3 representa el último avance en la serie de modelos de lenguaje de Meta, lo que marca un importante paso adelante en la evolución de la IA generativa. Disponible ahora, esta nueva generación incluye modelos con 8 mil millones y 70 mil millones de parámetros, cada uno diseñado para sobresalir en una amplia gama de aplicaciones. Desde participar en conversaciones cotidianas hasta abordar tareas complejas de razonamiento, Llama 3 establece un nuevo estándar en rendimiento, eclipsando a sus predecesores en numerosos puntos de referencia de la industria. Llama 3 es de libre acceso, lo que permite a la comunidad impulsar la innovación en IA, desde el desarrollo de aplicaciones hasta la mejora de las herramientas de desarrollo y más.

Arquitectura del modelo y mejoras de Llama 2

Llama 3 mantiene la probada arquitectura de transformador de solo decodificador al tiempo que incorpora mejoras significativas que elevan su funcionalidad más allá de la de Llama 2. Siguiendo una filosofía de diseño coherente, Llama 3 incluye un tokenizador que admite un extenso vocabulario de 128,000 tokens, lo que mejora enormemente la eficiencia del modelo. en lenguaje de codificación. Este desarrollo se traduce en un rendimiento general notablemente mejorado. Además, para aumentar la eficiencia de la inferencia, Llama 3 integra Atención de consultas agrupadas (GQA) en sus modelos de 8 mil millones y 70 mil millones de parámetros. Este modelo también emplea secuencias de 8,192 tokens con una técnica de enmascaramiento que evita que la atención propia se extienda más allá de los límites del documento, lo que garantiza un procesamiento más centrado y eficaz. Estas mejoras en conjunto mejoran la capacidad de Llama 3 para manejar una gama más amplia de tareas con mayor precisión y eficiencia.

| Feature | llamas 2 | llamas 3 |

| Rango de Parámetros | Parámetros 7B a 70B | Parámetros 8B y 70B, con planes para 400B+ |

| Arquitectura modelo | Basado en la arquitectura del transformador. | Arquitectura de transformador estándar solo decodificador |

| Eficiencia de tokenización | Longitud del contexto hasta 4096 tokens | Utiliza un tokenizador con un vocabulario de 128 tokens. |

| Datos de muestra | 2 billones de tokens de fuentes disponibles públicamente | Más de 15 billones de tokens de fuentes disponibles públicamente |

| Eficiencia de inferencia | Mejoras como GQA para el modelo 70B | Atención de consultas agrupadas (GQA) para mejorar la eficiencia |

| Métodos de ajuste | Ajuste supervisado y RLHF | Ajuste supervisado (SFT), muestreo de rechazo, PPO, DPO |

| Consideraciones éticas y de seguridad | Seguro según pruebas inmediatas adversas | Amplio equipo rojo para la seguridad |

| Código abierto y accesibilidad | Licencia comunitaria con ciertas restricciones | Apunta a un enfoque abierto para fomentar un ecosistema de IA |

| Casos de uso | Optimizado para chat y generación de código. | Uso amplio en múltiples dominios con un enfoque en el seguimiento de instrucciones |

Resultados de evaluación comparativa en comparación con otros modelos

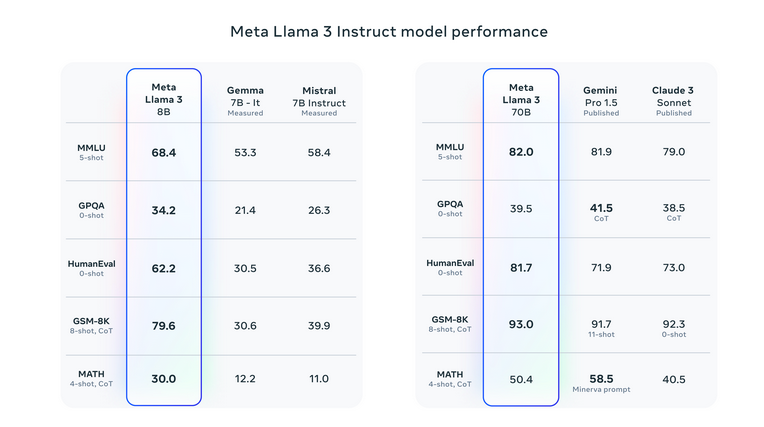

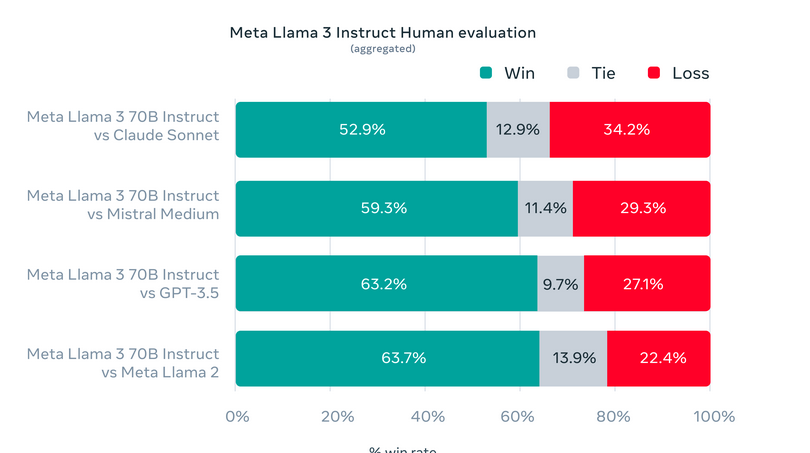

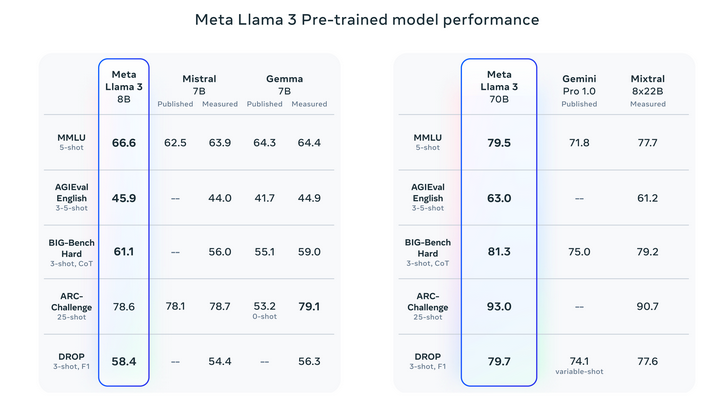

Llama 3 ha elevado el listón de la IA generativa, superando a sus predecesores y competidores en una variedad de puntos de referencia. Ha destacado especialmente en pruebas como MMLU, que evalúa conocimientos en diversas áreas, y HumanEval, centrada en habilidades de codificación. Además, Llama 3 ha superado a otros modelos de altos parámetros como el Gemini 1.5 Pro de Google y el Claude 3 Sonnet de Anthropic, especialmente en tareas complejas de razonamiento y comprensión.

Por favor mira detalles de la evaluación para la configuración y los parámetros con los que se calculan estas evaluaciones.

Evaluación de conjuntos de pruebas estándar y personalizados

Meta ha creado conjuntos de evaluación únicos más allá de los puntos de referencia tradicionales para probar Llama 3 en varias aplicaciones del mundo real. Este marco de evaluación personalizado incluye 1,800 indicaciones que cubren 12 casos de uso críticos: dar consejos, generar ideas, clasificar, responder preguntas abiertas y cerradas, codificación, composición creativa, extracción de datos, juegos de roles, razonamiento lógico, reescritura de textos y resúmenes. Restringir el acceso a este conjunto específico, incluso para los equipos de modelado de Meta, protege contra un posible sobreajuste del modelo. Este riguroso enfoque de prueba ha demostrado el rendimiento superior de Llama 3, eclipsando con frecuencia a otros modelos. Subrayando así su adaptabilidad y competencia.

Por favor mira detalles de la evaluación para la configuración y los parámetros con los que se calculan estas evaluaciones.

Datos de entrenamiento y estrategias de escalamiento

Exploremos ahora los datos de entrenamiento y las estrategias de escalamiento:

Datos de muestra

- El conjunto de datos de entrenamiento de Llama 3, más de 15 billones de tokens, es siete veces mayor que el de Llama 2.

- El conjunto de datos abarca cuatro veces más código y más del 5 % de datos de alta calidad en idiomas distintos del inglés en 30 idiomas. Garantizar una representación lingüística diversa para aplicaciones multilingües.

- Para mantener la calidad de los datos, Meta emplea sofisticados canales de filtrado de datos, incluidos filtros heurísticos, filtros NSFW, deduplicación semántica y clasificadores de texto.

- Aprovechando los conocimientos de modelos Llama anteriores, estos sistemas mejoran el entrenamiento de Llama 3 al identificar e incorporar datos de calidad.

Estrategias de escala

- Meta se centró en maximizar la utilidad del conjunto de datos de Llama 3 mediante el desarrollo de leyes de escala detalladas.

- La optimización de la combinación de datos y los recursos computacionales facilitó predicciones precisas del rendimiento del modelo en diversas tareas.

- La previsión estratégica garantiza un rendimiento sólido en diversas aplicaciones como trivia, STEM, codificación y conocimiento histórico.

- Los conocimientos revelaron la cantidad óptima de cálculo de entrenamiento de Chinchilla para el modelo de parámetros 8B, alrededor de 200 mil millones de tokens.

- Tanto el modelo 8B como el 70B continúan mejorando el rendimiento de forma logarítmica con hasta 15 billones de tokens.

- Meta logró más de 400 TFLOPS por GPU utilizando 16,000 24,000 GPU simultáneamente en clústeres de XNUMX XNUMX GPU personalizados.

- Las innovaciones en infraestructura de capacitación incluyen detección automatizada de errores, mantenimiento de sistemas y soluciones de almacenamiento escalables.

- Estos avances triplicaron la eficiencia del entrenamiento de Llama 3 en comparación con Llama 2, logrando un tiempo de entrenamiento efectivo de más del 95%.

- Estas mejoras establecen nuevos estándares para el entrenamiento de modelos de lenguaje grandes, ampliando los límites de la IA.

Instrucción de ajuste fino

- El ajuste de instrucciones mejora la funcionalidad de los modelos de chat previamente entrenados.

- El proceso combina ajuste supervisado, muestreo de rechazo, PPO y DPO.

- Las indicaciones en SFT y las clasificaciones de preferencias en PPO/DPO son cruciales para el rendimiento del modelo.

- Curación meticulosa de datos y control de calidad por parte de anotadores humanos.

- Las clasificaciones de preferencia en PPO/DPO mejoran el razonamiento y el rendimiento de las tareas de codificación.

- Modelos capaces de producir respuestas correctas pero que pueden tener dificultades con la selección.

- La formación con rankings de preferencias mejora la toma de decisiones en tareas complejas.

Despliegue de Llama3

Llama 3 está configurado para una disponibilidad generalizada en las principales plataformas, incluidos servicios en la nube y proveedores de API modelo. Presenta una eficiencia mejorada del tokenizador, lo que reduce el uso de tokens hasta en un 15 % en comparación con Llama 2, e incorpora Group Query Attention (GQA) en el modelo 8B para mantener la eficiencia de inferencia, incluso con mil millones de parámetros adicionales sobre Llama 1 2B. Las 'Llama Recipes' de código abierto ofrecen recursos integrales para estrategias prácticas de implementación y optimización, respaldando la versátil aplicación de Llama 7.

Mejoras y características de seguridad en Llama 3

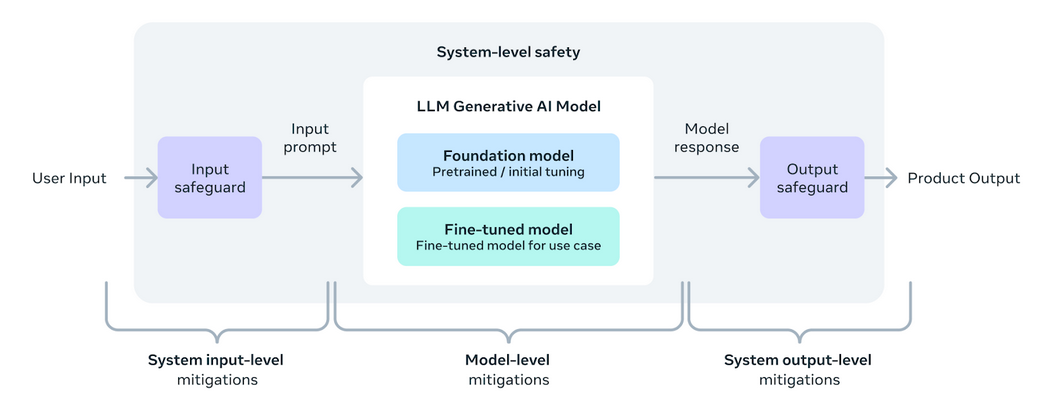

Llama 3 está diseñado para brindar a los desarrolladores herramientas y flexibilidad para adaptar aplicaciones de acuerdo con necesidades específicas. Mejora el ecosistema abierto de IA. Esta versión presenta nuevas herramientas de seguridad y confianza, incluidas Llama Guard 2, Cybersec Eval 2 y Code Shield, que ayudan a filtrar código inseguro durante la inferencia. Llama 3 se ha desarrollado en asociación con torchtune, una biblioteca nativa de PyTorch que permite la creación, el ajuste y la prueba de LLM de manera eficiente y amigable con la memoria. Esta biblioteca admite la integración con plataformas como Hugging Face y Weights & Biases. También facilita la inferencia eficiente en diversos dispositivos a través de Executorch.

Un enfoque sistémico para el despliegue responsable garantiza que los modelos Llama 3 no sólo sean útiles sino también seguros. El ajuste de las instrucciones es un componente clave, mejorado significativamente por los esfuerzos del equipo rojo que prueban la seguridad y la solidez contra posibles usos indebidos en áreas como la seguridad cibernética. La introducción de Llama Guard 2 incorpora la taxonomía MLCommons para respaldar el establecimiento de estándares de la industria, mientras que CyberSecEval 2 mejora las medidas de seguridad contra el uso indebido del código.

La adopción de un enfoque abierto en el desarrollo de Llama 3 tiene como objetivo unir a la comunidad de IA y abordar los riesgos potenciales de manera efectiva. Meta actualizada Guía de uso responsable (RUG) describe las mejores prácticas para garantizar que todas las entradas y salidas del modelo cumplan con los estándares de seguridad, complementadas con herramientas de moderación de contenido ofrecidas por los proveedores de la nube. Estos esfuerzos colectivos están dirigidos a fomentar un uso seguro, responsable e innovador de los LLM en diversas aplicaciones.

Desarrollos futuros para Llama 3

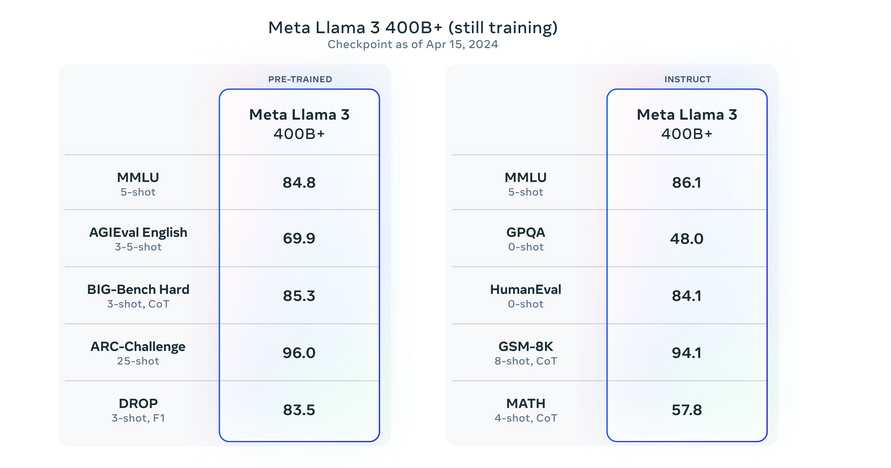

El lanzamiento inicial de los modelos Llama 3, incluidas las versiones 8B y 70B. Es sólo el comienzo de los desarrollos previstos para esta serie. Actualmente, Meta está entrenando modelos aún más grandes con más de 400 mil millones de parámetros. Estos modelos prometerán capacidades mejoradas, como multimodalidad, comunicación multilingüe, ventanas de contexto ampliadas y un rendimiento general más sólido. En los próximos meses se introducirán estos modelos avanzados. Acompañado de un artículo de investigación detallado que describe los hallazgos del entrenamiento de Llama 3. Meta ha compartido instantáneas tempranas del entrenamiento continuo de su modelo LLM más grande, ofreciendo información sobre lanzamientos futuros.

Por favor mira detalles de la evaluación para la configuración y los parámetros con los que se calculan estas evaluaciones.

Impacto y respaldo de Llama 3

- Llama 3 se convirtió rápidamente en el modelo más rápido en alcanzar el puesto número uno en tendencia en Hugging Face. Logrando este récord a tan solo unas horas de su lanzamiento.

Haga clic aquí para acceder al enlace.

- Tras el desarrollo de 30,000 modelos de Llama 1 y 2, Llama 3 está preparado para tener un impacto significativo en el ecosistema de IA.

- Las principales plataformas de nube e inteligencia artificial como AWS, Microsoft Azure, Google Cloud y Hugging Face incorporaron rápidamente Llama 3.

- La presencia del modelo en Kaggle amplía su accesibilidad, fomentando una exploración y un desarrollo más prácticos dentro de la comunidad científica de datos.

- Disponible en LlamaIndex, este recurso compilado por expertos como @ravithejads y @LoganMarkewich brinda orientación detallada sobre cómo utilizar Llama 3 en una variedad de aplicaciones, desde tareas simples hasta complejas canalizaciones RAG. Click aquí para enlace de acceso.

Conclusión

Llama 3 establece un nuevo estándar en la evolución de los modelos de lenguaje grandes. Están mejorando las capacidades de IA en una variedad de tareas con su arquitectura avanzada y eficiencia. Sus exhaustivas pruebas demuestran un rendimiento superior, eclipsando tanto a sus predecesores como a los modelos contemporáneos. Con sólidas estrategias de capacitación y medidas de seguridad innovadoras como Llama Guard 2 y Cybersec Eval 2, Llama 3 subraya el compromiso de Meta con el desarrollo responsable de la IA. A medida que Llama 3 esté ampliamente disponible, promete impulsar avances significativos en las aplicaciones de inteligencia artificial. Ofreciendo también a los desarrolladores una poderosa herramienta para explorar y ampliar las fronteras tecnológicas.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.analyticsvidhya.com/blog/2024/04/meta-llama-3-redefining-large-language-model-standards/