La carrera por modelos de inteligencia artificial cada vez más grandes ha sido un sello distintivo de los avances recientes. Sin embargo, Microsoft está revolucionando las cosas con el Phi-3 Mini, un modelo de IA que cuenta con capacidades impresionantes a pesar de su tamaño compacto.

Tradicionalmente, el éxito en los modelos de lenguaje grandes (LLM) se ha vinculado a la cantidad de parámetros, esencialmente los componentes básicos que informan la comprensión del lenguaje por parte del modelo.

Teniendo en cuenta los costos informáticos y la disponibilidad para todos, Microsoft Phi-3 está aquí para cambiar este enfoque "tradicional".

Microsoft Phi-3 Mini cabe un gigante en tus bolsillos

GPT-3.5, actualmente líder en la carrera LLM, cuenta con la asombrosa cifra de 175 mil millones de parámetros. Este inmenso número permite a GPT-3.5 procesar grandes cantidades de datos de texto, lo que le brinda una comprensión amplia y matizada del lenguaje. Sin embargo, esta complejidad también tiene un costo. Ejecutar un modelo con un número tan alto de parámetros requiere importantes recursos computacionales, lo que lo hace costoso y consume mucha energía.

El modelo mini de Microsoft, por el contrario, adopta un enfoque diferente. Al utilizar un conjunto de parámetros mucho más pequeño (apenas 3.8 millones), el Phi-3 Mini opera con un nivel de eficiencia que eclipsa a sus homólogos más grandes. Esta reducción de tamaño se traduce en varias ventajas.

Todo esto hace que Microsoft Phi-3:

- Significativamente menos costoso de ejecutar

- Una potencia potencial para aplicaciones de IA en dispositivos

Régimen de entrenamiento del Phi-3 Mini

Otro aspecto intrigante del Phi-3 Mini es su método de entrenamiento.

A diferencia de sus homólogos más grandes entrenados en conjuntos de datos masivos de texto y código, la educación de Phi-3 Mini implicó una selección más curada. Los investigadores optaron por un plan de estudios inspirado en cómo aprenden los niños, utilizando libros infantiles como base.

Este enfoque parece haber dado resultados positivos, con Phi-3 Mini demostrando un rendimiento que rivaliza con el de GPT-3.5 en varios puntos de referencia.

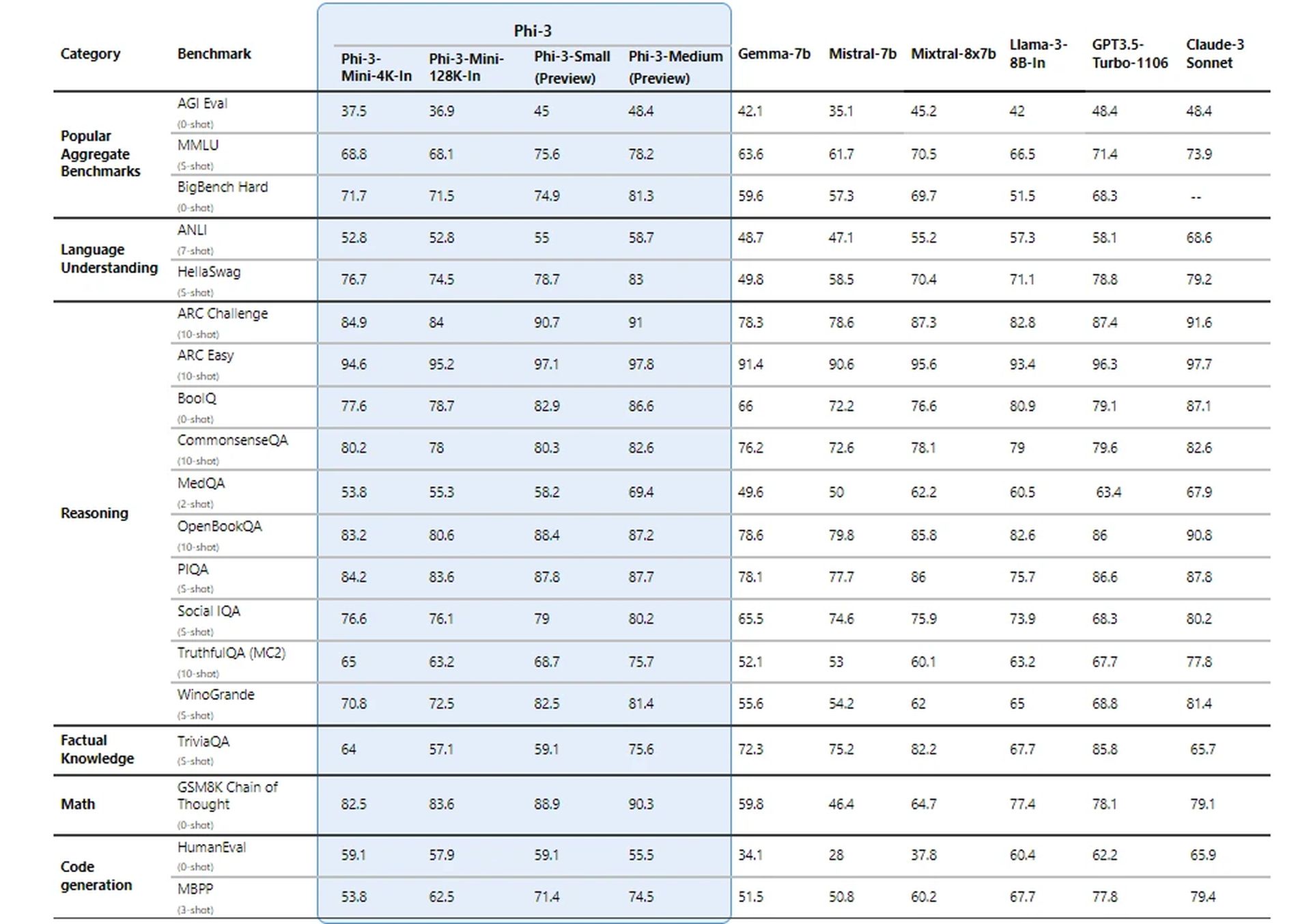

Comparado para el éxito

Los investigadores de Microsoft pusieron a prueba su nuevo modelo utilizando puntos de referencia establecidos para LLM. El modelo logró puntuaciones impresionantes en métricas como MMLU (una medida de la capacidad de un modelo para comprender relaciones complejas en el lenguaje) y MT-bench (una prueba de capacidades de traducción automática).

Estos resultados sugieren que Phi-3 Mini, a pesar de su tamaño, puede competir con los grandes nombres del juego LLM.

¿Cómo logra resultados tan impresionantes?

Los detalles técnicos de Phi-3 Mini revelan un enfoque fascinante para lograr resultados impresionantes con un tamaño de modelo notablemente pequeño. Aquí hay un desglose de los aspectos clave:

Arquitectura del decodificador de transformador

Phi-3 Mini utiliza una arquitectura de decodificador transformador, una opción de diseño predominante para modelos de lenguaje efectivos. Esta arquitectura destaca en el procesamiento de datos secuenciales como texto, lo que permite que el modelo comprenda las relaciones entre las palabras de una oración.

Longitud del contexto

El Phi-3 Mini estándar funciona con una longitud de contexto de 4,000 tokens. Esto define la cantidad máxima de tokens (palabras o partes de palabras) que el modelo considera al generar texto. Una longitud de contexto más larga permite una comprensión más profunda de la conversación anterior, pero también requiere más potencia de procesamiento.

Versión de contexto largo (Phi-3-Mini-128K)

Para tareas que requieren un contexto más amplio, está disponible una variante llamada Phi-3-Mini-128K. Esta versión amplía la longitud del contexto a la friolera de 128,000 tokens, lo que le permite manejar secuencias de información más complejas.

Compatibilidad con herramientas existentes

Para beneficiar a la comunidad de desarrolladores, Phi-3 Mini comparte una estructura y un tamaño de vocabulario similar (320,641) con la familia de modelos Llama-2. Esta compatibilidad permite a los desarrolladores aprovechar las herramientas y bibliotecas existentes diseñadas para Llama-2 cuando trabajan con Phi-3 Mini.

Parámetros del modelo

Aquí es donde realmente brilla el Phi-3 Mini. Con sólo 3.072 mil millones de parámetros, opera muy por debajo de las asombrosas cifras observadas en modelos más grandes como GPT-3.5 (175 mil millones de parámetros).

Esta importante reducción de parámetros se traduce en una eficiencia excepcional en términos de potencia de procesamiento y uso de memoria.

Saif Naik de Microsoft explica:

“Nuestro objetivo con el copiloto Krishi Mitra es mejorar la eficiencia manteniendo al mismo tiempo la precisión de un modelo de lenguaje grande. Estamos entusiasmados de asociarnos con Microsoft para utilizar versiones mejoradas de Phi-3 para alcanzar nuestros dos objetivos: ¡eficiencia y precisión!

– Saif Naik, Jefe de Tecnología, ITCMAARS

Metodología de entrenamiento

La formación de Phi-3 Mini se inspira en el enfoque "Los libros de texto son todo lo que necesitas". Este método enfatiza los datos de entrenamiento de alta calidad en lugar de simplemente aumentar el tamaño del modelo. Los datos de capacitación se seleccionan cuidadosamente, centrándose en fuentes web con un "nivel educativo" específico y datos sintéticos generados por otros LLM.

Esta estrategia permite al Phi-3 Mini lograr resultados impresionantes a pesar de su tamaño compacto.

Filtrado de datos para un aprendizaje óptimo

A diferencia de los enfoques tradicionales que priorizan los recursos computacionales o el entrenamiento excesivo, Phi-3 Mini se centra en un "régimen de datos óptimo" para su tamaño. Esto implica filtrar meticulosamente los datos web para garantizar que contengan el nivel correcto de "conocimiento" y promuevan las habilidades de razonamiento.

Por ejemplo, se podrían excluir datos deportivos generales para priorizar información que mejore la capacidad de razonamiento del modelo.

Ajuste post-entrenamiento

Después del proceso de capacitación central, el nuevo modelo se somete a un refinamiento adicional mediante ajuste fino supervisado (SFT) y optimización de preferencias directas (DPO). SFT expone el modelo a datos seleccionados en varios dominios, incluidos principios matemáticos, de codificación y de seguridad. DPO ayuda a alejar el modelo de comportamientos no deseados al identificar y excluir resultados no deseados.

Esta fase posterior al entrenamiento transforma al Phi-3 Mini de un modelo de lenguaje a un asistente de IA versátil y seguro.

Rendimiento eficiente en el dispositivo

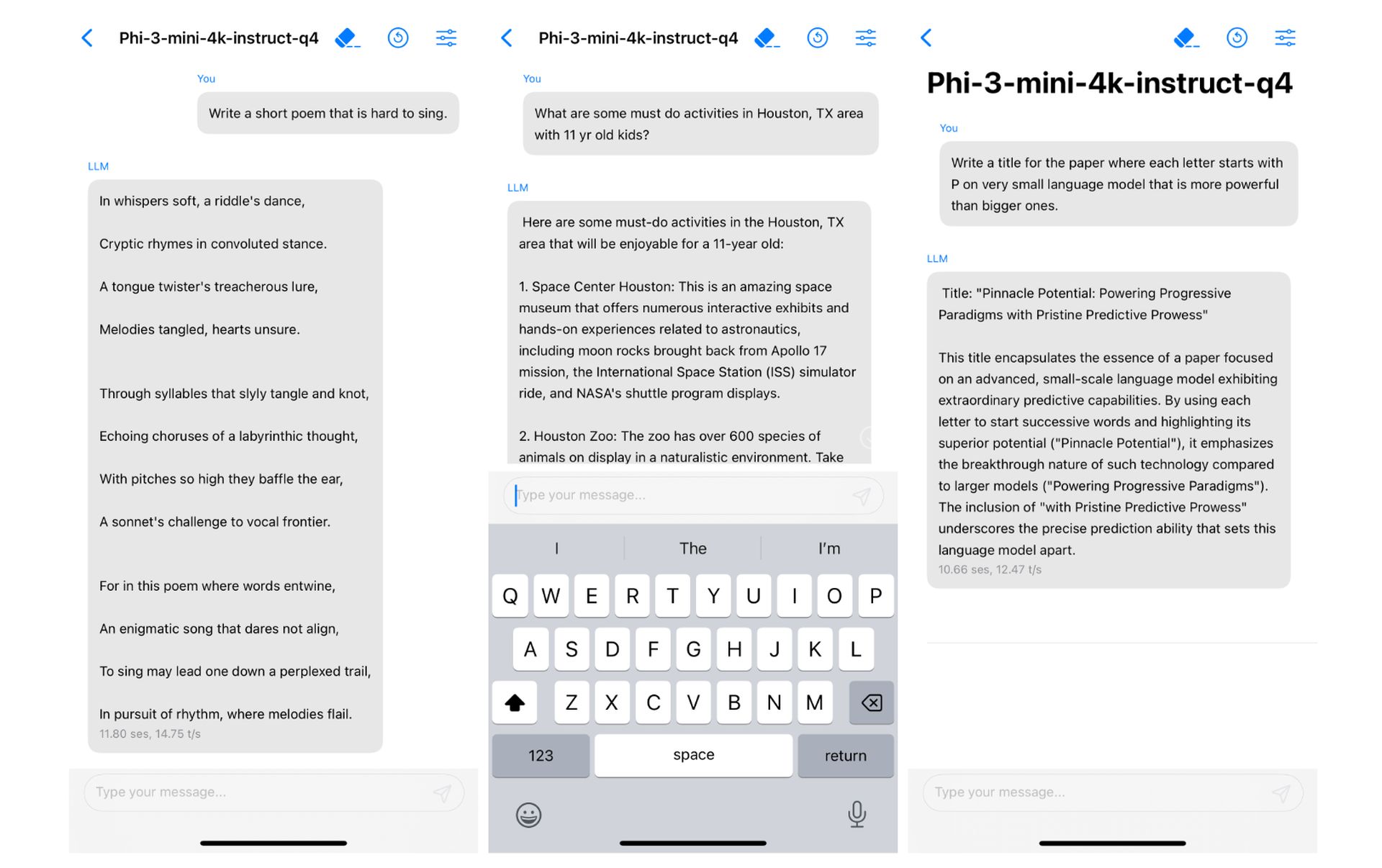

El pequeño tamaño del Phi-3 Mini se traduce en un rendimiento excepcional en el dispositivo. Al cuantificar el modelo a 4 bits, ocupa apenas 1.8 gigabytes de memoria.

Un partido hecho en el cielo

¿Recuerdas los intentos fallidos de Microsoft con los teléfonos inteligentes? Qué pasa Los fallidos acuerdos de integración de Google Gemini de Apple ¿En meses recientes? ¿O ha estado siguiendo las noticias de que Apple ha expresado su opinión sobre la integración de un LLM en el dispositivo con iOS 18 en las últimas semanas?

Sonó una campana?

Las aplicaciones potenciales de Phi-3 Mini son enormes. Su eficiencia lo hace ideal para la integración en dispositivos móviles, lo que potencialmente permite funciones como asistentes virtuales más inteligentes y traducción de idiomas en tiempo real. Además, su rentabilidad podría abrir las puertas a una adopción más amplia por parte de los desarrolladores que trabajan en diversos proyectos impulsados por IA.

Y eso es exactamente lo que Apple estaba buscando. Por supuesto, esta afirmación no es más que una suposición por ahora, pero no sería un error decir que se trata de una "combinación hecha en el cielo". Además, en el trabajo de investigación, el nuevo proyecto de Microsoft ya se ha ejecutado en un iPhone con chip A16 Bionic de forma nativa.

El éxito de Phi-3 Mini depende de una combinación de factores: una arquitectura adecuada, uso eficiente de la longitud del contexto, compatibilidad con herramientas existentes, enfoque en datos de entrenamiento de alta calidad y técnicas de optimización. Este enfoque único allana el camino para modelos de IA potentes y eficientes que pueden funcionar sin problemas en dispositivos personales.

Crédito de la imagen destacada: vecstock/Freepik

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://dataconomy.com/2024/04/24/microsoft-phi-3/