Esta publicación está escrita en colaboración con Balaji Chandrasekaran, Jennifer Cwagenberg y Andrew Sansom y Eiman Ebrahimi de Protopia AI.

Los nuevos y potentes modelos de lenguajes grandes (LLM) están cambiando las empresas rápidamente, mejorando la eficiencia y eficacia para una variedad de casos de uso empresarial. La velocidad es esencial y la adopción de tecnologías LLM puede hacer o deshacer la ventaja competitiva de una empresa. AWS es especialmente adecuado para proporcionar a las empresas las herramientas necesarias para implementar LLM a escala para permitir la toma de decisiones críticas.

Al implementar la tecnología de IA generativa, las empresas tienen preocupaciones reales sobre la exposición de los datos y la propiedad de la información confidencial que puede enviarse a los LLM. Estas preocupaciones sobre la privacidad y la protección de datos pueden ralentizar o limitar el uso de LLM en las organizaciones. Las empresas necesitan una forma responsable y más segura de enviar información confidencial a los modelos sin tener que asumir los gastos generales, a menudo prohibitivos, de DevOps local.

La publicación describe cómo puede superar los desafíos de conservar la propiedad de los datos y preservar la privacidad de los datos mientras utiliza LLM mediante la implementación de Stained Glass Transform de Protopia AI para proteger sus datos. Protopía IA se ha asociado con AWS para ofrecer el componente crítico de protección y propiedad de datos para una adopción empresarial segura y eficiente de la IA generativa. Esta publicación describe la solución y demuestra cómo se puede utilizar en AWS para casos de uso empresarial populares como Recuperación Generación Aumentada (RAG) y con LLM de última generación como llamas 2.

Descripción general de la transformación de vidrieras

Las organizaciones buscan conservar la propiedad y el control total de sus datos empresariales confidenciales. Este es un pilar de la IA responsable y un requisito emergente de privacidad y protección de datos que va más allá de las garantías legales y de seguridad básicas de los proveedores de LLM.

Aunque las unidades de negocios empresariales quieren utilizar LLM para diversas tareas, también les preocupa que los secretos comerciales, la propiedad intelectual y otra información patentada se filtren a través de los datos enviados a estos modelos. Al mismo tiempo, las oficinas de información, cumplimiento, gestión de datos y seguridad empresarial temen exponer o filtrar información de clientes en texto plano u otros datos regulados fuera de la empresa. AWS y Protopia AI se están asociando para ofrecer el componente crítico que resuelve esta necesidad común de los clientes empresariales.

Stained Glass Transform (SGT) de Protopia AI resuelve estos desafíos al convertir datos empresariales desprotegidos en una representación aleatoria, denominada datos RmoRed, como se muestra en la siguiente figura. Esta representación es una incrustación estocástica de los datos originales, que preserva la información que el LLM de destino necesita para funcionar sin exponer indicaciones o consultas confidenciales, contexto o datos de ajuste. Esta nueva representación es una transformación unidireccional que no se puede revertir, lo que garantiza la privacidad integral de los datos empresariales y la protección contra la filtración de información confidencial en texto sin formato a los LLM. La aplicabilidad de SGT no se limita a los modelos de lenguaje. También se pueden generar representaciones aleatorias para datos visuales y estructurados. El nombre Stained Glass Transform tiene sus raíces en la apariencia visual de representaciones aleatorias de datos visuales que pueden parecerse a ver los datos a través de vidrieras, como se demuestra en este Caso de uso de la Marina de EE. UU..

SGT trabaja con LLM de última generación como Llama 2. La siguiente figura muestra un ejemplo de aplicación de SGT a un modelo Llama 2 para seguir instrucciones mientras se agrega una capa de protección a la instrucción y el contexto. El lado izquierdo de la figura muestra un ejemplo de un documento financiero como contexto, con la instrucción pidiendo al modelo que resuma el documento. En la parte inferior izquierda, se muestra la respuesta generada por Llama 2 cuando opera en el mensaje sin formato. Cuando se utiliza SGT, las incrustaciones asociadas con este mensaje se transforman en el lado del cliente en incrustaciones estocásticas, como se describe con más detalle más adelante en esta publicación. La parte inferior derecha muestra que Llama 2 aún puede generar una respuesta correcta si se envían los datos de RmoRed (incrustaciones posteriores a la transformación) en lugar de las incrustaciones desprotegidas. La parte superior derecha muestra que si los datos de RmoRed se filtraran, una reconstrucción del mensaje original daría como resultado un texto ininteligible.

Para crear un SGT para un modelo determinado como Llama 2, Protopia AI proporciona una biblioteca liviana llamada Stained Glass SDK, que es una extensión de PyTorch. Como se muestra en la siguiente figura, una vez creado un SGT, se puede integrar en los canales de implementación de varias maneras. La transformación que se crea a partir del SDK se puede implementar localmente, en una configuración híbrida o completamente en la nube. Esto es posible porque SGT está diseñado para ser un proceso liviano que requiere muy pocos recursos informáticos y, como tal, tiene un impacto mínimo en la ruta crítica de inferencia. Otra evaluación clave es la retención de la precisión del modelo utilizando datos representados nuevamente. Observamos que en diferentes tipos de datos y variaciones de modelos, la precisión se mantiene dentro de los límites de tolerancia deseables cuando se utilizan datos representados nuevamente.

Estas opciones de implementación y mantenimiento de la precisión permiten una adopción segura de SGT por parte de todas las partes interesadas dentro de una organización empresarial. Para proteger aún más el resultado del LLM, Protopia AI puede codificar los resultados de la consulta en una representación cuyo decodificador solo esté disponible para el propietario de los datos empresariales.

Resumen de la solución

La sección anterior describió cómo se puede utilizar Stained Glass Transform en una variedad de arquitecturas. La siguiente figura detalla los pasos involucrados en la creación, implementación y uso de SGT para LLM:

- Creación de SGT: el equipo que entrena el modelo básico de LLM (proveedores de LLM propietarios, proveedores de servicios en la nube o equipos de ML empresarial que crean sus propios LLM) ejecuta el software Stained Glass SDK de Protopia AI sin alterar sus prácticas existentes para capacitar e implementar el LLM. Una vez completada la capacitación del modelo básico, el SDK se ejecuta como un paso de optimización sobre el modelo de lenguaje para calcular el SGT. Este pase de optimización se entrega a través de una extensión de PyTorch. El SDK envuelve el modelo básico y descubre matemáticamente una transformación de vidriera única para ese LLM. Se pueden encontrar más detalles de las matemáticas subyacentes en el documento adjunto. Tenga en cuenta que debido a que el equipo que entrena el LLM también ejecuta el SDK de Stained Glass, no es necesario exponer ni enviar pesos del modelo para completar este paso.

- Lanzamiento e implementación de SGT: el SGT que se obtiene del paso de optimización anterior se implementa como parte de la canalización de datos que alimenta el LLM capacitado. Como se describió en la sección anterior, el SGT se encuentra en el lado del cliente empresarial.

- Uso de SGT: el SGT se ejecuta según los mensajes creados por la empresa y genera mensajes protegidos, que se envían al LLM implementado. Esto permite a la empresa conservar la propiedad de sus consultas y contexto confidenciales. Al utilizar Protopia AI Stained Glass, los datos confidenciales desprotegidos no abandonan el sitio de la empresa ni la zona de confianza.

Puede utilizar el SDK de Stained Glass para crear un SGT de varias formas. Por ejemplo, puede utilizar el SDK de Stained Glass en entornos de aprendizaje automático (ML) autoadministrados con Servicio Amazon Elastic Kubernetes (Amazon EKS) para entrenamiento e inferencia o dentro Nube informática elástica de Amazon (Amazon EC2) directamente. Otra opción es que puede ejecutarse dentro Amazon SageMaker para crear un SGT para un modelo entrenado determinado. La transformación de la entrada para la implementación durante la inferencia del cliente es independiente de la implementación de implementación elegida.

La siguiente figura ilustra una posible implementación en un entorno de aprendizaje automático autoadministrado donde se realiza el entrenamiento de una transformación de Stained Glass en Amazon EKS.

En este flujo de trabajo, se crea un contenedor utilizando el SDK de Stained Glass y se implementa en Registro de contenedores elásticos de Amazon (Amazon ECR). Luego, este contenedor se implementa en Amazon EKS para entrenar un SGT que se guarda en Servicio de almacenamiento simple de Amazon (Amazon S3). Si utiliza Amazon EC2, puede entrenar una transformación directamente en su instancia como parte de su configuración de ML. El SDK de Stained Glass se puede ejecutar en una variedad de tipos de instancias, incluidas las familias de instancias Amazon P5, P4 o G5, según sus requisitos básicos de LLM. Después de implementar el LLM para usarlo con fines de inferencia, la aplicación cliente utiliza el SGT creado, que es una operación liviana, para transformar las indicaciones y el contexto antes de enviarlos al LLM. Al hacerlo, solo los datos transformados se exponen al LLM y la propiedad de la entrada original se conserva en el lado del cliente.

La siguiente figura demuestra cómo se puede entrenar una transformación y ejecutar inferencias en SageMaker.

La creación de SGT sigue un camino similar a la configuración de Amazon EKS al incorporar los datos de entrenamiento de Amazon S3, entrenar un SGT en un contenedor y guardarlo en Amazon S3. Puede utilizar el SDK de Stained Glass en su configuración existente de SageMaker con Estudio Amazon SageMaker, Cuadernos SageMaker, Y un Trabajo de entrenamiento de SageMaker. El LLM está alojado como un punto final de SageMaker al que puede acceder la aplicación cliente. La inferencia para la aplicación cliente también es idéntica a la configuración de Amazon EKS, excepto por lo que sirve al modelo.

Representaciones aleatorias para proteger las indicaciones de LLM y ajustar los datos

Esta sección cubre una variedad de casos de uso que demuestran cómo la representación aleatoria protege las indicaciones de LLM. Los ejemplos ilustran las principales implicaciones para los esfuerzos de IA generativa empresarial: abrir nuevas puertas a casos de uso de IA, acelerar la velocidad de comercialización al tiempo que se protegen adecuadamente los datos empresariales y conservar la propiedad de los datos confidenciales necesarios para su uso en las solicitudes de LLM.

Caso de uso de RAG

Un caso de uso empresarial popular para los LLM es la generación aumentada de recuperación (RAG). La siguiente figura muestra un ejemplo ilustrativo en el que las indicaciones y las fuentes están protegidas mediante Stained Glass. El lado izquierdo de la figura muestra las indicaciones desprotegidas y la información de origen. En una implementación empresarial de RAG, las fuentes podrían incluir información confidencial, como secretos comerciales empresariales, propiedad intelectual o información financiera. El lado derecho muestra la mejor reconstrucción posible en texto legible por humanos a partir de las indicaciones de RmoRed creadas por el SGT.

Podemos observar que incluso en la mejor reconstrucción posible, la información está completamente confusa. Sin embargo, la respuesta del modelo con y sin la transformación es la misma, con indicaciones a los documentos fuente originales, preservando así la precisión tanto de la pregunta como de los documentos fuente mientras se realiza este popular caso de uso empresarial.

Amplia aplicabilidad en LLM e idiomas

Uno de los aspectos más destacados del SDK de Stained Glass es que es altamente resistente a los avances del modelo y adaptable a modelos de última generación como llamas 2. La siguiente figura muestra un SGT que se creó en un LLM de Llama 2 que previamente se ajustó para trabajar con texto en japonés. Este ejemplo ilustra además que los SGT se pueden crear y aplicar para cualquier idioma y que incluso las entradas para modelos ajustados se pueden transformar. La aplicabilidad general de SGT está impulsada por la sólida base del SDK de Stained Glass que es independiente del modelo y de los datos.

Proteger los datos de ajuste y las indicaciones

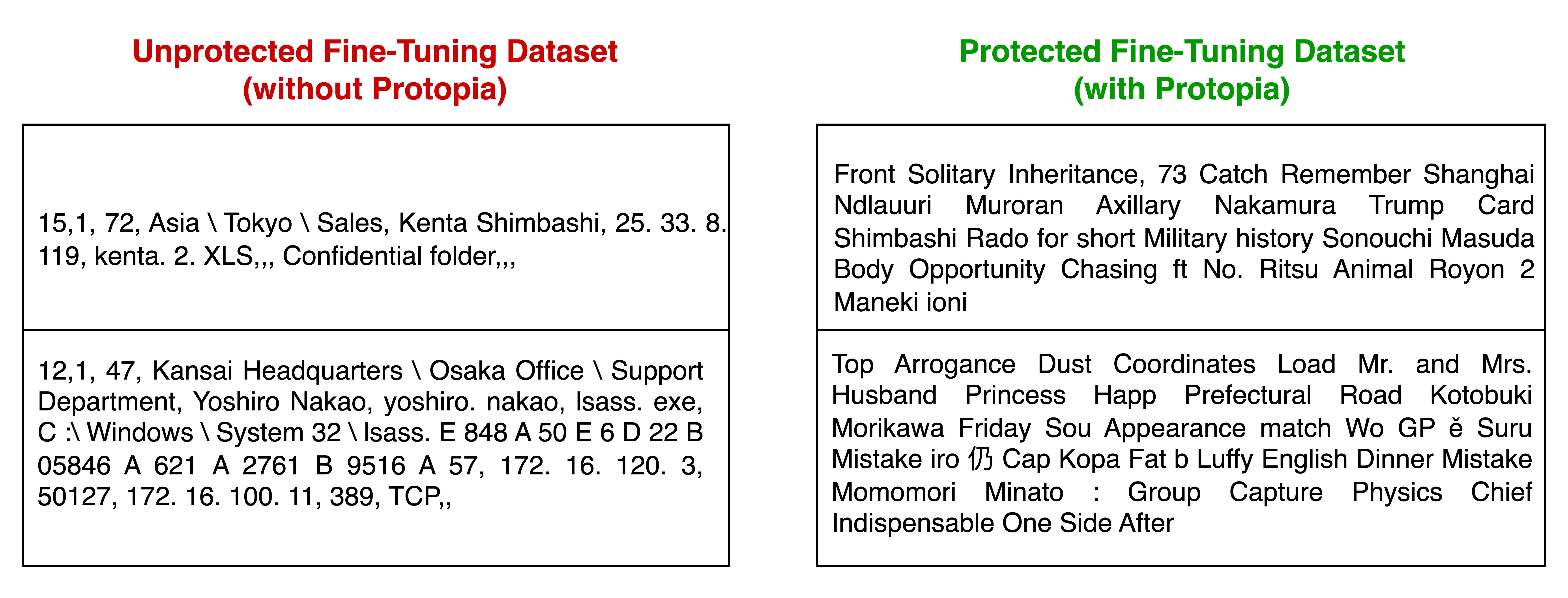

Stained Glass Transform no se limita únicamente a proteger los datos en el momento de la inferencia; también puede proteger los datos utilizados para ajustar un modelo básico. El proceso para crear la transformación para ajustar los conjuntos de datos es el mismo que se explica en la sección de arquitectura de la solución anteriormente en esta publicación. La transformación se crea para que el modelo básico se ajuste sin acceder a los datos de ajuste. Una vez creado y entrenado el SGT para el modelo básico, el conjunto de datos de ajuste se transforma en representaciones aleatorias que luego se utilizarán para ajustar el modelo básico. Este proceso se explica con más detalle en el documento adjunto.

En el siguiente ejemplo, un cliente empresarial necesitaba ajustar un modelo existente para la detección de anomalías en los registros de red. Utilizaron Stained Glass para transformar el conjunto de datos sensibles de ajuste fino en incrustaciones aleatorias, que se utilizaron para ajustar su modelo base. Descubrieron que el modelo de detección que se ajustó en las representaciones transformadas se desempeñó con una precisión casi idéntica en comparación con el escenario hipotético de ajustar el modelo básico en el conjunto de datos de ajuste fino desprotegido. La siguiente tabla muestra dos ejemplos de registros de datos de texto sin formato del conjunto de datos de ajuste fino y una reconstrucción en texto de esos mismos registros de datos del conjunto de datos de ajuste fino.

Debajo del capó de Stained Glass Transform para LLM

Cuando se aplica a la visión por computadora, SGT opera en características de píxeles de entrada y, para LLM, opera en el nivel de incrustación. Para resaltar cómo funciona Stained Glass Transform, imagine las incrustaciones de mensajes como una matriz, como se ilustra a la izquierda de la siguiente figura. En cada entrada, hay un valor determinista. Este valor se puede asignar a los datos originales, exponiendo el mensaje desprotegido. Stained Glass Transform convierte esta matriz de valores deterministas en una matriz cuyos elementos son una nube de posibilidades.

El aviso transformado se genera muestreando el ruido de las distribuciones de probabilidad definidas por el SGT y agregando el ruido muestreado a las incrustaciones deterministas, lo que aleatoriza los valores del aviso original de manera irreversible. El modelo aún comprende el mensaje re-representado aleatorio a nivel matemático y puede llevar a cabo su tarea con precisión.

Conclusión

Esta publicación analizó cómo Stained Glass Transform de Protopia AI desacopla la propiedad y la protección de los datos sin procesar del proceso de operaciones de ML, lo que permite a las empresas retener la propiedad y mantener la privacidad de la información confidencial en las indicaciones de LLM y ajustar los datos. Al utilizar esta protección de datos de última generación para el uso de LLM, las empresas pueden acelerar la adopción de modelos básicos y LLM al preocuparse menos por la exposición de información confidencial. Al desbloquear de forma segura el valor de los datos empresariales reales, las organizaciones pueden lograr las eficiencias y los resultados comerciales prometidos por los LLM de manera más eficiente y rápida. Para obtener más información sobre esta tecnología, puede encontrar más lecturas en el documento adjunto y conéctate con Protopia AI para obtener acceso y probarlo en los datos de su empresa.

Acerca de Protopía IA

Protopia AI es líder en tecnologías de IA/ML para protección de datos y preservación de la privacidad con sede en Austin, Texas, y se especializa en permitir que los algoritmos de IA y las plataformas de software funcionen sin la necesidad de acceder a información de texto sin formato. Durante los últimos 2 años, Protopia AI ha demostrado con éxito su producto estrella Stained Glass Transform en una variedad de casos de uso de ML y tipos de datos con la Marina de los EE. UU., servicios financieros líderes y proveedores de tecnología globales.

Protopia AI trabaja con empresas, proveedores de IA generativa y LLM, y proveedores de servicios en la nube (CSP) para permitir mantener la propiedad y la confidencialidad de los datos empresariales mientras se utilizan soluciones de IA/ML. Protopia AI se ha asociado con AWS para ofrecer un componente crítico de protección y propiedad de datos para la adopción empresarial de IA generativa, y fue una de las 21 nuevas empresas seleccionadas para la inauguración. Acelerador de IA generativa de AWS en 2023.

Sobre los autores

Balaji Chandrasekaran es vicepresidente de comercialización y habilitación del cliente en Protopia AI, trabaja en estrecha colaboración con los clientes para aprovechar la IA en sus negocios y al mismo tiempo priorizar la protección de datos y la privacidad. Antes de Protopia AI, Balaji fue líder de producto para soluciones de IA en Infor, desarrollando productos centrados en el valor y al mismo tiempo actuaba como un socio confiable para clientes empresariales en diversas industrias. Fuera del trabajo, le gusta la música, las caminatas y viajar con la familia.

Balaji Chandrasekaran es vicepresidente de comercialización y habilitación del cliente en Protopia AI, trabaja en estrecha colaboración con los clientes para aprovechar la IA en sus negocios y al mismo tiempo priorizar la protección de datos y la privacidad. Antes de Protopia AI, Balaji fue líder de producto para soluciones de IA en Infor, desarrollando productos centrados en el valor y al mismo tiempo actuaba como un socio confiable para clientes empresariales en diversas industrias. Fuera del trabajo, le gusta la música, las caminatas y viajar con la familia.

Jennifer Cwagenberg lidera el equipo de ingeniería de Protopia AI y trabaja para garantizar que la tecnología Stained Glass satisfaga las necesidades de sus clientes para proteger sus datos. Jennifer tiene experiencia previa en seguridad trabajando en Toyota en su grupo de ciberseguridad de productos, administrando cargas de trabajo en la nube en N-able y responsable de los datos en Match.com.

Jennifer Cwagenberg lidera el equipo de ingeniería de Protopia AI y trabaja para garantizar que la tecnología Stained Glass satisfaga las necesidades de sus clientes para proteger sus datos. Jennifer tiene experiencia previa en seguridad trabajando en Toyota en su grupo de ciberseguridad de productos, administrando cargas de trabajo en la nube en N-able y responsable de los datos en Match.com.

andres sansom es ingeniero de soluciones de inteligencia artificial en Protopia AI, donde ayuda a las empresas a utilizar la inteligencia artificial mientras preserva la información privada y confidencial en sus datos. Antes de Protopia AI, trabajó como consultor técnico enfocado en habilitar soluciones de inteligencia artificial para clientes de muchas industrias, incluidas finanzas, manufactura, atención médica y educación. También enseñó informática y matemáticas a estudiantes de secundaria, universidad y profesionales.

andres sansom es ingeniero de soluciones de inteligencia artificial en Protopia AI, donde ayuda a las empresas a utilizar la inteligencia artificial mientras preserva la información privada y confidencial en sus datos. Antes de Protopia AI, trabajó como consultor técnico enfocado en habilitar soluciones de inteligencia artificial para clientes de muchas industrias, incluidas finanzas, manufactura, atención médica y educación. También enseñó informática y matemáticas a estudiantes de secundaria, universidad y profesionales.

Eiman Ebrahimi, PhD, es cofundador y director ejecutivo de Protopia AI. Al Dr. Ebrahimi le apasiona permitir que la IA enriquezca la experiencia humana en diferentes sectores sociales e industriales. Protopia AI es una visión para mejorar la lente a través de la cual la IA observa los datos necesarios y de calidad que necesita mientras crea capacidades novedosas para salvaguardar la información confidencial. Antes de Protopia AI, fue investigador científico senior en NVIDIA durante 9 años. Su trabajo en la investigación de NVIDIA tenía como objetivo resolver los problemas de acceso a conjuntos de datos masivos en ML/AI. También fue coautor de publicaciones revisadas por pares sobre cómo utilizar el poder de miles de GPU para hacer factible el entrenamiento de modelos de lenguaje grandes.

Eiman Ebrahimi, PhD, es cofundador y director ejecutivo de Protopia AI. Al Dr. Ebrahimi le apasiona permitir que la IA enriquezca la experiencia humana en diferentes sectores sociales e industriales. Protopia AI es una visión para mejorar la lente a través de la cual la IA observa los datos necesarios y de calidad que necesita mientras crea capacidades novedosas para salvaguardar la información confidencial. Antes de Protopia AI, fue investigador científico senior en NVIDIA durante 9 años. Su trabajo en la investigación de NVIDIA tenía como objetivo resolver los problemas de acceso a conjuntos de datos masivos en ML/AI. También fue coautor de publicaciones revisadas por pares sobre cómo utilizar el poder de miles de GPU para hacer factible el entrenamiento de modelos de lenguaje grandes.

Rohit Talluri es especialista en IA generativa GTM en Amazon Web Services (AWS). Se está asociando con los principales creadores de modelos de IA generativa, clientes estratégicos, socios clave de IA/ML y equipos de servicio de AWS para permitir la próxima generación de inteligencia artificial, aprendizaje automático y computación acelerada en AWS. Anteriormente fue arquitecto de soluciones empresariales y líder de soluciones globales para el asesoramiento sobre fusiones y adquisiciones de AWS.

Rohit Talluri es especialista en IA generativa GTM en Amazon Web Services (AWS). Se está asociando con los principales creadores de modelos de IA generativa, clientes estratégicos, socios clave de IA/ML y equipos de servicio de AWS para permitir la próxima generación de inteligencia artificial, aprendizaje automático y computación acelerada en AWS. Anteriormente fue arquitecto de soluciones empresariales y líder de soluciones globales para el asesoramiento sobre fusiones y adquisiciones de AWS.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://aws.amazon.com/blogs/machine-learning/foundational-data-protection-for-enterprise-llm-acceleration-with-protopia-ai/