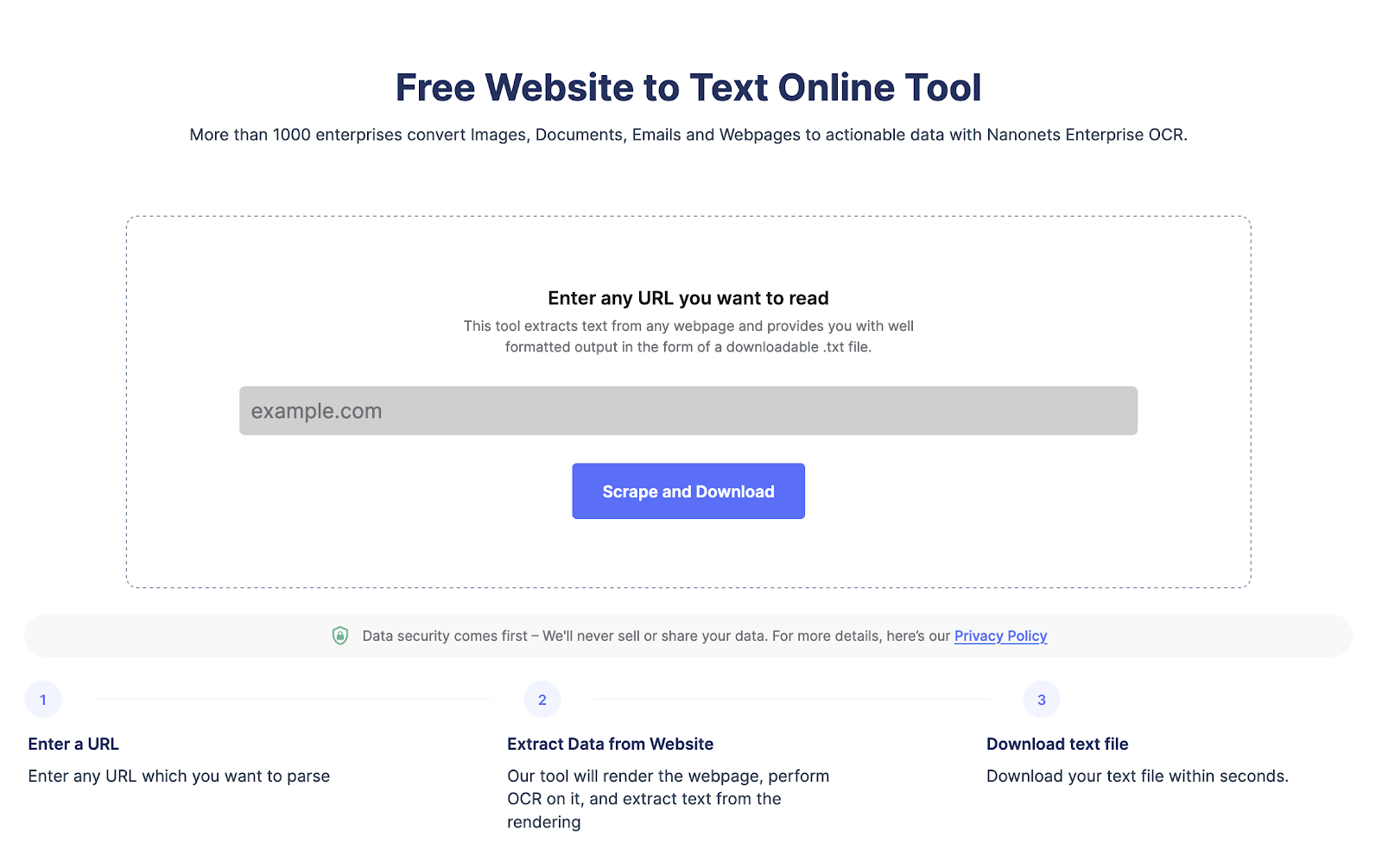

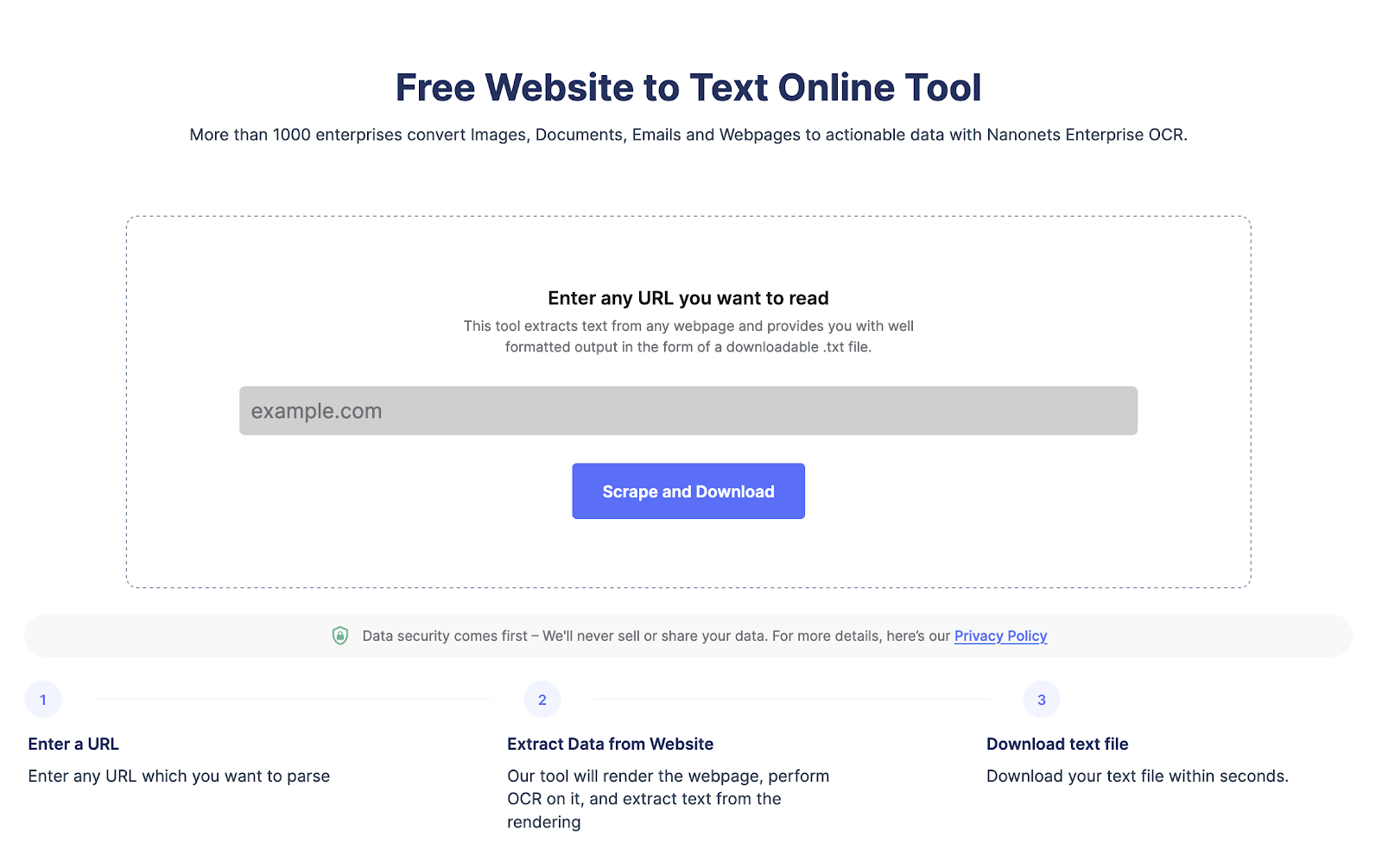

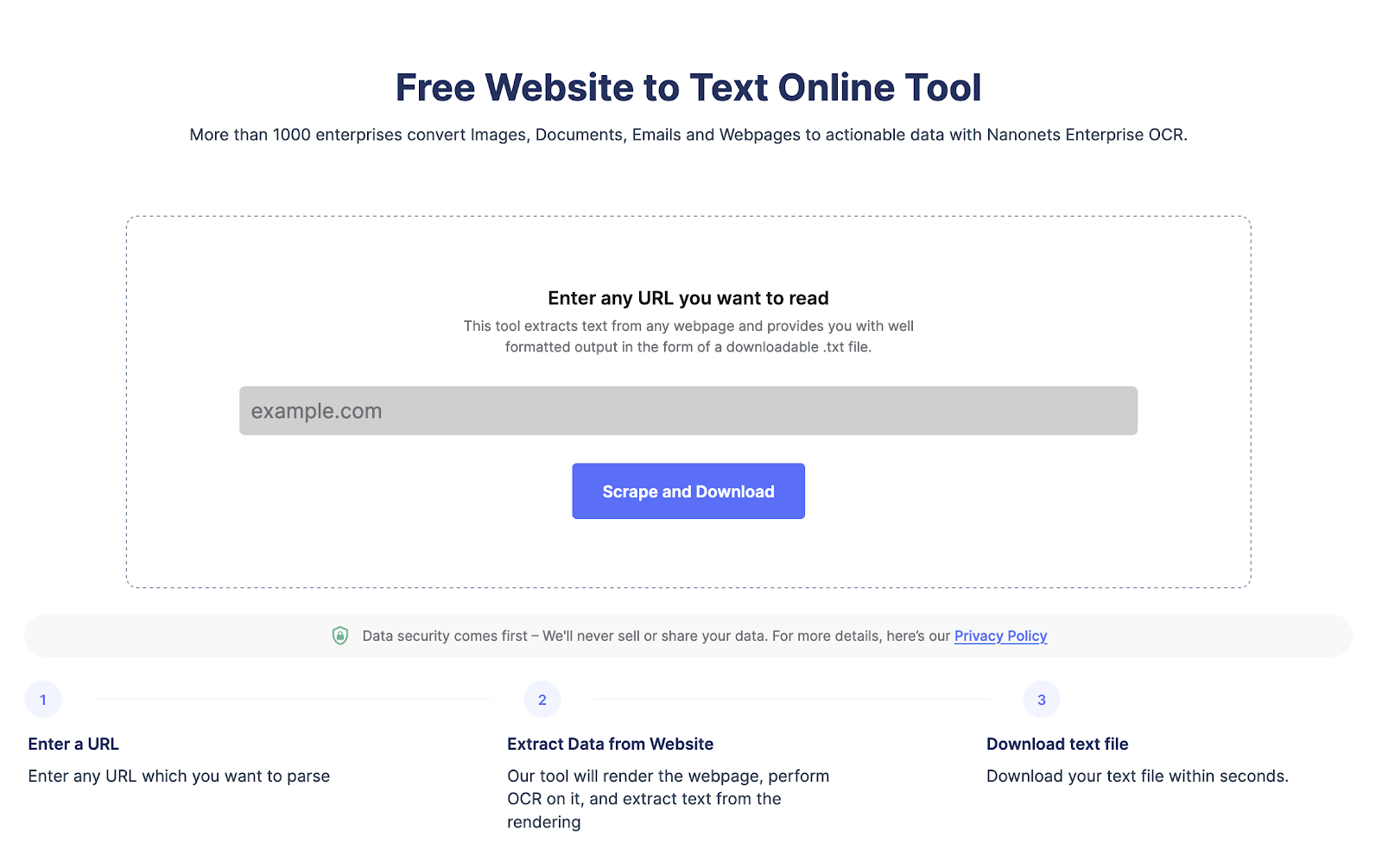

¿Buscas extraer datos de una página web?

Dirígete a Nanonets raspador de sitios web, agregue la URL y haga clic en "Raspar" y descargue el texto de la página web como un archivo al instante. Pruébelo gratis ahora.

¿Qué es el raspado web de Selenium?

El raspado web es el proceso de extracción de datos de sitios web. Es una técnica poderosa que revoluciona la recopilación y el análisis de datos. Con una gran cantidad de datos en línea, el web scraping se ha convertido en una herramienta esencial para empresas y particulares.

Selenium es una herramienta de desarrollo web de código abierto que se utiliza para automatizar las funciones de navegación web. Fue desarrollado en 2004 y se usa principalmente para probar automáticamente sitios web y aplicaciones en varios navegadores, pero ahora se ha convertido en una herramienta popular para el web scraping. Selenium se puede usar con varios lenguajes de programación, incluidos Python, Java y C#. Proporciona API sólidas para la interacción de la página web, incluida la navegación, los clics, la escritura y el desplazamiento.

El raspado web de Selenium se refiere al uso de la herramienta de automatización del navegador Selenium con Python para extraer datos de sitios web. Selenium permite a los desarrolladores controlar mediante programación un navegador web mediante programación, lo que significa que pueden interactuar con sitios web como si fueran usuarios humanos.

¿Por qué usar Selenium y Python para web scraping?

Python es un lenguaje de programación popular para el web scraping porque tiene muchas bibliotecas y marcos que facilitan la extracción de datos de los sitios web.

El uso de Python y Selenium para el web scraping ofrece varias ventajas sobre otras técnicas de web scraping:

- Sitios web dinámicos: Las páginas web dinámicas se crean utilizando JavaScript u otros lenguajes de secuencias de comandos. Estas páginas a menudo contienen elementos visibles una vez que la página está completamente cargada o cuando el usuario interactúa con ellos. Selenium puede interactuar con estos elementos, lo que lo convierte en una poderosa herramienta para extraer datos de páginas web dinámicas.

- Interacciones del usuario: Selenium puede simular interacciones de usuario como clics, envíos de formularios y desplazamiento. Esto le permite raspar sitios web que requieren la entrada del usuario, como formularios de inicio de sesión.

- Depuración: Selenium se puede ejecutar en modo de depuración, lo que le permite recorrer paso a paso el proceso de raspado y ver qué está haciendo el raspador en cada paso. Esto es útil para solucionar problemas cuando las cosas van mal.

Requisitos previos para web scraping con Selenium:

Python 3 está instalado en su sistema.

Biblioteca Selenium instalada. Puedes instalarlo usando pip con el siguiente comando:

pip install SeleniumWebDriver instalado.

WebDriver es un ejecutable separado que Selenium usa para controlar el navegador. Aquí están los enlaces que encontré para descargar WebDriver para los navegadores más populares:

Alternativamente, y esta es la forma más fácil, también puede instalar WebDriver usando un administrador de paquetes como el administrador de controladores web. Esto descargará e instalará automáticamente el WebDriver apropiado para usted. Para instalar el administrador de controladores web, puede usar el siguiente comando:

pip install webdriver-manager¡Extraiga el texto completo de la página web en segundos!

Dirígete a Nanonets raspador de sitios web, agregue la URL y haga clic en "Raspar" y descargue el texto de la página web como un archivo al instante. Pruébelo gratis ahora.

Una guía paso a paso para el web scraping de Selenium

Paso 1: Instalar e Importar

Antes de comenzar, nos hemos asegurado de haber instalado Selenium y un controlador apropiado. Usaremos el controlador Edge en este ejemplo.

from selenium import webdriver

from Selenium.webdriver.common.keys import Keys

from Selenium.webdriver.common.by import ByPaso 2: Instalar y acceder a WebDriver

Podemos crear una nueva instancia del controlador Edge ejecutando el siguiente código:

driver = webdriver.Edge()Paso 3: acceda al sitio web a través de Python

A continuación, debemos acceder al sitio web del motor de búsqueda. En este caso, usaremos Bing.

driver.get("https://www.bing.com")Paso 4: Localice la información específica que está raspando

Queremos extraer el número de resultados de búsqueda para un nombre en particular. Podemos hacer esto ubicando el elemento HTML que contiene el número de resultados de búsqueda

results = driver.find_elements(By.XPATH, "//*[@id='b_tween']/span")Paso 5: Háganlo juntos

Ahora que tenemos todas las piezas, podemos combinarlas para extraer los resultados de búsqueda de un nombre en particular.

try:

search_box = driver.find_element(By.NAME, "q")

search_box.clear()

search_box.send_keys("John Doe") # enter your name in the search box

search_box.submit() # submit the search

results = driver.find_elements(By.XPATH, "//*[@id='b_tween']/span")

for result in results:

text = result.text.split()[1] # extract the number of results

print(text)

# save it to a file

with open("results.txt", "w") as f:

f.write(text)

except Exception as e:

print(f"An error occurred: {e}")Paso 6: almacenar los datos

Finalmente, podemos almacenar los datos extraídos en un archivo de texto.

con abierto(“resultados.txt”, “w”) como f:

f.write(text)Usando un proxy con Selenium Wire

Selenium Wire es una biblioteca que amplía la funcionalidad de Selenium al permitirle inspeccionar y modificar solicitudes y respuestas HTTP. Por ejemplo, también se puede usar para configurar un proxy para su Selenium WebDriver fácilmente

Instalar cable de selenio

pip install selenium-wireConfigurar el proxy

from selenium import webdriver

from Selenium.webdriver.chrome.options import Options

from seleniumwire import webdriver as wiredriver

PROXY_HOST = 'your.proxy.host'

PROXY_PORT = 'your_proxy_port'

chrome_options = Options()

chrome_options.add_argument('--proxy-server=http://{}:{}'.format(PROXY_HOST, PROXY_PORT))

driver = wiredriver.Chrome(options=chrome_options)Utilice Selenium Wire para inspeccionar y modificar solicitudes.

for request in driver.requests:

if request.response:

print(request.url, request.response.status_code, request.response.headers['Content-Type'])En el código anterior, repasamos todas las solicitudes realizadas por WebDriver durante la sesión de web scraping. Para cada solicitud, verificamos si se recibió una respuesta e imprimimos la URL, el código de estado y el tipo de contenido de la respuesta.

Usando Selenium para extraer todos los títulos de una página web

Aquí hay un ejemplo de código de Python que usa Selenium para raspar todos los títulos de una página web:

from selenium import webdriver

# Initialize the webdriver

driver = webdriver.Chrome()

# Navigate to the webpage

driver.get("https://www.example.com")

# Find all the title elements on the page

title_elements = driver.find_elements_by_tag_name("title")

# Extract the text from each title element

titles = [title.text for title in title_elements]

# Print the list of titles

print(titles)

# Close the webdriver

driver.quit()En este ejemplo, primero importamos el módulo del controlador web de Selenium, luego inicializamos una nueva instancia del controlador web de Chrome. Navegamos a la página web que queremos raspar y luego usamos el método find_elements_by_tag_name para encontrar todos los elementos de título en la página.

Luego usamos una lista de comprensión para extraer el texto de cada elemento del título y almacenar la lista resultante de títulos en una variable llamada títulos. Finalmente, imprimimos la lista de títulos y cerramos la instancia del controlador web.

Tenga en cuenta que deberá tener los paquetes de controladores web de Selenium y Chrome instalados en su entorno de Python para que este código funcione. Puedes instalarlos usando pip, así:

pip install selenium chromedriver-binaryAdemás, asegúrese de actualizar la URL en el controlador. obtenga un método para apuntar a la página web que desea raspar.

Conclusión

En conclusión, el web scraping con Selenium es una poderosa herramienta para extraer datos de sitios web. Le permite automatizar el proceso de recopilación de datos y puede ahorrarle mucho tiempo y esfuerzo. Con Selenium, puede interactuar con sitios web como un usuario humano y extraer los datos que necesita de manera más eficiente.

Alternativamente, puede usar herramientas sin código como las de Nanonets. herramienta de raspado de sitios web para extraer fácilmente todos los elementos de texto de HTML. Es de uso gratuito por completo.

Extraiga texto de cualquier página web con un solo clic. Dirígete a Nanonets raspador de sitios web, agregue la URL y haga clic en "Raspar" y descargue el texto de la página web como un archivo al instante. Pruébelo gratis ahora.

Preguntas más frecuentes:

¿Es Selenium mejor que BeautifulSoup?

Selenium y BeautifulSoup son herramientas que sirven para diferentes propósitos en el web scraping. Mientras que Selenium se usa principalmente para automatizar navegadores web, BeautifulSoup es una biblioteca de Python para analizar documentos HTML y XML.

Selenium es mejor que BeautifulSoup cuando se trata de raspar páginas web dinámicas. Las páginas web dinámicas se crean utilizando JavaScript u otros lenguajes de secuencias de comandos. Estas páginas a menudo contienen elementos que no son visibles hasta que la página está completamente cargada o hasta que el usuario interactúa con ellos. Selenium puede interactuar con estos elementos, lo que lo convierte en una poderosa herramienta para extraer datos de páginas web dinámicas.

Por otro lado, BeautifulSoup es mejor que Selenium cuando analiza documentos HTML y XML. BeautifulSoup proporciona una interfaz simple e intuitiva para analizar documentos HTML y XML y extraer los datos que necesita. Es una biblioteca liviana que no requiere un navegador web, lo que la hace más rápida y eficiente que Selenium en algunos casos.

En resumen, si Selenium es mejor que BeautifulSoup depende de la tarea. Si necesita extraer datos de páginas web dinámicas, Selenium es la mejor opción. Sin embargo, si necesita analizar documentos HTML y XML, BeautifulSoup es la mejor opción.

¿Debo usar Selenium o Scrapy?

Selenium se usa principalmente para automatizar navegadores web y es más adecuado para extraer datos de páginas web dinámicas. Si necesita interactuar con páginas web que contienen elementos que no son visibles hasta que la página está completamente cargada o hasta que el usuario interactúa con ellos, entonces Selenium es la mejor opción. Selenium también puede interactuar con páginas web que requieren autenticación u otros formularios de entrada del usuario.

Scrapy, por otro lado, es un marco de web scraping basado en Python diseñado para eliminar datos de sitios web estructurados. Es una herramienta potente y flexible que proporciona muchas funciones para rastrear y raspar sitios web. Se puede usar para raspar datos de varias páginas o sitios web y manejar tareas complejas de raspado, como seguir enlaces y lidiar con la paginación. Scrapy también es más eficiente que Selenium con respecto a la memoria y los recursos de procesamiento, lo que lo convierte en una mejor opción para proyectos de web scraping a gran escala.

Si debe usar Selenium o Scrapy depende de los requisitos específicos de su proyecto de web scraping. Si necesita extraer datos de páginas web dinámicas o interactuar con páginas web que requieren autenticación u otra entrada del usuario, entonces Selenium es la mejor opción. Sin embargo, si necesita extraer datos de sitios web estructurados o realizar tareas de extracción complejas, entonces Scrapy es la mejor opción.

¿Qué idioma es mejor para web scraping?

Python es uno de los lenguajes más populares para el web scraping debido a su facilidad de uso, una gran selección de bibliotecas y potentes marcos de scraping como Scrapy, Requests, beautifulSoup y Selenium. Python también es fácil de aprender y usar, lo que lo convierte en una excelente opción para principiantes.

Se pueden usar muchos lenguajes de programación para web scraping, pero algunos son más adecuados para la tarea que otros. El mejor lenguaje para web scraping depende de varios factores, como la complejidad de la tarea, el sitio web de destino y sus preferencias personales.

También se pueden usar otros lenguajes, como R, JavaScript y PHP, según los requisitos específicos de su proyecto de web scraping.

¿Por qué es importante Selenium en el web scraping?

Selenium es una herramienta importante en web scraping por varias razones:

Scraping de páginas web dinámicas: muchos sitios web hoy en día usan contenido dinámico e interacciones de usuarios para mostrar datos. Esto significa que una gran cantidad de contenido en el sitio web se carga a través de JavaScript o AJAX. Selenium es muy eficaz para raspar estos sitios web dinámicos porque puede interactuar con elementos de la página y simular las interacciones del usuario, como desplazarse y hacer clic. Esto facilita la extracción de datos de sitios web que dependen en gran medida del contenido dinámico. Es más adecuado para el manejo de cookies y sesiones, pruebas automatizadas, compatibilidad entre navegadores y escalabilidad:

¿Puedes usar Selenium y BeautifulSoup juntos?

Sí, puedes usarlos juntos. Selenium interactúa principalmente con páginas web y simula las interacciones del usuario, como hacer clic, desplazarse y completar formularios. Por otro lado, BeautifulSoup es una biblioteca de Python que se utiliza para analizar documentos HTML y XML y extraer datos de ellos. Al combinar Selenium y BeautifulSoup, puede crear una poderosa herramienta de web scraping para interactuar con páginas web y extraer datos de ellas. Selenium puede manejar contenido dinámico e interacciones de usuarios, mientras que BeautifulSoup puede analizar HTML y extraer datos de la fuente de la página.

Sin embargo, vale la pena señalar que usar ambas herramientas juntas puede requerir más recursos y ser más lento que solo una. Por lo tanto, es esencial evaluar los requisitos de su proyecto de web scraping y elegir las herramientas adecuadas para el trabajo.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://nanonets.com/blog/web-scraping-with-selenium/