Imagen del autor

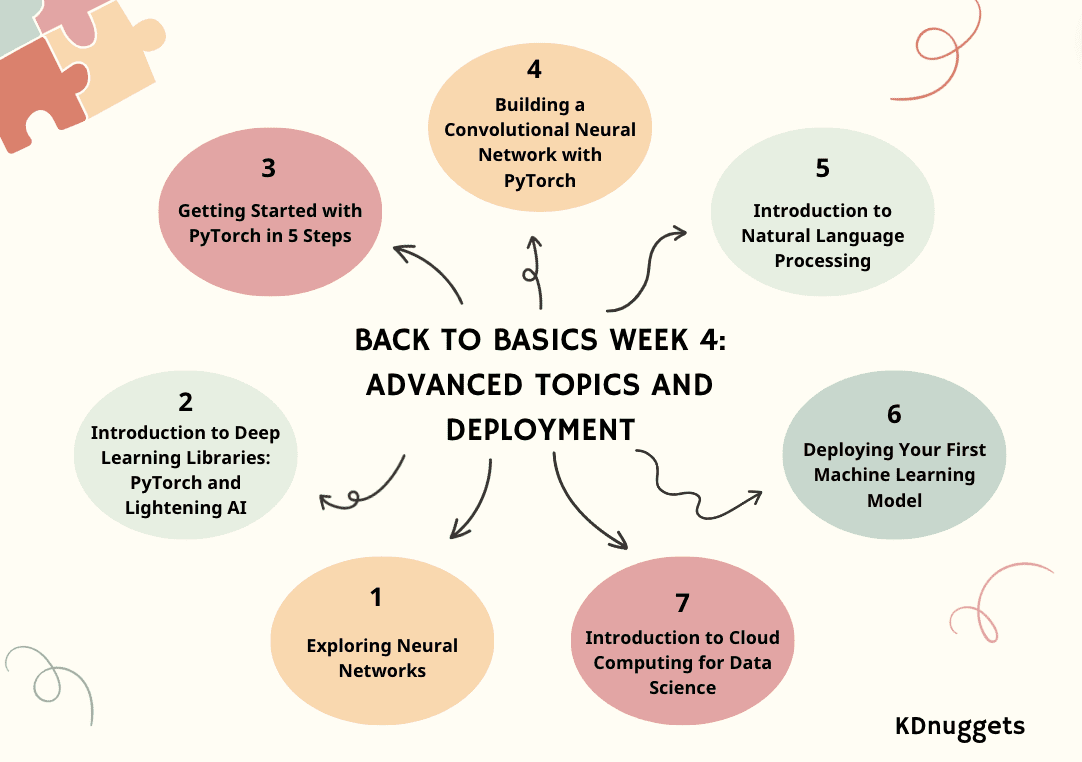

Únase a KDnuggets con nuestro camino de regreso a lo básico para comenzar una nueva carrera o repasar sus habilidades en ciencia de datos. El camino de Regreso a lo Básico se divide en 4 semanas con una semana extra. Esperamos que pueda utilizar estos blogs como guía del curso.

Si aún no lo has hecho, echa un vistazo a:

Pasando a la tercera semana, profundizaremos en temas avanzados e implementación.

- Día 1: Explorando las redes neuronales

- Día 2: Introducción a las bibliotecas de aprendizaje profundo: PyTorch y Lightening AI

- Día 3: Introducción a PyTorch en 5 pasos

- Día 4: Construcción de una red neuronal convolucional con PyTorch

- Día 5: Introducción al procesamiento del lenguaje natural

- Día 6: Implementación de su primer modelo de aprendizaje automático

- Día 7: Introducción a la computación en la nube para la ciencia de datos

Semana 4 – Parte 1: Explorando redes neuronales

Liberando el poder de la IA: una guía para las redes neuronales y sus aplicaciones.

Imagine una máquina que piensa, aprende y se adapta como el cerebro humano y descubre patrones ocultos dentro de los datos.

Los algoritmos de esta tecnología, redes neuronales (NN), están imitando la cognición. Exploraremos qué son las NN y cómo funcionan más adelante.

En este artículo, le explicaré los aspectos fundamentales de las redes neuronales (NN): estructura, tipos, aplicaciones de la vida real y términos clave que definen su funcionamiento.

Semana 4 – Parte 2: Introducción a las bibliotecas de aprendizaje profundo: PyTorch y Lightning AI

Una explicación sencilla de PyTorch y Lightning AI.

El aprendizaje profundo es una rama del modelo de aprendizaje automático basado en redes neuronales. En el otro modelo de máquina, el procesamiento de datos para encontrar características significativas a menudo se realiza manualmente o depende de la experiencia en el campo; sin embargo, el aprendizaje profundo puede imitar el cerebro humano para descubrir las características esenciales, aumentando el rendimiento del modelo.

Existen muchas aplicaciones para modelos de aprendizaje profundo, incluido el reconocimiento facial, la detección de fraude, la conversión de voz a texto, la generación de texto y muchas más. El aprendizaje profundo se ha convertido en un enfoque estándar en muchas aplicaciones avanzadas de aprendizaje automático y no tenemos nada que perder aprendiendo sobre ellas.

Para desarrollar este modelo de aprendizaje profundo, existen varios marcos de biblioteca en los que podemos confiar en lugar de trabajar desde cero. En este artículo, analizaremos dos bibliotecas diferentes que podemos utilizar para desarrollar modelos de aprendizaje profundo: PyTorch y Lighting AI.

Semana 4 – Parte 3: Comenzando con PyTorch en 5 pasos

Este tutorial proporciona una introducción detallada al aprendizaje automático utilizando PyTorch y su contenedor de alto nivel, PyTorch Lightning. El artículo cubre pasos esenciales desde la instalación hasta temas avanzados, ofrece un enfoque práctico para construir y entrenar redes neuronales y enfatiza los beneficios de usar Lightning.

PyTorch es un popular marco de aprendizaje automático de código abierto basado en Python y optimizado para la computación acelerada por GPU. Desarrollado originalmente por Meta AI en 2016 y ahora parte de la Fundación Linux, PyTorch se ha convertido rápidamente en uno de los marcos más utilizados para la investigación y las aplicaciones de aprendizaje profundo.

Rayo PyTorch es un contenedor liviano construido sobre PyTorch que simplifica aún más el proceso de flujo de trabajo del investigador y desarrollo de modelos. Con Lightning, los científicos de datos pueden centrarse más en diseñar modelos que en código repetitivo.

Semana 4 – Parte 4: Construyendo una red neuronal convolucional con PyTorch

Esta publicación de blog proporciona un tutorial sobre la construcción de una red neuronal convolucional para la clasificación de imágenes en PyTorch, aprovechando capas convolucionales y de agrupación para la extracción de características, así como capas completamente conectadas para la predicción.

Una red neuronal convolucional (CNN o ConvNet) es un algoritmo de aprendizaje profundo diseñado específicamente para tareas en las que el reconocimiento de objetos es crucial, como clasificación, detección y segmentación de imágenes. Las CNN pueden lograr una precisión de vanguardia en tareas de visión complejas, lo que impulsa muchas aplicaciones de la vida real, como sistemas de vigilancia, gestión de almacenes y más.

Como humanos, podemos reconocer fácilmente objetos en imágenes analizando patrones, formas y colores. Las CNN también pueden entrenarse para realizar este reconocimiento, aprendiendo qué patrones son importantes para la diferenciación. Por ejemplo, cuando intentamos distinguir entre una foto de un gato y una de un perro, nuestro cerebro se centra en formas, texturas y rasgos faciales únicos. Una CNN aprende a captar estos mismos tipos de características distintivas. Incluso para tareas de categorización muy detalladas, las CNN pueden aprender representaciones de características complejas directamente a partir de píxeles.

Semana 4 – Parte 5: Introducción al procesamiento del lenguaje natural

Una descripción general del procesamiento del lenguaje natural (PLN) y sus aplicaciones.

Estamos aprendiendo mucho sobre ChatGPT y los modelos de lenguajes grandes (LLM). El procesamiento del lenguaje natural ha sido un tema interesante, un tema que actualmente está arrasando en el mundo de la tecnología y la inteligencia artificial. Sí, los LLM como ChatGPT han ayudado a su crecimiento, pero ¿no sería bueno entender de dónde viene todo? Así que volvamos a lo básico: la PNL.

La PNL es un subcampo de la inteligencia artificial y es la capacidad de una computadora para detectar y comprender el lenguaje humano, a través del habla y el texto, tal como lo hacemos los humanos. La PNL ayuda a los modelos a procesar, comprender y generar el lenguaje humano.

El objetivo de la PNL es cerrar la brecha de comunicación entre humanos y computadoras. Los modelos de PNL generalmente se entrenan en tareas como la predicción de la siguiente palabra, lo que les permite construir dependencias contextuales y luego generar resultados relevantes.

Semana 4 – Parte 6: Implementación de su primer modelo de aprendizaje automático

Con solo 3 sencillos pasos, puede crear e implementar un modelo de clasificación de vidrio más rápido de lo que puede decir... ¡modelo de clasificación de vidrio!

En este tutorial, aprenderemos cómo construir un modelo simple de clasificación múltiple usando el Clasificación de vidrio conjunto de datos. Nuestro objetivo es desarrollar e implementar una aplicación web que pueda predecir varios tipos de vidrio, tales como:

- Ventanas de construcción flotantes procesadas.

- Construcción de ventanas no flotantes procesadas.

- Flotación de ventanas de vehículos procesadas

- Ventanas de vehículos no flotantes procesadas (faltan en el conjunto de datos)

- Contenedores

- Vajilla

- Los faros

Además, aprenderemos sobre:

- Skops: comparta sus modelos basados en scikit-learn y póngalos en producción.

- Gradio: marco de aplicaciones web de ML.

- HuggingFace Spaces: modelo gratuito de aprendizaje automático y plataforma de alojamiento de aplicaciones.

Al final de este tutorial, tendrá experiencia práctica en la creación, capacitación e implementación de un modelo básico de aprendizaje automático como una aplicación web.

Semana 4 – Parte 7: Introducción a la computación en la nube para la ciencia de datos

Y el Power Duo de la tecnología moderna.

En el mundo actual, han surgido dos fuerzas principales que están cambiando las reglas del juego: la ciencia de datos y la computación en la nube.

Imagine un mundo donde cada segundo se generan cantidades colosales de datos. Bueno… no tienes que imaginarlo… ¡Es nuestro mundo!

Desde las interacciones en las redes sociales hasta las transacciones financieras, desde los registros sanitarios hasta las preferencias del comercio electrónico, los datos están en todas partes.

Pero, ¿de qué sirven estos datos si no podemos obtener valor? Eso es exactamente lo que hace la ciencia de datos.

¿Y dónde almacenamos, procesamos y analizamos estos datos? Ahí es donde brilla la computación en la nube.

Embárcate en un viaje para comprender la relación entrelazada entre estas dos maravillas tecnológicas. ¡Intentemos) descubrirlo todos juntos!

¡¡Felicitaciones por completar la semana 4!!

El equipo de KDnuggets espera que el camino de Regreso a lo básico haya brindado a los lectores un enfoque integral y estructurado para dominar los fundamentos de la ciencia de datos.

La semana de bonificación se publicará la próxima semana el lunes. ¡Estén atentos!

nisha aria es científico de datos y escritor técnico independiente. Ella está particularmente interesada en proporcionar consejos o tutoriales sobre la carrera de Data Science y conocimiento basado en la teoría sobre Data Science. También desea explorar las diferentes formas en que la Inteligencia Artificial es o puede beneficiar la longevidad de la vida humana. Una estudiante entusiasta que busca ampliar sus conocimientos tecnológicos y sus habilidades de escritura, mientras ayuda a guiar a otros.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.kdnuggets.com/back-to-basics-week-4-advanced-topics-and-deployment?utm_source=rss&utm_medium=rss&utm_campaign=back-to-basics-week-4-advanced-topics-and-deployment