Conozca Mixtral 8x7B de Mistral AI. Es muy inteligente para manejar big data y puede ayudar con tareas como traducir idiomas y generar código. Los desarrolladores de todo el mundo están entusiasmados con su potencial para optimizar sus proyectos y mejorar la eficiencia. Con su diseño fácil de usar y capacidades impresionantes, Mixtral 8x7B se está convirtiendo rápidamente en una herramienta de referencia para el desarrollo de IA.

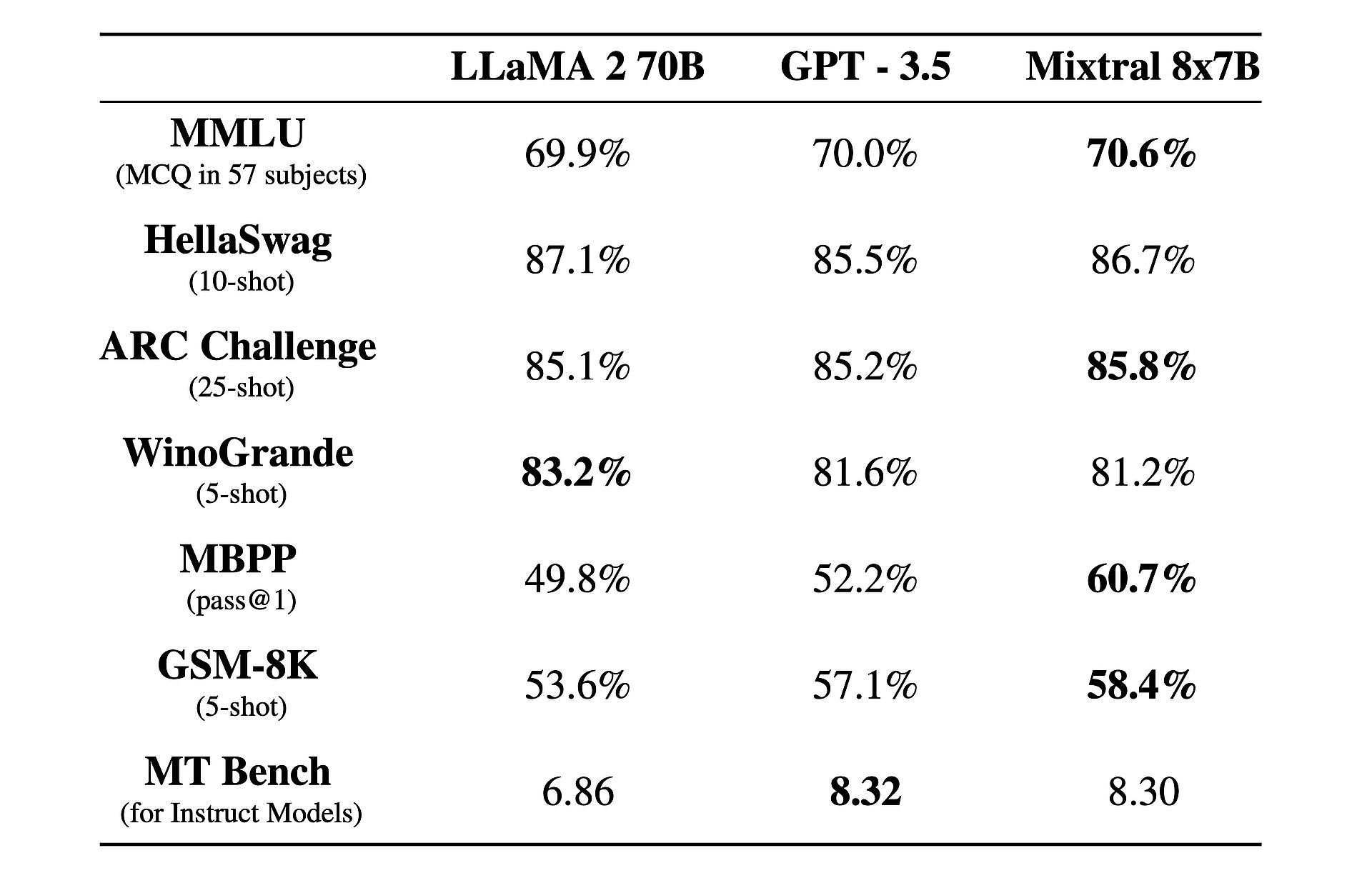

Además, hay un hecho interesante al respecto: está funcionando mejor que GPT-3.5 y llamas 2!

¿Qué es Mixtral 8x7B?

Mixtral 8x7B es un modelo avanzado de inteligencia artificial desarrollado por Mistral AI. Utiliza una arquitectura única llamada mezcla dispersa de expertos (SMoE) para procesar grandes cantidades de datos de manera eficiente. A pesar de su complejidad, Mixtral está diseñado para ser fácil de usar y adaptable para diversas tareas como traducción de idiomas y generación de código. Supera a otros modelos en términos de velocidad y precisión, lo que la convierte en una herramienta valiosa para los desarrolladores. Además, está disponible bajo la licencia Apache 2.0, lo que permite que cualquiera pueda usarlo y modificarlo libremente.

¿Quieres aprender más? En esencia, Mixtral 8x7B funciona como un modelo solo decodificador, aprovechando un enfoque único en el que un bloque de avance selecciona entre ocho grupos distintos de parámetros, denominados "expertos". Estos expertos son elegidos dinámicamente por una red de enrutadores para procesar cada token, mejorando la eficiencia y el rendimiento y minimizando la sobrecarga computacional.

Una de las fortalezas clave de Mixtral radica en su adaptabilidad y escalabilidad. Capaz puede manejar contextos de hasta 32,000 tokens y admitir varios idiomas, incluidos inglés, francés, italiano, alemán y español. Mixtral permite a los desarrolladores abordar una amplia gama de tareas con facilidad y precisión.

Lo que realmente distingue a Mixtral es su relación rendimiento-costo. Con un asombroso total de 46.7 mil millones de parámetros, Mixtral logra una eficiencia notable al utilizar solo una fracción de estos parámetros por token, lo que resulta en tiempos de inferencia más rápidos y costos computacionales reducidos.

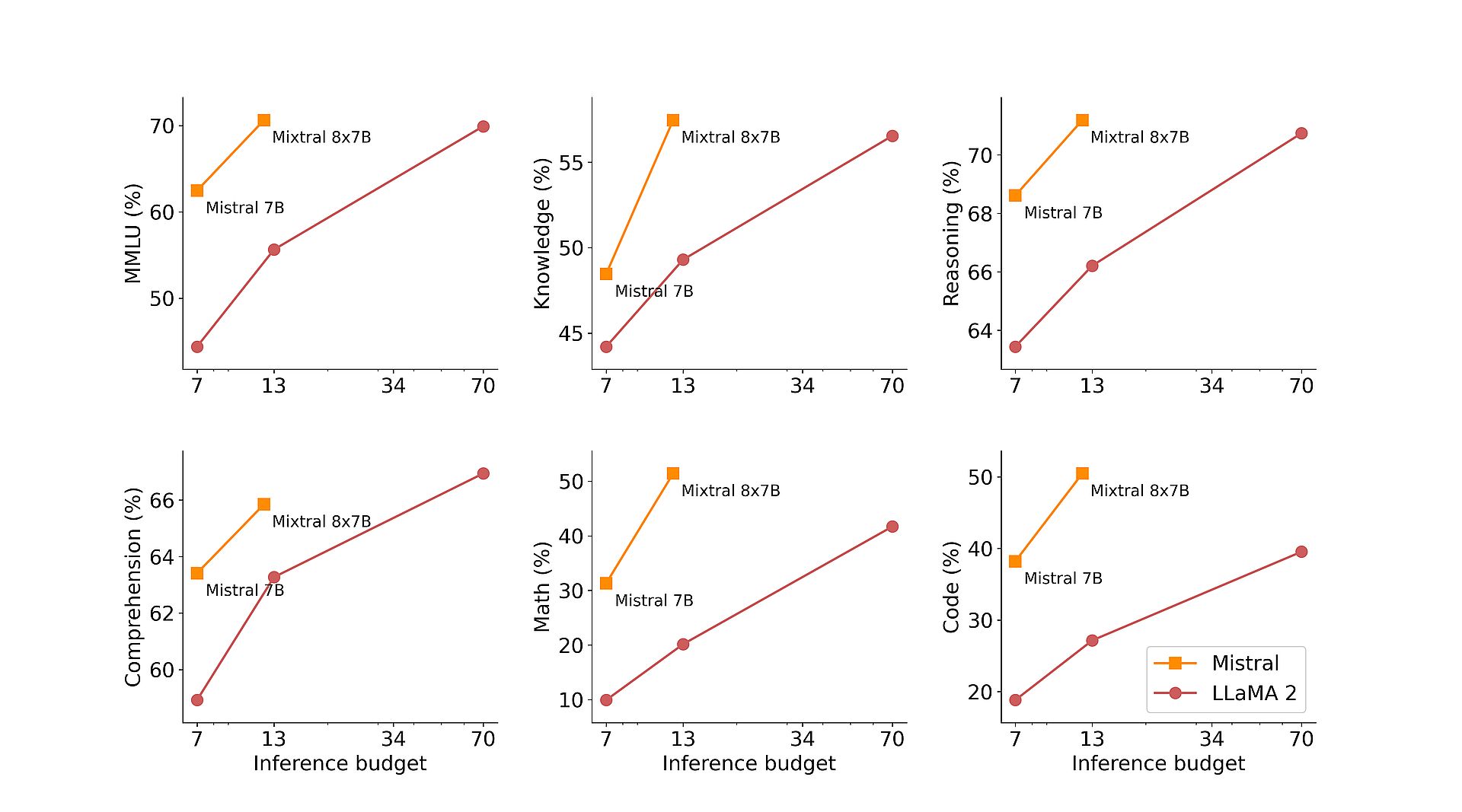

Además, la capacitación previa de Mixtral sobre extensos conjuntos de datos extraídos de la web abierta garantiza solidez y versatilidad en aplicaciones del mundo real. Ya sea generación de código, traducción de idiomas o análisis de sentimientos, Mixtral ofrece resultados sobresalientes en varios puntos de referencia, superando modelos tradicionales como Llama 2 e incluso superando a GPT3.5 en muchos casos.

Para mejorar aún más sus capacidades, Mistral AI ha presentado Mixtral 8x7B Instruct, una variante especializada optimizada para tareas de seguimiento de instrucciones. Al lograr una impresionante puntuación de 8.30 en MT-Bench, Mixtral 8x7B Instruct consolida su posición como modelo líder de código abierto para el ajuste fino supervisado y la optimización de preferencias.

Además de su destreza técnica, Mistral AI se compromete a democratizar el acceso a Mixtral contribuyendo al proyecto vLLM, permitiendo una integración e implementación perfectas con herramientas de código abierto. Esto permite a los desarrolladores aprovechar el poder de Mixtral en una amplia gama de aplicaciones y plataformas, impulsando la innovación y el avance en el campo de la inteligencia artificial.

Groq IA, no Grok, asa a Elon Musk con su “LLM más rápido”

Cómo utilizar Mixtral 8x7B

Se puede acceder a Mixtral 8x7B a través del punto final de Mistral, mistral-small, que se encuentra en el fases de prueba betami. Si está interesado en obtener acceso temprano a todos los puntos finales generativos e integrados de Mistral, puede registrarte ahora. Al registrarse, estará entre los primeros en experimentar todas las capacidades de Mixtral 8x7B y explorar sus soluciones innovadoras.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://dataconomy.com/2024/02/21/mistral-ai-mixtral-8x7b/