La ingeniería de datos desempeña un papel fundamental en el vasto ecosistema de datos al recopilar, transformar y entregar datos esenciales para análisis, informes y aprendizaje automático. Los aspirantes a ingenieros de datos a menudo buscan proyectos del mundo real para adquirir experiencia práctica y mostrar sus conocimientos. Este artículo presenta las 20 principales ideas de proyectos de ingeniería de datos con su código fuente. Ya sea principiante, ingeniero de nivel intermedio o profesional avanzado, estos proyectos ofrecen una excelente oportunidad para perfeccionar sus habilidades de ingeniería de datos.

Tabla de contenidos.

Proyectos de ingeniería de datos para principiantes

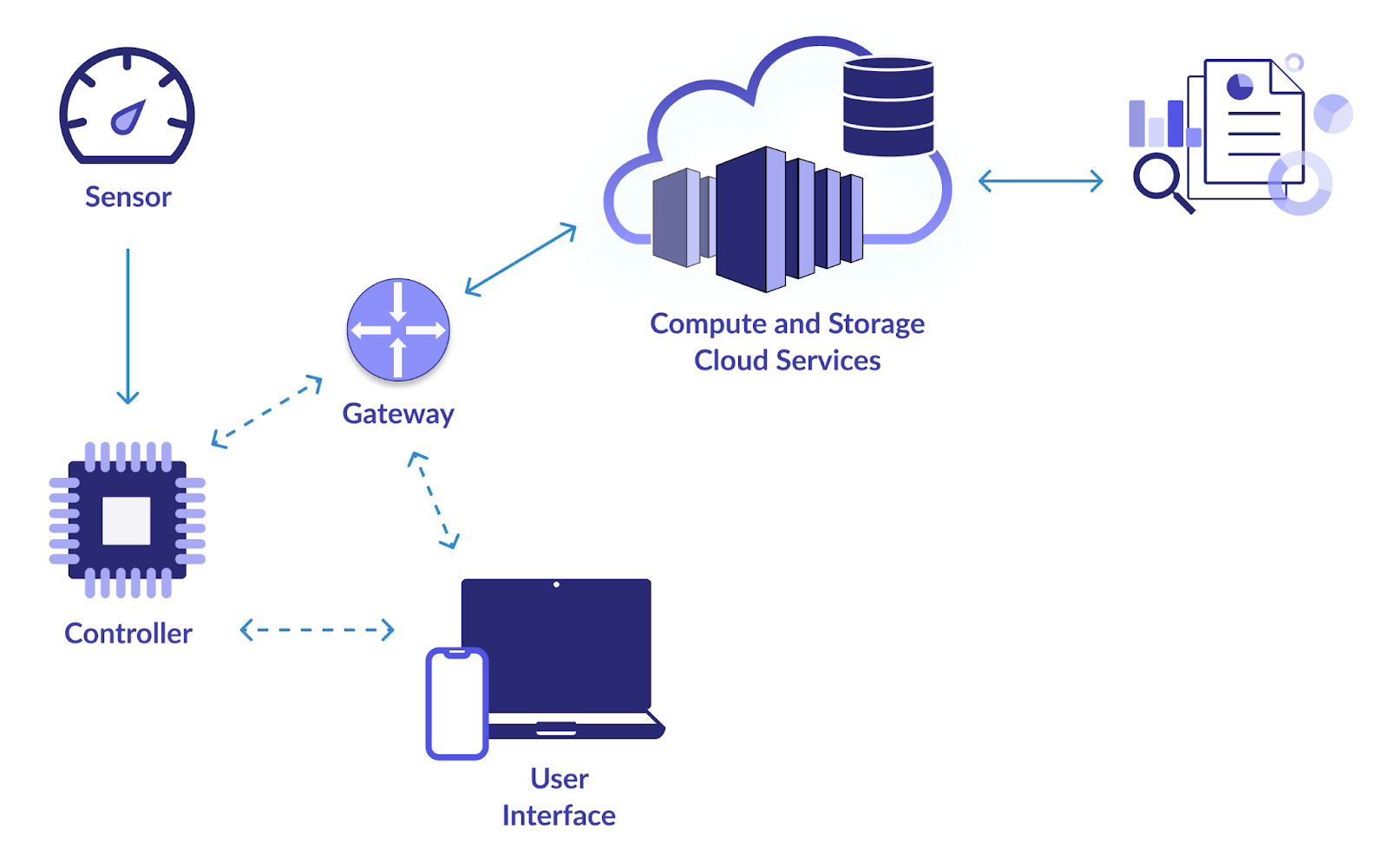

1. Infraestructura inteligente de IoT

Objetivo

El objetivo principal de este proyecto es establecer un canal de datos confiable para recopilar y analizar datos de dispositivos IoT (Internet de las cosas). Las cámaras web, los sensores de temperatura, los detectores de movimiento y otros dispositivos de IoT generan una gran cantidad de datos. Quiere diseñar un sistema para consumir, almacenar, procesar y analizar estos datos de forma eficaz. Al hacer esto, es posible el monitoreo en tiempo real y la toma de decisiones basadas en el aprendizaje de los datos de IoT.

¿Cómo resolver?

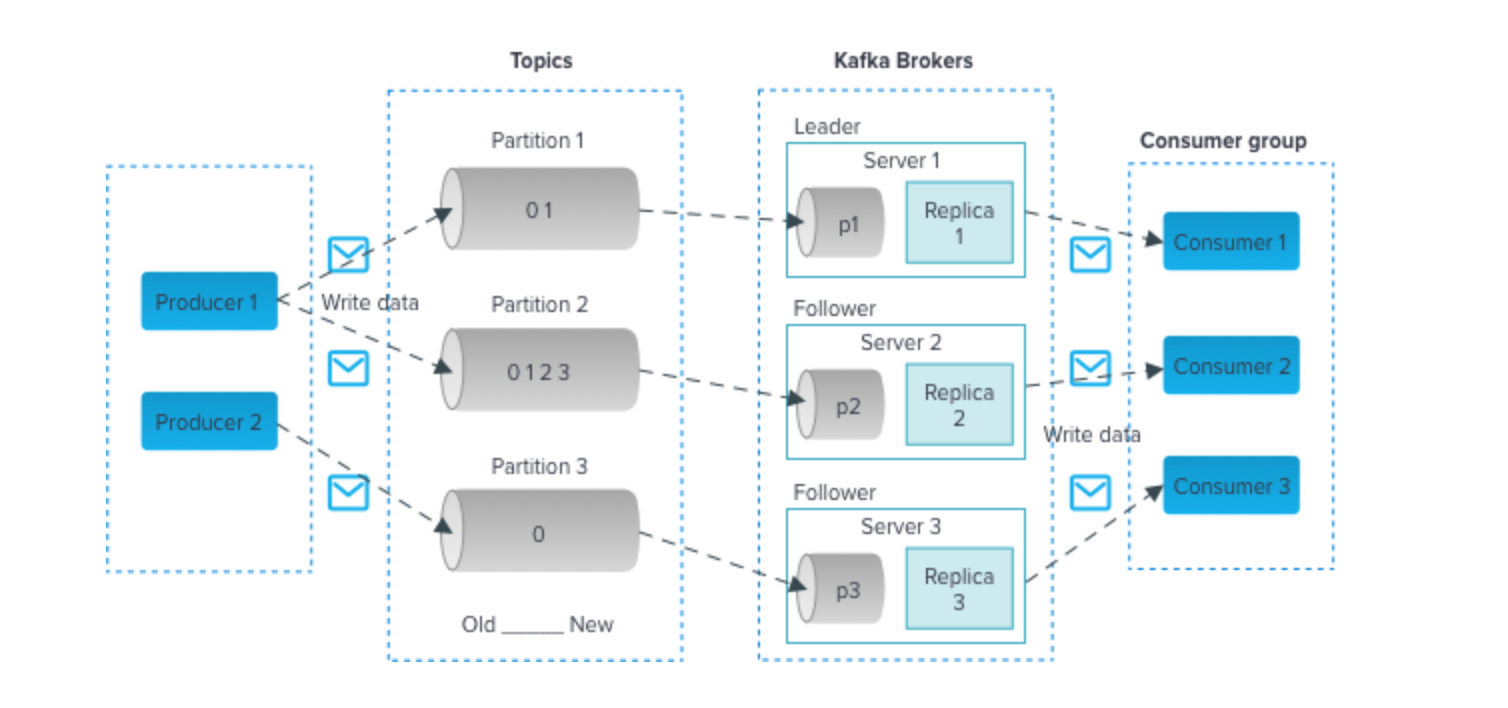

- Utilice tecnologías como Apache Kafka o MQTT para una ingesta eficiente de datos desde dispositivos IoT. Estas tecnologías admiten flujos de datos de alto rendimiento.

- Emplee bases de datos escalables como Apache Cassandra o MongoDB para almacenar los datos entrantes de IoT. Estas bases de datos NoSQL pueden manejar el volumen y la variedad de datos de IoT.

- Implemente el procesamiento de datos en tiempo real utilizando Apache Spark Streaming o Apache Flink. Estos marcos le permiten analizar y transformar los datos a medida que llegan, lo que los hace adecuados para el monitoreo en tiempo real.

- Utilice herramientas de visualización como Grafana o Kibana para crear paneles que brinden información sobre los datos de IoT. Las visualizaciones en tiempo real pueden ayudar a las partes interesadas a tomar decisiones informadas.

Haga clic aquí para consultar el código fuente

2. Análisis de datos de aviación

Objetivo

Para recopilar, procesar y analizar datos de aviación de numerosas fuentes, incluida la Administración Federal de Aviación (FAA), aerolíneas y aeropuertos, este proyecto intenta desarrollar un canal de datos. Los datos de aviación incluyen vuelos, aeropuertos, clima y datos demográficos de los pasajeros. Su objetivo es extraer información significativa de estos datos para mejorar la programación de vuelos, mejorar las medidas de seguridad y optimizar diversos aspectos de la industria de la aviación.

¿Cómo resolver?

- Apache Nifi o AWS Kinesis se pueden utilizar para la ingesta de datos de diversas fuentes.

- Almacene los datos procesados en almacenes de datos como Amazon Redshift o Google BigQuery para realizar consultas y análisis eficientes.

- Emplee Python con bibliotecas como Pandas y Matplotlib para analizar datos de aviación en profundidad. Esto puede implicar identificar patrones en retrasos de vuelos, optimizar rutas y evaluar las tendencias de los pasajeros.

- Se pueden utilizar herramientas como Tableau o Power BI para crear visualizaciones informativas que ayuden a las partes interesadas a tomar decisiones basadas en datos en el sector de la aviación.

Haga clic aquí para ver el código fuente

3. Previsión de la demanda de envío y distribución

Objetivo

En este proyecto, su objetivo es crear una canalización ETL (Extracción, Transformación, Carga) sólida que procese datos de envío y distribución. Al utilizar datos históricos, creará un sistema de pronóstico de la demanda que predice la demanda futura de productos en el contexto del envío y la distribución. Esto es crucial para optimizar la gestión de inventario, reducir los costos operativos y garantizar entregas oportunas.

¿Cómo resolver?

- Se puede utilizar Apache NiFi o Talend para construir el canal ETL, que extraerá datos de varias fuentes, los transformará y los cargará en una solución de almacenamiento de datos adecuada.

- Utilice herramientas como Python o Apache Spark para tareas de transformación de datos. Es posible que necesite limpiar, agregar y preprocesar datos para que sean adecuados para los modelos de pronóstico.

- Implemente modelos de pronóstico como ARIMA (Promedio Móvil Integrado AutoRegresivo) o Prophet para predecir la demanda con precisión.

- Almacene los datos limpios y transformados en bases de datos como PostgreSQL o MySQL.

Haga clic aquí para ver el código fuente de este proyecto de ingeniería de datos.

4. Análisis de datos de eventos

Objetivo

Cree un canal de datos que recopile información de diversos eventos, incluidas conferencias, eventos deportivos, conciertos y reuniones sociales. El procesamiento de datos en tiempo real, el análisis de sentimientos de las publicaciones en las redes sociales sobre estos eventos y la creación de visualizaciones para mostrar tendencias e información en tiempo real son parte del proyecto.

¿Cómo resolver?

- Dependiendo de las fuentes de datos del evento, puede utilizar la API de Twitter para recopilar tweets, web scraping para sitios web relacionados con eventos u otros métodos de ingesta de datos.

- Emplee técnicas de procesamiento del lenguaje natural (NLP) en Python para realizar análisis de sentimientos en publicaciones de redes sociales. Herramientas como NLTK o spaCy pueden resultar valiosas.

- Utilice tecnologías de transmisión como Apache Kafka o Apache Flink para el procesamiento y análisis de datos en tiempo real.

- Cree paneles y visualizaciones interactivos utilizando marcos como Dash o Plotly para presentar información relacionada con eventos en un formato fácil de usar.

Haga clic aquí para consultar el código fuente.

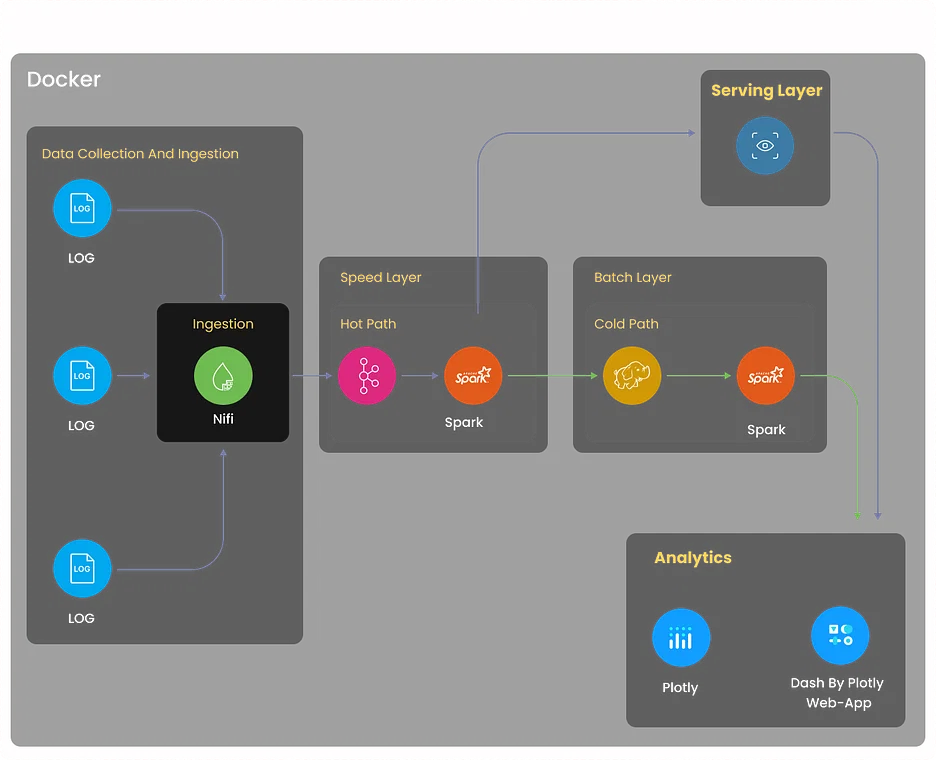

5. Proyecto de análisis de registros

Objetivo

Cree un sistema integral de análisis de registros que recopile registros de diversas fuentes, incluidos servidores, aplicaciones y dispositivos de red. El sistema debe centralizar los datos de registro, detectar anomalías, facilitar la resolución de problemas y optimizar el rendimiento del sistema a través de información basada en registros.

¿Cómo resolver?

- Implemente la recopilación de registros utilizando herramientas como Logstash o Fluentd. Estas herramientas pueden agregar registros de diversas fuentes y normalizarlos para su posterior procesamiento.

- Utilice Elasticsearch, un potente motor de análisis y búsqueda distribuido, para almacenar e indexar datos de registro de manera eficiente.

- Emplee Kibana para crear paneles y visualizaciones que permitan a los usuarios monitorear los datos de registro en tiempo real.

- Configure mecanismos de alerta utilizando Elasticsearch Watcher o Grafana Alerts para notificar a las partes interesadas relevantes cuando se detecten anomalías o patrones de registro específicos.

Haga clic aquí para explorar este proyecto de ingeniería de datos

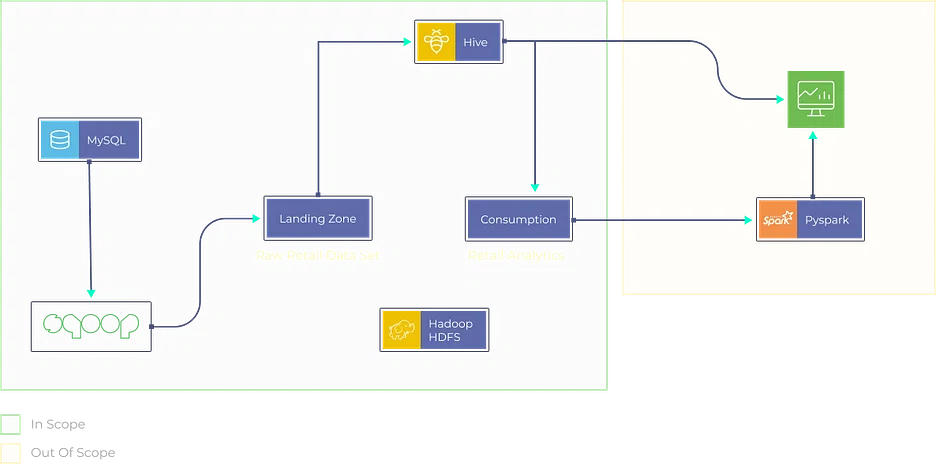

6. Análisis de datos de Movielens para recomendaciones

Objetivo

- Diseñe y desarrolle un motor de recomendaciones utilizando el conjunto de datos Movielens.

- Cree una canalización ETL sólida para preprocesar y limpiar los datos.

- Implemente algoritmos de filtrado colaborativo para proporcionar recomendaciones de películas personalizadas a los usuarios.

¿Cómo resolver?

- Aproveche Apache Spark o AWS Glue para crear una canalización ETL que extraiga datos de películas y usuarios, los transforme a un formato adecuado y los cargue en una solución de almacenamiento de datos.

- Implemente técnicas de filtrado colaborativo, como el filtrado colaborativo basado en usuarios o elementos, utilizando bibliotecas como Scikit-learn o TensorFlow.

- Almacene los datos limpios y transformados en soluciones de almacenamiento de datos como Amazon S3 o Hadoop HDFS.

- Desarrolle una aplicación basada en web (por ejemplo, usando Flask o Django) donde los usuarios puedan ingresar sus preferencias y el motor de recomendación proporcione recomendaciones de películas personalizadas.

Haga clic aquí para explorar este proyecto de ingeniería de datos.

7. Proyecto de análisis minorista

Objetivo

Cree una plataforma de análisis minorista que ingiera datos de diversas fuentes, incluidos sistemas de punto de venta, bases de datos de inventario e interacciones con los clientes. Analice tendencias de ventas, optimice la gestión de inventario y genere recomendaciones de productos personalizadas para los clientes.

¿Cómo resolver?

- Implemente procesos ETL utilizando herramientas como Apache Beam o AWS Data Pipeline para extraer, transformar y cargar datos de fuentes minoristas.

- Utilice algoritmos de aprendizaje automático como XGBoost o Random Forest para la predicción de ventas y la optimización del inventario.

- Almacene y administre datos en soluciones de almacenamiento de datos como Snowflake o Azure Synapse Analytics para realizar consultas eficientes.

- Cree paneles interactivos utilizando herramientas como Tableau o Looker para presentar información analítica del comercio minorista en un formato visualmente atractivo y comprensible.

Haga clic aquí para explorar el código fuente.

Proyectos de ingeniería de datos en GitHub

8. Análisis de datos en tiempo real

Objetivo

Contribuya a un proyecto de código abierto centrado en el análisis de datos en tiempo real. Este proyecto brinda la oportunidad de mejorar la velocidad de procesamiento de datos, la escalabilidad y las capacidades de visualización en tiempo real del proyecto. Es posible que se le asigne la tarea de mejorar el rendimiento de los componentes de transmisión de datos, optimizar el uso de recursos o agregar nuevas funciones para admitir casos de uso de análisis en tiempo real.

¿Cómo resolver?

El método de resolución dependerá del proyecto al que contribuya, pero a menudo involucra tecnologías como Apache Flink, Spark Streaming o Apache Storm.

Haga clic aquí para explorar el código fuente de este proyecto de ingeniería de datos.

9. Análisis de datos en tiempo real con Azure Stream Services

Objetivo

Explore Azure Stream Analytics contribuyendo o creando un proyecto de procesamiento de datos en tiempo real en Azure. Esto puede implicar la integración de servicios de Azure como Azure Functions y Power BI para obtener información y visualizar datos en tiempo real. Puede concentrarse en mejorar las capacidades de análisis en tiempo real y hacer que el proyecto sea más fácil de usar.

¿Cómo resolver?

- Describa claramente los objetivos y requisitos del proyecto, incluidas las fuentes de datos y los conocimientos deseados.

- Cree un entorno de Azure Stream Analytics, configure entradas/salidas e integre Azure Functions y Power BI.

- Ingiere datos en tiempo real y aplica las transformaciones necesarias mediante consultas similares a SQL.

- Implemente lógica personalizada para el procesamiento de datos en tiempo real mediante Azure Functions.

- Configure Power BI para la visualización de datos en tiempo real y garantice una experiencia fácil de usar.

Haga clic aquí para explorar el código fuente de este proyecto de ingeniería de datos.

10. Canalización de datos del mercado financiero en tiempo real con Finnhub API y Kafka

Objetivo

Cree un canal de datos que recopile y procese datos del mercado financiero en tiempo real utilizando la API Finnhub y Apache Kafka. Este proyecto implica analizar los precios de las acciones, realizar análisis de sentimiento sobre datos de noticias y visualizar tendencias del mercado en tiempo real. Las contribuciones pueden incluir la optimización de la ingesta de datos, la mejora del análisis de datos o la mejora de los componentes de visualización.

¿Cómo resolver?

- Describa claramente los objetivos del proyecto, que incluyen recopilar y procesar datos del mercado financiero en tiempo real y realizar análisis de acciones y análisis de sentimiento.

- Cree una canalización de datos utilizando Apache Kafka y la API de Finnhub para recopilar y procesar datos de mercado en tiempo real.

- Analice los precios de las acciones y realice análisis de sentimiento sobre los datos de noticias dentro del proceso.

- Visualice las tendencias del mercado en tiempo real y considere optimizaciones para la ingesta y el análisis de datos.

- Explore oportunidades para optimizar el procesamiento de datos, mejorar el análisis y mejorar los componentes de visualización a lo largo del proyecto.

Haga clic aquí para explorar el código fuente de este proyecto.

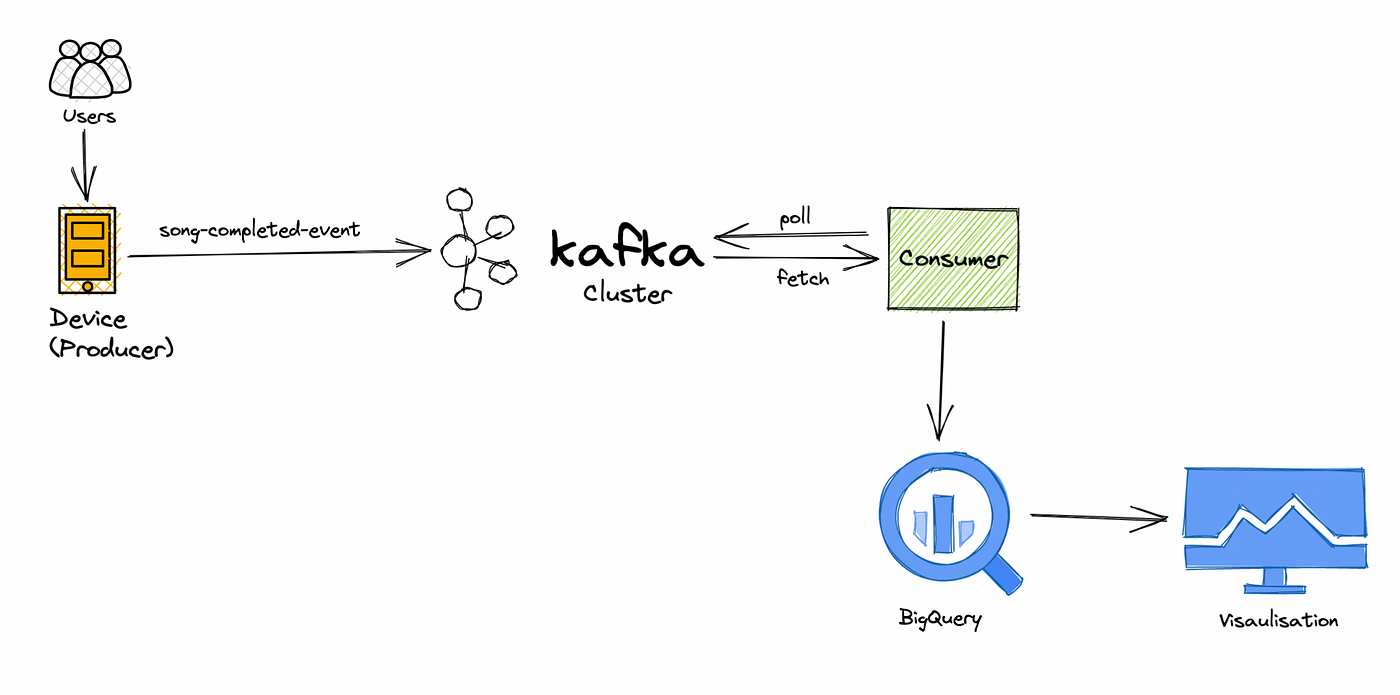

11. Canal de procesamiento de datos de aplicaciones musicales en tiempo real

Objetivo

Colabore en un proyecto de datos de transmisión de música en tiempo real centrado en procesar y analizar datos de comportamiento del usuario en tiempo real. Explorará las preferencias del usuario, realizará un seguimiento de la popularidad y mejorará el sistema de recomendación de música. Las contribuciones pueden incluir mejorar la eficiencia del procesamiento de datos, implementar algoritmos de recomendación avanzados o desarrollar paneles de control en tiempo real.

¿Cómo resolver?

- Defina claramente los objetivos del proyecto, centrándose en el análisis del comportamiento del usuario en tiempo real y la mejora de las recomendaciones musicales.

- Colabore en el procesamiento de datos en tiempo real para explorar las preferencias de los usuarios, realizar un seguimiento de la popularidad y perfeccionar el sistema de recomendaciones.

- Identificar e implementar mejoras de eficiencia dentro del proceso de procesamiento de datos.

- Desarrollar e integrar algoritmos de recomendación avanzados para mejorar el sistema.

- Cree paneles de control en tiempo real para monitorear y visualizar datos de comportamiento del usuario y considere mejoras continuas.

Haga clic aquí para explorar el código fuente.

Proyectos de ingeniería de datos avanzados para currículum

12. Monitoreo del sitio web

Objetivo

Desarrolle un sistema integral de monitoreo de sitios web que rastree el rendimiento, el tiempo de actividad y la experiencia del usuario. Este proyecto implica el uso de herramientas como Selenium para web scraping para recopilar datos de sitios web y crear mecanismos de alerta para notificaciones en tiempo real cuando se detectan problemas de rendimiento.

¿Cómo resolver?

- Defina los objetivos del proyecto, que incluyen la creación de un sistema de monitoreo de sitios web para rastrear el rendimiento y el tiempo de actividad, así como mejorar la experiencia del usuario.

- Utilice Selenium para web scraping para recopilar datos de sitios web de destino.

- Implemente mecanismos de alerta en tiempo real para notificar cuando se detecten problemas de rendimiento o tiempo de inactividad.

- Cree un sistema integral para realizar un seguimiento del rendimiento del sitio web, el tiempo de actividad y la experiencia del usuario.

- Planificar el mantenimiento continuo y la optimización del sistema de monitoreo para asegurar su efectividad en el tiempo.

Haga clic aquí para explorar el código fuente de este proyecto de ingeniería de datos.

13. Minería de Bitcoin

Objetivo

Sumérgete en el mundo de las criptomonedas creando un canal de datos de minería de Bitcoin. Analice patrones de transacciones, explore la red blockchain y obtenga información sobre el ecosistema de Bitcoin. Este proyecto requerirá la recopilación de datos de las API, análisis y visualización de blockchain.

¿Cómo resolver?

- Definir los objetivos del proyecto, centrándose en la creación de un canal de datos de minería de Bitcoin para el análisis de transacciones y la exploración de blockchain.

- Implementar mecanismos de recopilación de datos desde las API de blockchain para datos relacionados con la minería.

- Sumérjase en el análisis de blockchain para explorar patrones de transacciones y obtener información sobre el ecosistema de Bitcoin.

- Desarrolle componentes de visualización de datos para representar eficazmente los conocimientos de la red Bitcoin.

- Cree un canal de datos integral que abarque la recopilación, el análisis y la visualización de datos para obtener una visión holística de las actividades mineras de Bitcoin.

Haga clic aquí para explorar el código fuente de este proyecto de ingeniería de datos.

14. Proyecto GCP para explorar las funciones de la nube

Objetivo

Explore Google Cloud Platform (GCP) diseñando e implementando un proyecto de ingeniería de datos que aproveche los servicios de GCP como Cloud Functions, BigQuery y Dataflow. Este proyecto puede incluir tareas de procesamiento, transformación y visualización de datos, centrándose en optimizar el uso de recursos y mejorar los flujos de trabajo de ingeniería de datos.

¿Cómo resolver?

- Definir claramente el alcance del proyecto, enfatizando el uso de los servicios de GCP para la ingeniería de datos, incluidos Cloud Functions, BigQuery y Dataflow.

- Diseñar e implementar la integración de servicios de GCP, asegurando la utilización eficiente de Cloud Functions, BigQuery y Dataflow.

- Ejecutar tareas de procesamiento y transformación de datos como parte del proyecto, alineándose con los objetivos generales.

- Concéntrese en optimizar el uso de recursos dentro del entorno de GCP para mejorar la eficiencia.

- Buscar oportunidades para mejorar los flujos de trabajo de ingeniería de datos a lo largo del ciclo de vida del proyecto, apuntando a procesos ágiles y efectivos.

Haga clic aquí para explorar el código fuente de este proyecto.

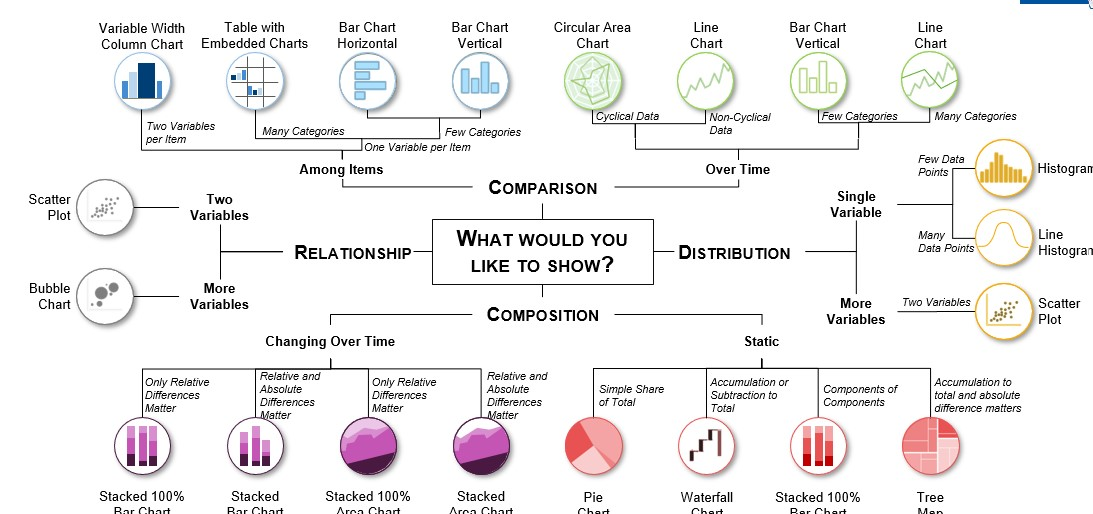

15. Visualización de datos de Reddit

Objetivo

Recopile y analice datos de Reddit, una de las plataformas de redes sociales más populares. Cree visualizaciones interactivas y obtenga información sobre el comportamiento del usuario, temas de actualidad y análisis de sentimientos en la plataforma. Este proyecto requerirá web scraping, análisis de datos y técnicas creativas de visualización de datos.

¿Cómo resolver?

- Defina los objetivos del proyecto, enfatizando la recopilación y el análisis de datos de Reddit para obtener información sobre el comportamiento del usuario, los temas de actualidad y el análisis de sentimientos.

- Implemente técnicas de web scraping para recopilar datos de la plataforma de Reddit.

- Sumérjase en el análisis de datos para explorar el comportamiento de los usuarios, identificar temas de actualidad y realizar análisis de opiniones.

- Cree visualizaciones interactivas para transmitir de manera efectiva información extraída de los datos de Reddit.

- Emplear técnicas innovadoras de visualización de datos para mejorar la presentación de los hallazgos a lo largo del proyecto.

Haga clic aquí para explorar el código fuente de este proyecto.

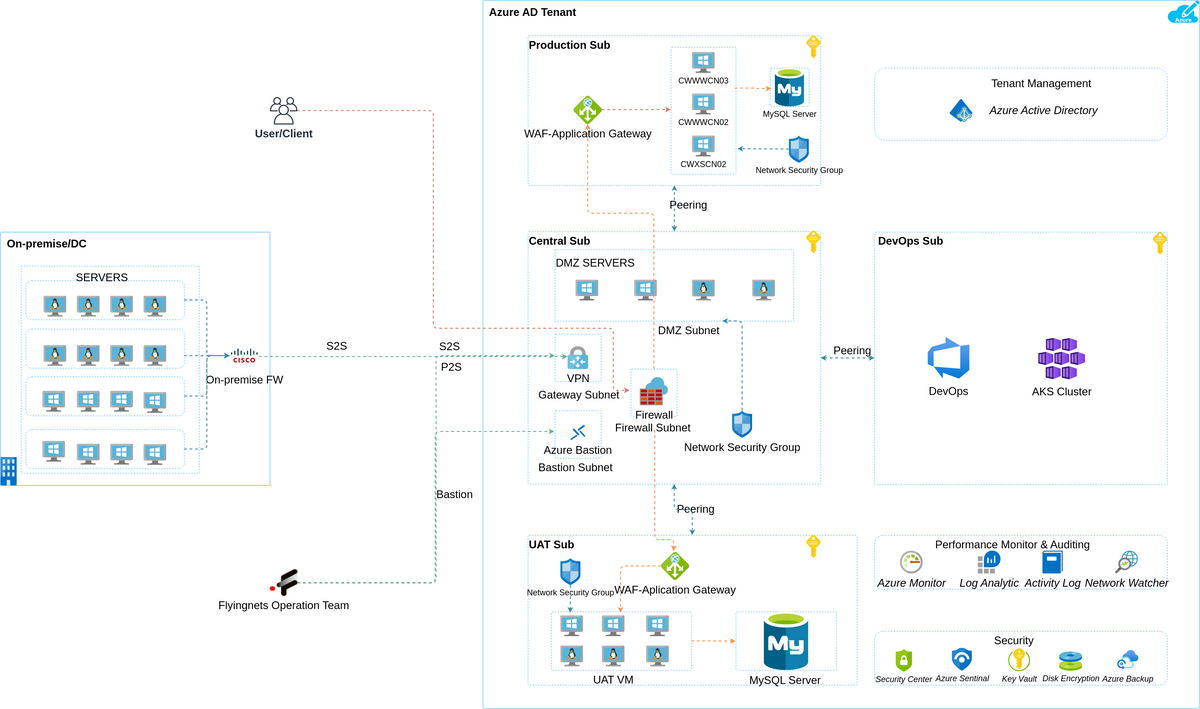

Proyectos de ingeniería de datos de Azure

16. Análisis de datos de Yelp

Objetivo

En este proyecto, su objetivo es analizar exhaustivamente los datos de Yelp. Creará una canalización de datos para extraer, transformar y cargar datos de Yelp en una solución de almacenamiento adecuada. El análisis puede implicar:

- Identificar negocios populares.

- Analizar el sentimiento de las opiniones de los usuarios.

- Proporcionar información a las empresas locales para mejorar sus servicios.

¿Cómo resolver?

- Utilice técnicas de web scraping o la API de Yelp para extraer datos.

- Limpie y preprocese datos con Python o Azure Data Factory.

- Almacene datos en Azure Blob Storage o Azure SQL Data Warehouse.

- Realice análisis de datos utilizando bibliotecas de Python como Pandas y Matplotlib.

Haga clic aquí para explorar el código fuente de este proyecto.

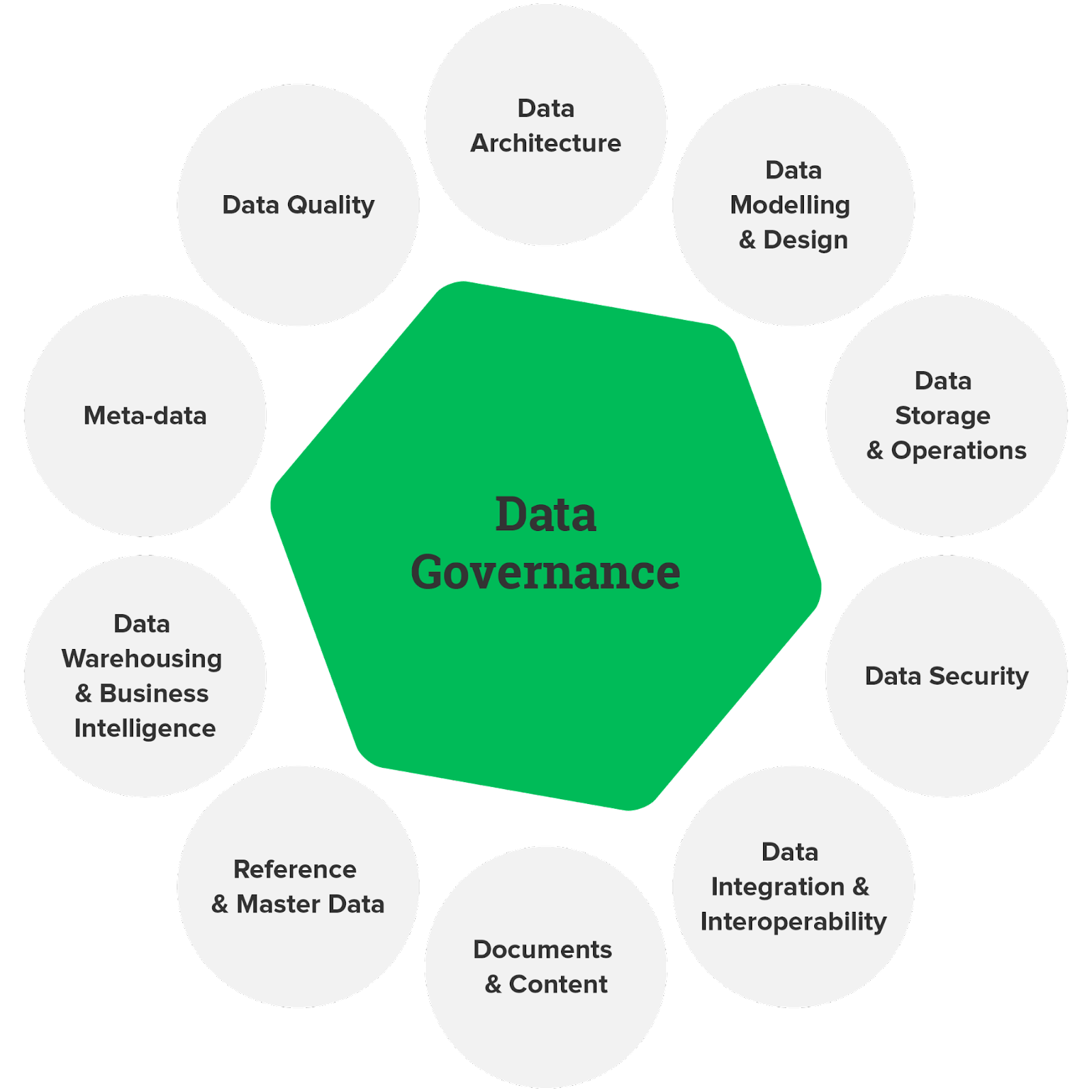

17. Gobernanza de datos

Objetivo

La gobernanza de datos es fundamental para garantizar la calidad, el cumplimiento y la seguridad de los datos. En este proyecto, diseñará e implementará un marco de gobierno de datos utilizando servicios de Azure. Esto puede implicar definir políticas de datos, crear catálogos de datos y establecer controles de acceso a los datos para garantizar que los datos se utilicen de manera responsable y de acuerdo con las regulaciones.

¿Cómo resolver?

- Utilice Azure Purview para crear un catálogo que documente y clasifique los activos de datos.

- Implemente políticas de datos mediante Azure Policy y Azure Blueprints.

- Configure el control de acceso basado en roles (RBAC) y la integración de Azure Active Directory para administrar el acceso a los datos.

Haga clic aquí para explorar el código fuente de este proyecto de ingeniería de datos.

18. Ingestión de datos en tiempo real

Objetivo

Diseñe una canalización de ingesta de datos en tiempo real en Azure mediante servicios como Azure Data Factory, Azure Stream Analytics y Azure Event Hubs. El objetivo es ingerir datos de diversas fuentes y procesarlos en tiempo real, proporcionando información inmediata para la toma de decisiones.

¿Cómo resolver?

- Utilice Azure Event Hubs para la ingesta de datos.

- Implemente el procesamiento de datos en tiempo real con Azure Stream Analytics.

- Almacene los datos procesados en Azure Data Lake Storage o Azure SQL Database.

- Visualice información en tiempo real mediante Power BI o Azure Dashboards.

Haga clic aquí para explorar el código fuente de este proyecto.

Ideas de proyectos de ingeniería de datos de AWS

19. Canalización ETL

Objetivo

Cree una canalización ETL (Extracción, Transformación, Carga) de un extremo a otro en AWS. La canalización debe extraer datos de varias fuentes, realizar transformaciones y cargar los datos procesados en un almacén o lago de datos. Este proyecto es ideal para comprender los principios básicos de la ingeniería de datos.

¿Cómo resolver?

- Utilice AWS Glue o AWS Data Pipeline para la extracción de datos.

- Implemente transformaciones utilizando Apache Spark en Amazon EMR o AWS Glue.

- Almacene los datos procesados en Amazon S3 o Amazon Redshift.

- Configure la automatización utilizando AWS Step Functions o AWS Lambda para la orquestación.

Haga clic aquí para explorar el código fuente de este proyecto.

20. Operaciones ETL y ELT

Objetivo

Explore los enfoques de integración de datos ETL (Extract, Transform, Load) y ELT (Extract, Load, Transform) en AWS. Compare sus fortalezas y debilidades en diferentes escenarios. Este proyecto proporcionará información sobre cuándo utilizar cada enfoque en función de los requisitos específicos de ingeniería de datos.

¿Cómo resolver?

- Implemente procesos ETL utilizando AWS Glue para la transformación y carga de datos. Emplee AWS Data Pipeline o AWS DMS (servicio de migración de bases de datos) para operaciones ELT.

- Almacene datos en Amazon S3, Amazon Redshift o Amazon Aurora, según el enfoque.

- Automatice los flujos de trabajo de datos utilizando AWS Step Functions o funciones de AWS Lambda.

Haga clic aquí para explorar el código fuente de este proyecto.

Conclusión

Los proyectos de ingeniería de datos ofrecen una oportunidad increíble para sumergirse en el mundo de los datos, aprovechar su poder y generar conocimientos significativos. Ya sea que esté creando canales para la transmisión de datos en tiempo real o creando soluciones para procesar grandes conjuntos de datos, estos proyectos mejoran sus habilidades y abren puertas a interesantes perspectivas profesionales.

Pero no te detengas aquí; Si está ansioso por llevar su viaje en ingeniería de datos al siguiente nivel, considere inscribirse en nuestro Programa BlackBelt Plus. Con BB+, obtendrá acceso a orientación experta, experiencia práctica y una comunidad de apoyo, lo que impulsará sus habilidades de ingeniería de datos a nuevas alturas. ¡Regístrate ahora!

Preguntas frecuentes

R. La ingeniería de datos implica diseñar, construir y mantener canales de datos. Ejemplo: crear una canalización para recopilar, limpiar y almacenar datos de clientes para su análisis.

R. Las mejores prácticas en ingeniería de datos incluyen controles sólidos de la calidad de los datos, procesos ETL eficientes, documentación y escalabilidad para el crecimiento futuro de los datos.

R. Los ingenieros de datos trabajan en tareas como el desarrollo de canales de datos, garantizando la precisión de los datos, colaborando con científicos de datos y solucionando problemas relacionados con los datos.

R. Para mostrar proyectos de ingeniería de datos en un currículum, resalte proyectos clave, mencione las tecnologías utilizadas y cuantifique el impacto en el procesamiento de datos o los resultados del análisis.

Relacionado:

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.analyticsvidhya.com/blog/2023/09/data-engineering-project/