Las fábricas están comenzando a implementar modelos de aprendizaje automático para profundizar en procesos complejos, aprovechando tanto una gran potencia informática como avances significativos en ML. Todo esto es necesario a medida que las dimensiones se reducen y la complejidad aumenta con nuevos materiales y estructuras, procesos y opciones de embalaje, y a medida que aumenta la demanda de confiabilidad.

La creación de modelos sólidos requiere entrenar los algoritmos, y una implementación exitosa requiere monitorear la aplicación y efectividad de esos modelos. Pero no es tan sencillo como pulsar un botón y listo. Se requiere capacitación, reentrenamiento y capacitación cruzada de diferentes disciplinas de ingeniería (ingenieros de fábricas, ingenieros de equipos e ingenieros de procesos) para utilizar estos modelos para encontrar rutas de recetas, acelerar procesos, optimizar dimensiones críticas, mejorar el rendimiento de obleas y herramienta a herramienta. y comparación entre cámaras.

"La experiencia en el dominio es absolutamente esencial para el uso productivo de los enfoques de IA/ML", dijo Regina Freed, vicepresidenta de soluciones AIx en Applied Materials. "De hecho, la experiencia en hardware y procesos, junto con modelos híbridos basados en ML y física, será el único camino para una implementación exitosa del ML".

Trabajar en conjunto con modelos entrenados en ML requiere comprender cómo utilizar esos modelos, así como la capacidad de evaluar su efectividad y solidez.

"Los ingenieros deben creer que va a funcionar y deben comprender qué puede y qué no puede hacer el aprendizaje automático", afirmó Jon Herlocker, director ejecutivo de tignis. “No se convertirá en una máquina y decidirá apoderarse de la fábrica. Los ingenieros pueden establecer controles sobre estos modelos para desarrollar confianza. Utilizan los mismos métodos estadísticos sólidos para calificar los modelos entrenados en ML que usarían para calificar un sistema de control de procesos tradicional. Crean planes de muestreo específicos para medir la variabilidad dentro de esos planes”.

El aprendizaje automático también abre la puerta a explorar relaciones más complejas entre datos en todo el flujo de fabricación. Pero hay algunas advertencias.

“Lo que realmente sorprende de la evolución del aprendizaje profundo (DL) del aprendizaje automático es el uso de esta increíble potencia informática, especialmente en las GPU”, observó Ajay Baranwal, director del Centro de Aprendizaje Profundo en Fabricación de Electrónica (CDLe). “En el entrenamiento DL, se puede explorar una cantidad increíble de parámetros y combinaciones de parámetros utilizando esta enorme potencia informática. En cierto modo, lo que ha sucedido es que la computación de fuerza bruta puede triunfar hoy en día porque ahora hay mucha potencia informática disponible. Pero existe un equilibrio entre explorar parámetros grandes para realizar análisis complejos y limitarlos a modelos más simples. El sobreajuste, el sesgo y la interpretabilidad son algunas de las desventajas de mantener más parámetros”.

Una vez calificado, un modelo ML utilizado para el control de fábricas debe monitorearse para tener en cuenta la deriva y otros cambios en el proceso que podrían afectar las relaciones entre los datos de entrada y salida.

La aplicación eficaz de un modelo basado en ML para el control de equipos y procesos requiere algo más que capacitación del modelo. También requiere validación, seguimiento y mantenimiento.

Datos confiables y experiencia en el dominio

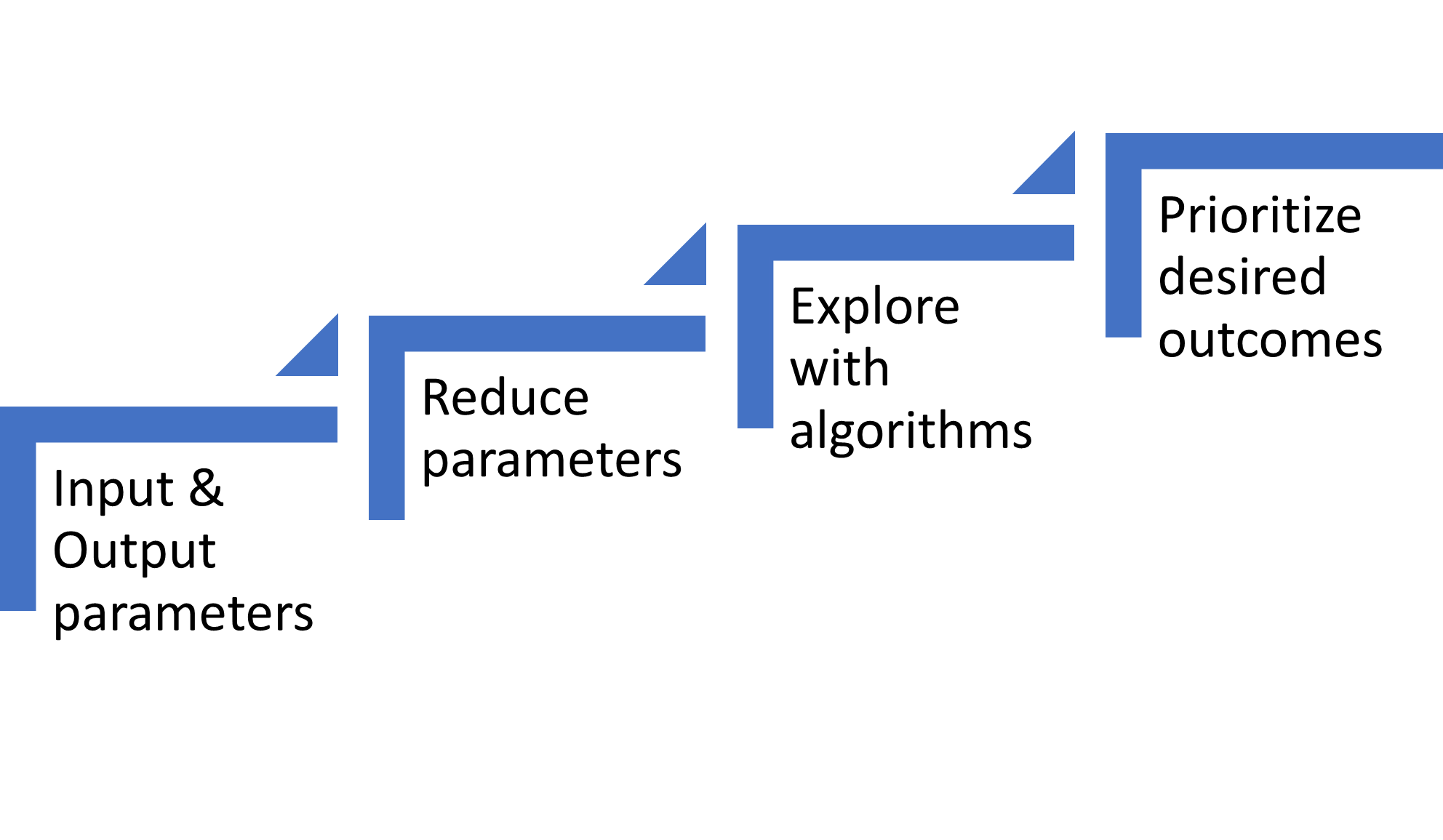

Los modelos exitosos entrenados en ML se basan en datos confiables y experiencia en el dominio. A continuación, reducir los parámetros de entrada de cientos a miles disponibles a aquellos que realmente importan requiere una exploración de las relaciones, a menudo utilizando modelos basados en la física. Estos modelos son particularmente importantes para el desarrollo de recetas de procesos. Comparar los resultados con modelos basados en física y conocimientos de ingeniería garantiza una orientación adecuada para el desarrollo de ML. Otras consideraciones son las compensaciones al optimizar múltiples especificaciones de resultados.

Fig. 1: Componentes necesarios para entrenar un modelo de ML para procesos fabulosos. Fuente: A. Meixner/Ingeniería de semiconductores

Independientemente de si los ingenieros aplican visión por computadora, modelos estadísticos o modelos de aprendizaje profundo, la creación de modelos siempre comienza con los datos. Esos datos deben estar limpios, es decir, libres de errores y completos. Para la optimización en múltiples pasos de procesos fabulosos o aplicaciones de avance, la combinación de datos de múltiples fuentes requiere trazabilidad a nivel de oblea y/o matriz. Como señalaron varios expertos de la industria, el trabajo pesado está en la gestión de datos. Esto es cierto para la construcción del modelo inicial y para la implementación en un entorno de fábrica.

Junto con un flujo constante de datos confiables, los ingenieros de procesos de fábricas deben dirigir el modelo en la dirección correcta. Esta necesidad no es diferente a la de cualquier otro campo en el que se crean modelos derivados de ML.

"En las primeras etapas, contar con expertos en la materia es muy útil para impulsar el aprendizaje automático en las fábricas, especialmente en aplicaciones de desarrollo de procesos", dijo Anjaneya Thakar, directora senior de gestión de línea de productos de Sinopsis. “Como el modelo se construye utilizando una cantidad limitada de datos, es posible que se esté optimizando en torno a un punto óptimo incorrecto, porque han visto el problema antes de que un experto en la materia pueda guiarlo rápidamente. Una vez que su modelo esté ajustado y haya obtenido el control de su variabilidad, habrá menos necesidad de que los expertos en la materia lo ejecuten a diario”.

Simplemente dejar que un algoritmo entrene a un modelo sin dirección es como tener un nuevo empleado en la fábrica.

"En algunos aspectos, el aprendizaje automático es como el aprendizaje humano", dijo Herlocker de Tignis. “Si tienes un ingeniero de procesos junior, hay mucho que puede hacer. Pero a medida que el ingeniero aprende, puede resolver problemas más complejos. Lo mismo se aplica con ML. Cuanto más entrenamiento tenga el modelo ML, mejor será. La formación del modelo ML es el conocimiento del dominio. El desafío a seguir es cómo tomar todo ese conocimiento del dominio y transformarlo para que pueda ser consumido por ML como “capacitación”. En última instancia, necesitamos combinar la intuición y el conocimiento humanos con ML para obtener los mejores resultados”.

Lam Research exploró esa combinación óptima de la intuición y el conocimiento del ingeniero con los resultados del aprendizaje automático en un experimento de simulación. [1] "Existe un dicho entre los ingenieros de que la ciencia de datos sin conocimiento del dominio no vale mucho", dijo Keren Kanarik, director general técnico de Investigación de lam. “Del mismo modo, el conocimiento del dominio sin ciencia de datos no le permitirá innovar lo suficientemente rápido en el competitivo mundo de los semiconductores. Lam probó recientemente esta idea creando un juego virtual que comparaba a los humanos con la IA en el desarrollo de un proceso de semiconductores con el menor costo para el objetivo (es decir, la menor cantidad de experimentos). Los resultados arrojaron un enfoque prescriptivo sobre cómo combinar la experiencia en el dominio con la ciencia de datos”.

Reducir y priorizar

El gran atractivo de los modelos basados en ML es su capacidad para conectar múltiples parámetros de entrada en relaciones no lineales con varios parámetros de resultados. Sin embargo, para los modelos actuales, la mayoría de los expertos coinciden en que a menudo el número de parámetros de entrada significativos es del orden de 10. Hay varias razones para este límite, incluida la optimización para resultados incorrectos, la explicación del modelo entrenado y la observación de las relaciones.

Fig. 2: Canal de construcción de aprendizaje automático para crear un modelo. Fuente: A. Meixner/Ingeniería de semiconductores

“La clave para la implementación exitosa de algoritmos complejos es la visualización. Debe proporcionar una representación visual poderosa que ayude a los usuarios a interpretar y comprender instantáneamente los resultados (y sus límites) de los algoritmos. Cuando la imagen visual llega al espectador justo entre los ojos, los ingenieros de rendimiento pueden entrar en acción”, afirmó Dieter Rathei, director ejecutivo de Rendimiento de DR.

Los algoritmos de entrenamiento de ML pueden explorar más fácilmente más parámetros; sin embargo, la reducción de parámetros representa un paso vital en el proceso de desarrollo del modelo.

"Debido a la naturaleza de caja negra de la mayoría de los modelos de aprendizaje automático, a veces existe el temor de que los usuarios se encuentren correlacionando el rendimiento del proceso con el día de la semana", dijo Meghali Chopra, directora ejecutiva de Sandbox Semiconductor. “El aprendizaje automático está diseñado para iluminar relaciones de datos clave, pero la basura que entra equivale a la basura que sale. Un buen enfoque y canalización del modelo ML está diseñado para distinguir la señal del ruido. Utilizamos IA basada en la física para limitar el espacio de parámetros. También invertimos mucho en preprocesamiento de datos y técnicas de reducción de dimensionalidad para garantizar que los parámetros más importantes estén iluminados para nuestros usuarios”.

Es posible informar a los ingenieros de los parámetros importantes de forma escalonada, primero un parámetro, luego dos y posiblemente tres.

"Tenemos dos niveles en nuestra herramienta", dijo Jeff David, vicepresidente de soluciones de IA en Soluciones PDF. “Una es la predicción univariante. Comenzamos con univariante porque es fácil de entender y visualizar. Por ejemplo, si el parámetro A es aproximadamente 2.7 y veo más fallas cuando está por debajo de 2.7, entonces en el siguiente paso tenemos una interacción entre dos parámetros. Y luego mostramos los desgloses de la interacción para esos dos parámetros. Pero nos detenemos en dos, porque una vez que pasas a tres y cuatro se vuelve muy difícil visualizar y explorar”.

La otra advertencia sobre la cantidad de parámetros utilizados son las correlaciones incorrectas.

"Para este tipo de aplicación (desarrollo de recetas de grabado), los procesos son tan complejos que el análisis de la causa raíz puede mostrar por qué modelar esa complejidad es realmente importante", dijo Chopra de Sandbox Semiconductor. “El peligro de modelar tantos parámetros es que se pueden encontrar correlaciones falsas, es decir, el resultado del proceso con el día de la semana. Eso es lo que quieres evitar. Invertimos mucho en la reducción de dimensionalidad. Y luego utilizamos nuestro modelo basado en la física de anclaje, por lo que nunca nos preocupamos demasiado por complicar demasiado el problema porque un buen proceso de modelado esencialmente encontrará todos los parámetros de proceso importantes para usted”.

Otros coinciden en la necesidad de un proceso de modelado que reduzca los parámetros y encuentre relaciones significativas.

"Definitivamente hay un límite en la cantidad de parámetros", dijo David de PDF. “Pero no lo sabes para un caso de uso determinado hasta que entrenas un modelo con los datos que tienes y lo validas. Nuestra plataforma permite automáticamente a nuestros clientes hacer esto con nuestro canal de capacitación. Nuestro proceso de capacitación se escala para permitir a nuestros clientes ver las métricas que necesitan ver en sus modelos entrenados en unas pocas horas, desde la ingesta de datos hasta los modelos entrenados. Luego, si los modelos entrenados muestran valor, el usuario puede implementar los modelos automáticamente con nuestra plataforma ModelOps”.

También existen compensaciones al equilibrar múltiples resultados.

"Básicamente, es cierto que no hay manera de construir estos controladores sin la participación de un ingeniero de procesos, porque hay que tomar decisiones sobre compensaciones", dijo Herlocker. “Estás intentando optimizar para muchas cosas a la vez. Por ejemplo, está intentando optimizar para CD, pero también está intentando minimizar la cantidad de energía que está utilizando. Hay decisiones humanas inherentes que toman los ingenieros sobre: "¿Cuánto me importa la calidad del proceso versus el uso de energía versus el consumo de químicos versus las emisiones químicas?" Pero la capacitación en ML no sabe cuál es más importante. Sólo los ingenieros lo saben, por lo que tienen que estar ahí”.

Implementar y mantener

Una vez desarrollado, el ML debe validarse e implementarse en un entorno de producción y debe mantenerse. Esto se ejecuta mejor con un proceso sistemático y confiable en las fábricas de semiconductores, y requiere una plataforma de procesos/métodos de operaciones de aprendizaje automático (ML Ops). Esto se ha convertido en un estándar en las aplicaciones de aprendizaje automático en otras industrias y recién ahora está sucediendo en la industria de los semiconductores.

Los ingenieros desarrollan modelos de ML de forma aislada. La transición del entorno de desarrollo al entorno de producción implica un conjunto de prácticas similares a DevOps para el despliegue de sistemas de software. Cuando el modelo se lanza a producción, una plataforma ML Ops permite aumentar la automatización de la implementación y mejorar la calidad del modelo. [2] Por lo tanto, se aplica a todo el ciclo de vida del modelo ML.

"Durante la última década ha habido mucho entusiasmo en torno a cómo el aprendizaje automático puede aportar valor a la fabricación de semiconductores en muchos casos de uso", dijo David de PDF. “Pero cuando llega el momento de implementarlo en producción, la gente tiene dificultades. Por ejemplo, ¿cómo controlas si tu modelo entrenado está haciendo lo que se supone que debe hacer? Si no, ¿cuál es el recurso? ¿Qué pasa si llega el momento de hacer predicciones y tus datos no están ahí? Eso sucede más a menudo de lo que nos gustaría. ¿Cómo se detecta una desviación en los datos de entrada en los que se basó su modelo entrenado? ¿Qué acciones toma al respecto? ¿A qué te dedicas? ML Ops es básicamente la implementación de hacer que todo este material se ejecute en producción para que puedas usarlo”.

Además, los modelos deberían tener capacidad de reentrenamiento. “Ha habido muchos avances en nuevos algoritmos de aprendizaje automático, muchos de los cuales están relacionados con el aprendizaje profundo. El aprendizaje profundo es un área de gran inversión y, como industria, podemos hacer muchas cosas que antes no eran posibles, especialmente cuando se trata de trabajar con modelos grandes. Muchas mejoras en el área de la automatización del reentrenamiento de modelos están resultando esenciales para la amplia implementación de modelos ML en entornos de fabricación de gran volumen”, dijo Herlocker de Tignis.

Otro aspecto de ML Ops es la implementación más rápida de modelos para predicciones similares, pero en productos diferentes. Debido a las características del producto, los mismos parámetros de entrada podrían dar como resultado datos de salida diferentes. Esto también puede significar que un enfoque de entrenamiento diferente se adapta mejor a un conjunto de datos. Y aquí es donde entran en juego el proceso de ML y las operaciones de ML.

"Quiere entrenar un modelo diferente por producto A, B y C y quiere hacerlo de forma automatizada, además de implementar rápidamente cada uno de ellos", dijo David de PDF. “Tal vez el bosque aleatorio no sea el mejor para ese conjunto de datos. Con ML Ops, toma su conjunto de datos, lo corta en pedazos e implementa diferentes tipos de enfoques algorítmicos. Son hiperparámetros de ese conjunto de datos que pueden validarse en lo que se llama validación cruzada. [3] Luego, construyes el modelo utilizando tu mejor enfoque de algoritmo, que luego se integra en el modelo y luego lo implementas para producción. Esto puede ser diferente de un chip a otro. ML Ops es muy necesario en la industria, e incluso escucho de clientes que quieren esta plataforma ML OPS más que la capacidad de entrenar un modelo con un algoritmo. La razón, al final del día, es que realmente quieren implementar ML en producción. Sin una plataforma para hacer eso, nada más importa”.

Conclusión

Con las presiones de la economía, la eficacia y la eficiencia, los equipos de ingeniería de las fábricas de semiconductores necesitarán utilizar modelos de aprendizaje automático para respaldar su trabajo. El aprendizaje automático ha surgido como un medio para acelerar el desarrollo de recetas, aumentar el rendimiento y obtener algunos puntos porcentuales de rendimiento. Con la capacidad del ML para abordar interacciones complejas que dependen de propiedades espaciales y estados temporales, los futuros modelos de ML se optimizarán conjuntamente en todos los pasos del proceso, acelerando la comprensión de nuevos mecanismos químicos y mucho más.

Pero como ocurre con cualquier herramienta de su caja de herramientas, los ingenieros deben comprender las limitaciones del aprendizaje automático. Para hacerlo de forma eficaz, necesitan un modelo de aprendizaje automático sólido que desarrolle, valide, implemente y supervise. Y todavía se requieren ingenieros de procesos para dirigir y facilitar la aplicación.

"Una de las cosas que descubrimos es que las soluciones de aprendizaje automático actuales necesitan un ingeniero de procesos, un ingeniero de software, científicos de datos y una persona de TI", dijo Herlocker. “Como parte de nuestra visión, la persona crítica es el ingeniero de procesos. Podemos crear un software que permita al ingeniero de procesos hacer esto sin nadie más. Nos estamos acercando a lograr ese objetivo y, por lo tanto, a capacitar al ingeniero de procesos para que utilice el aprendizaje automático de forma eficaz”.

Referencias

- Kanarik, K., et al. “Colaboración entre humanos y máquinas para mejorar el desarrollo de procesos de semiconductores”, Nature 616, 707–711 (2023). https://doi.org/10.1038/s41586-023-05773-7

- https://en.wikipedia.org/wiki/MLOps

- https://en.wikipedia.org/wiki/Hyperparameter_(machine_learning)

DOCUMENTOS RELACIONADOS

Cuándo y dónde implementar IA/ML en fábricas

Herramientas más inteligentes pueden mejorar el control de procesos, identificar las causas de las desviaciones y acelerar el desarrollo de recetas.

Uso de ML para mejorar la programación fabulosa

Los investigadores están utilizando redes neuronales para aumentar la eficiencia del procesamiento de obleas mediante la identificación de patrones en grandes colecciones de datos.

Aplicación de ML en el análisis de fallos

Cuándo y dónde se utiliza mejor el aprendizaje automático y cómo elegir el modelo correcto.

Los problemas de datos se acumulan en la fabricación de chips

Las prácticas de datos maestros permiten a los ingenieros de producto y a los ingenieros de TI de la fábrica lidiar con una variedad de tipos de datos y calidad.

Equilibrando la inteligencia artificial y la experiencia en ingeniería en la fábrica

Los resultados muestran grandes mejoras cuando ambos se implementan para el desarrollo de nuevos procesos.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://semiengineering.com/fabs-begin-ramping-up-machine-learning/