Imagen del autor

Los modelos de lenguaje grande (LLM) son un nuevo tipo de inteligencia artificial que se entrena con cantidades masivas de datos de texto. Su principal capacidad es generar texto similar a un humano en respuesta a una amplia gama de indicaciones y solicitudes.

Apuesto a que ya ha tenido alguna experiencia con soluciones LLM populares como ChatGPT o Google Gemini.

Pero ¿alguna vez te has preguntado cómo estos potentes modelos ofrecen respuestas tan rápidas?

La respuesta está en un campo especializado llamado LLMOps.

Antes de profundizar, intentemos visualizar la importancia de este campo.

Imagina que estás teniendo una conversación con un amigo. Lo normal que esperarías es que cuando haces una pregunta te den una respuesta enseguida y el diálogo fluya sin esfuerzo.

¿Derecha?

Este intercambio fluido es lo que los usuarios también esperan cuando interactúan con modelos de lenguajes grandes (LLM). Imagínese chatear con ChatGPT y tener que esperar un par de minutos cada vez que enviamos un mensaje, nadie lo usaría en absoluto, al menos yo no lo haría, seguro.

Es por eso que los LLM buscan lograr este flujo de conversación y efectividad en sus soluciones digitales con el campo LLMOps. Esta guía pretende ser su compañera en sus primeros pasos en este nuevo dominio.

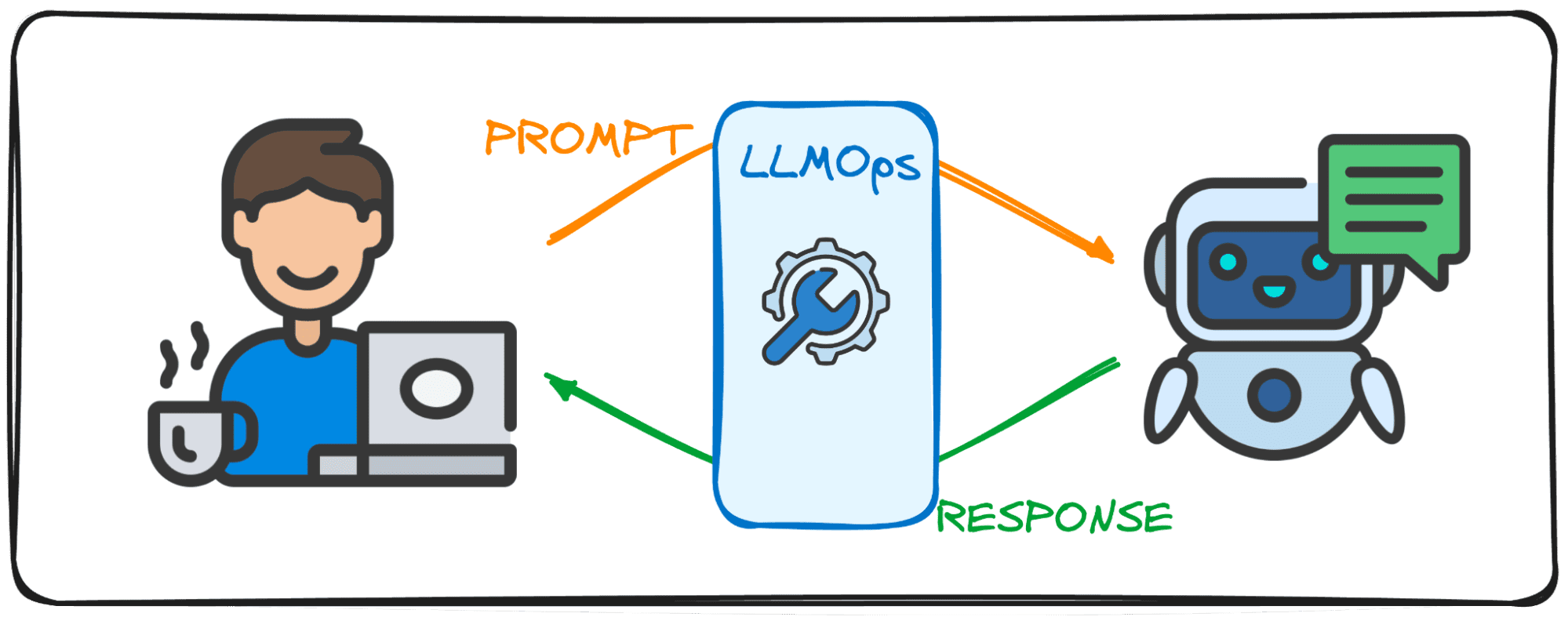

LLMOps, abreviatura de Large Language Model Operations, es la magia detrás de escena que garantiza que los LLM funcionen de manera eficiente y confiable. Representa un avance con respecto a los conocidos MLOps, diseñado específicamente para abordar los desafíos únicos que plantean los LLM.

Mientras que MLOps se centra en gestionar el ciclo de vida de los modelos generales de aprendizaje automático, LLMOps se ocupa específicamente de los requisitos específicos de LLM.

Cuando se utilizan modelos de entidades como OpenAI o Anthropic a través de interfaces web o API, los LLMOps trabajan detrás de escena, haciendo que estos modelos sean accesibles como servicios. Sin embargo, al implementar un modelo para una aplicación especializada, la responsabilidad de LLMOps recae en nosotros.

Así que considérelo como un moderador que se encarga del flujo de un debate. Así como el moderador mantiene la conversación fluida y alineada con el tema del debate, asegurándose siempre de que no haya malas palabras y tratando de evitar noticias falsas, LLMOps garantiza que los LLM operen al máximo rendimiento, brindando experiencias de usuario fluidas y verificando la seguridad del producción.

La creación de aplicaciones con modelos de lenguaje grandes (LLM) presenta desafíos distintos de los que se observan con el aprendizaje automático convencional. Para navegarlos, se han creado herramientas y metodologías de gestión innovadoras, dando lugar al marco LLMOps.

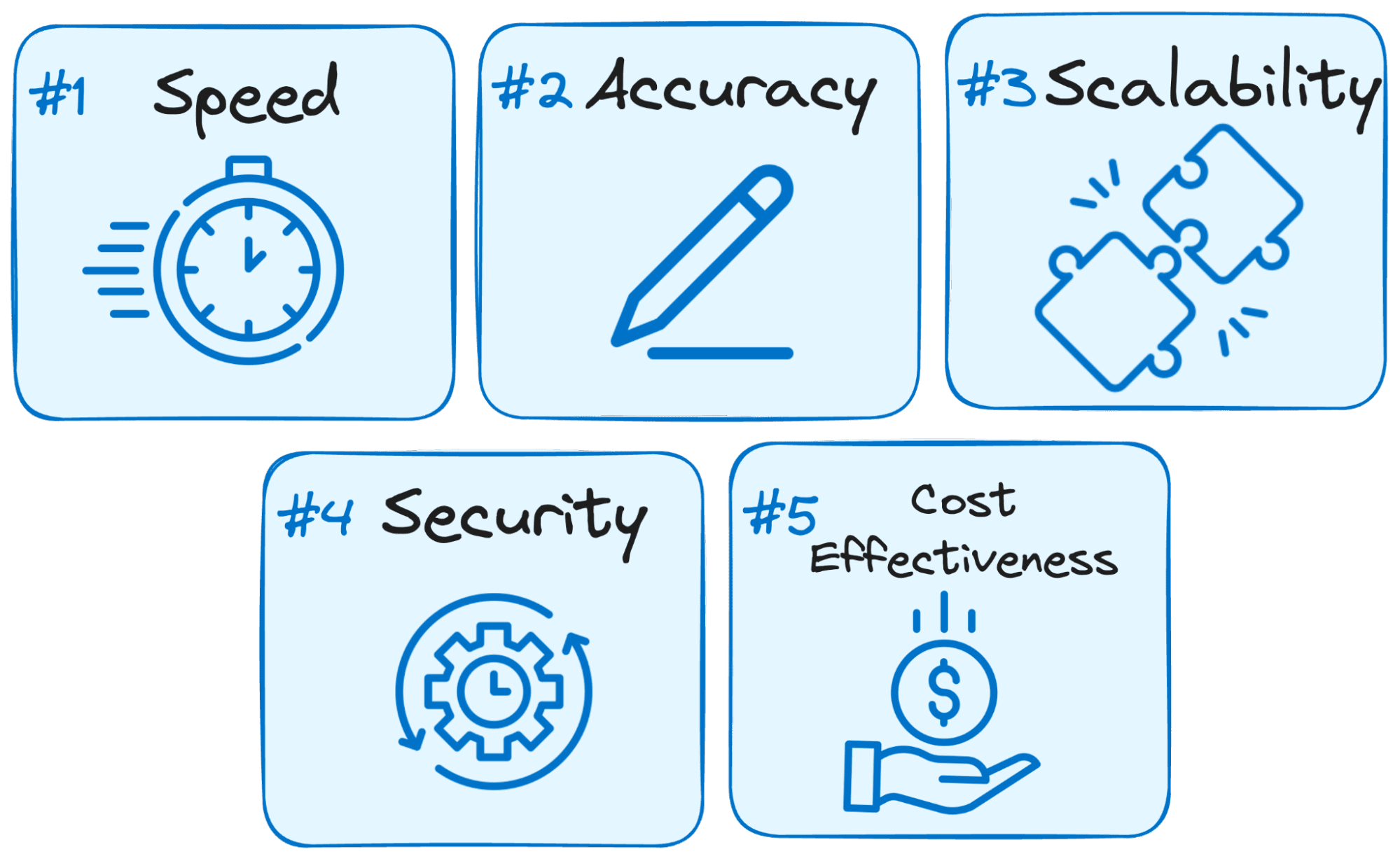

He aquí por qué LLMOps es crucial para el éxito de cualquier aplicación basada en LLM:

Imagen del autor

- La velocidad es clave: Los usuarios esperan respuestas inmediatas cuando interactúan con los LLM. LLMOps optimiza el proceso para minimizar la latencia, asegurando que obtenga respuestas dentro de un plazo razonable.

- La precisión importa: LLMOps implementa varias verificaciones y controles para garantizar la precisión y relevancia de las respuestas del LLM.

- Escalabilidad para el crecimiento: A medida que su aplicación LLM gana terreno, LLMOps lo ayuda a escalar recursos de manera eficiente para manejar cargas de usuarios cada vez mayores.

- La seguridad es primordial: LLMOps salvaguarda la integridad del sistema LLM y protege los datos confidenciales aplicando sólidas medidas de seguridad.

- Rentabilidad: Operar LLM puede ser financieramente exigente debido a sus importantes requisitos de recursos. LLMOps pone en juego métodos económicos para maximizar la utilización de recursos de manera eficiente, garantizando que no se sacrifique el máximo rendimiento.

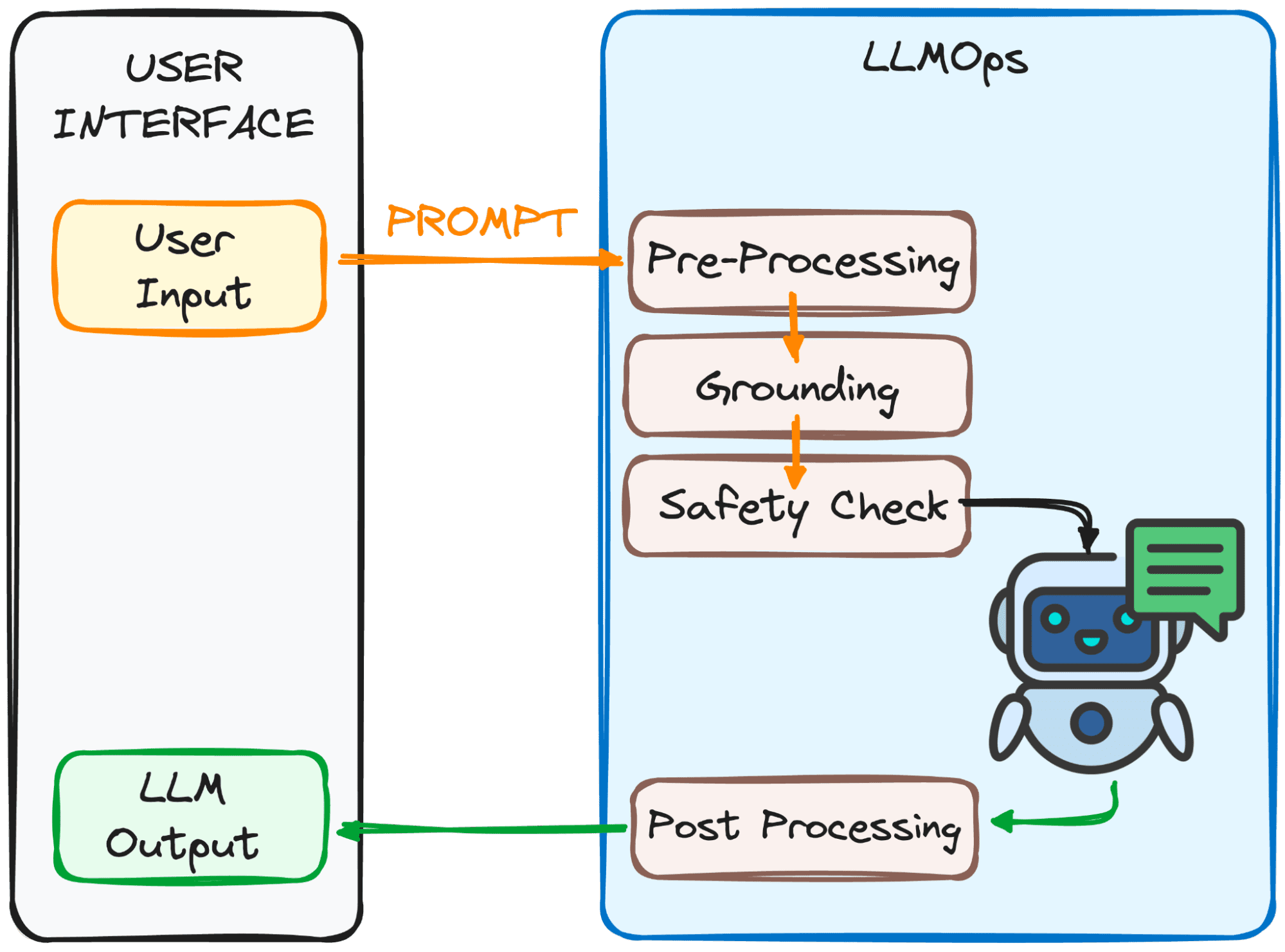

LLMOps se asegura de que su mensaje esté listo para el LLM y su respuesta le llegue lo más rápido posible. Sin embargo, esto no es nada fácil.

Este proceso implica varios pasos, principalmente 4, que se pueden observar en la imagen a continuación.

Imagen del autor

¿El objetivo de estos pasos?

Hacer que el mensaje sea claro y comprensible para el modelo.

Aquí hay un desglose de estos pasos:

1. Preprocesamiento

El mensaje pasa por un primer paso de procesamiento. Primero, se divide en partes más pequeñas (fichas). Luego, se limpian los errores tipográficos o los caracteres extraños y el texto se formatea de forma coherente.

Finalmente, los tokens se integran en datos numéricos para que el LLM los comprenda.

2. Toma de tierra

Antes de que el modelo procese nuestra indicación, debemos asegurarnos de que comprenda el panorama general. Esto podría implicar hacer referencia a conversaciones pasadas que haya tenido con el LLM o utilizar información externa.

Además, el sistema identifica cosas importantes mencionadas en el mensaje (como nombres o lugares) para que la respuesta sea aún más relevante.

3. Control de seguridad:

Al igual que tener reglas de seguridad en el set, LLMOps se asegura de que las indicaciones se utilicen de manera adecuada. El sistema busca elementos como información confidencial o contenido potencialmente ofensivo.

Sólo después de pasar estas comprobaciones estará listo el mensaje para el acto principal: ¡el LLM!

Ahora tenemos nuestro mensaje listo para ser procesado por el LLM. Sin embargo, su resultado también debe analizarse y procesarse. Entonces, antes de que lo veas, se realizan algunos ajustes más en el cuarto paso:

3. Postprocesamiento

¿Recuerda el código al que se convirtió el mensaje? La respuesta debe traducirse nuevamente a un texto legible por humanos. Luego, el sistema pule la respuesta en cuanto a gramática, estilo y claridad.

Todos estos pasos se realizan sin problemas gracias a LLMOps, el miembro invisible del equipo que garantiza una experiencia LLM fluida.

Impresionante, ¿verdad?

Estos son algunos de los componentes esenciales de una configuración LLMOps bien diseñada:

- Elegir el LLM adecuado: Con una amplia gama de modelos LLM disponibles, LLMOps le ayuda a seleccionar el que mejor se adapta a sus necesidades y recursos específicos.

- Ajuste fino para la especificidad: LLMOps le permite ajustar los modelos existentes o entrenar los suyos propios, personalizándolos para su caso de uso exclusivo.

- Ingeniería rápida: LLMOps le proporciona técnicas para elaborar indicaciones efectivas que guíen al LLM hacia el resultado deseado.

- Implementación y seguimiento: LLMOps agiliza el proceso de implementación y monitorea continuamente el desempeño del LLM, asegurando una funcionalidad óptima.

- Medidas de seguridad: LLMOps prioriza la seguridad de los datos mediante la implementación de medidas sólidas para proteger la información confidencial.

A medida que la tecnología LLM continúe evolucionando, LLMOps desempeñará un papel fundamental en los próximos desarrollos tecnológicos. La mayor parte del éxito de las últimas soluciones populares como ChatGPT o Google Gemini es su capacidad no sólo de responder cualquier solicitud sino también de brindar una buena experiencia de usuario.

Es por eso que, al garantizar una operación eficiente, confiable y segura, LLMOps allanará el camino para aplicaciones LLM aún más innovadoras y transformadoras en diversas industrias que llegarán a más personas.

Con un conocimiento sólido de LLMOps, estará bien equipado para aprovechar el poder de estos LLM y crear aplicaciones innovadoras.

Josep Ferrer Es ingeniero analítico de Barcelona. Se licenció en ingeniería física y actualmente trabaja en el campo de la ciencia de datos aplicada a la movilidad humana. Es un creador de contenido a tiempo parcial enfocado en ciencia y tecnología de datos. Josep escribe sobre todo lo relacionado con la IA, cubriendo la aplicación de la explosión en curso en este campo.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.kdnuggets.com/getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions?utm_source=rss&utm_medium=rss&utm_campaign=getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions