Esta es una publicación invitada coescrita con Scott Gutterman del PGA TOUR.

La inteligencia artificial generativa (IA generativa) ha permitido nuevas posibilidades para construir sistemas inteligentes. Las mejoras recientes en los modelos de lenguaje grande (LLM) basados en IA generativa han permitido su uso en una variedad de aplicaciones relacionadas con la recuperación de información. Dadas las fuentes de datos, los LLM proporcionaron herramientas que nos permitirían crear un chatbot de preguntas y respuestas en semanas, en lugar de lo que habría llevado años antes, y probablemente con un peor rendimiento. Formulamos una solución de generación aumentada de recuperación (RAG) que permitiría al PGA TOUR crear un prototipo para una futura plataforma de participación de los fanáticos que podría hacer que sus datos fueran accesibles para los fanáticos de manera interactiva en un formato conversacional.

El uso de datos estructurados para responder preguntas requiere una forma de extraer de manera efectiva datos que sean relevantes para la consulta de un usuario. Formulamos un enfoque de texto a SQL en el que la consulta en lenguaje natural de un usuario se convierte en una declaración SQL mediante un LLM. El SQL es ejecutado por Atenea amazónica para devolver los datos relevantes. Estos datos se proporcionan nuevamente a un LLM, al que se le pide que responda la consulta del usuario dada la información.

El uso de datos de texto requiere un índice que se pueda usar para buscar y proporcionar contexto relevante a un LLM para responder la consulta de un usuario. Para permitir la recuperación rápida de información, utilizamos amazona kendra como índice de estos documentos. Cuando los usuarios hacen preguntas, nuestro asistente virtual busca rápidamente en el índice de Amazon Kendra para encontrar información relevante. Amazon Kendra utiliza el procesamiento del lenguaje natural (NLP) para comprender las consultas de los usuarios y encontrar los documentos más relevantes. Luego, la información relevante se proporciona al LLM para la generación de la respuesta final. Nuestra solución final es una combinación de estos enfoques de texto a SQL y texto-RAG.

En este post destacamos cómo el Centro de innovación de IA generativa de AWS colaborado con el Servicios profesionales de AWS y PGA TOUR Desarrollar un prototipo de asistente virtual utilizando lecho rocoso del amazonas que podría permitir a los fanáticos extraer información sobre cualquier evento, jugador, hoyo o detalles del nivel de tiro de una manera interactiva y fluida. Amazon Bedrock es un servicio totalmente administrado que ofrece una selección de modelos básicos (FM) de alto rendimiento de empresas líderes en inteligencia artificial como AI21 Labs, Anthropic, Cohere, Meta, Stability AI y Amazon a través de una única API, junto con un amplio conjunto de capacidades que necesita para crear aplicaciones de IA generativa con seguridad, privacidad e IA responsable.

Desarrollo: preparar los datos

Como ocurre con cualquier proyecto basado en datos, el rendimiento será tan bueno como los datos. Procesamos los datos para permitir que el LLM pueda consultar y recuperar datos relevantes de manera efectiva.

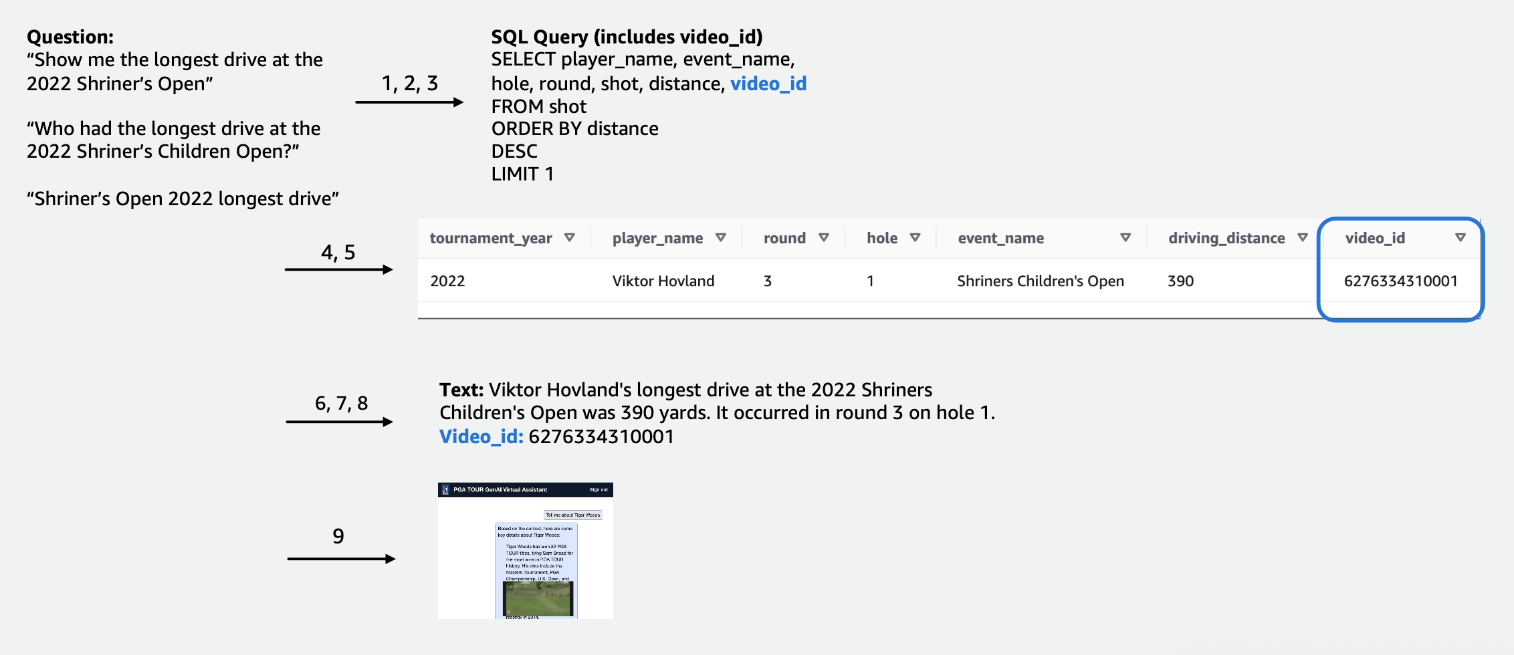

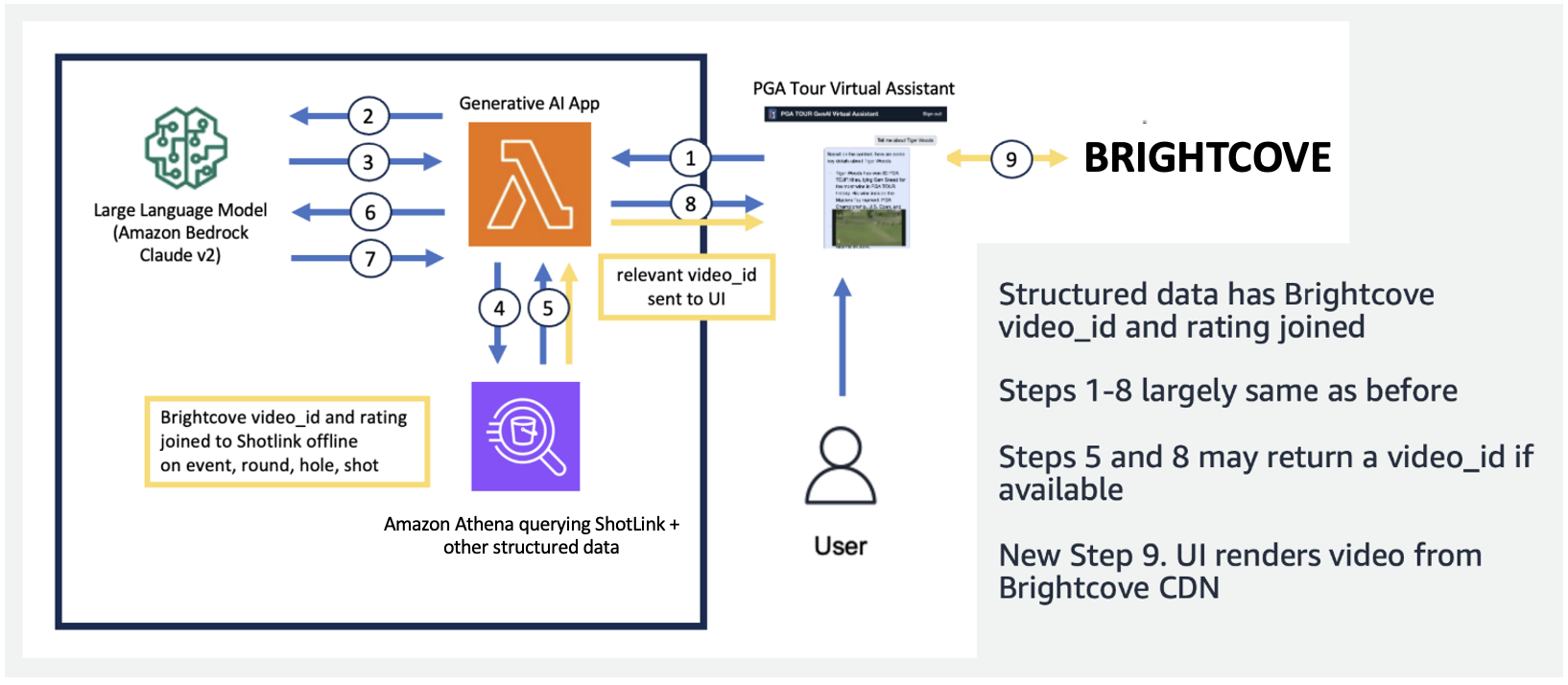

Para los datos tabulares de la competencia, nos centramos en un subconjunto de datos relevantes para la mayor cantidad de consultas de los usuarios y etiquetamos las columnas de manera intuitiva, de modo que fueran más fáciles de entender para los LLM. También creamos algunas columnas auxiliares para ayudar al LLM a comprender conceptos con los que de otro modo tendría dificultades. Por ejemplo, si un golfista dispara un tiro menos que el par (como por ejemplo, logra llegar al hoyo en 3 tiros en un par 4 o en 4 tiros en un par 5), comúnmente se le llama golfista. pajarito. Si un usuario pregunta: "¿Cuántos birdies hizo el jugador X el año pasado?", No basta con tener el puntaje y el par en la tabla. Como resultado, agregamos columnas para indicar términos comunes de golf, como bogey, birdie y eagle. Además, vinculamos los datos de la Competencia con una colección de videos separada, uniendo una columna para un video_id, lo que permitiría a nuestra aplicación extraer el vídeo asociado con una toma particular en los datos de la competencia. También permitimos unir datos de texto a los datos tabulares, por ejemplo, agregando biografías de cada jugador como una columna de texto. Las siguientes figuras muestran el procedimiento paso a paso de cómo se procesa una consulta para la canalización de texto a SQL. Los números indican la serie de pasos para responder una consulta.

En la siguiente figura demostramos nuestra canalización de un extremo a otro. Usamos AWS Lambda como nuestra función de orquestación responsable de interactuar con diversas fuentes de datos, LLM y corrección de errores en función de la consulta del usuario. Los pasos 1 a 8 son similares a los que se muestran en la figura anterior. Hay ligeros cambios para los datos no estructurados, que analizamos a continuación.

Los datos de texto requieren pasos de procesamiento únicos que fragmentan (o segmentan) documentos largos en partes digeribles para el LLM, manteniendo al mismo tiempo la coherencia del tema. Experimentamos con varios enfoques y elegimos un esquema de fragmentación a nivel de página que se alineaba bien con el formato de las Guías de Medios. Usamos Amazon Kendra, que es un servicio administrado que se encarga de indexar documentos, sin necesidad de especificar incrustaciones, y al mismo tiempo proporciona una API sencilla para su recuperación. La siguiente figura ilustra esta arquitectura.

El proceso unificado y escalable que desarrollamos permite al PGA TOUR escalar a su historial completo de datos, algunos de los cuales se remontan al siglo XIX. Permite aplicaciones futuras que pueden implementarse en el contexto del curso para crear ricas experiencias en tiempo real.

Desarrollo: Evaluación de LLM y desarrollo de aplicaciones de IA generativa

Probamos y evaluamos cuidadosamente los LLM propios y de terceros disponibles en Amazon Bedrock para elegir el modelo que mejor se adapte a nuestra cartera y caso de uso. Seleccionamos Claude v2 y Claude Instant de Anthropic en Amazon Bedrock. Para nuestra canalización final de datos estructurados y no estructurados, observamos que Claude 2 de Anthropic en Amazon Bedrock generó mejores resultados generales para nuestra canalización de datos final.

Las indicaciones son un aspecto fundamental para lograr que los LLM produzcan el texto como se desea. Pasamos un tiempo considerable experimentando con diferentes indicaciones para cada una de las tareas. Por ejemplo, para la canalización de texto a SQL teníamos varios mensajes alternativos, con una especificidad cada vez mayor y esquemas de tablas gradualmente simplificados. Si una consulta SQL no era válida y generaba un error por parte de Athena, desarrollamos un mensaje de corrección de errores que pasaría el error y el SQL incorrecto al LLM y le pediría que lo solucionara. El mensaje final en la canalización de texto a SQL le pide al LLM que tome la salida de Athena, que se puede proporcionar en formato Markdown o CSV, y proporcione una respuesta al usuario. Para el texto no estructurado, desarrollamos indicaciones generales para utilizar el contexto recuperado de Amazon Kendra para responder la pregunta del usuario. El mensaje incluía instrucciones para utilizar solo la información recuperada de Amazon Kendra y no confiar en los datos de la capacitación previa de LLM.

La latencia suele ser una preocupación en las aplicaciones de IA generativa, y también lo es en este caso. Es especialmente preocupante para la conversión de texto a SQL, que requiere una invocación inicial de LLM de generación de SQL, seguida de una invocación de LLM de generación de respuesta. Si utilizamos un LLM grande, como Claude V2 de Anthropic, esto efectivamente duplica la latencia de una sola invocación de LLM. Experimentamos con varias configuraciones de LLM grandes y más pequeños para evaluar el tiempo de ejecución y la corrección. La siguiente tabla muestra un ejemplo de una pregunta que demuestra la latencia, así como las respuestas generadas con Claude V2 y Claude Instant de Anthropic en Amazon Bedrock.

Prototipo

En nuestra aplicación, utilizamos una función Lambda para organizar las opciones rápidas y la comunicación entre Amazon Athena, Amazon Kendra y Amazon Bedrock. El asistente virtual presenta una interfaz conversacional, creada con React y Cloudscape Design System, que utiliza texto y videos para interactuar con los usuarios.

Nuestro asistente virtual puede responder una amplia gama de preguntas sobre eventos, jugadores, estadísticas, historia y más del PGA TOUR. Por ejemplo, cuando se le pregunta acerca de los drives más largos de Tony Finau en el Shriners Children's Open (uno de los eventos exclusivos del PGA TOUR), el asistente puede consultar datos estructurados para obtener datos de su nivel de tiro. Puede extraer la distancia exacta en yardas, el número redondo y el agujero durante el cual logró este récord utilizando la canalización de texto a SQL. Luego, el asistente interpreta estos datos numéricos para generar una respuesta final. La siguiente tabla contiene algunos ejemplos de respuestas.

| Pregunta | Respuesta |

| ¿Cuál fue el drive más largo de Tony Finau en el Shriners Children's Open? | El drive más largo logrado por Tony Finau en el Shriners Childrens Open fue de 382 yardas, el cual conectó durante la primera ronda en el hoyo número 4 en 2018. |

| ¿Cuál fue el drive más largo de Collin Morikawa en el Shriners Children's Open? | El drive más largo de Collin Morikawa en el Shriners Childrens Open fue de 334 yardas. Esto ocurrió en 2019 durante la primera vuelta en el hoyo número 15. |

| ¿Alguien consiguió un as en el Shriners Children's Open 2022? | Sí, Adam Hadwin hizo un hoyo en uno en el hoyo 14 durante la ronda 3 del Shriners Children's Open 2022 |

El siguiente vídeo explicativo destaca algunos ejemplos de interacción con el asistente virtual.

En las pruebas iniciales, nuestro asistente virtual del PGA TOUR se mostró muy prometedor a la hora de mejorar las experiencias de los aficionados. Al combinar tecnologías de inteligencia artificial como texto a SQL, búsqueda semántica y generación de lenguaje natural, el asistente brinda respuestas informativas y atractivas. Los fanáticos pueden acceder sin esfuerzo a datos y narrativas que antes eran difíciles de encontrar.

¿Qué depara el futuro?

A medida que continuemos con el desarrollo, ampliaremos la gama de preguntas que nuestro asistente virtual puede manejar. Esto requerirá pruebas exhaustivas, a través de la colaboración entre AWS y el PGA TOUR. Con el tiempo, nuestro objetivo es convertir el asistente en una experiencia personalizada y omnicanal accesible a través de interfaces web, móviles y de voz.

El establecimiento de un asistente de IA generativa basado en la nube permite al PGA TOUR presentar su amplia fuente de datos a múltiples partes interesadas internas y externas. A medida que evoluciona el panorama de la IA generativa deportiva, permite la creación de nuevos contenidos. Por ejemplo, puede utilizar la IA y el aprendizaje automático (ML) para mostrar el contenido que los fanáticos quieren ver mientras miran un evento o cuando los equipos de producción buscan tomas de torneos anteriores que coincidan con un evento actual. Por ejemplo, si Max Homa se está preparando para realizar su último tiro en el Campeonato del PGA TOUR desde un lugar a 20 pies de la bandera, el PGA TOUR puede usar IA y ML para identificar y presentar clips de él, con comentarios generados por IA. haber intentado un tiro similar cinco veces anteriormente. Este tipo de acceso y datos permite a un equipo de producción agregar valor inmediatamente a la transmisión o permitir que un fan personalice el tipo de datos que desea ver.

“El PGA TOUR es el líder de la industria en el uso de tecnología de punta para mejorar la experiencia de los fanáticos. La IA está a la vanguardia de nuestra tecnología, donde nos permite crear un entorno más atractivo e interactivo para los fanáticos. Este es el comienzo de nuestro viaje de IA generativa en colaboración con el Centro de innovación de IA generativa de AWS para una experiencia transformadora de extremo a extremo para el cliente. Estamos trabajando para aprovechar Amazon Bedrock y nuestros datos de propiedad para crear una experiencia interactiva para que los fanáticos del PGA TOUR encuentren información de interés sobre un evento, jugador, estadísticas u otro contenido de manera interactiva”.

– Scott Gutterman, vicepresidente senior de propiedades digitales y de transmisión en PGA TOUR.

Conclusión

El proyecto que analizamos en esta publicación ejemplifica cómo se pueden fusionar fuentes de datos estructuradas y no estructuradas utilizando IA para crear asistentes virtuales de próxima generación. Para las organizaciones deportivas, esta tecnología permite una participación más inmersiva de los fanáticos y desbloquea eficiencias internas. La inteligencia de datos que presentamos ayuda a las partes interesadas del PGA TOUR, como jugadores, entrenadores, funcionarios, socios y medios de comunicación, a tomar decisiones informadas más rápido. Más allá de los deportes, nuestra metodología se puede replicar en cualquier industria. Los mismos principios se aplican a la creación de asistentes que atraigan a clientes, empleados, estudiantes, pacientes y otros usuarios finales. Con un diseño y pruebas bien pensados, prácticamente cualquier organización puede beneficiarse de un sistema de inteligencia artificial que contextualice sus bases de datos estructuradas, documentos, imágenes, videos y otros contenidos.

Si está interesado en implementar funcionalidades similares, considere usar Agentes de Amazon Bedrock y Bases de conocimiento para Amazon Bedrock como una solución alternativa totalmente administrada por AWS. Este enfoque podría investigar más a fondo la provisión de capacidades de búsqueda de datos y automatización inteligente a través de agentes personalizables. Estos agentes podrían potencialmente transformar las interacciones de las aplicaciones de los usuarios para que sean más naturales, eficientes y efectivas.

Sobre los autores

Scott Gutterman es el vicepresidente senior de operaciones digitales del PGA TOUR. Es responsable de las operaciones digitales generales del TOUR, del desarrollo de productos y de impulsar su estrategia GenAI.

Scott Gutterman es el vicepresidente senior de operaciones digitales del PGA TOUR. Es responsable de las operaciones digitales generales del TOUR, del desarrollo de productos y de impulsar su estrategia GenAI.

Ahsan Alí es científico aplicado en el Centro de Innovación de IA Generativa de Amazon, donde trabaja con clientes de diferentes dominios para resolver sus problemas urgentes y costosos utilizando la IA Generativa.

Ahsan Alí es científico aplicado en el Centro de Innovación de IA Generativa de Amazon, donde trabaja con clientes de diferentes dominios para resolver sus problemas urgentes y costosos utilizando la IA Generativa.

Tahin Syed es un científico aplicado en el Centro de Innovación de IA Generativa de Amazon, donde trabaja con clientes para ayudar a lograr resultados comerciales con soluciones de IA generativa. Fuera del trabajo, le gusta probar comida nueva, viajar y enseñar taekwondo.

Tahin Syed es un científico aplicado en el Centro de Innovación de IA Generativa de Amazon, donde trabaja con clientes para ayudar a lograr resultados comerciales con soluciones de IA generativa. Fuera del trabajo, le gusta probar comida nueva, viajar y enseñar taekwondo.

gracia lang es ingeniero asociado de datos y aprendizaje automático en AWS Professional Services. Impulsada por la pasión por superar desafíos difíciles, Grace ayuda a los clientes a alcanzar sus objetivos mediante el desarrollo de soluciones impulsadas por el aprendizaje automático.

gracia lang es ingeniero asociado de datos y aprendizaje automático en AWS Professional Services. Impulsada por la pasión por superar desafíos difíciles, Grace ayuda a los clientes a alcanzar sus objetivos mediante el desarrollo de soluciones impulsadas por el aprendizaje automático.

Jae Lee es gerente senior de participación en la vertical de M&E de ProServe. Lidera y ofrece compromisos complejos, exhibe sólidas habilidades para la resolución de problemas, gestiona las expectativas de las partes interesadas y organiza presentaciones de nivel ejecutivo. Le gusta trabajar en proyectos centrados en deportes, IA generativa y experiencia del cliente.

Jae Lee es gerente senior de participación en la vertical de M&E de ProServe. Lidera y ofrece compromisos complejos, exhibe sólidas habilidades para la resolución de problemas, gestiona las expectativas de las partes interesadas y organiza presentaciones de nivel ejecutivo. Le gusta trabajar en proyectos centrados en deportes, IA generativa y experiencia del cliente.

Karn Chahar es consultor de seguridad del equipo de entrega compartida de AWS. Es un entusiasta de la tecnología que disfruta trabajar con los clientes para resolver sus desafíos de seguridad y mejorar su postura de seguridad en la nube.

Karn Chahar es consultor de seguridad del equipo de entrega compartida de AWS. Es un entusiasta de la tecnología que disfruta trabajar con los clientes para resolver sus desafíos de seguridad y mejorar su postura de seguridad en la nube.

Mike Amjadi es un ingeniero de datos y aprendizaje automático en AWS ProServe enfocado en permitir a los clientes maximizar el valor de los datos. Se especializa en diseñar, construir y optimizar canales de datos siguiendo principios bien diseñados. A Mike le apasiona utilizar la tecnología para resolver problemas y está comprometido a ofrecer los mejores resultados a nuestros clientes.

Mike Amjadi es un ingeniero de datos y aprendizaje automático en AWS ProServe enfocado en permitir a los clientes maximizar el valor de los datos. Se especializa en diseñar, construir y optimizar canales de datos siguiendo principios bien diseñados. A Mike le apasiona utilizar la tecnología para resolver problemas y está comprometido a ofrecer los mejores resultados a nuestros clientes.

Vrushali Sawant es ingeniero front-end en Proserve. Tiene una gran habilidad en la creación de sitios web responsivos. Le encanta trabajar con los clientes, comprender sus requisitos y brindarles soluciones UI/UX escalables y fáciles de adoptar.

Vrushali Sawant es ingeniero front-end en Proserve. Tiene una gran habilidad en la creación de sitios web responsivos. Le encanta trabajar con los clientes, comprender sus requisitos y brindarles soluciones UI/UX escalables y fáciles de adoptar.

Neelam Patel es gerente de soluciones de clientes en AWS y lidera iniciativas clave de modernización de la nube y de IA generativa. Neelam trabaja con ejecutivos clave y propietarios de tecnología para abordar sus desafíos de transformación de la nube y ayuda a los clientes a maximizar los beneficios de la adopción de la nube. Tiene un MBA de Warwick Business School (Reino Unido) y una licenciatura en Ingeniería Informática (India).

Neelam Patel es gerente de soluciones de clientes en AWS y lidera iniciativas clave de modernización de la nube y de IA generativa. Neelam trabaja con ejecutivos clave y propietarios de tecnología para abordar sus desafíos de transformación de la nube y ayuda a los clientes a maximizar los beneficios de la adopción de la nube. Tiene un MBA de Warwick Business School (Reino Unido) y una licenciatura en Ingeniería Informática (India).

Dr. Murali Baktha es arquitecto global de soluciones de golf en AWS y encabeza iniciativas fundamentales que involucran inteligencia artificial generativa, análisis de datos y tecnologías de nube de vanguardia. Murali trabaja con ejecutivos clave y propietarios de tecnología para comprender los desafíos comerciales de los clientes y diseñar soluciones para abordar esos desafíos. Tiene un MBA en Finanzas de UConn y un doctorado de la Universidad Estatal de Iowa.

Dr. Murali Baktha es arquitecto global de soluciones de golf en AWS y encabeza iniciativas fundamentales que involucran inteligencia artificial generativa, análisis de datos y tecnologías de nube de vanguardia. Murali trabaja con ejecutivos clave y propietarios de tecnología para comprender los desafíos comerciales de los clientes y diseñar soluciones para abordar esos desafíos. Tiene un MBA en Finanzas de UConn y un doctorado de la Universidad Estatal de Iowa.

Mehdi Noor es gerente de ciencias aplicadas en Generative Ai Innovation Center. Con una pasión por unir la tecnología y la innovación, ayuda a los clientes de AWS a desbloquear el potencial de la IA generativa, convirtiendo los desafíos potenciales en oportunidades para una experimentación e innovación rápidas centrándose en usos escalables, mensurables e impactantes de tecnologías avanzadas de IA, y agilizando el camino. a la producción.

Mehdi Noor es gerente de ciencias aplicadas en Generative Ai Innovation Center. Con una pasión por unir la tecnología y la innovación, ayuda a los clientes de AWS a desbloquear el potencial de la IA generativa, convirtiendo los desafíos potenciales en oportunidades para una experimentación e innovación rápidas centrándose en usos escalables, mensurables e impactantes de tecnologías avanzadas de IA, y agilizando el camino. a la producción.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://aws.amazon.com/blogs/machine-learning/the-journey-of-pga-tours-generative-ai-virtual-assistant-from-concept-to-development-to-prototype/