Introducción

Bienvenido a este artículo, donde exploraremos el apasionante mundo de la IA generativa. Nos centraremos principalmente en los codificadores automáticos variacionales condicionales o CVAE, que son como el siguiente nivel del arte de la IA, que fusionan las fortalezas de los codificadores automáticos variacionales (VAE) con la capacidad de seguir instrucciones específicas, lo que nos brinda un control preciso sobre la creación de imágenes. A lo largo de este artículo, profundizaremos en los CVAE y veremos cómo y por qué se pueden usar en varios escenarios del mundo real, e incluso le brindaremos algunos ejemplos de código fáciles de entender para mostrar su potencial.

Este artículo fue publicado como parte del Blogatón de ciencia de datos.

Tabla de contenidos.

Comprensión de los codificadores automáticos variacionales (VAE)

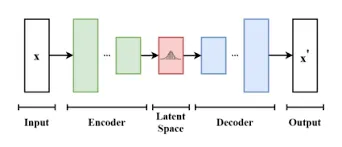

Antes de profundizar en los CVAE, centrémonos en los fundamentos de los VAE. Los VAE son un tipo de modelo generativo que combina una red codificadora y decodificadora. Se utilizan para conocer la estructura subyacente de los datos y generar nuevas muestras.

Claro, usemos un ejemplo simple que involucra las preferencias de café para explicar los codificadores automáticos variacionales (VAE).

Imagine que quiere representar las preferencias de café de todos en su oficina:

- Encoder: Cada persona resume su elección de café (negro, café con leche, capuchino) con unas pocas palabras (p. ej., firme, cremoso, suave).

- Variación: Entiende que incluso dentro de la misma opción (p. ej., café con leche), existen variaciones en la leche, el dulzor, etc.

- Espacio latente: Crea un espacio flexible donde las preferencias de café pueden variar.

- Descifrador: Utiliza estos resúmenes para preparar café para compañeros, con ligeras variaciones, respetando sus preferencias.

- Poder generativo: Puede crear nuevos estilos de café que se adapten a los gustos individuales pero que no sean réplicas exactas.

Los VAE funcionan de manera similar: aprenden características principales y variaciones en los datos para generar datos nuevos y similares con ligeras diferencias.

A continuación se muestra una implementación simple del codificador automático variacional (VAE) que utiliza Python y TensorFlow/Keras. Este ejemplo utiliza el conjunto de datos MNIST por simplicidad, pero puede adaptarlo a otros tipos de datos.

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers

import numpy as np # Load and preprocess the MNIST dataset

(x_train, _), (x_test, _) = keras.datasets.mnist.load_data()

x_train = x_train.astype('float32') / 255.0

x_test = x_test.astype('float32') / 255.0 # Define the VAE model

latent_dim = 2 # Encoder

encoder_inputs = keras.Input(shape=(28, 28))

x = layers.Flatten()(encoder_inputs)

x = layers.Dense(256, activation='relu')(x)

z_mean = layers.Dense(latent_dim)(x)

z_log_var = layers.Dense(latent_dim)(x) # Reparameterization trick

def sampling(args): z_mean, z_log_var = args epsilon = tf.keras.backend.random_normal(shape=(tf.shape(z_mean)[0], latent_dim)) return z_mean + tf.exp(0.5 * z_log_var) * epsilon z = layers.Lambda(sampling)([z_mean, z_log_var]) # Decoder

decoder_inputs = keras.Input(shape=(latent_dim,))

x = layers.Dense(256, activation='relu')(decoder_inputs)

x = layers.Dense(28 * 28, activation='sigmoid')(x)

decoder_outputs = layers.Reshape((28, 28))(x) # Define the VAE model

encoder = keras.Model(encoder_inputs, [z_mean, z_log_var, z], name='encoder')

decoder = keras.Model(decoder_inputs, decoder_outputs, name='decoder')

vae_outputs = decoder(encoder(encoder_inputs)[2])

vae = keras.Model(encoder_inputs, vae_outputs, name='vae') # Loss function

def vae_loss(x, x_decoded_mean, z_log_var, z_mean): x = tf.keras.backend.flatten(x) x_decoded_mean = tf.keras.backend.flatten(x_decoded_mean) xent_loss = keras.losses.binary_crossentropy(x, x_decoded_mean) kl_loss = -0.5 * tf.reduce_mean(1 + z_log_var - tf.square(z_mean) - tf.exp(z_log_var)) return xent_loss + kl_loss vae.compile(optimizer='adam', loss=vae_loss)

vae.fit(x_train, x_train, epochs=10, batch_size=32, validation_data=(x_test, x_test))

Explicación de los codificadores automáticos variacionales condicionales (CVAE)

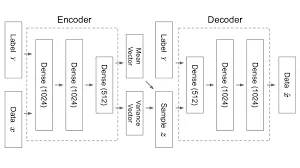

Los CVAE amplían las capacidades de los VAE mediante la introducción de entradas condicionales. Los CVAE pueden generar muestras de datos basadas en condiciones o información específicas. Por ejemplo, puede generar condicionalmente imágenes de perros o gatos proporcionando al modelo la etiqueta de clase deseada como entrada.

Entendamos usando un ejemplo en tiempo real.

Compras en línea con CVAE Imagine que está comprando zapatillas de deporte en línea:

- VAE básico (sin condiciones): El sitio web te muestra zapatillas al azar.

- CVAE (con condiciones): Usted selecciona sus preferencias: color (rojo), tamaño (10) y estilo (correr).

- Encoder: El sitio web comprende sus elecciones y filtra las zapatillas en función de estas condiciones.

- Variación: Reconociendo que incluso dentro de sus condiciones existen variaciones (diferentes tonos de rojo, estilos de zapatillas para correr), las considera.

- Espacio latente: Crea un “espacio de personalización de zapatillas” donde se permiten variaciones.

- Descifrador: Utilizando sus condiciones personalizadas, le muestra zapatillas que se ajustan estrechamente a sus preferencias.

Los CVAE, como los sitios web de compras en línea, utilizan condiciones específicas (sus preferencias) para generar datos personalizados (opciones de zapatillas) que se alinean estrechamente con sus elecciones.

Siguiendo con el ejemplo del codificador automático variacional (VAE), puede implementar un codificador automático variacional condicional (CVAE). En este ejemplo, consideraremos el conjunto de datos MNIST y generaremos dígitos condicionalmente en función de una etiqueta de clase.

# Define the CVAE model

encoder = keras.Model([encoder_inputs, label], [z_mean, z_log_var, z], name='encoder')

decoder = keras.Model([decoder_inputs, label], decoder_outputs, name='decoder')

cvae_outputs = decoder([encoder([encoder_inputs, label])[2], label])

cvae = keras.Model([encoder_inputs, label], cvae_outputs, name='cvae')

Diferencia entre VAE y CVAE

VAE

- Los VAE son como artistas que crean arte pero con un poco de aleatoriedad.

- Aprenden a crear diversas variaciones de datos sin instrucciones específicas.

- Útil para generar nuevas muestras de datos sin condiciones, como arte aleatorio.

CVAE

- Los CVAE son como artistas que pueden seguir solicitudes específicas

- Generan datos basados en condiciones o instrucciones dadas.

- Útil para tareas en las que desea un control preciso sobre lo que se genera, como convertir un caballo en una cebra conservando las características principales.

Implementación de CVAE: ejemplos de código

Exploremos un ejemplo de código Python simple usando TensorFlow y Keras para implementar un CVAE para generar dígitos escritos a mano.

# Import necessary libraries

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers

from tensorflow.keras.models import Model # Define the CVAE model architecture

latent_dim = 2

input_shape = (28, 28, 1)

num_classes = 10 # Encoder network

encoder_inputs = keras.Input(shape=input_shape)

x = layers.Conv2D(32, 3, padding='same', activation='relu')(encoder_inputs)

x = layers.Flatten()(x)

x = layers.Dense(64, activation='relu')(x) # Conditional input

label = keras.Input(shape=(num_classes,))

x = layers.concatenate([x, label]) # Variational layers

z_mean = layers.Dense(latent_dim)(x)

z_log_var = layers.Dense(latent_dim)(x) # Reparameterization trick

def sampling(args): z_mean, z_log_var = args epsilon = tf.keras.backend.random_normal(shape=(tf.shape(z_mean)[0], latent_dim)) return z_mean + tf.exp(0.5 * z_log_var) * epsilon z = layers.Lambda(sampling)([z_mean, z_log_var]) # Decoder network

decoder_inputs = layers.Input(shape=(latent_dim,))

x = layers.concatenate([decoder_inputs, label])

x = layers.Dense(64, activation='relu')(x)

x = layers.Dense(28 * 28 * 1, activation='sigmoid')(x)

x = layers.Reshape((28, 28, 1))(x) # Create the models

encoder = Model([encoder_inputs, label], [z_mean, z_log_var, z], name='encoder')

decoder = Model([decoder_inputs, label], x, name='decoder')

cvae = Model([encoder_inputs, label], decoder([z, label]), name='cvae')

#import csvEste código proporciona una estructura básica para un modelo CVAE. Para entrenar y generar imágenes, necesitará un conjunto de datos adecuado y ajustes adicionales.

Aplicaciones de CVAE

Los CVAE tienen aplicaciones en diversos dominios, que incluyen:

Traducción de imagen a imagen: Se pueden utilizar para traducir imágenes de un dominio a otro preservando el contenido. Imagina que tienes una foto de un caballo y quieres convertirlo en una cebra manteniendo las características principales. Los CVAE pueden hacer eso:

#import csv# Translate horse image to a zebra image

translated_image = cvae_generate(horse_image, target="zebra")Transferencia de estilo: Los CVAE permiten la transferencia de estilos artísticos entre imágenes. Suponga que tiene una imagen y quiere que se parezca a un cuadro famoso, por ejemplo, “La noche estrellada” de Van Gogh. Los CVAE pueden aplicar ese estilo:

#import csv

# Apply "Starry Night" style to your photo

styled_image = cvae_apply_style(your_photo, style="Starry Night")- Detección de anomalías : Son eficaces para detectar anomalías en los datos. Tiene un conjunto de datos de latidos normales y desea detectar latidos irregulares. Los CVAE pueden detectar anomalías:

# Detect irregular heartbeats

is_anomaly = cvae_detect_anomaly(heartbeat_data)- Descubrimiento de medicamento : Los CVAE ayudan a generar estructuras moleculares para el descubrimiento de fármacos. Digamos que necesita encontrar nuevas moléculas para un medicamento que salve vidas. Los CVAE pueden ayudar a diseñar estructuras moleculares:

#import csv# Generate potential drug molecules

drug_molecule = cvae_generate_molecule("anti-cancer")

Estas aplicaciones muestran cómo los CVAE pueden transformar imágenes, aplicar estilos artísticos, detectar anomalías y ayudar en tareas cruciales como el descubrimiento de fármacos, todo ello manteniendo los datos subyacentes significativos y útiles.

Desafíos y direcciones futuras

Desafios

- Modo colapso: Piense en los CVAE como un pintor que a veces se olvida de utilizar todos sus colores. El colapso del modo ocurre cuando los CVAE siguen usando los mismos colores (representaciones) para diferentes cosas. Entonces, podrían pintar a todos los animales de un solo color, perdiendo diversidad.

- Generación de imágenes de alta resolución: Imagínese pedirle a un artista que pinte un gran mural detallado en un lienzo pequeño. Es desafiante. Los CVAE se enfrentan a un desafío similar cuando intentan crear imágenes grandes y muy detalladas.

Metas futuras

Los investigadores quieren mejorar los CVAE:

- Evitar el colapso del modo: Están trabajando para asegurarse de que el artista (CVAE) utilice todos los colores (representaciones) que tiene, creando resultados más diversos y precisos.

- Arte de alta resolución: Su objetivo es ayudar al artista (CVAE) a pintar murales (imágenes) más grandes y detallados mejorando las técnicas utilizadas. De esta manera, podemos obtener obras de arte impresionantes y de alta calidad de los CVAE.

Conclusión

Los codificadores automáticos variacionales condicionales representan un desarrollo innovador en la IA generativa. Su capacidad para generar datos en función de condiciones específicas abre un mundo de posibilidades en diversas aplicaciones. Al comprender sus principios subyacentes e implementarlos de manera efectiva, podemos aprovechar el potencial de los CVAE para la generación de imágenes avanzadas y más.

Puntos clave

- Avance de la IA generativa: Habilitación de la generación de imágenes con entradas condicionales.

- Analogía simple del café: Piense en los VAE como si resumieran las preferencias de café, permitiendo variaciones mientras se preserva la esencia.

- Código VAE básico: Se proporciona un ejemplo de código Python fácil de usar para principiantes de un VAE, utilizando el conjunto de datos MNIST.

- Implementación de CVAE: El artículo incluye un fragmento de código para implementar un CVAE para la generación de imágenes condicional.

- Ejemplo de compras en línea: Una analogía con la compra de zapatillas deportivas en línea ilustra la capacidad de los CVAE para personalizar los datos según las condiciones.

Preguntas frecuentes

R. Mientras que los VAE generan datos con cierta aleatoriedad, los CVAE generan datos con condiciones o restricciones específicas. Los VAE son como artistas que crean arte al azar.

R. Los codificadores automáticos variacionales condicionales (CVAE) son muy útiles en el mundo de la IA. Pueden crear datos personalizados basados en condiciones específicas, abriendo puertas a muchas aplicaciones.

R. Sí, puede encontrar bibliotecas de código abierto como TensorFlow y PyTorch que proporcionan herramientas para crear CVAE. Algunos modelos previamente entrenados y ejemplos de código están disponibles en estas bibliotecas para impulsar sus proyectos.

R. Los modelos CVAE previamente entrenados son menos comunes en comparación con otras arquitecturas como las redes neuronales convolucionales (CNN). Sin embargo, puede encontrar VAE previamente entrenados que puede adaptar a su tarea ajustando el modelo.

Los medios que se muestran en este artículo no son propiedad de Analytics Vidhya y se utilizan a discreción del autor.

Relacionado:

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Automoción / vehículos eléctricos, Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- ChartPrime. Eleve su juego comercial con ChartPrime. Accede Aquí.

- Desplazamientos de bloque. Modernización de la propiedad de compensaciones ambientales. Accede Aquí.

- Fuente: https://www.analyticsvidhya.com/blog/2023/09/generative-ai-conditional-vaes/