Imagen generada por ArteMyko usando medio viaje

La creencia de que la ciencia significa experimentos observables y repetibles, que comenzó con Descartes en el siglo XVII, está, en esta medida, superada. La comprensión global, por el contrario, se basa en modelos computacionales respaldados por una infraestructura de conocimiento.

— Cómo ver el mundo, Nicolás Mirzoeff

El sistema de numeración arábiga permitió que los números se manipularan fácilmente, lo que condujo a las matemáticas y su papel como herramienta para validar la ciencia. De hecho, la historia de la ciencia es en gran parte la historia de las nuevas matemáticas que validan los nuevos fundamentos de la ciencia. Hoy tenemos un nuevo conjunto de herramientas “matemáticas”, los avances en Inteligencia Artificial (AI) y Machine Learning (ML) en los últimos cinco años. Este nuevo ML realmente no se trata tanto de generar nuevo texto o arte. Este nuevo ML se trata de validar la nueva ciencia a un nivel más fundamental de lo que hemos explorado antes. El propósito de este artículo es hablar sobre esta nueva herramienta ML para validar la nueva ciencia.

La ciencia moderna comenzó con el trabajo de Newton y Descartes. Newton nos dio la primera comprensión precisa de la física, pero también se le atribuye el desarrollo del cálculo diferencial. Esta combinación de ciencias físicas y matemáticas continúa dando forma a la investigación hasta el día de hoy, particularmente en la aplicación de ecuaciones diferenciales parciales a problemas de múltiples variables en ingeniería y física. A Descartes se le atribuye el desarrollo del álgebra para explicar la geometría. Una forma geométrica podría explicarse mediante una serie de ecuaciones (álgebra), en las que las coordenadas ubican un punto, los puntos determinan las líneas y las líneas determinan los planos y la forma. Este álgebra apoyó la visión de Descartes de la ciencia como una inspección de arriba hacia abajo de lo tangible desde el nivel macro al micro y un enfoque en la materia, la estructura y la causalidad lineal y determinista. Descartes, como era de esperar, fue un filósofo empirista además de su estudio de las matemáticas y la ciencia. Su filosofía "natural" dio forma a la ciencia durante los siguientes doscientos años y aún hasta el día de hoy.

El siguiente gran avance en la ciencia fue la Teoría Cuántica. Gran parte de los fundamentos de la física cuántica se basaron en las nuevas matemáticas. Primero, Ludwig Boltzmann nos dio la mecánica estadística, que introduce la probabilidad y la incertidumbre en el estudio de la ciencia física. Maxwell, Poincaré, Heisenberg, Schrödinger, Bohr, Plank y Einstein utilizaron las matemáticas para desarrollar el trabajo de Boltzmann. Esto nos dejó con una nueva comprensión de la realidad basada en partículas subatómicas e invisibles que se comportan de manera probabilística. No podríamos haber terminado más lejos de la filosofía natural de Descartes. La ciencia ahora se centró en lo invisible. Afortunadamente, el siguiente avance en matemáticas y ciencias, la Teoría del Caos, nos ayudó a unir la incertidumbre de la física cuántica con el mundo natural que vemos todos los días.

En 1972, el profesor del MIT Edward Lorenz introdujo la idea del caos determinista. Benoît Mandelbrot, investigador de IBM, adelantó el trabajo de Lorenz, estableció “una base matemática de formación de patrones en la naturaleza” [ 1 ], y mostró que los sistemas deterministas no lineales con dependencia sensible de las condiciones iniciales (SDIC) podrían modelarse en una computadora. Mandelbrot no solo explicó una parte de las ciencias naturales que antes se entendía poco, sino que introdujo el concepto de "fractales" para explicar los patrones que se repiten constantemente en toda la naturaleza. Con los patrones documentados, las matemáticas fueron fáciles y la computarización facilitó en gran medida la investigación adicional en el modelado de fenómenos caóticos en campos como la meteorología, la geología y la biología. Lo que sea que quedara de la metafísica y la epistemología de Descartes después de la física cuántica, la nueva comprensión de los patrones naturales mostrados por la teoría del caos demostró otra forma en que las matemáticas explican la ciencia previamente inexplicada. La teoría del caos también demostró quizás un punto más significativo. La ciencia podría entenderse mediante la aplicación de modelos informáticos para buscar patrones en los sistemas. Este enfoque de la ciencia en los sistemas se aplicó luego a otra categoría de sistemas: la ciencia de la complejidad.

Si este contenido educativo en profundidad es útil para usted, suscríbase a nuestra lista de correo de IA ser alertado cuando lancemos nuevo material.

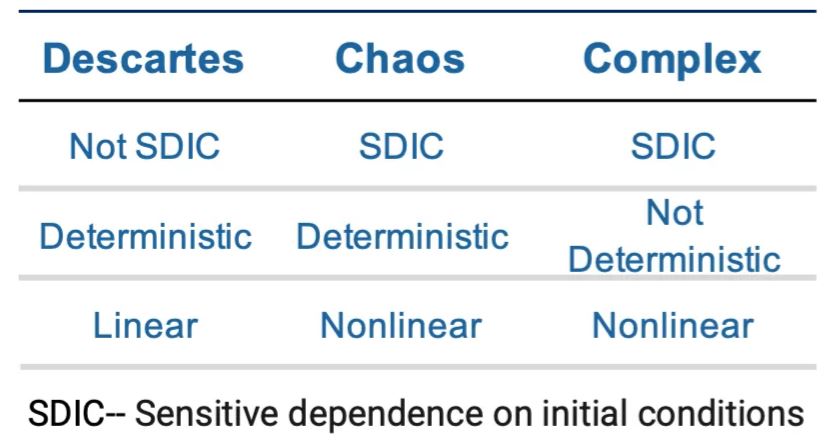

En 1984, el Premio Nobel de Física Murray Gell-Mann fundó el Instituto Santa Fe junto con un grupo de otros científicos y académicos distinguidos para explorar sistemas complejos. Gell-Mann explicó la complejidad, "lo que deberíamos buscar eran grandes síntesis que estaban surgiendo hoy, que eran altamente interdisciplinarias", dice Gell-Mann [ 2 ]. Algunos ya estaban en camino: Biología molecular. ciencia no lineal. Ciencia cognitiva. Pero seguramente había otras síntesis emergentes, dijo, y este nuevo instituto debería buscarlas”. A diferencia de los sistemas caóticos, los sistemas complejos no son deterministas, como se muestra a continuación. Los sistemas deterministas exhiben una "evolución única", en la que "un estado dado de un modelo siempre es seguido por la misma historia de transiciones de estado". [ 3 ]

La característica de "no lineal", un "sistema no necesita cambiar proporcionalmente al cambio en una variable" [ 4 ], proporciona la flexibilidad para capturar matemáticamente la idea de que todos los sistemas naturales y artificiales son redes que incluyen bucles de retroalimentación. Esta conectividad, diferentes variables en red en diferentes estados en diferentes momentos, explica la naturaleza no determinista de los sistemas complejos, la naturaleza multivariable de los sistemas y la calidad emergente de estos sistemas. La emergencia es una característica del sistema donde las características del todo no pueden ser explicadas de forma aditiva por los componentes. El agua que se convierte en hielo es un ejemplo de emergencia. Lo que nos mostró la complejidad fue otro tipo de sistema explicado por principios que iban mucho más allá de la ciencia cartesiana.

Una característica de los sistemas complejos explica por qué ML ha progresado tanto como herramienta para explicar la ciencia. Los sistemas complejos son jerárquicos de abajo hacia arriba. Lo que esto significa es que las partículas cuánticas se unen para formar átomos que se convierten en moléculas, luego en células, órganos (sistemas) y finalmente en humanos (sistemas). Herbert Simon, economista Nobel, llamó a esta combinación de síntesis de componentes [ 5 ] y es la base de la creatividad y la evolución humana. La máquina tragamonedas gira y los resultados cambian cada vez que tiras de la palanca. Algunos resultados en cualquier nivel de la jerarquía de los sistemas mejoran la capacidad de supervivencia y otras variaciones no. Ya sea un proceso sintético o natural, este proceso combinatorio crea la variedad para mejorar potencialmente los resultados. Esta noción del proceso combinatorio es la base intelectual de la biología computacional, la química y la física.

EO Wilson, legendario profesor de biología en Harvard, lo explica bien.

“Nos estamos ahogando en información, mientras estamos hambrientos de sabiduría. De ahora en adelante, el mundo estará dirigido por sintetizadores, personas capaces de recopilar la información correcta en el momento adecuado, pensar críticamente al respecto y tomar decisiones importantes sabiamente”. (1999)

Con base en este pensamiento, Wilson fundó lo que se denominó biología computacional: la aplicación de ML a la investigación biológica. En biología, no solo teníamos que considerar los animales y las especies, sino todos los genomas y su jerarquía de múltiples capas de componentes. A medida que los conjuntos de datos aumentaron de tamaño con el tiempo, la aplicación de ML se expandió desde el análisis de datos hasta el análisis predictivo y prescriptivo, desde la biología hasta la ciencia médica, la agricultura, la ciencia de los materiales y las aplicaciones ciberfísicas. ML fue la herramienta perfecta para el reconocimiento de patrones en una amplia gama de disciplinas. Eventualmente, nos dimos cuenta de que el ML podía usarse para algo más que analizar datos. ML podría usarse para desarrollar soluciones propuestas a problemas en medicina, ciencia de materiales, agricultura y muchos otros campos. ML podría analizar las combinaciones sintéticas de componentes para determinar las mejores soluciones teóricas. Ya no teníamos que evaluar miles y miles de soluciones. El ML preseleccionó las soluciones, redujo la carga de trabajo y, lo que es más importante, acortó el tiempo de comercialización (para soluciones que salvan vidas).

Hannah Fry explica lo que realmente sucedió.

“Las matemáticas se tratan de abstraerse de la realidad, no de replicarla. Y ofrece valor real en el proceso. Al permitirte ver el mundo desde una perspectiva abstracta, creas un lenguaje que es excepcionalmente capaz de capturar y describir los patrones y mecanismos que de otro modo permanecerían ocultos. Y, como le dirá cualquier científico o ingeniero de los últimos 200 años, comprender estos patrones es el primer paso para poder explotarlos”. [ 6 ]

ML, como lo había anticipado Wilson, se convirtió en la mejor herramienta de la historia para la manipulación matemática mediante el uso de algoritmos para el reconocimiento de patrones. Como explica el economista de la complejidad W. Bryan Arthur, “Con las ecuaciones manipulamos el sistema para llegar a alguna forma que buscamos: alguna expresión de una solución, alguna fórmula, alguna condición necesaria, alguna estructura matemática, alguna demostración buscada de un verdad contenida en el sistema”. … “Los algoritmos nos dan la posibilidad de estudiar la formación. El investigador estudia qué proceso generativo produce un patrón dado y cómo esto puede variar con diferentes diseños algorítmicos. Así que hay un ir y venir entre el patrón o estructura formado y el algoritmo que lo ha formado. El estilo se vuelve experimental: un algoritmo produce alguna estructura, y esa estructura retroalimenta la consulta del algoritmo que la produjo”. [ 7 ] El siguiente paso en la evolución de ML fue reutilizar este "proceso generativo".

A medida que ML creció en popularidad y utilidad, la computación en la nube floreció y se prevé que alcance ingresos de más de $ 1 billón para 2026/2027, según Synergy Research. [ 8 ] La computación en la nube combinada con una mejor tecnología de base de datos permitió la expansión del tamaño del conjunto de datos para cualquier problema en particular. A medida que la tecnología de la base de datos mejoró, se vio acompañada por una mejora en la variedad de algoritmos de ML disponibles. Un conjunto de algoritmos que surgió fue la IA generativa, que atrajo mucha atención por su manipulación de datos de texto y arte para producir escritura y arte originales. El desarrollo más significativo fue el uso de la IA generativa en la ciencia.

La IA generativa viene en muchas versiones: no supervisada, supervisada y de refuerzo. Independientemente del estilo del algoritmo, los datos sintéticos se utilizan como salida en forma de escritos o arte o como nuevos datos de entrenamiento para refinar los algoritmos. Este uso de datos sintéticos como datos de entrenamiento tiene muchos usos, incluso para hacer que los usuarios sean anónimos. Sin embargo, creo que el descubrimiento más emocionante lo explica Daphne Koller, científica informática, MacArthur Genius y directora ejecutiva de la empresa de biomedicina en etapa inicial Insitro. Usando datos sintéticos, lo que Insitro ha encontrado son nuevas características en los conjuntos de datos médicos que antes eran desconocidas para los investigadores. Básicamente, los algoritmos vieron patrones invisibles para los humanos y los duplicaron en los nuevos datos sintéticos. Koller cree que las nuevas características, que se repiten en futuros conjuntos de datos sintéticos, podrían llevar el estudio de la medicina a un nivel completamente nuevo de ciencia médica fundamental. [ 9 ] Esta lógica también podría aplicarse en casi cualquier campo computacional de las ciencias naturales para abrir el estudio de nuevos niveles de fundamentos.

Marc Andresseen, cofundador de la firma de capital de riesgo a16z, en una reciente Podcast, señala que la nueva tecnología nos permite "revisar los fundamentos". Históricamente, los científicos se han visto limitados por las herramientas al alcance experimental. La IA generativa tiene el potencial de transformar la ciencia en el nivel fundamental. La historia moderna de la ciencia fue moldeada inicialmente por el análisis de datos empíricos y validada por las matemáticas. Hoy, con datos sintéticos, estamos al borde de las matemáticas haciendo todo el proceso de descubrimiento con los científicos haciendo solo la validación clínica. Como dicen los capitalistas de riesgo de Air Street Capital, "la IA es lo primero por diseño". Este AI primero por diseño se explica bien en el Revista de quimioinformática:

“El uso de inteligencia artificial y aprendizaje automático (AI/ML) en el descubrimiento de fármacos ha aumentado rápidamente en los últimos años, proporcionando herramientas de diseño asistidas por IA para proyectos de diseño de fármacos. Las fortalezas de la IA radican en encontrar patrones a partir de una gran cantidad de datos de fuentes heterogéneas, en su mejor momento, aumentando las habilidades de los humanos en tareas desafiantes como la optimización molecular. Los avances en las herramientas de diseño molecular de novo permiten la automatización del paso de diseño en los ciclos de diseño de fármacos in silico design-make-test-analyse (DMTA). [ 10 ]

En este punto, los investigadores avanzados utilizan el ML para acelerar el nuevo enfoque, DMTA, para aumentar el desarrollo de nuevos productos químicos y medicamentos en una amplia gama de industrias. Los investigadores seguirán mejorando los algoritmos para optimizar el proceso, pero gran parte de la investigación científica se ha trasladado a modelos computacionales que están revolucionando la biología, la química y la ciencia médica.

Emad Mostaque, Fundador de Stable Diffusion, en el MIT Technology Review (febrero de 2023) destaca el punto.

“Google y Microsoft apuestan por la IA generativa como núcleo de su futuro. No hay ningún "todavía estamos temprano aquí", las empresas de billones de dólares están cambiando toda su estrategia y enfoque. No puedo recordar un cambio de tecnología y estrategia tan rápido y significativo como este”.

Comparar la IA generativa con Excel o el iPhone es subestimar el impacto potencial de esta nueva tecnología. El efecto de la IA generativa bien puede ser equivalente a la electricidad o la teoría de la información de Shannon. ¡La IA generativa será una superpotencia! [ 11 ]

En realidad no sabemos nada, porque la verdad está en las profundidades.

— Demócrito

Referencias

[ 1 ] La teoría del caos y sus aplicaciones en nuestra vida real

[ 2 ] Complejidad: la ciencia emergente al borde del orden y el caos por M. Mitchell Waldrop

[ 3 ] Funciones y secuencias deterministas

[ 4 ] Funciones y secuencias deterministas

[ 5 ] Las Ciencias de lo Artificial por Herbet A. Simón

[ 6 ] Las matemáticas del amor de Hannah Fry

[ 7 ] Algoritmos y el cambio en la ciencia moderna por W. Brian Arthur

[ 8 ] El gasto en la nube superará el billón de dólares en cuatro años

[ 9 ] Daphne Koller sobre el aprendizaje automático en el descubrimiento de fármacos: “Será un cambio de paradigma”

[ 10 ] Diseño molecular de novo asistido por humanos en el circuito

[ 11 ] Muchos han usado esta frase. No me queda claro quién merece el crédito.

Este artículo se publicó originalmente el Mediana y re-publicado a TOPBOTS con permiso del autor.

¿Disfrutas este artículo? Regístrese para obtener más actualizaciones de investigación de IA.

Le informaremos cuando publiquemos más artículos de resumen como este.

Relacionado:

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://www.topbots.com/the-evolution-of-science-from-descartes-to-generative-ai/