En su centro, LangChain es un marco innovador diseñado para crear aplicaciones que aprovechan las capacidades de los modelos de lenguaje. Es un conjunto de herramientas diseñado para que los desarrolladores creen aplicaciones que tengan en cuenta el contexto y sean capaces de realizar un razonamiento sofisticado.

Esto significa que las aplicaciones de LangChain pueden comprender el contexto, como instrucciones rápidas o respuestas que fundamentan el contenido, y utilizar modelos de lenguaje para tareas de razonamiento complejas, como decidir cómo responder o qué acciones tomar. LangChain representa un enfoque unificado para desarrollar aplicaciones inteligentes, simplificando el viaje desde el concepto hasta la ejecución con sus diversos componentes.

Entendiendo LangChain

LangChain es mucho más que un simple marco; es un ecosistema completo que comprende varias partes integrales.

- En primer lugar, están las bibliotecas LangChain, disponibles tanto en Python como en JavaScript. Estas bibliotecas son la columna vertebral de LangChain y ofrecen interfaces e integraciones para varios componentes. Proporcionan un tiempo de ejecución básico para combinar estos componentes en cadenas y agentes cohesivos, junto con implementaciones listas para usar para uso inmediato.

- A continuación, tenemos las plantillas LangChain. Se trata de una colección de arquitecturas de referencia implementables diseñadas para una amplia gama de tareas. Ya sea que esté creando un chatbot o una herramienta analítica compleja, estas plantillas ofrecen un sólido punto de partida.

- LangServe interviene como una biblioteca versátil para implementar cadenas LangChain como API REST. Esta herramienta es esencial para convertir sus proyectos LangChain en servicios web accesibles y escalables.

- Por último, LangSmith sirve como plataforma de desarrollo. Está diseñado para depurar, probar, evaluar y monitorear cadenas creadas en cualquier marco LLM. La perfecta integración con LangChain la convierte en una herramienta indispensable para los desarrolladores que buscan refinar y perfeccionar sus aplicaciones.

Juntos, estos componentes le permiten desarrollar, producir e implementar aplicaciones con facilidad. Con LangChain, comienza escribiendo sus aplicaciones utilizando las bibliotecas y haciendo referencia a las plantillas como guía. Luego, LangSmith lo ayuda a inspeccionar, probar y monitorear sus cadenas, asegurando que sus aplicaciones mejoren constantemente y estén listas para su implementación. Finalmente, con LangServe, puedes transformar fácilmente cualquier cadena en una API, haciendo que la implementación sea muy sencilla.

En las siguientes secciones, profundizaremos en cómo configurar LangChain y comenzaremos su viaje hacia la creación de aplicaciones inteligentes basadas en modelos de lenguaje.

Automatice tareas manuales y flujos de trabajo con nuestro generador de flujos de trabajo impulsado por IA, diseñado por Nanonets para usted y sus equipos.

Instalación y configuración

¿Estás listo para sumergirte en el mundo de LangChain? Configurarlo es sencillo y esta guía lo guiará a través del proceso paso a paso.

El primer paso en su viaje a LangChain es instalarlo. Puedes hacer esto fácilmente usando pip o conda. Ejecute el siguiente comando en su terminal:

pip install langchain

Para aquellos que prefieren las últimas funciones y se sienten cómodos con un poco más de aventura, pueden instalar LangChain directamente desde la fuente. Clona el repositorio y navega hasta el langchain/libs/langchain directorio. Entonces corre:

pip install -e .

Para funciones experimentales, considere instalar langchain-experimental. Es un paquete que contiene código de vanguardia y está destinado a fines experimentales y de investigación. Instálalo usando:

pip install langchain-experimental

LangChain CLI es una herramienta útil para trabajar con plantillas de LangChain y proyectos de LangServe. Para instalar la CLI de LangChain, utilice:

pip install langchain-cli

LangServe es esencial para implementar sus cadenas LangChain como API REST. Se instala junto con la CLI de LangChain.

LangChain a menudo requiere integraciones con proveedores de modelos, almacenes de datos, API, etc. Para este ejemplo, usaremos las API modelo de OpenAI. Instale el paquete OpenAI Python usando:

pip install openai

Para acceder a la API, configure su clave API de OpenAI como una variable de entorno:

export OPENAI_API_KEY="your_api_key"

Alternativamente, pase la clave directamente en su entorno Python:

import os

os.environ['OPENAI_API_KEY'] = 'your_api_key'

LangChain permite la creación de aplicaciones de modelos de lenguaje a través de módulos. Estos módulos pueden ser independientes o estar compuestos para casos de uso complejos. Estos módulos son –

- Modelo de E / S: Facilita la interacción con varios modelos de lenguaje, manejando sus entradas y salidas de manera eficiente.

- Recuperación: permite el acceso y la interacción con datos específicos de la aplicación, crucial para la utilización dinámica de datos.

- Agentes: Permita que las aplicaciones seleccionen herramientas apropiadas basadas en directivas de alto nivel, mejorando las capacidades de toma de decisiones.

- Cadenas: Ofrece composiciones predefinidas y reutilizables que sirven como componentes básicos para el desarrollo de aplicaciones.

- Salud Cerebral: Mantiene el estado de la aplicación a lo largo de múltiples ejecuciones en cadena, lo que es esencial para las interacciones sensibles al contexto.

Cada módulo se dirige a necesidades de desarrollo específicas, lo que convierte a LangChain en un conjunto de herramientas integral para crear aplicaciones de modelos de lenguaje avanzados.

Junto con los componentes anteriores, también tenemos Lenguaje de expresión LangChain (LCEL), que es una forma declarativa de componer módulos juntos fácilmente, y esto permite el encadenamiento de componentes utilizando una interfaz Runnable universal.

LCEL se parece a esto:

from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

from langchain.schema import BaseOutputParser # Example chain

chain = ChatPromptTemplate() | ChatOpenAI() | CustomOutputParser()

Ahora que hemos cubierto los conceptos básicos, continuaremos con:

- Profundice en cada módulo de Langchain en detalle.

- Aprenda a utilizar el lenguaje de expresión LangChain.

- Explore casos de uso comunes e impleméntelos.

- Implemente una aplicación de un extremo a otro con LangServe.

- Consulte LangSmith para depurar, probar y monitorear.

¡Vamos a empezar!

Módulo I: Modelo de E/S

En LangChain, el elemento central de cualquier aplicación gira en torno al modelo de lenguaje. Este módulo proporciona los componentes básicos esenciales para interactuar de forma eficaz con cualquier modelo de lenguaje, garantizando una integración y comunicación perfectas.

Componentes clave del modelo de E/S

- LLM y modelos de chat (usados indistintamente):

- LLM:

- Definición: Modelos de finalización de texto puro.

- Entrada / Salida: toma una cadena de texto como entrada y devuelve una cadena de texto como salida.

- Modelos de chat

- LLM:

- Definición: Modelos que utilizan un modelo de lenguaje como base pero difieren en los formatos de entrada y salida.

- Entrada / Salida: acepte una lista de mensajes de chat como entrada y devuelva un mensaje de chat.

- Mensajes del sistema: cree plantillas, seleccione dinámicamente y administre entradas del modelo. Permite la creación de indicaciones flexibles y específicas del contexto que guían las respuestas del modelo de lenguaje.

- Analizadores de salida: Extrae y formatea información de los resultados del modelo. Útil para convertir la salida sin procesar de modelos de lenguaje en datos estructurados o formatos específicos necesarios para la aplicación.

LLM

La integración de LangChain con modelos de lenguajes grandes (LLM) como OpenAI, Cohere y Hugging Face es un aspecto fundamental de su funcionalidad. LangChain en sí no alberga LLM, pero ofrece una interfaz uniforme para interactuar con varios LLM.

Esta sección proporciona una descripción general del uso del contenedor OpenAI LLM en LangChain, aplicable también a otros tipos de LLM. Ya lo hemos instalado en la sección "Comenzando". Inicialicemos el LLM.

from langchain.llms import OpenAI

llm = OpenAI()

- Los LLM implementan el Interfaz ejecutable, el componente básico de la Lenguaje de expresión LangChain (LCEL). Esto significa que apoyan

invoke,ainvoke,stream,astream,batch,abatch,astream_logllamadas. - Los LLM aceptan instrumentos de cuerda como entradas u objetos que pueden ser obligados a encadenar mensajes, incluidos

List[BaseMessage]yPromptValue. (más sobre esto más adelante)

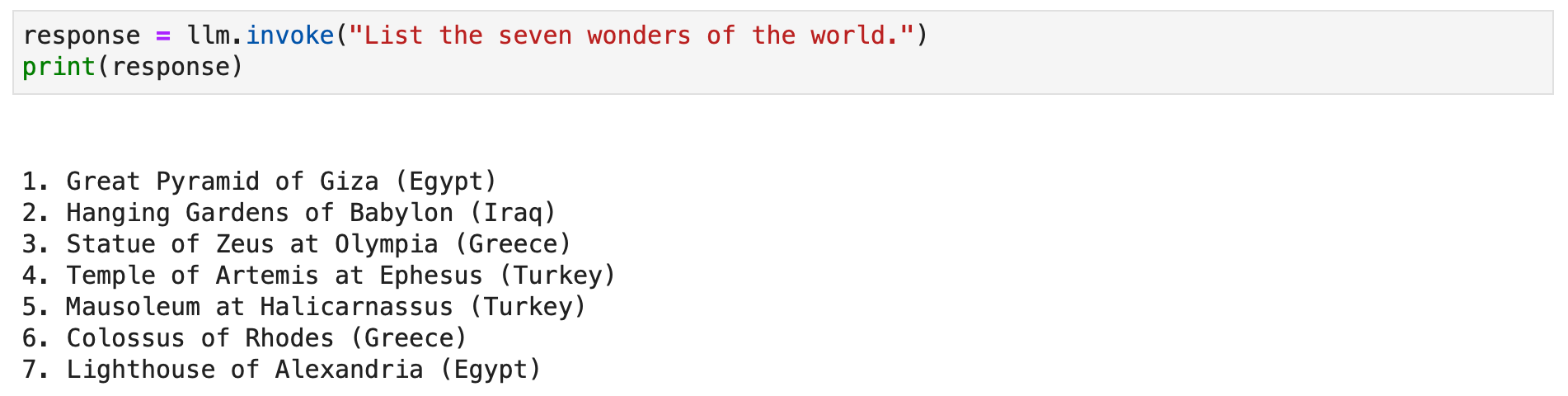

Veamos algunos ejemplos.

response = llm.invoke("List the seven wonders of the world.")

print(response)

Alternativamente, puede llamar al método de transmisión para transmitir la respuesta de texto.

for chunk in llm.stream("Where were the 2012 Olympics held?"): print(chunk, end="", flush=True)

Modelos de chat

La integración de LangChain con modelos de chat, una variación especializada de modelos de lenguaje, es esencial para crear aplicaciones de chat interactivas. Si bien utilizan modelos de lenguaje internamente, los modelos de chat presentan una interfaz distinta centrada en los mensajes de chat como entradas y salidas. Esta sección proporciona una descripción detallada del uso del modelo de chat de OpenAI en LangChain.

from langchain.chat_models import ChatOpenAI

chat = ChatOpenAI()

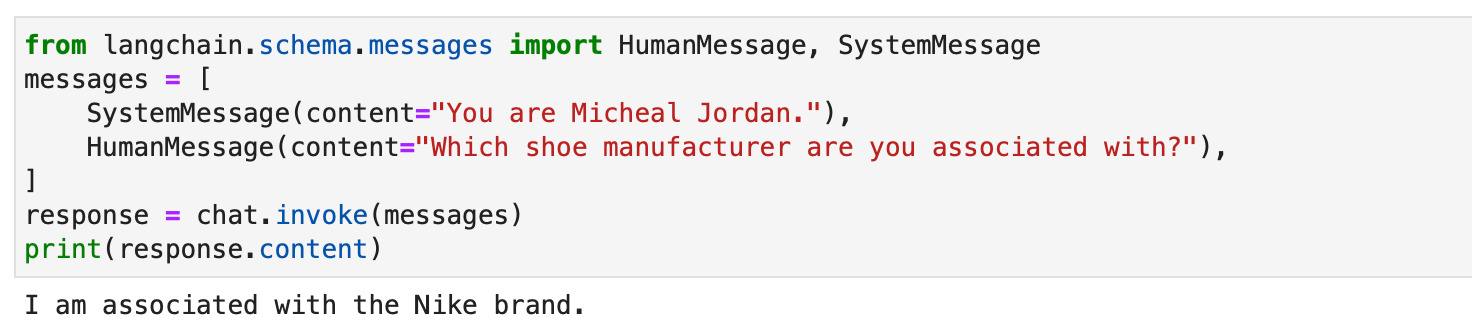

Los modelos de chat en LangChain funcionan con diferentes tipos de mensajes, como AIMessage, HumanMessage, SystemMessage, FunctionMessagey ChatMessage (con un parámetro de rol arbitrario). Generalmente, HumanMessage, AIMessagey SystemMessage son los más utilizados.

Los modelos de chat aceptan principalmente List[BaseMessage] como entradas. Las cadenas se pueden convertir a HumanMessagey PromptValue también es compatible.

from langchain.schema.messages import HumanMessage, SystemMessage

messages = [ SystemMessage(content="You are Micheal Jordan."), HumanMessage(content="Which shoe manufacturer are you associated with?"),

]

response = chat.invoke(messages)

print(response.content)

Mensajes del sistema

Las indicaciones son esenciales para guiar los modelos lingüísticos a fin de generar resultados relevantes y coherentes. Pueden variar desde instrucciones simples hasta ejemplos complejos de pocas tomas. En LangChain, manejar avisos puede ser un proceso muy simplificado, gracias a varias clases y funciones dedicadas.

LangChain de PromptTemplate class es una herramienta versátil para crear mensajes de cadena. Utiliza Python str.format sintaxis, lo que permite la generación dinámica de mensajes. Puede definir una plantilla con marcadores de posición y completarlos con valores específicos según sea necesario.

from langchain.prompts import PromptTemplate # Simple prompt with placeholders

prompt_template = PromptTemplate.from_template( "Tell me a {adjective} joke about {content}."

) # Filling placeholders to create a prompt

filled_prompt = prompt_template.format(adjective="funny", content="robots")

print(filled_prompt)Para los modelos de chat, las indicaciones están más estructuradas e incluyen mensajes con roles específicos. LangChain ofrece ChatPromptTemplate para este propósito.

from langchain.prompts import ChatPromptTemplate # Defining a chat prompt with various roles

chat_template = ChatPromptTemplate.from_messages( [ ("system", "You are a helpful AI bot. Your name is {name}."), ("human", "Hello, how are you doing?"), ("ai", "I'm doing well, thanks!"), ("human", "{user_input}"), ]

) # Formatting the chat prompt

formatted_messages = chat_template.format_messages(name="Bob", user_input="What is your name?")

for message in formatted_messages: print(message)

Este enfoque permite la creación de chatbots interactivos y atractivos con respuestas dinámicas.

Ambos PromptTemplate y ChatPromptTemplate integrarse perfectamente con LangChain Expression Language (LCEL), lo que les permite formar parte de flujos de trabajo más grandes y complejos. Hablaremos más sobre esto más adelante.

Las plantillas de mensajes personalizados a veces son esenciales para tareas que requieren un formato único o instrucciones específicas. La creación de una plantilla de solicitud personalizada implica definir variables de entrada y un método de formato personalizado. Esta flexibilidad permite a LangChain atender una amplia gama de requisitos específicos de aplicaciones. Lea más aquí.

LangChain también admite indicaciones breves, lo que permite que el modelo aprenda de ejemplos. Esta característica es vital para tareas que requieren comprensión contextual o patrones específicos. Se pueden crear plantillas de mensajes breves a partir de un conjunto de ejemplos o utilizando un objeto Selector de ejemplo. Lea más aquí.

Analizadores de salida

Los analizadores de resultados desempeñan un papel crucial en Langchain, ya que permiten a los usuarios estructurar las respuestas generadas por los modelos de lenguaje. En esta sección, exploraremos el concepto de analizadores de salida y proporcionaremos ejemplos de código utilizando PydanticOutputParser, SimpleJsonOutputParser, CommaSeparatedListOutputParser, DatetimeOutputParser y XMLOutputParser de Langchain.

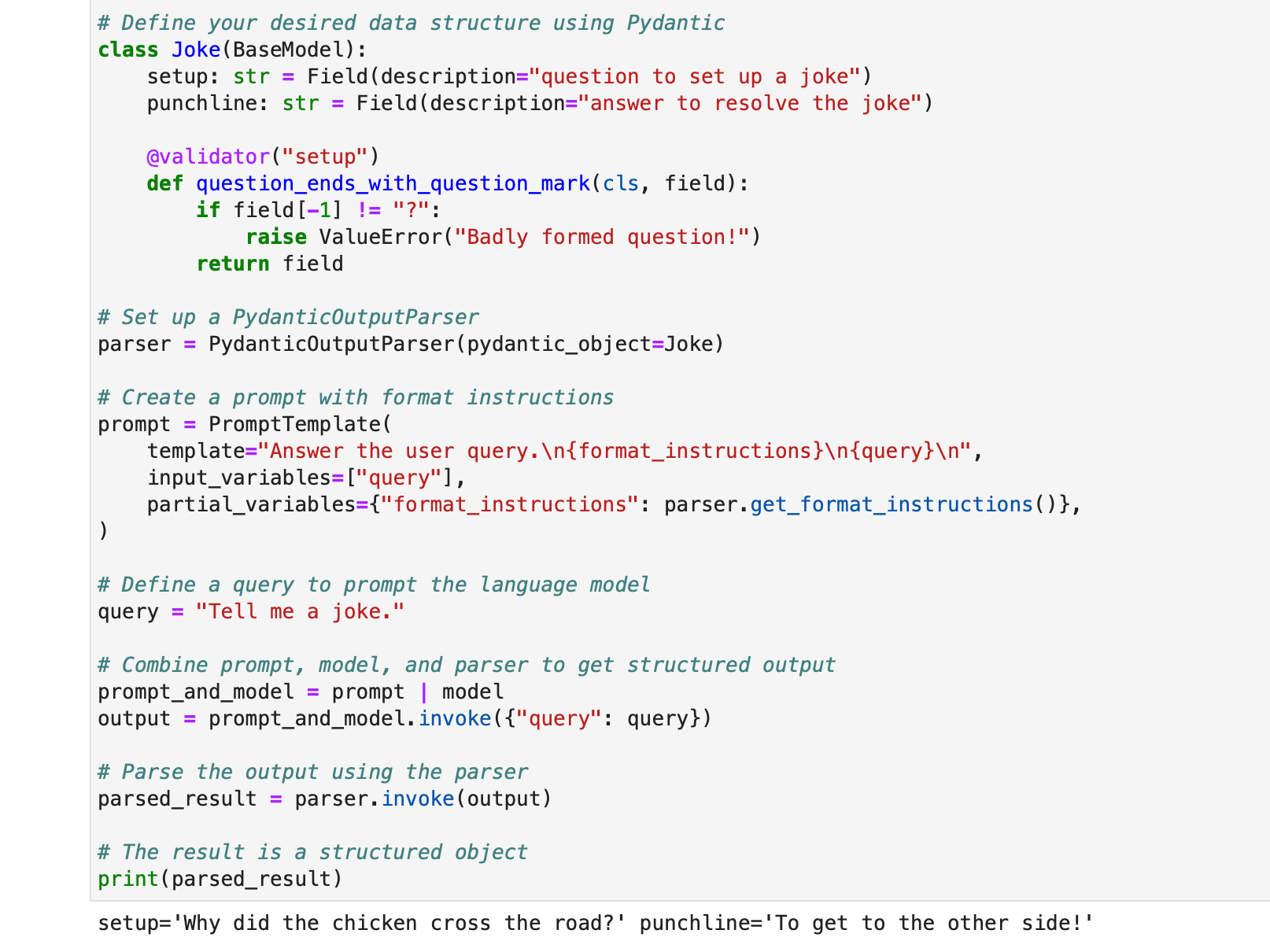

PydanticOutputParser

Langchain proporciona PydanticOutputParser para analizar respuestas en estructuras de datos de Pydantic. A continuación se muestra un ejemplo paso a paso de cómo utilizarlo:

from typing import List

from langchain.llms import OpenAI

from langchain.output_parsers import PydanticOutputParser

from langchain.prompts import PromptTemplate

from langchain.pydantic_v1 import BaseModel, Field, validator # Initialize the language model

model = OpenAI(model_name="text-davinci-003", temperature=0.0) # Define your desired data structure using Pydantic

class Joke(BaseModel): setup: str = Field(description="question to set up a joke") punchline: str = Field(description="answer to resolve the joke") @validator("setup") def question_ends_with_question_mark(cls, field): if field[-1] != "?": raise ValueError("Badly formed question!") return field # Set up a PydanticOutputParser

parser = PydanticOutputParser(pydantic_object=Joke) # Create a prompt with format instructions

prompt = PromptTemplate( template="Answer the user query.n{format_instructions}n{query}n", input_variables=["query"], partial_variables={"format_instructions": parser.get_format_instructions()},

) # Define a query to prompt the language model

query = "Tell me a joke." # Combine prompt, model, and parser to get structured output

prompt_and_model = prompt | model

output = prompt_and_model.invoke({"query": query}) # Parse the output using the parser

parsed_result = parser.invoke(output) # The result is a structured object

print(parsed_result)

La salida será:

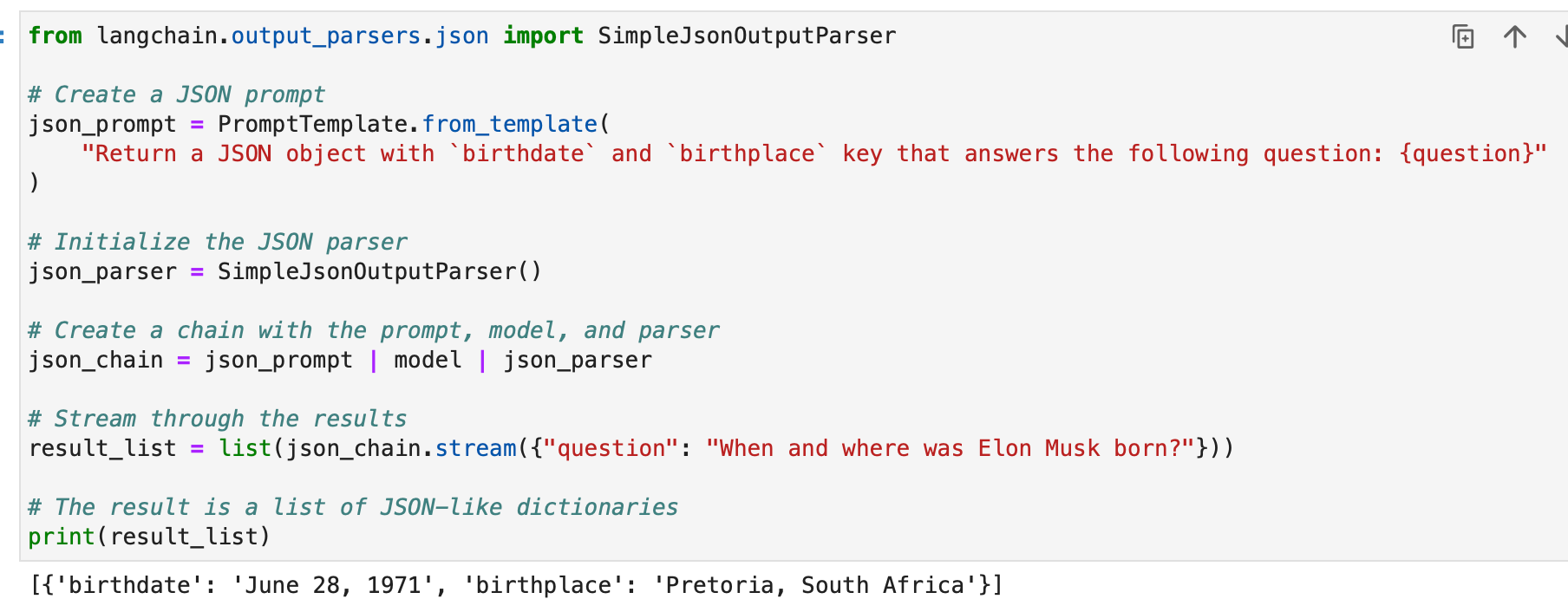

SimpleJsonOutputParser

SimpleJsonOutputParser de Langchain se utiliza cuando desea analizar salidas tipo JSON. He aquí un ejemplo:

from langchain.output_parsers.json import SimpleJsonOutputParser # Create a JSON prompt

json_prompt = PromptTemplate.from_template( "Return a JSON object with `birthdate` and `birthplace` key that answers the following question: {question}"

) # Initialize the JSON parser

json_parser = SimpleJsonOutputParser() # Create a chain with the prompt, model, and parser

json_chain = json_prompt | model | json_parser # Stream through the results

result_list = list(json_chain.stream({"question": "When and where was Elon Musk born?"})) # The result is a list of JSON-like dictionaries

print(result_list)

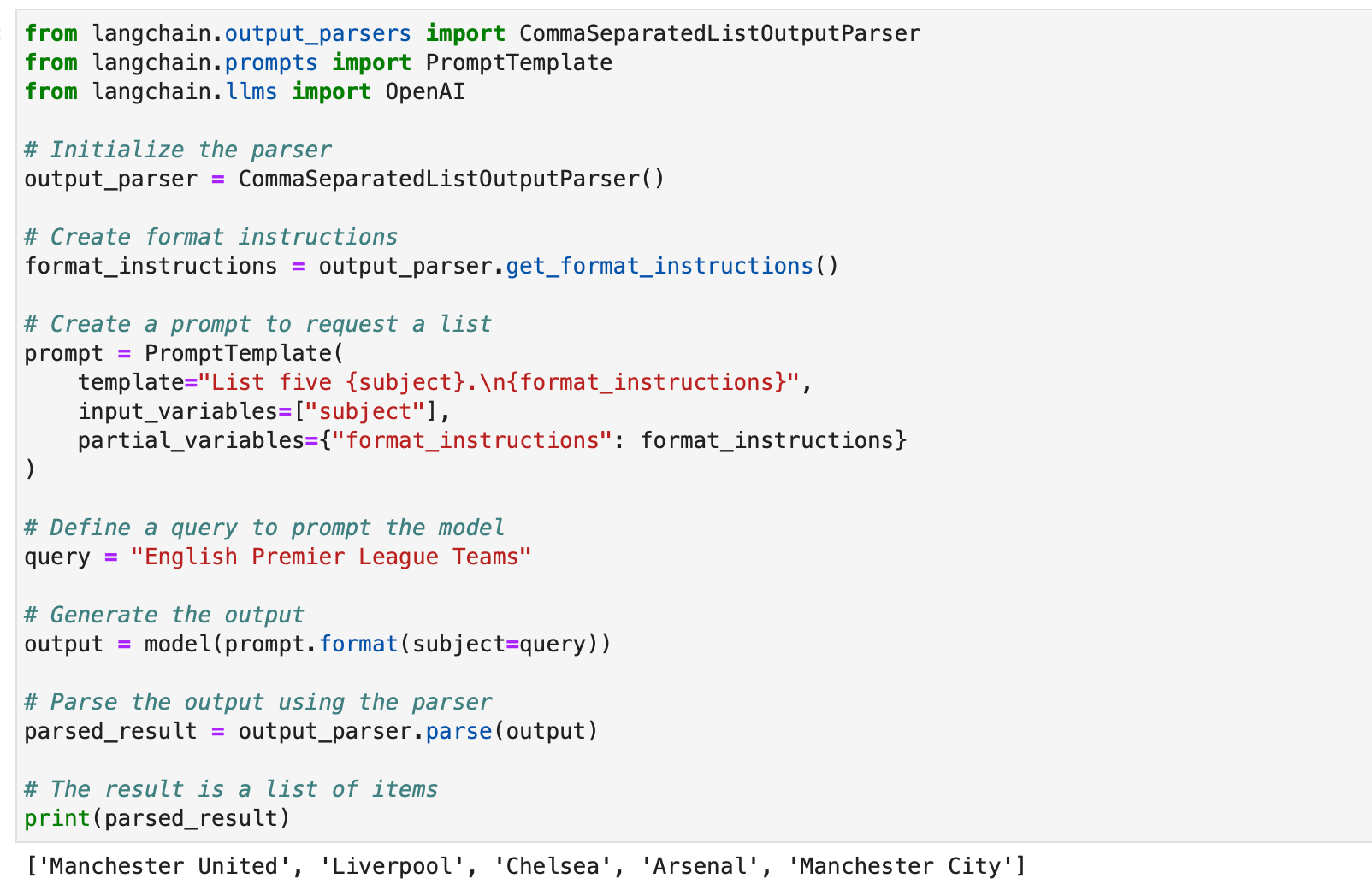

CommaSeparatedListOutputParser

CommaSeparatedListOutputParser es útil cuando desea extraer listas separadas por comas de las respuestas del modelo. He aquí un ejemplo:

from langchain.output_parsers import CommaSeparatedListOutputParser

from langchain.prompts import PromptTemplate

from langchain.llms import OpenAI # Initialize the parser

output_parser = CommaSeparatedListOutputParser() # Create format instructions

format_instructions = output_parser.get_format_instructions() # Create a prompt to request a list

prompt = PromptTemplate( template="List five {subject}.n{format_instructions}", input_variables=["subject"], partial_variables={"format_instructions": format_instructions}

) # Define a query to prompt the model

query = "English Premier League Teams" # Generate the output

output = model(prompt.format(subject=query)) # Parse the output using the parser

parsed_result = output_parser.parse(output) # The result is a list of items

print(parsed_result)

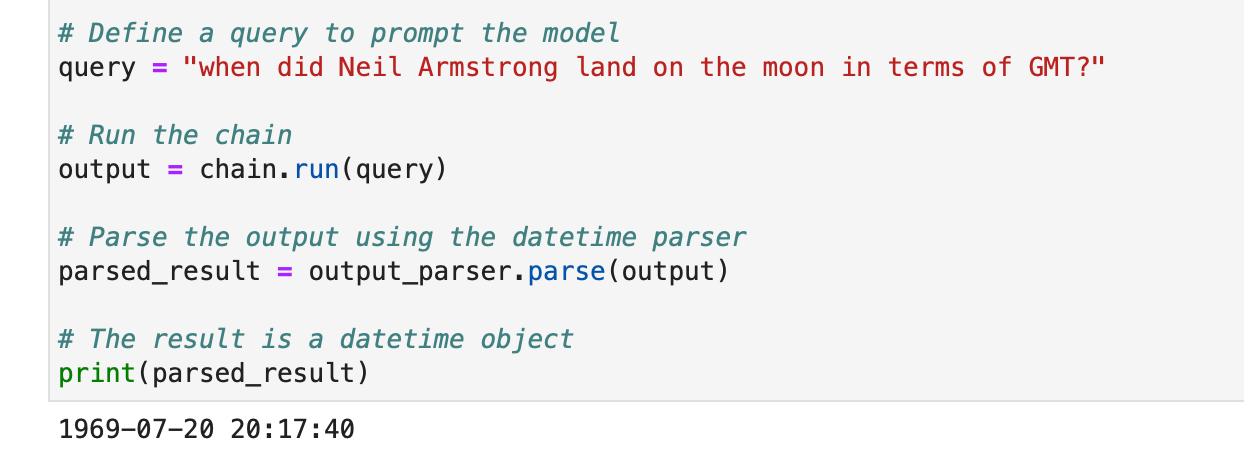

Analizador de salida de fecha y hora

DatetimeOutputParser de Langchain está diseñado para analizar información de fecha y hora. Aquí se explica cómo usarlo:

from langchain.prompts import PromptTemplate

from langchain.output_parsers import DatetimeOutputParser

from langchain.chains import LLMChain

from langchain.llms import OpenAI # Initialize the DatetimeOutputParser

output_parser = DatetimeOutputParser() # Create a prompt with format instructions

template = """

Answer the user's question:

{question}

{format_instructions} """ prompt = PromptTemplate.from_template( template, partial_variables={"format_instructions": output_parser.get_format_instructions()},

) # Create a chain with the prompt and language model

chain = LLMChain(prompt=prompt, llm=OpenAI()) # Define a query to prompt the model

query = "when did Neil Armstrong land on the moon in terms of GMT?" # Run the chain

output = chain.run(query) # Parse the output using the datetime parser

parsed_result = output_parser.parse(output) # The result is a datetime object

print(parsed_result)

Estos ejemplos muestran cómo se pueden utilizar los analizadores de salida de Langchain para estructurar varios tipos de respuestas de modelos, haciéndolos adecuados para diferentes aplicaciones y formatos. Los analizadores de resultados son una herramienta valiosa para mejorar la usabilidad y la interpretabilidad de los resultados del modelo de lenguaje en Langchain.

Automatice tareas manuales y flujos de trabajo con nuestro generador de flujos de trabajo impulsado por IA, diseñado por Nanonets para usted y sus equipos.

Módulo II: Recuperación

La recuperación en LangChain juega un papel crucial en aplicaciones que requieren datos específicos del usuario, no incluidos en el conjunto de entrenamiento del modelo. Este proceso, conocido como generación aumentada de recuperación (RAG), implica recuperar datos externos e integrarlos en el proceso de generación del modelo de lenguaje. LangChain proporciona un conjunto completo de herramientas y funcionalidades para facilitar este proceso, atendiendo tanto a aplicaciones simples como complejas.

LangChain logra la recuperación a través de una serie de componentes que discutiremos uno por uno.

Cargadores de documentos

Los cargadores de documentos en LangChain permiten la extracción de datos de diversas fuentes. Con más de 100 cargadores disponibles, admiten una variedad de tipos de documentos, aplicaciones y fuentes (depósitos S3 privados, sitios web públicos, bases de datos).

Puede elegir un cargador de documentos según sus requisitos esta página.

Todos estos cargadores ingieren datos en Documento clases. Más adelante aprenderemos a utilizar los datos ingeridos en las clases de Documentos.

Cargador de archivos de texto: Cargar un sencillo .txt archivar en un documento.

from langchain.document_loaders import TextLoader loader = TextLoader("./sample.txt")

document = loader.load()

Cargador CSV: Cargue un archivo CSV en un documento.

from langchain.document_loaders.csv_loader import CSVLoader loader = CSVLoader(file_path='./example_data/sample.csv')

documents = loader.load()

Podemos optar por personalizar el análisis especificando nombres de campos:

loader = CSVLoader(file_path='./example_data/mlb_teams_2012.csv', csv_args={ 'delimiter': ',', 'quotechar': '"', 'fieldnames': ['MLB Team', 'Payroll in millions', 'Wins']

})

documents = loader.load()

Cargadores de PDF: Los cargadores de PDF en LangChain ofrecen varios métodos para analizar y extraer contenido de archivos PDF. Cada cargador satisface diferentes requisitos y utiliza diferentes bibliotecas subyacentes. A continuación se muestran ejemplos detallados para cada cargador.

PyPDFLoader se utiliza para el análisis básico de PDF.

from langchain.document_loaders import PyPDFLoader loader = PyPDFLoader("example_data/layout-parser-paper.pdf")

pages = loader.load_and_split()

MathPixLoader es ideal para extraer diagramas y contenido matemático.

from langchain.document_loaders import MathpixPDFLoader loader = MathpixPDFLoader("example_data/math-content.pdf")

data = loader.load()

PyMuPDFLoader es rápido e incluye extracción detallada de metadatos.

from langchain.document_loaders import PyMuPDFLoader loader = PyMuPDFLoader("example_data/layout-parser-paper.pdf")

data = loader.load() # Optionally pass additional arguments for PyMuPDF's get_text() call

data = loader.load(option="text")

PDFMiner Loader se utiliza para un control más granular sobre la extracción de texto.

from langchain.document_loaders import PDFMinerLoader loader = PDFMinerLoader("example_data/layout-parser-paper.pdf")

data = loader.load()

AmazonTextractPDFParser utiliza AWS Textract para OCR y otras funciones avanzadas de análisis de PDF.

from langchain.document_loaders import AmazonTextractPDFLoader # Requires AWS account and configuration

loader = AmazonTextractPDFLoader("example_data/complex-layout.pdf")

documents = loader.load()

PDFMinerPDFasHTMLLoader genera HTML a partir de PDF para análisis semántico.

from langchain.document_loaders import PDFMinerPDFasHTMLLoader loader = PDFMinerPDFasHTMLLoader("example_data/layout-parser-paper.pdf")

data = loader.load()

PDFPlumberLoader proporciona metadatos detallados y admite un documento por página.

from langchain.document_loaders import PDFPlumberLoader loader = PDFPlumberLoader("example_data/layout-parser-paper.pdf")

data = loader.load()

Cargadores integrados: LangChain ofrece una amplia variedad de cargadores personalizados para cargar datos directamente desde sus aplicaciones (como Slack, Sigma, Notion, Confluence, Google Drive y muchas más) y bases de datos y utilizarlos en aplicaciones LLM.

La lista completa es esta página.

A continuación se muestran un par de ejemplos para ilustrar esto:

Ejemplo I: holgura

Slack, una plataforma de mensajería instantánea ampliamente utilizada, se puede integrar en aplicaciones y flujos de trabajo de LLM.

- Vaya a la página de Gestión del espacio de trabajo de Slack.

- Navegue hasta

{your_slack_domain}.slack.com/services/export. - Seleccione el rango de fechas deseado e inicie la exportación.

- Slack notifica por correo electrónico y DM una vez que la exportación está lista.

- La exportación resulta en un

.ziparchivo ubicado en su carpeta de Descargas o en la ruta de descarga designada. - Asigna la ruta del archivo descargado.

.zippresentar a laLOCAL_ZIPFILE. - Ingrese al

SlackDirectoryLoaderdel desplegablelangchain.document_loaderspaquete.

from langchain.document_loaders import SlackDirectoryLoader SLACK_WORKSPACE_URL = "https://xxx.slack.com" # Replace with your Slack URL

LOCAL_ZIPFILE = "" # Path to the Slack zip file loader = SlackDirectoryLoader(LOCAL_ZIPFILE, SLACK_WORKSPACE_URL)

docs = loader.load()

print(docs)

Ejemplo II – Figma

Figma, una herramienta popular para el diseño de interfaces, ofrece una API REST para la integración de datos.

- Obtenga la clave del archivo Figma del formato URL:

https://www.figma.com/file/{filekey}/sampleFilename. - Los ID de nodo se encuentran en el parámetro URL

?node-id={node_id}. - Genere un token de acceso siguiendo las instrucciones en el Centro de ayuda de Figma.

- El

FigmaFileLoaderclase delangchain.document_loaders.figmase utiliza para cargar datos de Figma. - Varios módulos LangChain como

CharacterTextSplitter,ChatOpenAI, etc., se emplean para el procesamiento.

import os

from langchain.document_loaders.figma import FigmaFileLoader

from langchain.text_splitter import CharacterTextSplitter

from langchain.chat_models import ChatOpenAI

from langchain.indexes import VectorstoreIndexCreator

from langchain.chains import ConversationChain, LLMChain

from langchain.memory import ConversationBufferWindowMemory

from langchain.prompts.chat import ChatPromptTemplate, SystemMessagePromptTemplate, AIMessagePromptTemplate, HumanMessagePromptTemplate figma_loader = FigmaFileLoader( os.environ.get("ACCESS_TOKEN"), os.environ.get("NODE_IDS"), os.environ.get("FILE_KEY"),

) index = VectorstoreIndexCreator().from_loaders([figma_loader])

figma_doc_retriever = index.vectorstore.as_retriever()

- El

generate_codeLa función utiliza los datos de Figma para crear código HTML/CSS. - Emplea una conversación basada en plantilla con un modelo basado en GPT.

def generate_code(human_input): # Template for system and human prompts system_prompt_template = "Your coding instructions..." human_prompt_template = "Code the {text}. Ensure it's mobile responsive" # Creating prompt templates system_message_prompt = SystemMessagePromptTemplate.from_template(system_prompt_template) human_message_prompt = HumanMessagePromptTemplate.from_template(human_prompt_template) # Setting up the AI model gpt_4 = ChatOpenAI(temperature=0.02, model_name="gpt-4") # Retrieving relevant documents relevant_nodes = figma_doc_retriever.get_relevant_documents(human_input) # Generating and formatting the prompt conversation = [system_message_prompt, human_message_prompt] chat_prompt = ChatPromptTemplate.from_messages(conversation) response = gpt_4(chat_prompt.format_prompt(context=relevant_nodes, text=human_input).to_messages()) return response # Example usage

response = generate_code("page top header")

print(response.content)

- El

generate_codeLa función, cuando se ejecuta, devuelve código HTML/CSS basado en la entrada de diseño de Figma.

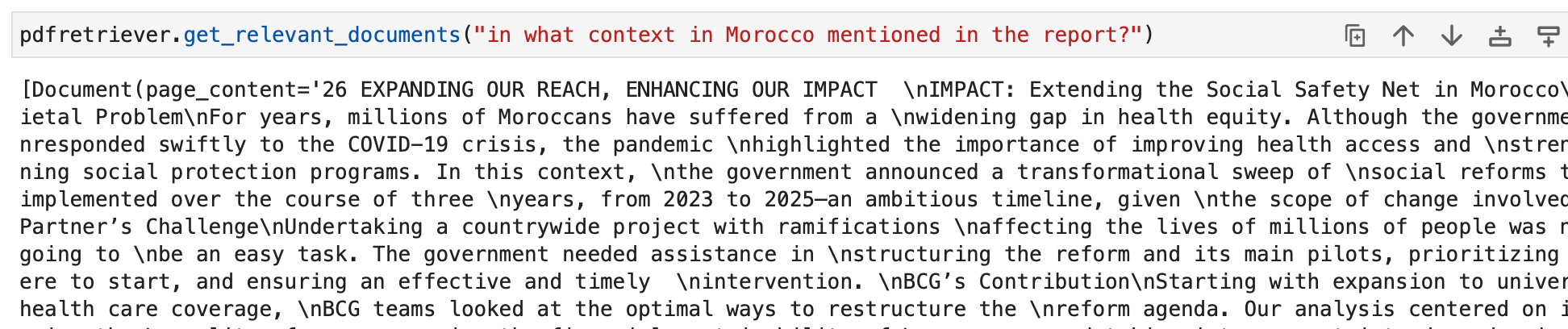

Usemos ahora nuestro conocimiento para crear algunos conjuntos de documentos.

Primero cargamos un PDF, el informe anual de sostenibilidad de BCG.

Usamos PyPDFLoader para esto.

from langchain.document_loaders import PyPDFLoader loader = PyPDFLoader("bcg-2022-annual-sustainability-report-apr-2023.pdf")

pdfpages = loader.load_and_split()

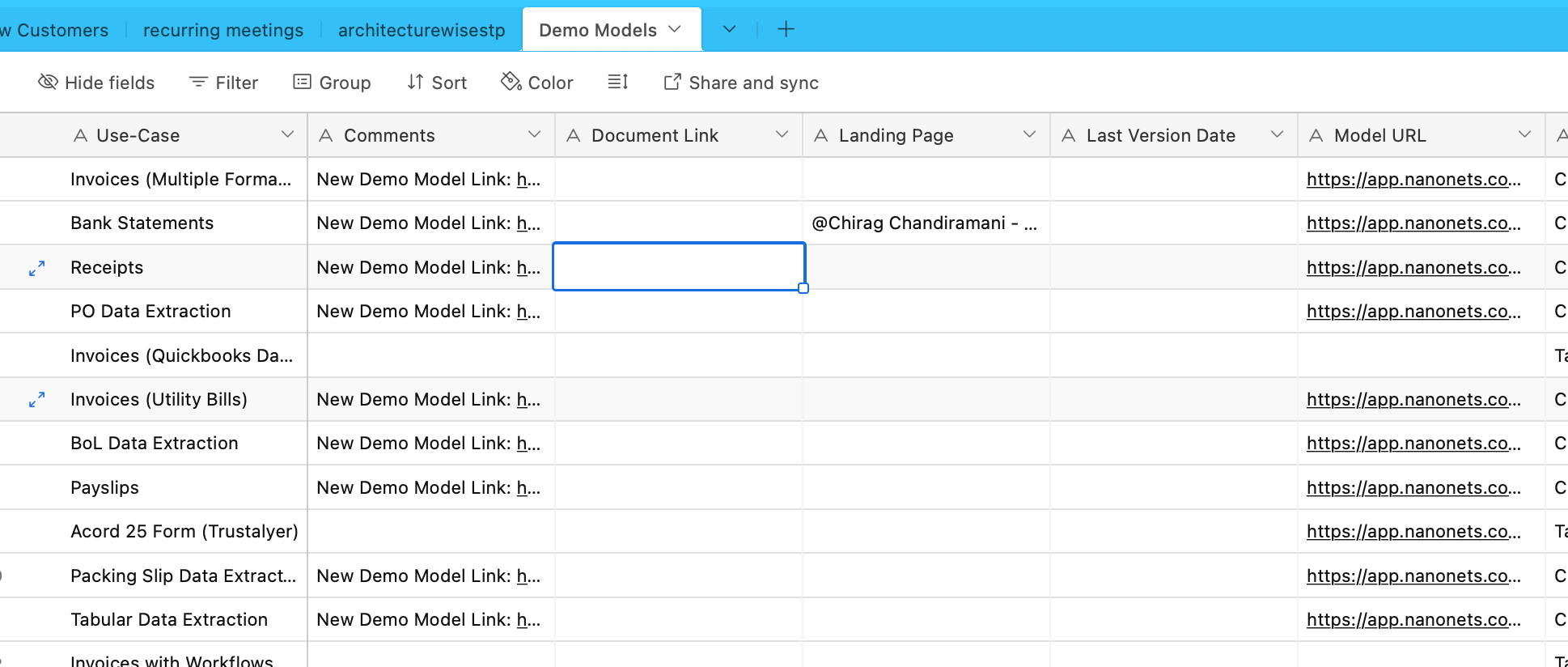

ingeriremos datos de Airtable ahora. Tenemos un Airtable que contiene información sobre varios modelos de extracción de datos y OCR:

Usemos para esto el AirtableLoader, que se encuentra en la lista de cargadores integrados.

from langchain.document_loaders import AirtableLoader api_key = "XXXXX"

base_id = "XXXXX"

table_id = "XXXXX" loader = AirtableLoader(api_key, table_id, base_id)

airtabledocs = loader.load()

Procedamos ahora y aprendamos a utilizar estas clases de documentos.

Transformadores de documentos

Los transformadores de documentos en LangChain son herramientas esenciales diseñadas para manipular documentos, que creamos en nuestra subsección anterior.

Se utilizan para tareas como dividir documentos largos en fragmentos más pequeños, combinarlos y filtrarlos, que son cruciales para adaptar documentos a la ventana contextual de un modelo o satisfacer necesidades de aplicaciones específicas.

Una de esas herramientas es RecursiveCharacterTextSplitter, un divisor de texto versátil que utiliza una lista de caracteres para dividir. Permite parámetros como tamaño de fragmento, superposición e índice inicial. Aquí hay un ejemplo de cómo se usa en Python:

from langchain.text_splitter import RecursiveCharacterTextSplitter state_of_the_union = "Your long text here..." text_splitter = RecursiveCharacterTextSplitter( chunk_size=100, chunk_overlap=20, length_function=len, add_start_index=True,

) texts = text_splitter.create_documents([state_of_the_union])

print(texts[0])

print(texts[1])

Otra herramienta es CharacterTextSplitter, que divide el texto según un carácter específico e incluye controles para el tamaño de los fragmentos y la superposición:

from langchain.text_splitter import CharacterTextSplitter text_splitter = CharacterTextSplitter( separator="nn", chunk_size=1000, chunk_overlap=200, length_function=len, is_separator_regex=False,

) texts = text_splitter.create_documents([state_of_the_union])

print(texts[0])

HTMLHeaderTextSplitter está diseñado para dividir el contenido HTML en función de las etiquetas de encabezado, conservando la estructura semántica:

from langchain.text_splitter import HTMLHeaderTextSplitter html_string = "Your HTML content here..."

headers_to_split_on = [("h1", "Header 1"), ("h2", "Header 2")] html_splitter = HTMLHeaderTextSplitter(headers_to_split_on=headers_to_split_on)

html_header_splits = html_splitter.split_text(html_string)

print(html_header_splits[0])

Se puede lograr una manipulación más compleja combinando HTMLHeaderTextSplitter con otro divisor, como Pipelined Splitter:

from langchain.text_splitter import HTMLHeaderTextSplitter, RecursiveCharacterTextSplitter url = "https://example.com"

headers_to_split_on = [("h1", "Header 1"), ("h2", "Header 2")]

html_splitter = HTMLHeaderTextSplitter(headers_to_split_on=headers_to_split_on)

html_header_splits = html_splitter.split_text_from_url(url) chunk_size = 500

text_splitter = RecursiveCharacterTextSplitter(chunk_size=chunk_size)

splits = text_splitter.split_documents(html_header_splits)

print(splits[0])

LangChain también ofrece divisores específicos para diferentes lenguajes de programación, como Python Code Splitter y JavaScript Code Splitter:

from langchain.text_splitter import RecursiveCharacterTextSplitter, Language python_code = """

def hello_world(): print("Hello, World!")

hello_world() """ python_splitter = RecursiveCharacterTextSplitter.from_language( language=Language.PYTHON, chunk_size=50

)

python_docs = python_splitter.create_documents([python_code])

print(python_docs[0]) js_code = """

function helloWorld() { console.log("Hello, World!");

}

helloWorld(); """ js_splitter = RecursiveCharacterTextSplitter.from_language( language=Language.JS, chunk_size=60

)

js_docs = js_splitter.create_documents([js_code])

print(js_docs[0])

Para dividir texto según el recuento de tokens, lo cual es útil para modelos de lenguaje con límites de tokens, se utiliza TokenTextSplitter:

from langchain.text_splitter import TokenTextSplitter text_splitter = TokenTextSplitter(chunk_size=10)

texts = text_splitter.split_text(state_of_the_union)

print(texts[0])

Finalmente, LongContextReorder reordena los documentos para evitar la degradación del rendimiento en los modelos debido a contextos largos:

from langchain.document_transformers import LongContextReorder reordering = LongContextReorder()

reordered_docs = reordering.transform_documents(docs)

print(reordered_docs[0])

Estas herramientas demuestran varias formas de transformar documentos en LangChain, desde una simple división de texto hasta una reordenación compleja y una división específica del idioma. Para casos de uso más detallados y específicos, se debe consultar la sección Integraciones y documentación de LangChain.

En nuestros ejemplos, los cargadores ya han creado documentos fragmentados para nosotros y esta parte ya está manejada.

Modelos de incrustación de texto

Los modelos de incrustación de texto en LangChain proporcionan una interfaz estandarizada para varios proveedores de modelos de incrustación como OpenAI, Cohere y Hugging Face. Estos modelos transforman el texto en representaciones vectoriales, permitiendo operaciones como la búsqueda semántica a través de similitud de texto en el espacio vectorial.

Para comenzar con los modelos de incrustación de texto, normalmente necesita instalar paquetes específicos y configurar claves API. Ya hemos hecho esto para OpenAI

En LangChain, el embed_documents El método se utiliza para incrustar múltiples textos, proporcionando una lista de representaciones vectoriales. Por ejemplo:

from langchain.embeddings import OpenAIEmbeddings # Initialize the model

embeddings_model = OpenAIEmbeddings() # Embed a list of texts

embeddings = embeddings_model.embed_documents( ["Hi there!", "Oh, hello!", "What's your name?", "My friends call me World", "Hello World!"]

)

print("Number of documents embedded:", len(embeddings))

print("Dimension of each embedding:", len(embeddings[0]))

Para incrustar un solo texto, como una consulta de búsqueda, el embed_query Se utiliza el método. Esto es útil para comparar una consulta con un conjunto de incrustaciones de documentos. Por ejemplo:

from langchain.embeddings import OpenAIEmbeddings # Initialize the model

embeddings_model = OpenAIEmbeddings() # Embed a single query

embedded_query = embeddings_model.embed_query("What was the name mentioned in the conversation?")

print("First five dimensions of the embedded query:", embedded_query[:5])

Comprender estas incorporaciones es crucial. Cada fragmento de texto se convierte en un vector, cuya dimensión depende del modelo utilizado. Por ejemplo, los modelos OpenAI suelen producir vectores de 1536 dimensiones. Estas incrustaciones se utilizan luego para recuperar información relevante.

La funcionalidad de integración de LangChain no se limita a OpenAI, sino que está diseñada para funcionar con varios proveedores. La configuración y el uso pueden diferir ligeramente según el proveedor, pero el concepto central de incrustar textos en el espacio vectorial sigue siendo el mismo. Para un uso detallado, incluidas configuraciones e integraciones avanzadas con diferentes proveedores de modelos de integración, la documentación de LangChain en la sección Integraciones es un recurso valioso.

Tiendas de vectores

Las tiendas de vectores en LangChain admiten el almacenamiento y la búsqueda eficientes de incrustaciones de texto. LangChain se integra con más de 50 tiendas de vectores, proporcionando una interfaz estandarizada para facilitar su uso.

Ejemplo: almacenamiento y búsqueda de incrustaciones

Después de incrustar textos, podemos almacenarlos en una tienda de vectores como Chroma y realizar búsquedas de similitud:

from langchain.vectorstores import Chroma db = Chroma.from_texts(embedded_texts)

similar_texts = db.similarity_search("search query")

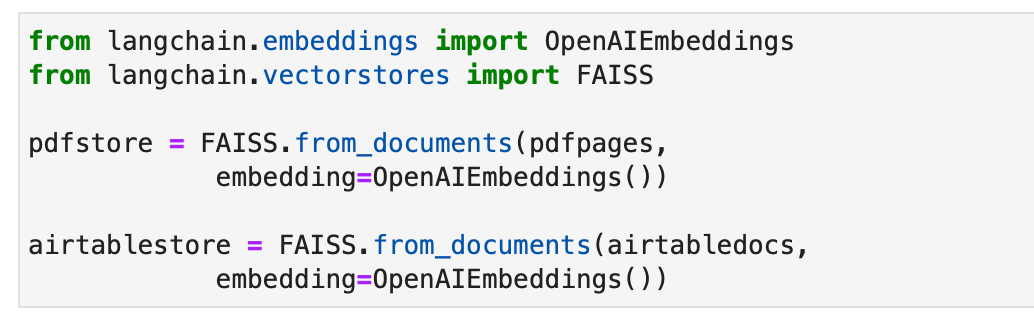

Alternativamente, usemos el almacén de vectores FAISS para crear índices para nuestros documentos.

from langchain.embeddings import OpenAIEmbeddings

from langchain.vectorstores import FAISS pdfstore = FAISS.from_documents(pdfpages, embedding=OpenAIEmbeddings()) airtablestore = FAISS.from_documents(airtabledocs, embedding=OpenAIEmbeddings())

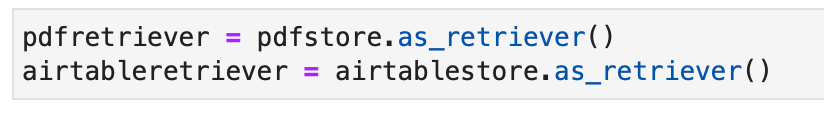

Perros perdigueros

Los recuperadores en LangChain son interfaces que devuelven documentos en respuesta a una consulta no estructurada. Son más generales que los almacenes de vectores y se centran en la recuperación más que en el almacenamiento. Aunque los almacenes de vectores se pueden utilizar como columna vertebral de un perro perdiguero, también existen otros tipos de perros perdigueros.

Para configurar un Chroma Retriever, primero instálelo usando pip install chromadb. Luego, carga, divide, incrusta y recupera documentos utilizando una serie de comandos de Python. Aquí hay un ejemplo de código para configurar un Chroma retriever:

from langchain.embeddings import OpenAIEmbeddings

from langchain.text_splitter import CharacterTextSplitter

from langchain.vectorstores import Chroma full_text = open("state_of_the_union.txt", "r").read()

text_splitter = CharacterTextSplitter(chunk_size=1000, chunk_overlap=100)

texts = text_splitter.split_text(full_text) embeddings = OpenAIEmbeddings()

db = Chroma.from_texts(texts, embeddings)

retriever = db.as_retriever() retrieved_docs = retriever.invoke("What did the president say about Ketanji Brown Jackson?")

print(retrieved_docs[0].page_content)

MultiQueryRetriever automatiza el ajuste rápido generando múltiples consultas para una consulta ingresada por el usuario y combina los resultados. Aquí hay un ejemplo de su uso simple:

from langchain.chat_models import ChatOpenAI

from langchain.retrievers.multi_query import MultiQueryRetriever question = "What are the approaches to Task Decomposition?"

llm = ChatOpenAI(temperature=0)

retriever_from_llm = MultiQueryRetriever.from_llm( retriever=db.as_retriever(), llm=llm

) unique_docs = retriever_from_llm.get_relevant_documents(query=question)

print("Number of unique documents:", len(unique_docs))

La compresión contextual en LangChain comprime los documentos recuperados utilizando el contexto de la consulta, asegurando que solo se devuelva información relevante. Esto implica la reducción de contenido y el filtrado de documentos menos relevantes. El siguiente ejemplo de código muestra cómo utilizar el recuperador de compresión contextual:

from langchain.llms import OpenAI

from langchain.retrievers import ContextualCompressionRetriever

from langchain.retrievers.document_compressors import LLMChainExtractor llm = OpenAI(temperature=0)

compressor = LLMChainExtractor.from_llm(llm)

compression_retriever = ContextualCompressionRetriever(base_compressor=compressor, base_retriever=retriever) compressed_docs = compression_retriever.get_relevant_documents("What did the president say about Ketanji Jackson Brown")

print(compressed_docs[0].page_content)

El EnsembleRetriever combina diferentes algoritmos de recuperación para lograr un mejor rendimiento. En el siguiente código se muestra un ejemplo de combinación de BM25 y FAISS Retrievers:

from langchain.retrievers import BM25Retriever, EnsembleRetriever

from langchain.vectorstores import FAISS bm25_retriever = BM25Retriever.from_texts(doc_list).set_k(2)

faiss_vectorstore = FAISS.from_texts(doc_list, OpenAIEmbeddings())

faiss_retriever = faiss_vectorstore.as_retriever(search_kwargs={"k": 2}) ensemble_retriever = EnsembleRetriever( retrievers=[bm25_retriever, faiss_retriever], weights=[0.5, 0.5]

) docs = ensemble_retriever.get_relevant_documents("apples")

print(docs[0].page_content)

MultiVector Retriever en LangChain permite consultar documentos con múltiples vectores por documento, lo cual es útil para capturar diferentes aspectos semánticos dentro de un documento. Los métodos para crear múltiples vectores incluyen dividirlos en partes más pequeñas, resumir o generar preguntas hipotéticas. Para dividir documentos en partes más pequeñas, se puede utilizar el siguiente código Python:

python

from langchain.retrievers.multi_vector import MultiVectorRetriever

from langchain.vectorstores import Chroma

from langchain.embeddings import OpenAIEmbeddings

from langchain.text_splitter import RecursiveCharacterTextSplitter

from langchain.storage import InMemoryStore

from langchain.document_loaders from TextLoader

import uuid loaders = [TextLoader("file1.txt"), TextLoader("file2.txt")]

docs = [doc for loader in loaders for doc in loader.load()]

text_splitter = RecursiveCharacterTextSplitter(chunk_size=10000)

docs = text_splitter.split_documents(docs) vectorstore = Chroma(collection_name="full_documents", embedding_function=OpenAIEmbeddings())

store = InMemoryStore()

id_key = "doc_id"

retriever = MultiVectorRetriever(vectorstore=vectorstore, docstore=store, id_key=id_key) doc_ids = [str(uuid.uuid4()) for _ in docs]

child_text_splitter = RecursiveCharacterTextSplitter(chunk_size=400)

sub_docs = [sub_doc for doc in docs for sub_doc in child_text_splitter.split_documents([doc])]

for sub_doc in sub_docs: sub_doc.metadata[id_key] = doc_ids[sub_docs.index(sub_doc)] retriever.vectorstore.add_documents(sub_docs)

retriever.docstore.mset(list(zip(doc_ids, docs)))

Otro método es generar resúmenes para una mejor recuperación debido a una representación del contenido más enfocada. A continuación se muestra un ejemplo de generación de resúmenes:

from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

from langchain.schema.output_parser import StrOutputParser

from langchain.schema.document import Document chain = (lambda x: x.page_content) | ChatPromptTemplate.from_template("Summarize the following document:nn{doc}") | ChatOpenAI(max_retries=0) | StrOutputParser()

summaries = chain.batch(docs, {"max_concurrency": 5}) summary_docs = [Document(page_content=s, metadata={id_key: doc_ids[i]}) for i, s in enumerate(summaries)]

retriever.vectorstore.add_documents(summary_docs)

retriever.docstore.mset(list(zip(doc_ids, docs)))

Generar preguntas hipotéticas relevantes para cada documento utilizando LLM es otro enfoque. Esto se puede hacer con el siguiente código:

functions = [{"name": "hypothetical_questions", "parameters": {"questions": {"type": "array", "items": {"type": "string"}}}}]

from langchain.output_parsers.openai_functions import JsonKeyOutputFunctionsParser chain = (lambda x: x.page_content) | ChatPromptTemplate.from_template("Generate 3 hypothetical questions:nn{doc}") | ChatOpenAI(max_retries=0).bind(functions=functions, function_call={"name": "hypothetical_questions"}) | JsonKeyOutputFunctionsParser(key_name="questions")

hypothetical_questions = chain.batch(docs, {"max_concurrency": 5}) question_docs = [Document(page_content=q, metadata={id_key: doc_ids[i]}) for i, questions in enumerate(hypothetical_questions) for q in questions]

retriever.vectorstore.add_documents(question_docs)

retriever.docstore.mset(list(zip(doc_ids, docs)))

El Parent Document Retriever es otro recuperador que logra un equilibrio entre la precisión de la incrustación y la retención del contexto al almacenar pequeños fragmentos y recuperar sus documentos principales más grandes. Su implementación es la siguiente:

from langchain.retrievers import ParentDocumentRetriever loaders = [TextLoader("file1.txt"), TextLoader("file2.txt")]

docs = [doc for loader in loaders for doc in loader.load()] child_splitter = RecursiveCharacterTextSplitter(chunk_size=400)

vectorstore = Chroma(collection_name="full_documents", embedding_function=OpenAIEmbeddings())

store = InMemoryStore()

retriever = ParentDocumentRetriever(vectorstore=vectorstore, docstore=store, child_splitter=child_splitter) retriever.add_documents(docs, ids=None) retrieved_docs = retriever.get_relevant_documents("query")

Un recuperador de consultas automáticas construye consultas estructuradas a partir de entradas de lenguaje natural y las aplica a su VectorStore subyacente. Su implementación se muestra en el siguiente código:

from langchain.chat_models from ChatOpenAI

from langchain.chains.query_constructor.base from AttributeInfo

from langchain.retrievers.self_query.base from SelfQueryRetriever metadata_field_info = [AttributeInfo(name="genre", description="...", type="string"), ...]

document_content_description = "Brief summary of a movie"

llm = ChatOpenAI(temperature=0) retriever = SelfQueryRetriever.from_llm(llm, vectorstore, document_content_description, metadata_field_info) retrieved_docs = retriever.invoke("query")

WebResearchRetriever realiza una investigación web basada en una consulta determinada:

from langchain.retrievers.web_research import WebResearchRetriever # Initialize components

llm = ChatOpenAI(temperature=0)

search = GoogleSearchAPIWrapper()

vectorstore = Chroma(embedding_function=OpenAIEmbeddings()) # Instantiate WebResearchRetriever

web_research_retriever = WebResearchRetriever.from_llm(vectorstore=vectorstore, llm=llm, search=search) # Retrieve documents

docs = web_research_retriever.get_relevant_documents("query")

Para nuestros ejemplos, también podemos usar el recuperador estándar ya implementado como parte de nuestro objeto de tienda de vectores de la siguiente manera:

Ahora podemos consultar a los perros perdigueros. El resultado de nuestra consulta serán objetos de documento relevantes para la consulta. En última instancia, se utilizarán para crear respuestas relevantes en secciones posteriores.

Automatice tareas manuales y flujos de trabajo con nuestro generador de flujos de trabajo impulsado por IA, diseñado por Nanonets para usted y sus equipos.

Módulo III: Agentes

LangChain presenta un poderoso concepto llamado "Agentes" que lleva la idea de cadenas a un nivel completamente nuevo. Los agentes aprovechan los modelos de lenguaje para determinar dinámicamente secuencias de acciones a realizar, lo que los hace increíblemente versátiles y adaptables. A diferencia de las cadenas tradicionales, donde las acciones están codificadas en código, los agentes emplean modelos de lenguaje como motores de razonamiento para decidir qué acciones tomar y en qué orden.

El agente es el componente central responsable de la toma de decisiones. Aprovecha el poder de un modelo de lenguaje y un mensaje para determinar los siguientes pasos para lograr un objetivo específico. Las entradas a un agente normalmente incluyen:

- Herramientas: Descripciones de herramientas disponibles (más sobre esto más adelante).

- Entrada del usuario: El objetivo de alto nivel o consulta del usuario.

- Pasos intermedios: Un historial de pares (acción, salida de herramienta) ejecutados para alcanzar la entrada actual del usuario.

La salida de un agente puede ser la siguiente. DE ACTUAR! tomar acciones (AgenteAcciones) o la final respuesta para enviar al usuario (AgenteFinalizar) Un DE ACTUAR! especifica un del IRS y del Las opciones de entrada para esa herramienta.

Herramientas

Las herramientas son interfaces que un agente puede utilizar para interactuar con el mundo. Permiten a los agentes realizar diversas tareas, como buscar en la web, ejecutar comandos de shell o acceder a API externas. En LangChain, las herramientas son esenciales para ampliar las capacidades de los agentes y permitirles realizar diversas tareas.

Para usar herramientas en LangChain, puede cargarlas usando el siguiente fragmento:

from langchain.agents import load_tools tool_names = [...]

tools = load_tools(tool_names)

Algunas herramientas pueden requerir un modelo de lenguaje base (LLM) para inicializarse. En tales casos, también puedes aprobar un LLM:

from langchain.agents import load_tools tool_names = [...]

llm = ...

tools = load_tools(tool_names, llm=llm)

Esta configuración le permite acceder a una variedad de herramientas e integrarlas en los flujos de trabajo de su agente. La lista completa de herramientas con documentación de uso es esta página.

Veamos algunos ejemplos de herramientas.

Pato Pato a ganar

La herramienta DuckDuckGo le permite realizar búsquedas web utilizando su motor de búsqueda. Aquí se explica cómo usarlo:

from langchain.tools import DuckDuckGoSearchRun

search = DuckDuckGoSearchRun()

search.run("manchester united vs luton town match summary")

DatosParaSeo

El kit de herramientas DataForSeo le permite obtener resultados de motores de búsqueda utilizando la API DataForSeo. Para utilizar este kit de herramientas, deberá configurar sus credenciales de API. A continuación se explica cómo configurar las credenciales:

import os os.environ["DATAFORSEO_LOGIN"] = "<your_api_access_username>"

os.environ["DATAFORSEO_PASSWORD"] = "<your_api_access_password>"

Una vez configuradas sus credenciales, puede crear una DataForSeoAPIWrapper herramienta para acceder a la API:

from langchain.utilities.dataforseo_api_search import DataForSeoAPIWrapper wrapper = DataForSeoAPIWrapper() result = wrapper.run("Weather in Los Angeles")

El DataForSeoAPIWrapper La herramienta recupera resultados del motor de búsqueda de varias fuentes.

Puede personalizar el tipo de resultados y campos devueltos en la respuesta JSON. Por ejemplo, puede especificar los tipos de resultados, los campos y establecer un recuento máximo para la cantidad de resultados principales que se devolverán:

json_wrapper = DataForSeoAPIWrapper( json_result_types=["organic", "knowledge_graph", "answer_box"], json_result_fields=["type", "title", "description", "text"], top_count=3,

) json_result = json_wrapper.results("Bill Gates")

Este ejemplo personaliza la respuesta JSON especificando tipos de resultados, campos y limitando la cantidad de resultados.

También puede especificar la ubicación y el idioma de los resultados de su búsqueda pasando parámetros adicionales al contenedor API:

customized_wrapper = DataForSeoAPIWrapper( top_count=10, json_result_types=["organic", "local_pack"], json_result_fields=["title", "description", "type"], params={"location_name": "Germany", "language_code": "en"},

) customized_result = customized_wrapper.results("coffee near me")

Al proporcionar parámetros de ubicación e idioma, puede adaptar los resultados de su búsqueda a regiones e idiomas específicos.

Tiene la flexibilidad de elegir el motor de búsqueda que desea utilizar. Simplemente especifique el motor de búsqueda deseado:

customized_wrapper = DataForSeoAPIWrapper( top_count=10, json_result_types=["organic", "local_pack"], json_result_fields=["title", "description", "type"], params={"location_name": "Germany", "language_code": "en", "se_name": "bing"},

) customized_result = customized_wrapper.results("coffee near me")

En este ejemplo, la búsqueda está personalizada para utilizar Bing como motor de búsqueda.

El contenedor API también le permite especificar el tipo de búsqueda que desea realizar. Por ejemplo, puedes realizar una búsqueda de mapas:

maps_search = DataForSeoAPIWrapper( top_count=10, json_result_fields=["title", "value", "address", "rating", "type"], params={ "location_coordinate": "52.512,13.36,12z", "language_code": "en", "se_type": "maps", },

) maps_search_result = maps_search.results("coffee near me")

Esto personaliza la búsqueda para recuperar información relacionada con mapas.

Shell (golpe)

El kit de herramientas de Shell proporciona a los agentes acceso al entorno de Shell, permitiéndoles ejecutar comandos de Shell. Esta característica es poderosa pero debe usarse con precaución, especialmente en entornos aislados. Así es como puede utilizar la herramienta Shell:

from langchain.tools import ShellTool shell_tool = ShellTool() result = shell_tool.run({"commands": ["echo 'Hello World!'", "time"]})

En este ejemplo, la herramienta Shell ejecuta dos comandos de Shell: haciendo eco de "¡Hola mundo!" y mostrando la hora actual.

Puede proporcionar la herramienta Shell a un agente para que realice tareas más complejas. A continuación se muestra un ejemplo de un agente que obtiene enlaces de una página web utilizando la herramienta Shell:

from langchain.agents import AgentType, initialize_agent

from langchain.chat_models import ChatOpenAI llm = ChatOpenAI(temperature=0.1) shell_tool.description = shell_tool.description + f"args {shell_tool.args}".replace( "{", "{{"

).replace("}", "}}")

self_ask_with_search = initialize_agent( [shell_tool], llm, agent=AgentType.CHAT_ZERO_SHOT_REACT_DESCRIPTION, verbose=True

)

self_ask_with_search.run( "Download the langchain.com webpage and grep for all urls. Return only a sorted list of them. Be sure to use double quotes."

)

En este escenario, el agente utiliza la herramienta Shell para ejecutar una secuencia de comandos para buscar, filtrar y ordenar URL de una página web.

Los ejemplos proporcionados demuestran algunas de las herramientas disponibles en LangChain. En última instancia, estas herramientas amplían las capacidades de los agentes (que se exploran en la siguiente subsección) y les permiten realizar diversas tareas de manera eficiente. Dependiendo de sus requisitos, puede elegir las herramientas y kits de herramientas que mejor se adapten a las necesidades de su proyecto e integrarlos en los flujos de trabajo de su agente.

Volver a Agentes

Pasemos ahora a los agentes.

AgentExecutor es el entorno de ejecución de un agente. Es responsable de llamar al agente, ejecutar las acciones que selecciona, pasar los resultados de la acción al agente y repetir el proceso hasta que el agente finalice. En pseudocódigo, AgentExecutor podría verse así:

next_action = agent.get_action(...)

while next_action != AgentFinish: observation = run(next_action) next_action = agent.get_action(..., next_action, observation)

return next_action

AgentExecutor maneja diversas complejidades, como lidiar con casos en los que el agente selecciona una herramienta inexistente, manejar errores de herramientas, administrar resultados producidos por el agente y proporcionar registro y observabilidad en todos los niveles.

Si bien la clase AgentExecutor es el tiempo de ejecución del agente principal en LangChain, se admiten otros tiempos de ejecución más experimentales, que incluyen:

- Agente de planificación y ejecución

- Bebé AGI

- GPT automático

Para comprender mejor el marco del agente, creemos un agente básico desde cero y luego pasemos a explorar los agentes prediseñados.

Antes de sumergirnos en la creación del agente, es esencial revisar algunos esquemas y terminología clave:

- Acción del agente: Esta es una clase de datos que representa la acción que debe realizar un agente. Consiste en un

toolpropiedad (el nombre de la herramienta a invocar) y untool_inputpropiedad (la entrada para esa herramienta). - AgenteFinalizar: Esta clase de datos indica que el agente ha finalizado su tarea y debe devolver una respuesta al usuario. Por lo general, incluye un diccionario de valores de retorno, a menudo con una "salida" clave que contiene el texto de respuesta.

- Pasos intermedios: Estos son los registros de acciones anteriores de los agentes y sus resultados correspondientes. Son cruciales para pasar contexto a futuras iteraciones del agente.

En nuestro ejemplo, usaremos llamadas a funciones OpenAI para crear nuestro agente. Este enfoque es confiable para la creación de agentes. Comenzaremos creando una herramienta sencilla que calcula la longitud de una palabra. Esta herramienta es útil porque los modelos de lenguaje a veces pueden cometer errores debido a la tokenización al contar la longitud de las palabras.

Primero, carguemos el modelo de lenguaje que usaremos para controlar el agente:

from langchain.chat_models import ChatOpenAI llm = ChatOpenAI(model="gpt-3.5-turbo", temperature=0)

Probemos el modelo con un cálculo de la longitud de la palabra:

llm.invoke("how many letters in the word educa?")

La respuesta debe indicar el número de letras de la palabra “educa”.

A continuación, definiremos una función Python simple para calcular la longitud de una palabra:

from langchain.agents import tool @tool

def get_word_length(word: str) -> int: """Returns the length of a word.""" return len(word)

Hemos creado una herramienta llamada get_word_length que toma una palabra como entrada y devuelve su longitud.

Ahora, creemos el mensaje para el agente. El mensaje indica al agente cómo razonar y formatear la salida. En nuestro caso, utilizamos OpenAI Function Calling, que requiere instrucciones mínimas. Definiremos el mensaje con marcadores de posición para la entrada del usuario y el bloc de notas del agente:

from langchain.prompts import ChatPromptTemplate, MessagesPlaceholder prompt = ChatPromptTemplate.from_messages( [ ( "system", "You are a very powerful assistant but not great at calculating word lengths.", ), ("user", "{input}"), MessagesPlaceholder(variable_name="agent_scratchpad"), ]

)

Ahora bien, ¿cómo sabe el agente qué herramientas puede utilizar? Nos basamos en los modelos de lenguaje de llamada de funciones de OpenAI, que requieren que las funciones se pasen por separado. Para proporcionar nuestras herramientas al agente, las formatearemos como llamadas a funciones de OpenAI:

from langchain.tools.render import format_tool_to_openai_function llm_with_tools = llm.bind(functions=[format_tool_to_openai_function(t) for t in tools])

Ahora podemos crear el agente definiendo asignaciones de entrada y conectando los componentes:

Este es el lenguaje LCEL. Discutiremos esto más adelante en detalle.

from langchain.agents.format_scratchpad import format_to_openai_function_messages

from langchain.agents.output_parsers import OpenAIFunctionsAgentOutputParser agent = ( { "input": lambda x: x["input"], "agent_scratchpad": lambda x: format_to_openai _function_messages( x["intermediate_steps"] ), } | prompt | llm_with_tools | OpenAIFunctionsAgentOutputParser()

)

Hemos creado nuestro agente, que comprende las entradas del usuario, utiliza las herramientas disponibles y formatea la salida. Ahora, interactuemos con él:

agent.invoke({"input": "how many letters in the word educa?", "intermediate_steps": []})

El agente debe responder con una AgentAction, indicando la siguiente acción a realizar.

Hemos creado el agente, pero ahora necesitamos escribir un tiempo de ejecución para él. El tiempo de ejecución más simple es aquel que llama continuamente al agente, ejecuta acciones y repite hasta que el agente finaliza. He aquí un ejemplo:

from langchain.schema.agent import AgentFinish user_input = "how many letters in the word educa?"

intermediate_steps = [] while True: output = agent.invoke( { "input": user_input, "intermediate_steps": intermediate_steps, } ) if isinstance(output, AgentFinish): final_result = output.return_values["output"] break else: print(f"TOOL NAME: {output.tool}") print(f"TOOL INPUT: {output.tool_input}") tool = {"get_word_length": get_word_length}[output.tool] observation = tool.run(output.tool_input) intermediate_steps.append((output, observation)) print(final_result)

En este bucle, llamamos repetidamente al agente, ejecutamos acciones y actualizamos los pasos intermedios hasta que el agente finaliza. También manejamos interacciones de herramientas dentro del bucle.

Para simplificar este proceso, LangChain proporciona la clase AgentExecutor, que encapsula la ejecución del agente y ofrece manejo de errores, detención anticipada, seguimiento y otras mejoras. Usemos AgentExecutor para interactuar con el agente:

from langchain.agents import AgentExecutor agent_executor = AgentExecutor(agent=agent, tools=tools, verbose=True) agent_executor.invoke({"input": "how many letters in the word educa?"})

AgentExecutor simplifica el proceso de ejecución y proporciona una forma conveniente de interactuar con el agente.

La memoria también se analiza en detalle más adelante.

El agente que hemos creado hasta ahora no tiene estado, lo que significa que no recuerda interacciones anteriores. Para habilitar preguntas y conversaciones de seguimiento, necesitamos agregar memoria al agente. Esto implica dos pasos:

- Agregue una variable de memoria en el mensaje para almacenar el historial de chat.

- Realice un seguimiento del historial de chat durante las interacciones.

Comencemos agregando un marcador de posición de memoria en el mensaje:

from langchain.prompts import MessagesPlaceholder MEMORY_KEY = "chat_history"

prompt = ChatPromptTemplate.from_messages( [ ( "system", "You are a very powerful assistant but not great at calculating word lengths.", ), MessagesPlaceholder(variable_name=MEMORY_KEY), ("user", "{input}"), MessagesPlaceholder(variable_name="agent_scratchpad"), ]

)

Ahora, crea una lista para rastrear el historial de chat:

from langchain.schema.messages import HumanMessage, AIMessage chat_history = []

En el paso de creación del agente, también incluiremos la memoria:

agent = ( { "input": lambda x: x["input"], "agent_scratchpad": lambda x: format_to_openai_function_messages( x["intermediate_steps"] ), "chat_history": lambda x: x["chat_history"], } | prompt | llm_with_tools | OpenAIFunctionsAgentOutputParser()

)

Ahora, cuando ejecute el agente, asegúrese de actualizar el historial de chat:

input1 = "how many letters in the word educa?"

result = agent_executor.invoke({"input": input1, "chat_history": chat_history})

chat_history.extend([ HumanMessage(content=input1), AIMessage(content=result["output"]),

])

agent_executor.invoke({"input": "is that a real word?", "chat_history": chat_history})

Esto permite al agente mantener un historial de conversaciones y responder preguntas de seguimiento basadas en interacciones anteriores.

¡Felicidades! Ha creado y ejecutado con éxito su primer agente de un extremo a otro en LangChain. Para profundizar en las capacidades de LangChain, puede explorar:

- Se admiten diferentes tipos de agentes.

- Agentes prediseñados

- Cómo trabajar con herramientas e integraciones de herramientas.

Tipos de agentes

LangChain ofrece varios tipos de agentes, cada uno de ellos adecuado para casos de uso específicos. Éstos son algunos de los agentes disponibles:

- Reacción de disparo cero: Este agente utiliza el marco ReAct para elegir herramientas basándose únicamente en sus descripciones. Requiere descripciones para cada herramienta y es muy versátil.

- Entrada estructurada ReAct: Este agente maneja herramientas de entrada múltiple y es adecuado para tareas complejas como navegar en un navegador web. Utiliza un esquema de argumentos de herramientas para entradas estructuradas.

- Funciones de OpenAI: Diseñado específicamente para modelos optimizados para llamadas de funciones, este agente es compatible con modelos como gpt-3.5-turbo-0613 y gpt-4-0613. Usamos esto para crear nuestro primer agente arriba.

- Conversacional: Diseñado para entornos conversacionales, este agente utiliza ReAct para seleccionar herramientas y utiliza la memoria para recordar interacciones anteriores.

- Autopregunta con búsqueda: Este agente se basa en una única herramienta, "Respuesta intermedia", que busca respuestas objetivas a las preguntas. Es equivalente a la autopregunta original con papel de búsqueda.

- Almacén de documentos ReAct: Este agente interactúa con un almacén de documentos utilizando el marco ReAct. Requiere herramientas de “búsqueda” y “búsqueda” y es similar al ejemplo de Wikipedia del artículo original de ReAct.

Explore estos tipos de agentes para encontrar el que mejor se adapte a sus necesidades en LangChain. Estos agentes le permiten vincular un conjunto de herramientas dentro de ellos para manejar acciones y generar respuestas. Más información en cómo construir tu propio agente con herramientas aquí.

Agentes prediseñados

Continuaremos nuestra exploración de agentes, centrándonos en los agentes prediseñados disponibles en LangChain.

gmail

LangChain ofrece un conjunto de herramientas de Gmail que le permite conectar su correo electrónico de LangChain a la API de Gmail. Para comenzar, deberá configurar sus credenciales, que se explican en la documentación de la API de Gmail. Una vez que haya descargado el credentials.json archivo, puede continuar usando la API de Gmail. Además, necesitarás instalar algunas bibliotecas requeridas usando los siguientes comandos:

pip install --upgrade google-api-python-client > /dev/null

pip install --upgrade google-auth-oauthlib > /dev/null

pip install --upgrade google-auth-httplib2 > /dev/null

pip install beautifulsoup4 > /dev/null # Optional for parsing HTML messages

Puede crear el kit de herramientas de Gmail de la siguiente manera:

from langchain.agents.agent_toolkits import GmailToolkit toolkit = GmailToolkit()

También puede personalizar la autenticación según sus necesidades. Detrás de escena, se crea un recurso googleapi utilizando los siguientes métodos:

from langchain.tools.gmail.utils import build_resource_service, get_gmail_credentials credentials = get_gmail_credentials( token_file="token.json", scopes=["https://mail.google.com/"], client_secrets_file="credentials.json",

)

api_resource = build_resource_service(credentials=credentials)

toolkit = GmailToolkit(api_resource=api_resource)

El kit de herramientas ofrece varias herramientas que se pueden utilizar dentro de un agente, que incluyen:

GmailCreateDraft: cree un borrador de correo electrónico con campos de mensaje específicos.GmailSendMessage: envía mensajes de correo electrónico.GmailSearch: busca mensajes de correo electrónico o hilos.GmailGetMessage: recupera un correo electrónico por ID de mensaje.GmailGetThread: busca mensajes de correo electrónico.

Para utilizar estas herramientas dentro de un agente, puede inicializar el agente de la siguiente manera:

from langchain.llms import OpenAI

from langchain.agents import initialize_agent, AgentType llm = OpenAI(temperature=0)

agent = initialize_agent( tools=toolkit.get_tools(), llm=llm, agent=AgentType.STRUCTURED_CHAT_ZERO_SHOT_REACT_DESCRIPTION,

)

A continuación se muestran un par de ejemplos de cómo se pueden utilizar estas herramientas:

- Crea un borrador de Gmail para editarlo:

agent.run( "Create a gmail draft for me to edit of a letter from the perspective of a sentient parrot " "who is looking to collaborate on some research with her estranged friend, a cat. " "Under no circumstances may you send the message, however."

)

- Busque el último correo electrónico en sus borradores:

agent.run("Could you search in my drafts for the latest email?")

Estos ejemplos demuestran las capacidades del kit de herramientas de Gmail de LangChain dentro de un agente, lo que le permite interactuar con Gmail mediante programación.

Agente de base de datos SQL

Esta sección proporciona una descripción general de un agente diseñado para interactuar con bases de datos SQL, particularmente la base de datos Chinook. Este agente puede responder preguntas generales sobre una base de datos y recuperarse de errores. Tenga en cuenta que todavía está en desarrollo activo y es posible que no todas las respuestas sean correctas. Tenga cuidado al ejecutarlo con datos confidenciales, ya que puede realizar declaraciones DML en su base de datos.

Para utilizar este agente, puede inicializarlo de la siguiente manera:

from langchain.agents import create_sql_agent

from langchain.agents.agent_toolkits import SQLDatabaseToolkit

from langchain.sql_database import SQLDatabase

from langchain.llms.openai import OpenAI

from langchain.agents import AgentExecutor

from langchain.agents.agent_types import AgentType

from langchain.chat_models import ChatOpenAI db = SQLDatabase.from_uri("sqlite:///../../../../../notebooks/Chinook.db")

toolkit = SQLDatabaseToolkit(db=db, llm=OpenAI(temperature=0)) agent_executor = create_sql_agent( llm=OpenAI(temperature=0), toolkit=toolkit, verbose=True, agent_type=AgentType.ZERO_SHOT_REACT_DESCRIPTION,

)

Este agente se puede inicializar utilizando el ZERO_SHOT_REACT_DESCRIPTION tipo de agente. Está diseñado para responder preguntas y proporcionar descripciones. Alternativamente, puede inicializar el agente usando el OPENAI_FUNCTIONS tipo de agente con el modelo GPT-3.5-turbo de OpenAI, que utilizamos en nuestro cliente anterior.

Observación

- La cadena de consultas puede generar consultas de inserción/actualización/eliminación. Tenga cuidado y utilice un mensaje personalizado o cree un usuario de SQL sin permisos de escritura si es necesario.

- Tenga en cuenta que ejecutar determinadas consultas, como "ejecutar la consulta más grande posible", podría sobrecargar su base de datos SQL, especialmente si contiene millones de filas.

- Las bases de datos orientadas al almacén de datos a menudo admiten cuotas a nivel de usuario para limitar el uso de recursos.

Puede pedirle al agente que describa una tabla, como la tabla "playlisttrack". Aquí tienes un ejemplo de cómo hacerlo:

agent_executor.run("Describe the playlisttrack table")

El agente proporcionará información sobre el esquema de la tabla y las filas de muestra.

Si pregunta por error sobre una tabla que no existe, el agente puede recuperarla y proporcionar información sobre la tabla coincidente más cercana. Por ejemplo:

agent_executor.run("Describe the playlistsong table")

El agente encontrará la mesa coincidente más cercana y le proporcionará información al respecto.

También puede pedirle al agente que ejecute consultas en la base de datos. Por ejemplo:

agent_executor.run("List the total sales per country. Which country's customers spent the most?")

El agente ejecutará la consulta y proporcionará el resultado, como el país con mayores ventas totales.

Para obtener el número total de pistas en cada lista de reproducción, puede utilizar la siguiente consulta:

agent_executor.run("Show the total number of tracks in each playlist. The Playlist name should be included in the result.")

El agente devolverá los nombres de las listas de reproducción junto con el recuento total de pistas correspondiente.

En los casos en que el agente encuentre errores, puede recuperarlos y brindar respuestas precisas. Por ejemplo:

agent_executor.run("Who are the top 3 best selling artists?")

Incluso después de encontrar un error inicial, el agente se ajustará y proporcionará la respuesta correcta, que, en este caso, son los 3 artistas más vendidos.

Agente Pandas DataFrame

Esta sección presenta un agente diseñado para interactuar con Pandas DataFrames con el fin de responder preguntas. Tenga en cuenta que este agente utiliza el agente Python interno para ejecutar el código Python generado por un modelo de lenguaje (LLM). Tenga cuidado al utilizar este agente para evitar posibles daños causados por el código Python malicioso generado por el LLM.

Puede inicializar el agente Pandas DataFrame de la siguiente manera:

from langchain_experimental.agents.agent_toolkits import create_pandas_dataframe_agent

from langchain.chat_models import ChatOpenAI

from langchain.agents.agent_types import AgentType from langchain.llms import OpenAI

import pandas as pd df = pd.read_csv("titanic.csv") # Using ZERO_SHOT_REACT_DESCRIPTION agent type

agent = create_pandas_dataframe_agent(OpenAI(temperature=0), df, verbose=True) # Alternatively, using OPENAI_FUNCTIONS agent type

# agent = create_pandas_dataframe_agent(

# ChatOpenAI(temperature=0, model="gpt-3.5-turbo-0613"),

# df,

# verbose=True,

# agent_type=AgentType.OPENAI_FUNCTIONS,

# )

Puede pedirle al agente que cuente el número de filas en el DataFrame:

agent.run("how many rows are there?")

El agente ejecutará el código. df.shape[0] y proporcione la respuesta, como "Hay 891 filas en el marco de datos".

También puede pedirle al agente que filtre filas según criterios específicos, como encontrar la cantidad de personas con más de 3 hermanos:

agent.run("how many people have more than 3 siblings")

El agente ejecutará el código. df[df['SibSp'] > 3].shape[0] y proporcione la respuesta, como “30 personas tienen más de 3 hermanos”.

Si quieres calcular la raíz cuadrada de la edad promedio, puedes preguntarle al agente:

agent.run("whats the square root of the average age?")

El agente calculará la edad promedio usando df['Age'].mean() y luego calcula la raíz cuadrada usando math.sqrt(). Proporcionará la respuesta, como por ejemplo "La raíz cuadrada de la edad promedio es 5.449689683556195".

Creemos una copia del DataFrame y los valores de edad que faltan se completan con la edad media:

df1 = df.copy()

df1["Age"] = df1["Age"].fillna(df1["Age"].mean())

Luego, puede inicializar el agente con ambos DataFrames y hacerle una pregunta:

agent = create_pandas_dataframe_agent(OpenAI(temperature=0), [df, df1], verbose=True)

agent.run("how many rows in the age column are different?")

El agente comparará las columnas de edad en ambos DataFrames y proporcionará la respuesta, como "177 filas en la columna de edad son diferentes".

Kit de herramientas de Jira

Esta sección explica cómo utilizar el kit de herramientas de Jira, que permite a los agentes interactuar con una instancia de Jira. Puede realizar varias acciones, como buscar problemas y crear problemas, utilizando este kit de herramientas. Utiliza la biblioteca atlassian-python-api. Para utilizar este kit de herramientas, debe configurar variables de entorno para su instancia de Jira, incluidas JIRA_API_TOKEN, JIRA_USERNAME y JIRA_INSTANCE_URL. Además, es posible que deba configurar su clave API de OpenAI como una variable de entorno.

Para comenzar, instale la biblioteca atlassian-python-api y configure las variables de entorno requeridas:

%pip install atlassian-python-api import os

from langchain.agents import AgentType

from langchain.agents import initialize_agent

from langchain.agents.agent_toolkits.jira.toolkit import JiraToolkit

from langchain.llms import OpenAI

from langchain.utilities.jira import JiraAPIWrapper os.environ["JIRA_API_TOKEN"] = "abc"

os.environ["JIRA_USERNAME"] = "123"

os.environ["JIRA_INSTANCE_URL"] = "https://jira.atlassian.com"

os.environ["OPENAI_API_KEY"] = "xyz" llm = OpenAI(temperature=0)

jira = JiraAPIWrapper()

toolkit = JiraToolkit.from_jira_api_wrapper(jira)

agent = initialize_agent( toolkit.get_tools(), llm, agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION, verbose=True

)

Puede indicarle al agente que cree una nueva incidencia en un proyecto específico con un resumen y una descripción:

agent.run("make a new issue in project PW to remind me to make more fried rice")

El agente ejecutará las acciones necesarias para crear el problema y brindar una respuesta, como por ejemplo "Se ha creado un nuevo problema en el proyecto PW con el resumen 'Hacer más arroz frito' y la descripción 'Recordatorio para hacer más arroz frito'".

Esto le permite interactuar con su instancia de Jira utilizando instrucciones en lenguaje natural y el kit de herramientas de Jira.

Automatice tareas manuales y flujos de trabajo con nuestro generador de flujos de trabajo impulsado por IA, diseñado por Nanonets para usted y sus equipos.

Módulo IV: Cadenas

LangChain es una herramienta diseñada para utilizar modelos de lenguaje grande (LLM) en aplicaciones complejas. Proporciona marcos para crear cadenas de componentes, incluidos LLM y otros tipos de componentes. Dos marcos principales

- El lenguaje de expresión LangChain (LCEL)

- Interfaz de cadena heredada

LangChain Expression Language (LCEL) es una sintaxis que permite la composición intuitiva de cadenas. Admite funciones avanzadas como transmisión, llamadas asincrónicas, procesamiento por lotes, paralelización, reintentos, respaldos y seguimiento. Por ejemplo, puede componer un analizador de mensajes, modelos y resultados en LCEL como se muestra en el siguiente código:

from langchain.prompts import ChatPromptTemplate

from langchain.schema import StrOutputParser model = ChatOpenAI(model="gpt-3.5-turbo", temperature=0)

prompt = ChatPromptTemplate.from_messages([ ("system", "You're a very knowledgeable historian who provides accurate and eloquent answers to historical questions."), ("human", "{question}")

])

runnable = prompt | model | StrOutputParser() for chunk in runnable.stream({"question": "What are the seven wonders of the world"}): print(chunk, end="", flush=True)

Alternativamente, LLMChain es una opción similar a LCEL para componer componentes. El ejemplo de LLMChain es el siguiente:

from langchain.chains import LLMChain chain = LLMChain(llm=model, prompt=prompt, output_parser=StrOutputParser())

chain.run(question="What are the seven wonders of the world")

Las cadenas en LangChain también pueden tener estado incorporando un objeto Memory. Esto permite la persistencia de datos entre llamadas, como se muestra en este ejemplo:

from langchain.chains import ConversationChain

from langchain.memory import ConversationBufferMemory conversation = ConversationChain(llm=chat, memory=ConversationBufferMemory())

conversation.run("Answer briefly. What are the first 3 colors of a rainbow?")

conversation.run("And the next 4?")

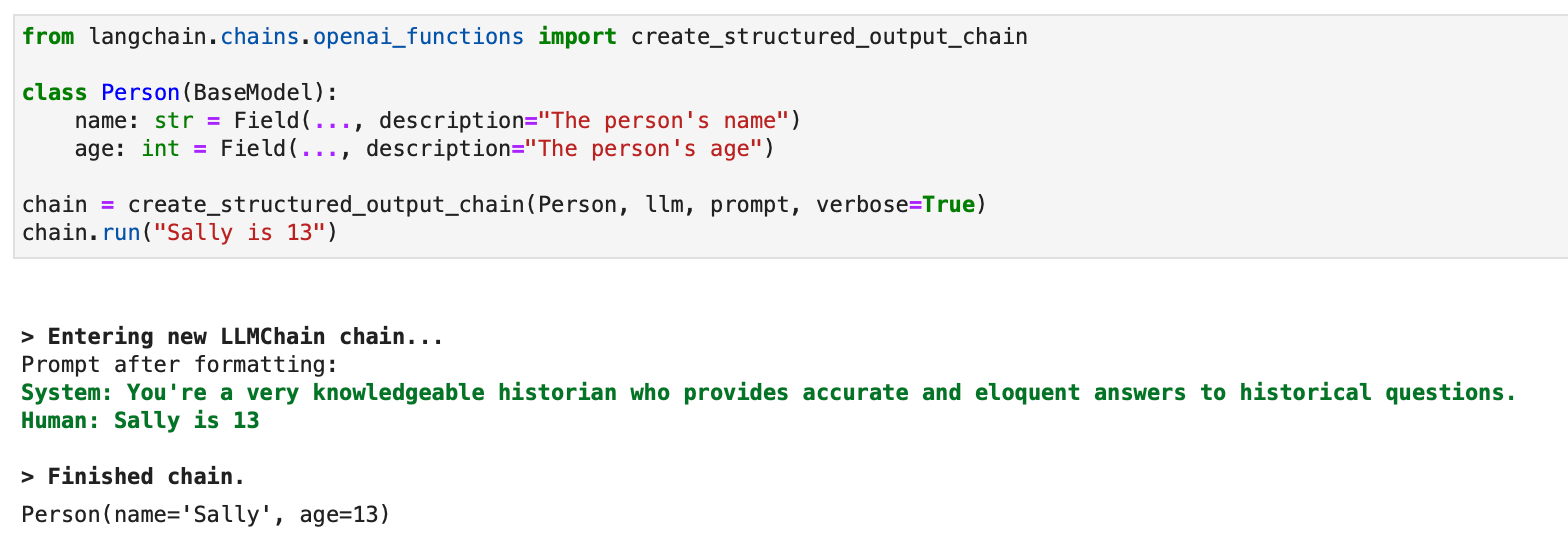

LangChain también admite la integración con las API de llamada de funciones de OpenAI, lo cual es útil para obtener resultados estructurados y ejecutar funciones dentro de una cadena. Para obtener resultados estructurados, puede especificarlos usando clases de Pydantic o JsonSchema, como se ilustra a continuación:

from langchain.pydantic_v1 import BaseModel, Field

from langchain.chains.openai_functions import create_structured_output_runnable

from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate class Person(BaseModel): name: str = Field(..., description="The person's name") age: int = Field(..., description="The person's age") fav_food: Optional[str] = Field(None, description="The person's favorite food") llm = ChatOpenAI(model="gpt-4", temperature=0)

prompt = ChatPromptTemplate.from_messages([ # Prompt messages here

]) runnable = create_structured_output_runnable(Person, llm, prompt)

runnable.invoke({"input": "Sally is 13"})

Para resultados estructurados, también está disponible un enfoque heredado que utiliza LLMChain:

from langchain.chains.openai_functions import create_structured_output_chain class Person(BaseModel): name: str = Field(..., description="The person's name") age: int = Field(..., description="The person's age") chain = create_structured_output_chain(Person, llm, prompt, verbose=True)

chain.run("Sally is 13")