Introducción

La IA generativa, un campo emocionante en la intersección de la inteligencia artificial y la creatividad, está revolucionando varias industrias al permitir que las máquinas generen contenido nuevo y original. Desde la generación de imágenes realistas y composiciones musicales hasta la creación de texto realista y entornos virtuales inmersivos, la IA generativa está ampliando los límites de lo que las máquinas pueden lograr. En este blog, nos embarcaremos en un viaje para explorar el panorama prometedor de la IA generativa con VAE, GAN y Transformers, profundizando en sus aplicaciones, avances y el profundo impacto que tiene para el futuro.

OBJETIVOS DE APRENDIZAJE

- Comprender los conceptos fundamentales de la IA generativa, incluidos los codificadores automáticos variacionales (VAEs), las redes antagónicas generativas (GAN) y los transformadores.

- Explore el potencial creativo de los modelos generativos de IA y sus aplicaciones.

- Obtenga información sobre la implementación de VAE, GAN y transformadores.

- Explore las direcciones futuras y los avances en la IA generativa.

Este artículo fue publicado como parte del Blogatón de ciencia de datos.

Definición de IA generativa

La IA generativa, en esencia, implica entrenar modelos para aprender de los datos existentes y luego generar contenido nuevo que comparta características similares. Rompe con los enfoques tradicionales de IA que se enfocan en reconocer patrones y hacer predicciones basadas en la información existente. En cambio, la IA generativa tiene como objetivo crear algo completamente nuevo, expandiendo los reinos de la creatividad y la innovación.

El poder de la IA generativa

La IA generativa tiene el poder de dar rienda suelta a la creatividad y ampliar los límites de lo que pueden lograr las máquinas. Al comprender los principios y modelos subyacentes que se utilizan en la IA generativa, como los codificadores automáticos variacionales (VAEs), las redes antagónicas generativas (GAN) y los transformadores, podemos comprender las técnicas y los métodos detrás de esta tecnología creativa.

El poder de la IA generativa radica en su capacidad para dar rienda suelta a la creatividad y generar nuevos contenidos que imitan e incluso superan la creatividad humana. Al aprovechar algoritmos y modelos, la IA generativa puede producir diversos resultados, como imágenes, música y texto, que inspiran, innovan y superan los límites de la expresión artística.

Los modelos generativos de IA, como los codificadores automáticos variacionales (VAEs), las redes adversas generativas (GAN) y los transformadores, juegan un papel clave en el desbloqueo de este poder. Los VAE capturan la estructura subyacente de los datos y pueden generar nuevas muestras mediante el muestreo de un espacio latente aprendido. Las GAN introducen un marco competitivo entre un generador y un discriminador, lo que genera resultados muy realistas. Los transformadores se destacan en la captura de dependencias de largo alcance, lo que los hace ideales para generar contenido coherente y contextualmente relevante.

Exploremos esto en detalle.

Autoencoders variables (VAE)

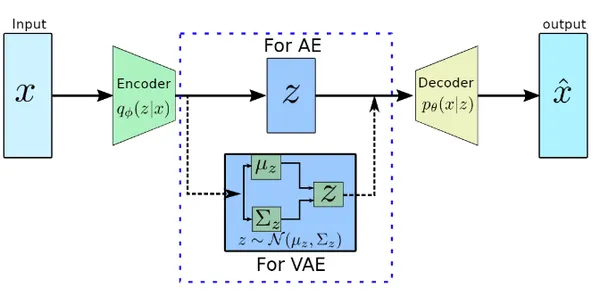

Uno de los modelos fundamentales utilizados en la IA generativa es el Variational Autoencoder o VAE. Al emplear una arquitectura de codificador-decodificador, los VAE capturan la esencia de los datos de entrada al comprimirlos en un espacio latente de menor dimensión. A partir de este espacio latente, el decodificador genera nuevas muestras que se asemejan a los datos originales.

Los VAE han encontrado aplicaciones en la generación de imágenes, la síntesis de texto y más, lo que permite que las máquinas creen contenido novedoso que cautiva e inspira.

Implementación de VAE

En esta sección, implementaremos el codificador automático variacional (VAE) desde cero.

Definición del modelo de codificador y decodificador

El codificador toma los datos de entrada, los pasa a través de una capa densa con una función de activación ReLU y genera la varianza media y logarítmica de la distribución del espacio latente.

La red del decodificador es una red neuronal de avance que toma la representación del espacio latente como entrada, la pasa a través de una capa densa con una función de activación ReLU y produce las salidas del decodificador aplicando otra capa densa con una función de activación sigmoidea.

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers # Define the encoder network

encoder_inputs = keras.Input(shape=(input_dim,))

x = layers.Dense(hidden_dim, activation="relu")(encoder_inputs)

z_mean = layers.Dense(latent_dim)(x)

z_log_var = layers.Dense(latent_dim)(x) # Define the decoder network

decoder_inputs = keras.Input(shape=(latent_dim,))

x = layers.Dense(hidden_dim, activation="relu")(decoder_inputs)

decoder_outputs = layers.Dense(output_dim, activation="sigmoid")(x)

Definir función de muestreo

La función de muestreo toma la media y la varianza logarítmica de un espacio latente como entradas y genera una muestra aleatoria añadiendo ruido escalado por la exponencial de la mitad de la varianza logarítmica a la media.

# Define the sampling function for the latent space

def sampling(args): z_mean, z_log_var = args epsilon = tf.random.normal(shape=(batch_size, latent_dim)) return z_mean + tf.exp(0.5 * z_log_var) * epsilon z = layers.Lambda(sampling)([z_mean, z_log_var])

Definir función de pérdida

La función de pérdida VAE tiene la pérdida de reconstrucción, que mide la similitud entre la entrada y la salida, y la pérdida de Kullback-Leibler (KL), que regulariza el espacio latente penalizando las desviaciones de una distribución anterior. Estas pérdidas se combinan y se suman al modelo VAE, lo que permite una capacitación integral que optimiza simultáneamente los objetivos de reconstrucción y regularización.

vae = keras.Model(inputs=encoder_inputs, outputs=decoder_outputs) # Define the loss function

reconstruction_loss = keras.losses.binary_crossentropy(encoder_inputs, decoder_outputs)

reconstruction_loss *= input_dim kl_loss = 1 + z_log_var - tf.square(z_mean) - tf.exp(z_log_var)

kl_loss = tf.reduce_mean(kl_loss) * -0.5 vae_loss = reconstruction_loss + kl_loss

vae.add_loss(vae_loss)

Compilar y entrenar el modelo

El código proporcionado compila y entrena un modelo de codificador automático variacional utilizando el optimizador de Adam, donde el modelo aprende a minimizar la reconstrucción combinada y la pérdida de KL para generar representaciones y reconstrucciones significativas de los datos de entrada.

# Compile and train the VAE

vae.compile(optimizer="adam")

vae.fit(x_train, epochs=epochs, batch_size=batch_size)Redes Adversarias Generativas (GAN)

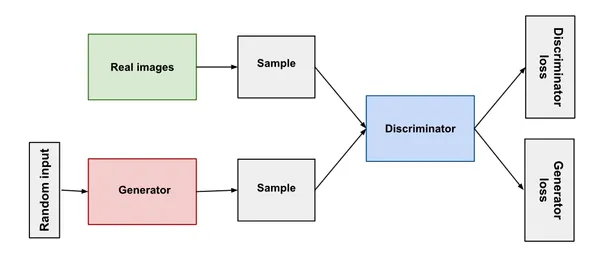

Las redes adversarias generativas han ganado una atención significativa en el campo de la IA generativa. Compuesto por un generador y un discriminador, los GAN se involucran en un proceso de entrenamiento contradictorio. El generador tiene como objetivo producir muestras realistas, mientras que el discriminador distingue entre muestras reales y generadas. A través de esta interacción competitiva, las GAN aprenden a generar contenido cada vez más convincente y realista.

Las GAN se han empleado para generar imágenes y videos, e incluso para simular voces humanas, lo que ofrece un vistazo al asombroso potencial de la IA generativa.

Implementación GAN

En esta sección, implementaremos redes adversarias generativas (GAN) desde cero.

Definición de red de generadores y discriminadores

Esto define una red generadora, representada por la variable 'generador', que toma una entrada de espacio latente y la transforma a través de una serie de capas densas con activaciones ReLU para generar muestras de datos sintéticos.

Del mismo modo, también define una red discriminadora, representada por la variable 'discriminador', que toma las muestras de datos generadas como entrada y las pasa a través de capas densas con activaciones ReLU para predecir un único valor de salida que indica la probabilidad de que la entrada sea real o falsa.

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers # Define the generator network

generator = keras.Sequential([ layers.Dense(256, input_dim=latent_dim, activation="relu"), layers.Dense(512, activation="relu"), layers.Dense(output_dim, activation="sigmoid")

]) # Define the discriminator network

discriminator = keras.Sequential([ layers.Dense(512, input_dim=output_dim, activation="relu"), layers.Dense(256, activation="relu"), layers.Dense(1, activation="sigmoid")

])

Definición del modelo GAN

El modelo GAN se define combinando las redes generador y discriminador. El discriminador se compila por separado con la pérdida de entropía cruzada binaria y el optimizador de Adam. Durante el entrenamiento GAN, el discriminador se congela para evitar que se actualicen sus pesos. Luego, el modelo GAN se compila con la pérdida de entropía cruzada binaria y el optimizador de Adam.

# Define the GAN model

gan = keras.Sequential([generator, discriminator]) # Compile the discriminator

discriminator.compile(loss="binary_crossentropy", optimizer="adam") # Freeze the discriminator during GAN training

discriminator.trainable = False # Compile the GAN

gan.compile(loss="binary_crossentropy", optimizer="adam")

Entrenamiento de la GAN

En el bucle de entrenamiento, el discriminador y el generador se entrenan por separado utilizando lotes de datos reales y generados, y las pérdidas se imprimen para cada época para monitorear el progreso del entrenamiento. El modelo GAN tiene como objetivo entrenar al generador para producir muestras de datos realistas que puedan engañar al discriminador.

# Training loop

for epoch in range(epochs): # Generate random noise noise = tf.random.normal(shape=(batch_size, latent_dim)) # Generate fake samples and create a batch of real samples generated_data = generator(noise) real_data = x_train[np.random.choice(x_train.shape[0], batch_size, replace=False)] # Concatenate real and fake samples and create labels combined_data = tf.concat([real_data, generated_data], axis=0) labels = tf.concat([tf.ones((batch_size, 1)), tf.zeros((batch_size, 1))], axis=0) # Train the discriminator discriminator_loss = discriminator.train_on_batch(combined_data, labels) # Train the generator (via GAN model) gan_loss = gan.train_on_batch(noise, tf.ones((batch_size, 1))) # Print the losses print(f"Epoch: {epoch+1}, Disc Loss: {discriminator_loss}, GAN Loss: {gan_loss}")

Transformadores y modelos autorregresivos

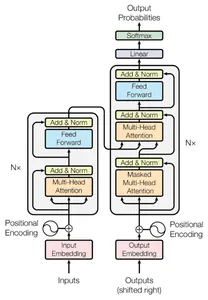

Estos modelos han revolucionado las tareas de procesamiento del lenguaje natural. Con el mecanismo de autoatención de los transformadores, sobresalga en la captura de dependencias de largo alcance en datos secuenciales. Esta habilidad les permite generar textos coherentes y contextualmente relevantes, revolucionando las tareas de generación de lenguaje.

Los modelos autorregresivos, como la serie GPT, generan salidas secuencialmente, condicionando cada paso a las salidas anteriores. Estos modelos han demostrado ser invaluables para generar historias cautivadoras, diálogos atractivos e incluso ayudar en la escritura.

Implementación de transformadores

Esto define un modelo de Transformador utilizando la API secuencial de Keras, que incluye una capa de incrustación, una capa de Transformador y una capa densa con una activación de softmax. Este modelo está diseñado para tareas como la traducción de idiomas de secuencia a secuencia o el procesamiento de lenguaje natural, donde puede aprender a procesar datos secuenciales y generar predicciones de salida.

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers # Define the Transformer model

transformer = keras.Sequential([ layers.Embedding(input_dim=vocab_size, output_dim=embedding_dim), layers.Transformer(num_layers, d_model, num_heads, dff, input_vocab_size=vocab_size, maximum_position_encoding=max_seq_length), layers.Dense(output_vocab_size, activation="softmax")

])

Aplicación en el mundo real de la IA generativa

La Inteligencia Artificial Generativa ha emergido como un cambio de juego, transformando varias industrias al permitir experiencias personalizadas y desbloquear nuevos reinos de creatividad. A través de técnicas como VAE, GAN y Transformers, la IA generativa ha logrado avances significativos en las recomendaciones personalizadas, la generación de contenido creativo y el aumento de datos. En este blog, exploraremos cómo estas aplicaciones del mundo real están remodelando las industrias y revolucionando las experiencias de los usuarios.

Custom Recommendations

Las técnicas de IA generativa, como VAE, GAN y Transformers, están revolucionando los sistemas de recomendación al ofrecer contenido altamente personalizado y personalizado. Al analizar los datos de los usuarios, estos modelos brindan recomendaciones personalizadas para productos, servicios y contenido, lo que mejora las experiencias y el compromiso de los usuarios.

Generación de contenido creativo

La IA generativa permite a los artistas, diseñadores y músicos explorar nuevos reinos de creatividad. Los modelos entrenados en grandes conjuntos de datos pueden generar obras de arte impresionantes, inspirar diseños e incluso componer música original. Esta colaboración entre la creatividad humana y la inteligencia artificial abre nuevas posibilidades de innovación y expresión.

Aumento y síntesis de datos

Los modelos generativos juegan un papel crucial en el aumento de datos al generar muestras de datos sintéticos para aumentar conjuntos de datos de entrenamiento limitados. Esto mejora la capacidad de generalización de los modelos ML, mejorando su rendimiento y robustez, desde la visión artificial hasta la PNL.

Publicidad y Marketing Personalizado

La IA generativa transforma la publicidad y el marketing al permitir campañas personalizadas y dirigidas. Al analizar el comportamiento y las preferencias de los usuarios, los modelos de IA generan anuncios personalizados y contenido de marketing. Ofrece mensajes personalizados y ofertas a clientes individuales. Esto mejora la participación del usuario y mejora la eficacia del marketing.

Desafíos y consideraciones éticas

La IA generativa brinda posibilidades, es vital abordar los desafíos y las consideraciones éticas que acompañan a estas poderosas tecnologías. A medida que nos adentramos en el mundo de las recomendaciones, la generación de contenido creativo y el aumento de datos, debemos garantizar la equidad, la autenticidad y el uso responsable de la IA generativa.

1. Sesgos y equidad

Los modelos de IA generativa pueden heredar los sesgos presentes en los datos de entrenamiento, lo que requiere esfuerzos para minimizar y mitigar los sesgos a través de la selección de datos y las medidas de equidad algorítmica.

2. Derechos de Propiedad Intelectual

Las pautas claras y los marcos de licencia son cruciales para proteger los derechos de los creadores de contenido y garantizar una colaboración respetuosa entre la IA generativa y los creadores humanos.

3. Mal uso de la Información Generada

Se necesitan salvaguardas sólidas, mecanismos de verificación e iniciativas educativas para combatir el posible uso indebido de la IA generativa para noticias falsas, información errónea o falsificaciones profundas.

4. Transparencia y explicabilidad

Mejorar la transparencia y la explicabilidad en los modelos generativos de IA puede fomentar la confianza y la responsabilidad, lo que permite a los usuarios y partes interesadas comprender los procesos de toma de decisiones.

Al abordar estos desafíos y consideraciones éticas, podemos aprovechar el poder de la IA generativa de manera responsable, promoviendo la equidad, la inclusión y la innovación ética en beneficio de la sociedad.

Futuro de la IA generativa

El futuro de la IA generativa tiene interesantes posibilidades y avances. Aquí hay algunas áreas clave que podrían dar forma a su desarrollo.

Controlabilidad mejorada

Los investigadores están trabajando para mejorar la capacidad de control de los modelos generativos de IA. Esto incluye técnicas que permiten a los usuarios tener un control más detallado sobre los resultados generados, como especificar los atributos, estilos o niveles de creatividad deseados. La capacidad de control permitirá a los usuarios dar forma al contenido generado de acuerdo con sus necesidades y preferencias específicas.

Salidas Interpretables y Explicables

Mejorar la interpretabilidad de los modelos generativos de IA es un área activa de investigación. La capacidad de comprender y explicar por qué un modelo genera un resultado particular es crucial, especialmente en dominios como la atención médica y la ley, donde la responsabilidad y la transparencia son importantes. Las técnicas que brindan información sobre el proceso de toma de decisiones de los modelos generativos de IA permitirán una mayor confianza y adopción.

Aprendizaje de pocos disparos y cero disparos

Actualmente, los modelos de IA generativa a menudo requieren grandes cantidades de datos de entrenamiento de alta calidad para producir resultados deseables. Sin embargo, los investigadores están explorando técnicas para permitir que los modelos aprendan de ejemplos de entrenamiento limitados o incluso nulos. Los enfoques de aprendizaje de pocos disparos y cero disparos harán que la IA generativa sea más accesible y aplicable a dominios donde la adquisición de grandes conjuntos de datos es un desafío.

Modelos Generativos Multimodales

Los modelos generativos multimodales que combinan diferentes tipos de datos, como texto, imágenes y audio, están ganando atención. Estos modelos pueden generar resultados diversos y cohesivos a través de múltiples modalidades, lo que permite una creación de contenido más rica y envolvente. Las aplicaciones podrían incluir la generación de historias interactivas, experiencias de realidad aumentada y contenido multimedia personalizado.

Generación Interactiva y en Tiempo Real

La capacidad de generar contenido en tiempo real e interactivamente abre oportunidades interesantes. Esto incluye generar recomendaciones personalizadas, avatares virtuales y contenido dinámico que responda a las entradas y preferencias del usuario. La IA generativa en tiempo real tiene aplicaciones en juegos, realidad virtual y experiencias de usuario personalizadas.

A medida que la IA generativa continúa avanzando, es importante considerar las implicaciones éticas, el desarrollo responsable y el uso justo de estos modelos. Al abordar estas preocupaciones y fomentar la colaboración entre la creatividad humana y la IA generativa, podemos desbloquear todo su potencial para impulsar la innovación e impactar positivamente en varias industrias y dominios.

Conclusión

La IA generativa se ha convertido en una poderosa herramienta para la expresión creativa, revolucionando varias industrias y ampliando los límites de lo que las máquinas pueden lograr. Con los avances y la investigación en curso, el futuro de la IA generativa es tremendamente prometedor. A medida que continuamos explorando este emocionante panorama, es esencial navegar por las consideraciones éticas y garantizar un desarrollo responsable e inclusivo.

Puntos clave

- Los VAE ofrecen un potencial creativo al mapear datos en un espacio de menor dimensión y generar contenido diverso, lo que los hace invaluables para aplicaciones como obras de arte y síntesis de imágenes.

- Las GAN revolucionan el contenido generado por IA a través de su marco competitivo, produciendo resultados altamente realistas, como videos falsos profundos y obras de arte fotorrealistas.

- Los transformadores se destacan en la generación de resultados coherentes mediante la captura de dependencias de largo alcance, lo que los hace ideales para tareas como la traducción automática, la generación de texto y la síntesis de imágenes.

- El futuro de la IA generativa radica en mejorar la capacidad de control, la interpretabilidad y la eficiencia a través de avances de investigación en modelos multimodales, aprendizaje de transferencia y métodos de capacitación para mejorar la calidad y diversidad de los resultados generados.

Adoptar la IA generativa abre nuevas posibilidades para la creatividad, la innovación y las experiencias personalizadas, dando forma al futuro de la tecnología y la interacción humana.

Preguntas frecuentes

R1: La IA generativa se refiere al uso de algoritmos y modelos para generar contenido nuevo, como imágenes, música y texto.

A2: Los VAE consisten en un codificador y un decodificador. El codificador asigna los datos de entrada a un espacio latente de menor dimensión, capturando la esencia de los datos. El decodificador reconstruye los datos originales a partir de puntos en el espacio latente. Permite la generación de nuevas muestras tomando muestras de este espacio.

A3: Las GAN constan de un generador y un discriminador. El generador genera nuevas muestras a partir de ruido aleatorio, con el objetivo de engañar al discriminador. El discriminador actúa como juez, distinguiendo entre muestras reales y falsas. Las GAN son conocidas por su capacidad para producir resultados muy realistas.

A4: Los transformadores sobresalen en la generación de resultados coherentes al capturar dependencias de largo alcance en los datos. Sopesan la importancia de los diferentes elementos de entrada. Esto los hace efectivos para tareas como la traducción automática, la generación de texto y la síntesis de imágenes.

R5: Los modelos de IA generativa se pueden ajustar y acondicionar. Pero en parámetros de entrada específicos o restricciones para generar contenido que se adhiera a las características o estilos deseados. Esto permite un mayor control sobre las salidas generadas.

Los medios que se muestran en este artículo no son propiedad de Analytics Vidhya y se utilizan a discreción del autor.

Relacionado:

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Automoción / vehículos eléctricos, Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- Desplazamientos de bloque. Modernización de la propiedad de compensaciones ambientales. Accede Aquí.

- Fuente: https://www.analyticsvidhya.com/blog/2023/07/generative-ai-with-vaes-gans-transformers/