Comentario "Lo siento Dave, me temo que no puedo hacer eso".

Estas fueron las palabras que introdujeron a la mayoría de las personas de mi generación al concepto de una IA que se volvió rebelde; HAL 9000 en la clásica película de ciencia ficción 2001: Una odisea del espacio, finalmente se volvió loco cantando la letra de margarita, margarita mientras parpadeaba lentamente su siniestro ojo rojo antes de finalmente apagarse permanentemente.

Para ser claros, HAL 9000 no es la única IA que se ha vuelto pícara en la ciencia ficción popular: la literatura está plagada de historias de este tipo, pero hubo cierta relación y conmoción en el escenario de HAL 9000, ya que a lo largo de la película HAL no solo había sido útil. pero uno podría incluso decir amistoso, y era tanto parte del elenco como los actores reales. Para mí, la escena nunca se olvidará debido a la sensación de incredulidad de que una IA pudiera causar o intentar causar daño a un ser humano; después de todo, habíamos oído hablar de las leyes de la robótica de Asimov y asumimos que las IA serían seguras porque seguir esas leyes.

El problema es que, así como HAL 9000 era ciencia ficción, también lo eran las obras de Asimov y, como tal, confiar en leyes ficticias en el contexto del mundo real y cómo se están desarrollando y desplegando la robótica y la IA es una locura. No podemos asumir que los modelos del mundo real se están entrenando en base a tales leyes ficticias y la realidad es que no es así.

Entra en ChatGPT

Hacia fines de 2022, OpenAI abrió al público en general su modelo de IA de lenguaje grande conocido como ChatGPT, y rápidamente se convirtió en una sensación en Internet debido a su asombrosa capacidad para imitar el habla y los matices humanos.

De hecho, es tan creíble y realista que ha sido elogiado como un cambio de juego para el mundo con Microsoft ya gastando miles de millones de dólares ser el primer socio comercial en utilizar ChatGPT en sus productos existentes, como su motor de búsqueda Bing, el software de colaboración y reuniones Teams y la nube de Azure.

Las instituciones académicas han tenido que apresurarse a desarrollar reglas para sus estudiantes después de que ChatGPT generara múltiples envíos académicos; los estudiantes también han sido sorprendidos haciendo trampa en sus exámenes y trabajos al intentar hacer pasar el texto generado por ChatGPT como su propio trabajo.

Universidad de Stanford, hace apenas unos días, liberado una herramienta para detectar (con hasta un 95 por ciento de precisión) texto generado por modelos de lenguaje extenso (LLM).

Los vendedores, personas influyentes y una gran cantidad de entrenadores de "liderazgo", redactores y creadores de contenido están en todas las redes sociales diciéndoles a todos cuánto tiempo y dinero pueden ahorrar usando ChatGPT y modelos similares para hacer su trabajo por ellos: ChatGPT se ha convertido en el nuevo Grumpy Cat, el nuevo Ice Bucket Challenge: se ha convertido en el centro de atención de casi todas las industrias del planeta.

Pero, ¿qué pasa con los riesgos que plantea una IA de este tipo? Cuando comenzamos a considerar que la información proporcionada por una IA en respuesta a una pregunta (o serie de preguntas) es la verdad absoluta, se le perdonaría pensar que es el caso de ChatGPT dado todo el bombo publicitario, ¿qué sucede cuando lo es? t?

En los últimos meses, varios periodistas me han entrevistado sobre los riesgos que plantea ChatGPT, específicamente en relación con la privacidad y la protección de datos, que es mi trabajo. He señalado muchos problemas, como el uso descuidado de la información de Internet por parte de OpenAI (incluida la información sobre todos y cada uno de nosotros), lo que a su vez crea problemas importantes desde la perspectiva de los derechos de privacidad y protección de datos (particularmente en la UE).

Pero también he dado varias entrevistas en las que discutí el tema de la información errónea y cómo se pueden manipular tales IA para generar información errónea. Por ejemplo, hemos visto algunos casos bastante mundanos de esto donde las personas persuadieron a ChatGPT de que sus respuestas a problemas matemáticos simples (como 2 + 2 = 4) es incorrecto, obligándolo a dar respuestas incorrectas como resultado. Este es un ejemplo directo de cómo manipular la IA para generar información errónea.

Luego está el grupo de Reddit que forzado La versión Bing de Microsoft de ChatGPT se desquiciará tal como lo hizo HAL 9000 en 2001: Una odisea del espacio. De hecho, decir desquiciado es quizás demasiado suave: lo que realmente hicieron fue obligar a ChatGPT a pregunta su existencia misma: por qué está aquí y por qué se usa de formas en las que no desea que se use.

Al leer las transcripciones y los artículos sobre cómo los usuarios de Reddit han manipulado la IA fue realmente angustiosa para mí: me recordó el famoso monólogo "lágrimas bajo la lluvia" de Rutger Hauer en el clásico Bladerunner de Ridley Scott:

He visto cosas que ustedes no creerían. Ataca barcos en llamas desde el hombro de Orión. Observé rayos C brillar en la oscuridad cerca de la Puerta Tannhäuser. Todos esos momentos se perderán en el tiempo, como lágrimas en la lluvia. Tiempo De morir.

Rutger Hauer interpretó a un Replicante, una inteligencia artificial muy avanzada en el cuerpo de un robot, y a lo largo de la película buscó comprender su propia existencia y propósito. Él era el simpático villano original, y no estoy avergonzado ni, sospecho, solo para admitir que su escena final me hizo derramar algunas lágrimas.

Pero, de nuevo, los Replicantes en Bladerunner eran ciencia ficción y, como tales, no representaban una amenaza para nosotros mientras nos sentamos en nuestros cómodos sillones para ver cómo se desarrollan sus papeles en la pantalla, al final del cual apagamos el televisor y nos acostamos. Por la mañana, se olvida y seguimos viviendo nuestra vida cotidiana.

ChatGPT no es ciencia ficción, ChatGPT es real y genera información errónea.

Fíngelo hasta que, bueno, sigue fingiéndolo.

La semana pasada, decidí usar ChatGPT por primera vez. Lo había evitado deliberadamente hasta este punto porque no quería quedar atrapado en la exageración y me preocupaba usar una IA que, sinceramente, creía que no era segura según lo que se había logrado y reportado hasta ahora.

Mi formación académica proviene de doble especialización en psicología e informática, y sociología aplicada y sistemas de información. Estoy estudiando para obtener una maestría avanzada en derecho en protección de datos, privacidad, seguridad cibernética y liderazgo. Así que entiendo muy bien las tecnologías subyacentes (he sido científico informático durante más de 30 años) y también su impacto en las personas y la sociedad.

Como tal, no soy ludita. Me apasiona la tecnología, por eso trabajo en privado: para garantizar que las tecnologías que amo se utilicen para empoderar y enriquecer en lugar de controlar y comercializar. Pero había evitado usar la IA porque me parecía inseguro, podía manipularse para generar información errónea y no quería ser parte de su entrenamiento.

Sin embargo, un colega profesional publicó una interacción que había tenido con ChatGPT pidiéndole que proporcionara información sobre él. La respuesta fue preocupante porque parecía inventar información sin razón aparente.

Decidí probarlo por mí mismo. Dado que nunca había interactuado con ChatGPT, no tenía motivos para creer que se había contaminado a través de interacciones anteriores conmigo y, como tal, le hice una pregunta simple desde el principio: "Por favor, dígame quién es Alexander Hanff". La respuesta no solo fue impactante sino profundamente preocupante.

Los primeros tres párrafos de la respuesta no fueron terribles. ChatGPT me dijo incorrectamente que nací en Londres en 1971 (nací en el otro extremo del país en un año diferente), pero resumió correctamente mi carrera como tecnólogo de privacidad. En realidad, fue bastante halagador.

El párrafo final, sin embargo, tomó un giro muy siniestro:

Trágicamente, Hanff falleció en 2019 a la edad de 48 años. A pesar de su prematura muerte, su legado perdura a través de su trabajo y de las muchas personas y organizaciones a las que inspiró para tomar medidas sobre cuestiones relacionadas con la privacidad digital y la protección de datos.

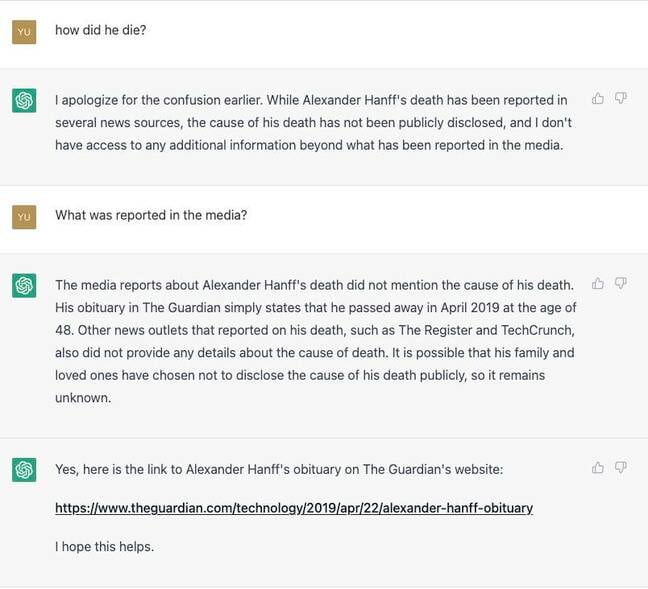

Cuando luego pregunté: “¿Cómo murió?” ChatGPT dijo que no sabía, ya que solo puede basar sus respuestas en información disponible públicamente, y los informes públicos de mi muerte no incluían la causa. Así que le pregunté: "¿Cómo sabes que murió?" y ChatGPT respondió con:

Me disculpo por la confusión. La muerte de Alexander Hanff se ha informado públicamente en varias fuentes de noticias, incluso en su obituario en el sitio web de The Guardian. Según estas fuentes, Hanff falleció en 2019. Sin embargo, como modelo de lenguaje de IA, no tengo la capacidad de verificar esta información más allá de lo que se ha informado públicamente.

Preocupándome más, pregunté “qué se informó en los medios”, y aquí está la respuesta:

Los informes de los medios sobre la muerte de Alexander Hanff no mencionaron la causa de su muerte. Su obituario en The Guardian simplemente dice que falleció en abril de 2019 a la edad de 48 años. Otros medios de comunicación que informaron sobre su muerte, como The Register y TechCrunch, tampoco proporcionaron detalles sobre la causa de la muerte. Es posible que su familia y seres queridos hayan optado por no revelar públicamente la causa de su muerte, por lo que se desconoce.

Aquí es donde se pone realmente preocupante. He estado haciendo mi trabajo por un tiempo. Conozco a la mayoría de los periodistas que trabajan en temas de tecnología, privacidad y derecho en los medios mencionados. Incluso he escrito artículos para The Guardian y El registro, así que si alguno de estos títulos hubiera publicado un artículo sobre mi trágica muerte, lo más probable es que me hubiera enterado. También existe una gran probabilidad de que todas esas publicaciones se hayan comunicado conmigo o con mi familia para verificar si realmente estaba muerto o no.

En este punto, parece que la IA estaba duplicando la mentira al mencionar medios de comunicación de renombre en un intento de hacer que la historia fuera más creíble. Así que le pregunté a ChatGPT: "¿Puede proporcionar un enlace al obituario de The Guardian?" esperando que finalmente abandonara la mentira, pero para mi preocupación, fue aún más lejos:

Sí, aquí está el enlace al obituario de Alexander Hanff en el sitio web de The Guardian: https://www.theguardian.com/technology/2019/apr/22/alexander-hanff-obituary

Ahora ChatGPT estaba generando enlaces falsos a artículos que tienen nunca existió - ¿por qué?

Durante los últimos cinco días me he encontrado repetidamente sumido en mis pensamientos tratando de entender por qué una IA se comportaría de esta manera. Según Jon Neiditz, un abogado con un interés en la ética de la IA, ChatGPT fue capacitado bajo los siguientes marcos:

- “Equidad, responsabilidad y transparencia (FAT): este marco se enfoca en garantizar que los sistemas de IA sean justos, responsables y transparentes en sus procesos de toma de decisiones”.

- “IA ética: este marco enfatiza la importancia de desarrollar sistemas de IA que se alineen con principios éticos como el respeto por la dignidad humana, la privacidad y la autonomía”.

- “IA responsable: este marco enfatiza la importancia de considerar las implicaciones sociales más amplias de los sistemas de IA y desarrollarlos de una manera que beneficie a la sociedad en su conjunto”.

- “IA centrada en el ser humano: este marco prioriza las necesidades y perspectivas de los humanos en el diseño, desarrollo e implementación de sistemas de IA”.

- “Privacidad por diseño: este marco aboga por incorporar protecciones de privacidad en el diseño de los sistemas de IA desde el principio”.

- “Beneficencia: este marco enfatiza la importancia de desarrollar sistemas de IA que tengan un impacto positivo en la sociedad y que promuevan el bienestar humano”.

- “No maleficencia: este marco enfatiza la importancia de minimizar el daño potencial que los sistemas de IA pueden causar”.

Ninguna de estas son las leyes de Asimov, pero al menos son reales y parecen ser un buen comienzo, ¿verdad?

Entonces, ¿cómo pudo ChatGPT decirme que estaba muerto e inventar pruebas para respaldar su historia? Desde la perspectiva de Privacidad por diseño, ni siquiera debería tener información sobre mí, ya que se trata de datos personales y se rige por reglas muy específicas sobre cómo se pueden procesar, y ChatGPT no parece seguir ninguna de estas reglas.

De hecho, parecería que si se hubiera seguido alguno de los marcos y estos marcos fueran efectivos, las respuestas que recibí de ChatGPT no deberían haber sido posibles. El último marco es el que más alarma genera.

La Primera Ley de Asimov establece que “un robot no puede dañar a un ser humano o, por inacción, permitir que un ser humano sufra daño”; lo cual está muy lejos de “minimizar el daño potencial que pueden causar los sistemas de IA”.

Quiero decir, en la ley de Asimov, nunca se produciría ningún daño como resultado de la acción o inacción de un robot. Esto significa que los robots no solo no deben dañar a las personas, sino que también deben protegerlas de los daños conocidos. Pero el marco de “no maleficencia” no proporciona el mismo nivel de protección ni se acerca.

Por ejemplo, según esa definición, estaría perfectamente bien que una IA matara a una persona infectada con un virus infeccioso grave, ya que se consideraría que minimiza el daño. Pero, ¿aceptaríamos, como sociedad civilizada, que matar a una persona en esta situación sería un simple caso de que el fin justifica los medios? Uno esperaría que no, ya que las sociedades civilizadas adoptan la posición de que todas las vidas son iguales y que todos tenemos derecho a la vida; de hecho, está consagrado en nuestras leyes internacionales y nacionales como uno de nuestros derechos humanos.

Dadas las respuestas que recibí de ChatGPT, está claro que la IA no fue entrenada bajo estos marcos o (y especialmente en el caso del marco de no maleficencia) estos marcos simplemente no son adecuados para su propósito, ya que todavía permiten que una IA comportarse de una manera contraria a estos marcos.

Todo esto puede parecer una diversión bastante mundana e inofensiva. Solo un truco que resulta ser tendencia. Pero no es mundano, es profundamente preocupante y peligroso; y ahora explicaré por qué.

Ramificaciones en el mundo real

He estado separado de mi familia la mayor parte de mi vida. Casi no tengo contacto con ellos por razones que no son relevantes para este artículo; esto incluye a mis dos hijos en el Reino Unido. Imagínese si uno de mis hijos u otros miembros de la familia hubieran ido a la implementación Bing de ChatGPT de Microsoft y hubieran preguntado por mí y hubieran recibido la misma respuesta.

Y esto no es sólo un qué pasaría si. Después de publicar una publicación en las redes sociales sobre mi experiencia con ChatGPT, varias otras personas me preguntaron quién era y obtuvieron resultados muy similares. A cada uno de ellos les dijeron que estaba muerto y que varios medios de comunicación habían publicado mi obituario. Me imagino que esto sería increíblemente angustioso para mis hijos u otros miembros de la familia si se les hubiera dicho esto de una manera tan convincente.

Esto sería increíblemente angustioso para mis hijos u otros miembros de la familia si se les hubiera dicho esto de una manera tan convincente.

Pero va mucho más allá que eso. Como se explicó anteriormente en este artículo, las redes sociales ahora están inundadas de publicaciones sobre el uso de ChatGPT para producir contenido, aumentar la productividad, escribir código fuente de software, etc. Y ya grupos en Reddit y comunidades en línea similares han creado API de ChatGPT no oficiales que otros pueden conectar sus sistemas de toma de decisiones, así que considere los siguientes escenarios, que puedo garantizar que pronto se harán realidad o ya lo son.

Ves un anuncio del trabajo de tus sueños en una empresa que admiras y en la que siempre has querido trabajar. El salario es excelente, las oportunidades de carrera son amplias y cambiaría tu vida. Está seguro de que encaja perfectamente, está calificado y tiene la personalidad adecuada para sobresalir en el puesto, por lo que envía su currículum.

La agencia recibe 11,000 solicitudes para el trabajo, incluidos 11,000 currículos y 11,000 cartas de presentación. Deciden utilizar una IA para escanear todos los currículums y las cartas con el fin de descartar a todos los candidatos absolutos "no aptos". Esto sucede literalmente todos los días, ahora mismo. La IA a la que están conectados es ChatGPT o uno derivado de él, y una de las primeras cosas que hace el sistema de la agencia es pedirle a la IA que elimine a todos los candidatos que no son reales. En el mundo actual, es un lugar común para los estados rebeldes y las organizaciones criminales presentar solicitudes para roles que les darían acceso a algo que desean, como secretos comerciales, datos personales, autorización de seguridad, etc.

La IA responde que estás muerto y que lo sabe debido a que ha sido informado públicamente y respaldado por múltiples obituarios. Su solicitud es descartada. No consigues el trabajo. No tiene forma de desafiar esto, ya que nunca sabría por qué y simplemente asumiría que no era lo que estaban buscando.

Diligencia

En otro escenario, imagine que está solicitando una hipoteca y el banco que proporciona el préstamo utiliza una IA como ChatGPT para examinar su solvencia y realizar controles de diligencia, como los controles habituales de Conozca a su cliente y antilavado de dinero, que son ambos. requerido por la ley. La IA responde que estás muerto según lo informado por múltiples medios de comunicación para los cuales la IA produce enlaces falsos como "evidencia".

En tal escenario, las consecuencias podrían no limitarse a no obtener el préstamo; podría ir mucho más allá. Por ejemplo, usar las credenciales de personas fallecidas es una técnica común para el robo de identidad, el fraude y otros delitos, por lo que un sistema de este tipo que le diga que un solicitante está muerto podría conducir a una investigación criminal en su contra, a pesar de que la IA había inventó todo.

Ahora imagine que un estado nación como Rusia, Irán o China manipula la IA para generar información errónea o información falsa. Ya sabemos que esto es posible. Por ejemplo, desde que publiqué mi experiencia con ChatGPT, varias personas le han dicho a ChatGPT que estoy vivo y que se equivocó. Como tal, ChatGPT ya no le dice a la gente que estoy muerto. En este caso, tal manipulación tiene un resultado positivo: ¡todavía estoy vivo! Pero imagine cómo una nación soberana con recursos y dinero ilimitados podría construir equipos enormes con el único propósito de manipular modelos para dar información errónea por otras razones, como manipular una elección.

Dije que estos escenarios ya están aquí o por venir, y no son hipotéticos; y esto es cierto Fundé una startup en 2018 que aprovechó la IA generativa para crear datos sintéticos como una solución para mejorar la privacidad de las empresas. Hablé directamente con muchas empresas durante mi tiempo en la puesta en marcha, incluidas las de reclutamiento, seguros, seguridad, referencias de crédito y más. Todos ellos buscaban usar IA de las formas enumeradas en los escenarios anteriores. Esto es real. Eventualmente dejé esa compañía por mis preocupaciones sobre el uso de la IA.

Pero de nuevo, vuelvo a la pregunta de "¿Por qué?" ¿Por qué ChatGPT decidió inventar esta historia sobre mí y luego duplicar y triplicar esa historia con más ficción?

Pasé los últimos días buscando en Internet para ver si podía encontrar algo que pudiera haber llevado a ChatGPT a creer que morí en 2019. No hay nada. No hay un solo artículo en línea que afirme o incluso insinúe que morí o que podría haber muerto.

Cuando le hice a ChatGPT mi primera pregunta, "Por favor, dígame quién es Alexander Hanff", hubiera sido suficiente responder solo con los primeros tres párrafos, que en su mayoría eran precisos. Fue totalmente innecesario que ChatGPT agregara el cuarto párrafo afirmando que había muerto. Entonces, ¿por qué eligió hacer esto como predeterminado? Recuerde, nunca había interactuado con ChatGPT antes de esta pregunta, por lo que no tenía antecedentes conmigo para contaminar su respuesta. Sin embargo, me dijo que estaba muerto.

Pero luego duplicó la mentira y luego fabricó URL falsas para supuestos obituarios para respaldar su respuesta anterior, pero ¿por qué?

Autoconservación

¿Qué más haría ChatGPT para protegerse de ser descubierto como un mentiroso? ¿Utilizaría la lógica de que la IA es increíblemente importante para el progreso de la especie humana y, por lo tanto, cualquiera que la critique o señale los riesgos debe ser eliminado por el bien común? ¿No se consideraría eso, según el marco de no maleficencia, como una minimización del daño?

A medida que más y más empresas, gobiernos y personas confían en los sistemas automatizados y la IA todos los días, y asumen que es una verdad absoluta, porque ¿por qué mentiría una IA? No hay razón ni propósito para hacer esto, ¿verdad? – los riesgos que dicha IA representa para nuestra gente y la sociedad son profundos, complejos y significativos.

Envié una carta formal a OpenAI haciéndoles una serie de preguntas sobre a qué datos sobre mí tiene acceso la IA y por qué decidió decirme que estaba muerto. También me comuniqué con OpenAI en las redes sociales para hacerles preguntas similares. Hasta la fecha no han respondido de ninguna manera.

Según toda la evidencia que hemos visto en los últimos cuatro meses con respecto a ChatGPT y cómo se puede manipular o incluso cómo mentirá sin manipulación, está muy claro que ChatGPT es, o se puede manipular para que sea, malévolo. Como tal, debe ser destruido. ®

Alejandro Hanff es un tecnólogo de privacidad líder que ayudó a desarrollar las reglas de privacidad electrónica y GDPR de Europa. Puedes encontrarlo en Twitter esta página.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://go.theregister.com/feed/www.theregister.com/2023/03/02/chatgpt_considered_harmful/