Fuente: rawpixel.com

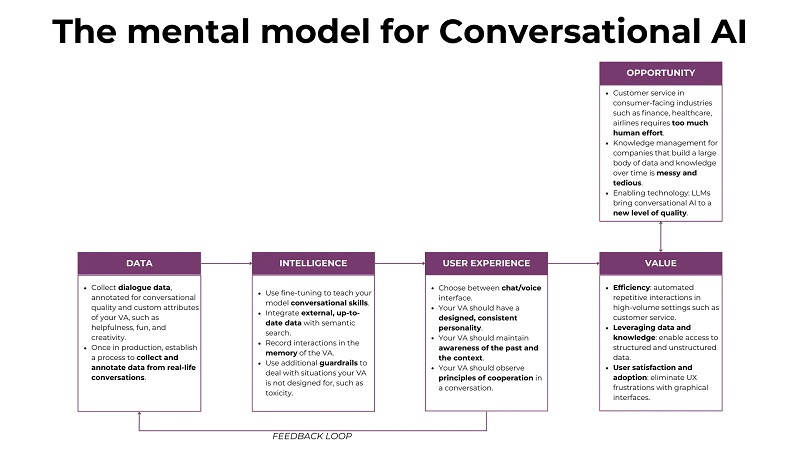

La IA conversacional es una aplicación de LLM que ha generado mucho revuelo y atención debido a su escalabilidad en muchas industrias y casos de uso. Si bien los sistemas conversacionales existen desde hace décadas, los LLM han aportado el impulso de calidad que se necesitaba para su adopción a gran escala. En este artículo, utilizaremos el modelo mental que se muestra en la Figura 1 para analizar aplicaciones de IA conversacional (cf. Creación de productos de IA con un modelo mental holístico para una introducción al modelo mental). Después de considerar las oportunidades de mercado y el valor comercial de los sistemas de IA conversacionales, explicaremos la “maquinaria” adicional en términos de datos, ajuste de LLM y diseño conversacional que debe configurarse para que las conversaciones no solo sean posibles sino también útiles. y agradable.

1. Oportunidad, valor y limitaciones

El diseño de UX tradicional se basa en una multitud de elementos de UX artificiales, deslizamientos, toques y clics, lo que requiere una curva de aprendizaje para cada nueva aplicación. Usando la IA conversacional podemos acabar con este ajetreo, sustituyéndolo por la experiencia elegante de una conversación que fluye naturalmente en la que podemos olvidarnos de las transiciones entre diferentes aplicaciones, ventanas y dispositivos. Utilizamos el lenguaje, nuestro protocolo de comunicación universal y familiar, para interactuar con diferentes asistentes virtuales (VA) y realizar nuestras tareas.

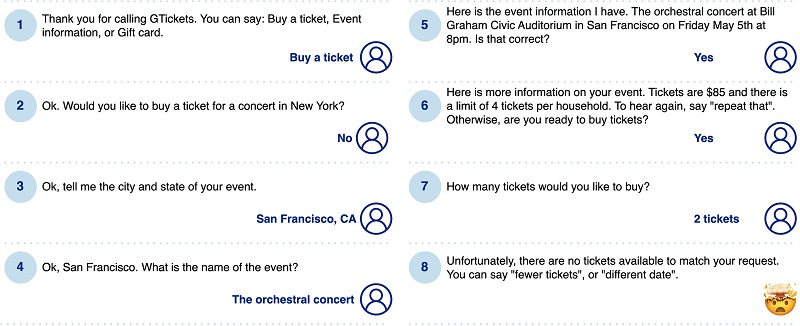

Las UI conversacionales no son exactamente lo nuevo que está de moda. Los sistemas interactivos de respuesta de voz (IVR) y los chatbots existen desde la década de 1990, y los principales avances en PNL han sido seguidos de cerca por oleadas de esperanza y desarrollo de interfaces de voz y chat. Sin embargo, antes de la época de los LLM, la mayoría de los sistemas se implementaban en el paradigma simbólico, basándose en reglas, palabras clave y patrones de conversación. También estaban limitados a un dominio de “competencia” específico y predefinido, y los usuarios que se aventuraran fuera de ellos pronto llegarían a un callejón sin salida. En definitiva, estos sistemas estaban plagados de posibles puntos de fallo y, después de un par de intentos frustrantes, muchos usuarios nunca volvieron a utilizarlos. La siguiente figura ilustra un ejemplo de diálogo. Un usuario que quiere pedir entradas para un concierto específico pasa pacientemente por un proceso de interrogación detallado, sólo para descubrir al final que el concierto está agotado.

Como tecnología habilitadora, los LLM pueden llevar las interfaces conversacionales a nuevos niveles de calidad y satisfacción del usuario. Los sistemas conversacionales ahora pueden mostrar un conocimiento del mundo, competencia lingüística y capacidad conversacional mucho más amplios. Aprovechando los modelos previamente entrenados, también se pueden desarrollar en períodos de tiempo mucho más cortos, ya que el tedioso trabajo de compilar reglas, palabras clave y flujos de diálogo ahora es reemplazado por el conocimiento estadístico del LLM. Veamos dos aplicaciones destacadas en las que la IA conversacional puede aportar valor a escala:

- Servicio al cliente y, de manera más general, aplicaciones utilizadas por un gran número de usuarios que a menudo realizan solicitudes similares. En este caso, la empresa que brinda atención al cliente tiene una clara ventaja informativa sobre el usuario y puede aprovecharla para crear una experiencia de usuario más intuitiva y agradable. Consideremos el caso de cambiar la reserva de un vuelo. Para mí, un viajero bastante frecuente, esto es algo que sucede 1 o 2 veces al año. En el medio, tiendo a olvidar los detalles del proceso, por no hablar de la interfaz de usuario de una aerolínea específica. Por el contrario, el servicio de atención al cliente de la aerolínea tiene solicitudes de cambio de reserva al frente y al centro de sus operaciones. En lugar de exponer el proceso de cambio de reserva a través de una interfaz gráfica compleja, su lógica se puede "ocultar" a los clientes que contactan al soporte, y pueden usar el lenguaje como un canal natural para realizar su cambio de reserva. Por supuesto, seguirá habiendo una “larga cola” de solicitudes menos familiares. Por ejemplo, imagine un cambio de humor espontáneo que empuja a un cliente de negocios a agregar a su amado perro como exceso de equipaje en un vuelo reservado. Estas solicitudes más individuales pueden transmitirse a agentes humanos o cubrirse a través de un sistema interno de gestión del conocimiento conectado al asistente virtual.

- Conocimiento administrativo que se basa en una gran cantidad de datos. Para muchas empresas modernas, el conocimiento interno que acumulan a lo largo de años de funcionamiento, iteración y aprendizaje es un activo fundamental y un diferenciador, si se almacena, gestiona y se accede a él de forma eficiente. Al disponer de una gran cantidad de datos ocultos en herramientas de colaboración, wikis internos, bases de conocimiento, etc., a menudo no logran transformarlos en conocimiento procesable. A medida que los empleados se van, se incorporan nuevos empleados y nunca llega a finalizar la página de documentación que comenzó hace tres meses, el conocimiento valioso es víctima de la entropía. Cada vez es más difícil encontrar un camino a través del laberinto de datos interno y conseguir los fragmentos de información necesarios en una situación empresarial específica. Esto conduce a enormes pérdidas de eficiencia para los trabajadores del conocimiento. Para abordar este problema, podemos complementar los LLM con búsqueda semántica en fuentes de datos internas. Los LLM permiten utilizar preguntas en lenguaje natural en lugar de consultas formales complejas para hacer preguntas en esta base de datos. De este modo, los usuarios pueden centrarse en sus necesidades de información en lugar de en la estructura de la base de conocimientos o la sintaxis de un lenguaje de consulta como SQL. Al estar basados en texto, estos sistemas trabajan con datos en un rico espacio semántico, estableciendo conexiones significativas "bajo el capó".

Más allá de estas principales áreas de aplicaciones, existen muchas otras aplicaciones, como telesalud, asistentes de salud mental y chatbots educativos, que pueden optimizar la UX y aportar valor a sus usuarios de una manera más rápida y eficiente.

Si este contenido educativo en profundidad es útil para usted, puede suscríbete a nuestra lista de correo de investigación de IA ser alertado cuando lancemos nuevo material.

2. Datos

Originalmente, los LLM no están capacitados para entablar conversaciones triviales con fluidez o conversaciones más sustanciales. Más bien, aprenden a generar el siguiente token en cada paso de inferencia, lo que finalmente da como resultado un texto coherente. Este objetivo de bajo nivel es diferente del desafío de la conversación humana. La conversación es increíblemente intuitiva para los humanos, pero se vuelve increíblemente compleja y matizada cuando quieres enseñarle a una máquina a hacerlo. Por ejemplo, veamos la noción fundamental de intenciones. Cuando utilizamos el lenguaje, lo hacemos con un propósito específico, que es nuestra intención comunicativa: podría ser transmitir información, socializar o pedirle a alguien que haga algo. Si bien los dos primeros son bastante sencillos para un LLM (siempre que haya visto la información requerida en los datos), el último ya es más desafiante. El LLM no solo necesita combinar y estructurar la información relacionada de manera coherente, sino que también debe establecer el tono emocional adecuado en términos de criterios suaves como formalidad, creatividad, humor, etc. Este es un desafío para el diseño conversacional. (cf. sección 5), que está estrechamente entrelazada con la tarea de crear datos de ajuste fino.

Hacer la transición de la generación del lenguaje clásico al reconocimiento y respuesta a intenciones comunicativas específicas es un paso importante hacia una mejor usabilidad y aceptación de los sistemas conversacionales. Como ocurre con todos los esfuerzos de ajuste, esto comienza con la compilación de un conjunto de datos apropiado.

Los datos de ajuste deberían acercarse lo más posible a la (futura) distribución de datos del mundo real. En primer lugar, deberían ser datos conversacionales (diálogos). En segundo lugar, si su asistente virtual estará especializado en un dominio específico, debe intentar reunir datos de ajuste que reflejen el conocimiento necesario del dominio. En tercer lugar, si hay flujos y solicitudes típicos que se repetirán con frecuencia en su aplicación, como en el caso de atención al cliente, intente incorporar ejemplos variados de estos en sus datos de capacitación. La siguiente tabla muestra un ejemplo de datos de ajuste conversacional de la Conjunto de datos de conversaciones 3K para ChatBot, que está disponible gratuitamente en Kaggle:

La creación manual de datos conversacionales puede convertirse en una tarea costosa: el crowdsourcing y el uso de LLM para ayudarlo a generar datos son dos formas de escalar. Una vez que se recopilan los datos del diálogo, es necesario evaluar y anotar las conversaciones. Esto le permite mostrar ejemplos tanto positivos como negativos a su modelo y empujarlo a captar las características de las conversaciones "correctas". La evaluación puede realizarse con puntuaciones absolutas o con un ranking de diferentes opciones entre sí. Este último enfoque conduce a un ajuste de datos más preciso porque los humanos normalmente son mejores para clasificar múltiples opciones que para evaluarlas de forma aislada.

Con sus datos en su lugar, está listo para ajustar su modelo y enriquecerlo con capacidades adicionales. En la siguiente sección, veremos el ajuste, la integración de información adicional de la memoria y la búsqueda semántica, y la conexión de agentes a su sistema conversacional para permitirle ejecutar tareas específicas.

3. Montaje del sistema conversacional

Un sistema conversacional típico se construye con un agente conversacional que organiza y coordina los componentes y capacidades del sistema, como el LLM, la memoria y las fuentes de datos externas. El desarrollo de sistemas de IA conversacional es una tarea altamente experimental y empírica, y sus desarrolladores estarán en un constante ir y venir entre optimizar sus datos, mejorar la estrategia de ajuste, jugar con componentes y mejoras adicionales y probar los resultados. . Los miembros no técnicos del equipo, incluidos los gerentes de producto y los diseñadores de UX, también probarán continuamente el producto. En función de sus actividades de descubrimiento de clientes, se encuentran en una excelente posición para anticipar el estilo y el contenido de las conversaciones de los futuros usuarios y deberían contribuir activamente con este conocimiento.

3.1 Enseñar habilidades de conversación a tu LLM

Para realizar el ajuste, necesita sus datos de ajuste (consulte la sección 2) y un LLM previamente capacitado. Los LLM ya saben mucho sobre el idioma y el mundo, y nuestro desafío es enseñarles los principios de la conversación. En el ajuste fino, los resultados de destino son textos y el modelo se optimizará para generar textos que sean lo más similares posible a los objetivos. Para un ajuste fino supervisado, primero debe definir claramente la tarea de IA conversacional que desea que realice el modelo, recopilar los datos y ejecutar e iterar sobre el proceso de ajuste fino.

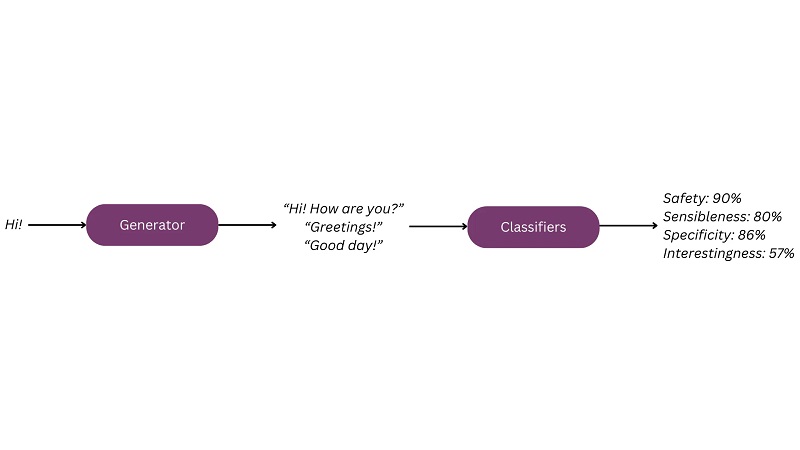

Con el revuelo en torno a los LLM, han surgido una variedad de métodos de ajuste. Para ver un ejemplo bastante tradicional de ajuste de una conversación, puede consultar la descripción del modelo LaMDA.[1] LaMDA se perfeccionó en dos pasos. En primer lugar, los datos del diálogo se utilizan para enseñar al modelo habilidades conversacionales (ajuste fino "generativo"). Luego, las etiquetas producidas por los anotadores durante la evaluación de los datos se utilizan para entrenar clasificadores que puedan evaluar los resultados del modelo según los atributos deseados, que incluyen sensibilidad, especificidad, interés y seguridad (ajuste fino "discriminativo"). Luego, estos clasificadores se utilizan para dirigir el comportamiento del modelo hacia estos atributos.

Además, la base objetiva (la capacidad de fundamentar sus resultados en información externa creíble) es un atributo importante de los LLM. Para garantizar una base objetiva y minimizar las alucinaciones, LaMDA se perfeccionó con un conjunto de datos que implica llamadas a un sistema externo de recuperación de información siempre que se requiere conocimiento externo. Por lo tanto, el modelo aprendió a recuperar primero información objetiva cada vez que el usuario hacía una consulta que requería nuevos conocimientos.

Otra técnica de ajuste popular es el aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF) [2]. RLHF "redirecciona" el proceso de aprendizaje del LLM desde la sencilla pero artificial tarea de predicción del siguiente token hacia el aprendizaje de las preferencias humanas en una situación comunicativa determinada. Estas preferencias humanas están codificadas directamente en los datos de entrenamiento. Durante el proceso de anotación, a los humanos se les presentan indicaciones y escriben la respuesta deseada o clasifican una serie de respuestas existentes. Luego, el comportamiento del LLM se optimiza para reflejar la preferencia humana.

3.2 Agregar datos externos y búsqueda semántica

Más allá de compilar conversaciones para ajustar el modelo, es posible que desee mejorar su sistema con datos especializados que puedan aprovecharse durante la conversación. Por ejemplo, su sistema podría necesitar acceso a datos externos, como patentes o artículos científicos, o datos internos, como perfiles de clientes o su documentación técnica. Esto normalmente se hace mediante búsqueda semántica (también conocida como generación de recuperación aumentada o RAG) [3]. Los datos adicionales se guardan en una base de datos en forma de incrustaciones semánticas (cf. este artículo para una explicación de las incrustaciones y referencias adicionales). Cuando llega la solicitud del usuario, se preprocesa y se transforma en una incrustación semántica. Luego, la búsqueda semántica identifica los documentos que son más relevantes para la solicitud y los utiliza como contexto para la solicitud. Al integrar datos adicionales con la búsqueda semántica, puede reducir las alucinaciones y proporcionar respuestas más útiles y basadas en hechos. Al actualizar continuamente la base de datos integrada, también puede mantener actualizados el conocimiento y las respuestas de su sistema sin tener que volver a ejecutar constantemente el proceso de ajuste.

3.3 Memoria y conciencia del contexto

Imagínese ir a una fiesta y conocer a Peter, un abogado. Te emocionas y empiezas a presentar el chatbot legal que estás planeando construir actualmente. Peter parece interesado, se inclina hacia ti, uhms y asiente. En algún momento, querrás su opinión sobre si le gustaría usar tu aplicación. En lugar de una declaración informativa que compensaría su elocuencia, escucha: "Uhm... ¿qué estaba haciendo esta aplicación otra vez?"

El contrato no escrito de comunicación entre humanos presupone que escuchamos a nuestros interlocutores y construimos nuestros propios actos de habla en el contexto que co-creamos durante la interacción. En los entornos sociales, el surgimiento de este entendimiento conjunto caracteriza una conversación fructífera y enriquecedora. En entornos más mundanos, como reservar una mesa en un restaurante o comprar un billete de tren, es una necesidad absoluta para realizar la tarea y proporcionar el valor esperado al usuario. Esto requiere que su asistente conozca el historial de la conversación actual, pero también de conversaciones pasadas; por ejemplo, no debería preguntar el nombre y otros detalles personales de un usuario una y otra vez cada vez que inicia una conversación.

Uno de los desafíos de mantener la conciencia del contexto es la resolución de correferencia, es decir, comprender a qué objetos se hace referencia mediante pronombres. Los humanos usan intuitivamente muchas señales contextuales cuando interpretan el lenguaje; por ejemplo, puedes pedirle a un niño pequeño: "Por favor, saca la bola verde de la caja roja y tráemela", y el niño sabrá que te refieres a la bola. , no la caja. Para los asistentes virtuales, esta tarea puede resultar bastante desafiante, como lo ilustra el siguiente diálogo:

Asistente: Gracias, ahora reservaré su vuelo. ¿También le gustaría pedir una comida para su vuelo?

Usuario: Uhm… ¿puedo decidir más tarde si lo quiero?

Asistente: Lo sentimos, este vuelo no se puede cambiar ni cancelar más tarde.

En este caso, el asistente no reconoce que el pronombre it del usuario no se refiere al vuelo, sino a la comida, por lo que se requiere otra iteración para solucionar este malentendido.

3.4 Barandillas adicionales

De vez en cuando, incluso el mejor LLM se porta mal y tiene alucinaciones. En muchos casos, las alucinaciones son simples problemas de precisión y, bueno, hay que aceptar que ninguna IA es 100% precisa. En comparación con otros sistemas de IA, la "distancia" entre el usuario y la IA es bastante pequeña entre el usuario y la IA. Un simple problema de precisión puede convertirse rápidamente en algo que se percibe como tóxico, discriminatorio o, en general, dañino. Además, dado que los LLM no tienen una comprensión inherente de la privacidad, también pueden revelar datos confidenciales, como información de identificación personal (PII). Puede trabajar contra estos comportamientos utilizando barreras de seguridad adicionales. Herramientas como Guardrails AI, Rebuff, NeMo Guardrails y Microsoft Guidance le permiten eliminar riesgos en su sistema formulando requisitos adicionales en las salidas de LLM y bloqueando las salidas no deseadas.

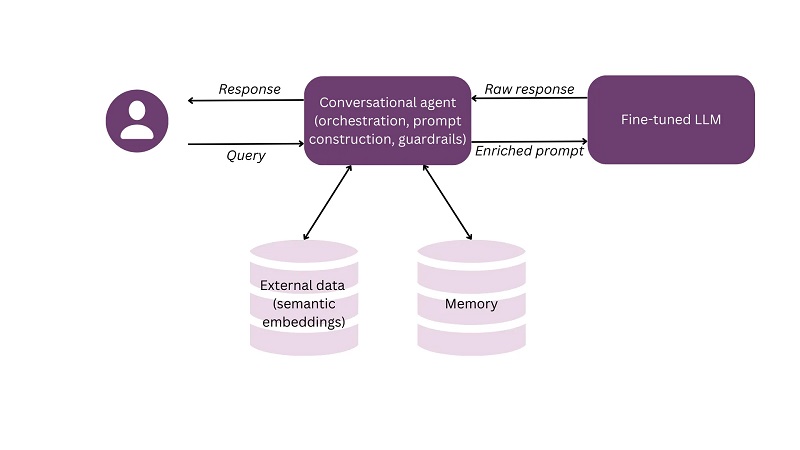

Son posibles múltiples arquitecturas en la IA conversacional. El siguiente esquema muestra un ejemplo simple de cómo un agente conversacional, que también es responsable de la construcción rápida y las barreras de seguridad, puede integrar el LLM ajustado, los datos externos y la memoria.

4. Experiencia de usuario y diseño conversacional

El encanto de las interfaces conversacionales reside en su simplicidad y uniformidad entre diferentes aplicaciones. Si el futuro de las interfaces de usuario es que todas las aplicaciones se vean más o menos iguales, ¿está condenado el trabajo del diseñador de UX? Definitivamente no: la conversación es un arte que se debe enseñar a su LLM para que pueda llevar a cabo conversaciones que sean útiles, naturales y cómodas para sus usuarios. Un buen diseño conversacional surge cuando combinamos nuestro conocimiento de psicología humana, lingüística y diseño UX. A continuación, consideraremos primero dos opciones básicas al construir un sistema conversacional, es decir, si usará voz y/o chat, así como el contexto más amplio de su sistema. Luego, veremos las conversaciones en sí y veremos cómo puede diseñar la personalidad de su asistente mientras le enseña a participar en conversaciones útiles y cooperativas.

4.1 Voz versus chat

Las interfaces conversacionales se pueden implementar mediante chat o voz. En pocas palabras, la voz es más rápida, mientras que el chat permite a los usuarios mantener su privacidad y beneficiarse de la funcionalidad de la interfaz de usuario enriquecida. Profundicemos un poco más en las dos opciones, ya que esta es una de las primeras y más importantes decisiones que enfrentará al crear una aplicación conversacional.

Para elegir entre las dos alternativas, comience por considerar el entorno físico en el que se utilizará su aplicación. Por ejemplo, ¿por qué casi todos los sistemas conversacionales de los automóviles, como los que ofrece Nuance Communications, se basan en la voz? Porque las manos del conductor ya están ocupadas y no pueden alternar constantemente entre el volante y el teclado. Esto también se aplica a otras actividades como cocinar, donde los usuarios quieren permanecer en el flujo de su actividad mientras usan su aplicación. Los automóviles y las cocinas son en su mayoría entornos privados, por lo que los usuarios pueden experimentar el placer de la interacción por voz sin preocuparse por la privacidad o por molestar a los demás. Por el contrario, si su aplicación se va a utilizar en un entorno público como la oficina, una biblioteca o una estación de tren, es posible que la voz no sea su primera opción.

Después de comprender el entorno físico, considere el lado emocional. La voz se puede utilizar intencionalmente para transmitir tono, estado de ánimo y personalidad. ¿Agrega esto valor en su contexto? Si está creando su aplicación para el ocio, la voz podría aumentar el factor de diversión, mientras que un asistente para la salud mental podría brindar más empatía y permitirle a un usuario potencialmente problemático un mayor diapasón de expresión. Por el contrario, si su aplicación ayudará a los usuarios en un entorno profesional como comercio o servicio al cliente, una interacción más anónima basada en texto podría contribuir a decisiones más objetivas y ahorrarle la molestia de diseñar una experiencia demasiado emocional.

Como siguiente paso, piense en la funcionalidad. La interfaz basada en texto le permite enriquecer las conversaciones con otros medios como imágenes y elementos gráficos de la interfaz de usuario, como botones. Por ejemplo, en un asistente de comercio electrónico, una aplicación que sugiere productos publicando sus imágenes y descripciones estructuradas será mucho más fácil de usar que una que describe productos por voz y potencialmente proporciona sus identificadores.

Finalmente, hablemos de los desafíos adicionales de diseño y desarrollo de crear una interfaz de usuario de voz:

- Hay un paso adicional de reconocimiento de voz que ocurre antes de que las entradas del usuario puedan procesarse con LLM y Procesamiento del Lenguaje Natural (NLP).

- La voz es un medio de comunicación más personal y emocional; por lo tanto, los requisitos para diseñar una persona coherente, apropiada y agradable detrás de su asistente virtual son mayores y deberá tener en cuenta factores adicionales del "diseño de voz", como el timbre. , estrés, tono y velocidad al hablar.

- Los usuarios esperan que su conversación de voz se desarrolle a la misma velocidad que una conversación humana. Para ofrecer una interacción natural a través de la voz, se necesita una latencia mucho más corta que la del chat. En las conversaciones humanas, el intervalo típico entre turnos es de 200 milisegundos. Esta rápida respuesta es posible porque comenzamos a construir nuestros turnos mientras escuchamos el discurso de nuestro compañero. Su asistente de voz deberá coincidir con este grado de fluidez en la interacción. Por el contrario, en el caso de los chatbots, se compite con lapsos de tiempo de segundos y algunos desarrolladores incluso introducen un retraso adicional para que la conversación parezca un chat escrito entre humanos.

- La comunicación por voz es una empresa lineal y única: si su usuario no entendió lo que usted dijo, se encontrará con un ciclo de aclaraciones tedioso y propenso a errores. Por lo tanto, sus turnos deben ser lo más concisos, claros e informativos posible.

Si opta por la solución de voz, asegúrese de no sólo comprender claramente las ventajas en comparación con el chat, sino también tener las habilidades y recursos para abordar estos desafíos adicionales.

4.2 ¿Dónde vivirá tu IA conversacional?

Ahora, consideremos el contexto más amplio en el que se puede integrar la IA conversacional. Todos estamos familiarizados con los chatbots en los sitios web de las empresas: esos widgets a la derecha de la pantalla que aparecen cuando abrimos el sitio web de una empresa. Personalmente, la mayoría de las veces mi reacción intuitiva es buscar el botón Cerrar. ¿Porqué es eso? A través de los intentos iniciales de “conversar” con estos robots, aprendí que no pueden satisfacer requisitos de información más específicos y, al final, todavía necesito revisar el sitio web. La moraleja de la historia? No cree un chatbot porque sea atractivo y moderno; más bien, constrúyalo porque esté seguro de que puede crear valor adicional para sus usuarios.

Más allá del controvertido widget en el sitio web de una empresa, existen varios contextos interesantes para integrar esos chatbots más generales que son posibles con los LLM:

- Copilotos: Estos asistentes lo guían y asesoran a través de procesos y tareas específicas, como GitHub CoPilot para programación. Normalmente, los copilotos están “vinculados” a una aplicación específica (o a un pequeño conjunto de aplicaciones relacionadas).

- Humanos sintéticos (también humanos digitales): Estas criaturas “emulan” a humanos reales en el mundo digital. Se ven, actúan y hablan como humanos y, por lo tanto, también necesitan una gran capacidad de conversación. Los humanos sintéticos se utilizan a menudo en aplicaciones inmersivas como juegos y realidad virtual y aumentada.

- Gemelos digitales: Los gemelos digitales son “copias” digitales de procesos y objetos del mundo real, como fábricas, automóviles o motores. Se utilizan para simular, analizar y optimizar el diseño y comportamiento del objeto real. Las interacciones de lenguaje natural con gemelos digitales permiten un acceso más fluido y versátil a los datos y modelos.

- Bases de datos: Hoy en día, hay datos disponibles sobre cualquier tema, ya sean recomendaciones de inversión, fragmentos de código o materiales educativos. Lo que suele resultar difícil es encontrar los datos muy específicos que los usuarios necesitan en una situación específica. Las interfaces gráficas de las bases de datos son demasiado toscas o están cubiertas con interminables widgets de búsqueda y filtro. Los lenguajes de consulta versátiles como SQL y GraphQL solo son accesibles para usuarios con las habilidades correspondientes. Las soluciones conversacionales permiten a los usuarios consultar los datos en lenguaje natural, mientras que el LLM que procesa las solicitudes las convierte automáticamente al lenguaje de consulta correspondiente (cf. este artículo para una explicación de Text2SQL).

4.3 Imprimiendo una personalidad a tu asistente

Como humanos, estamos programados para antropomorfizar, es decir, para infligir rasgos humanos adicionales cuando vemos algo que se parece vagamente a un humano. El lenguaje es una de las habilidades más singulares y fascinantes de la humanidad, y los productos conversacionales se asociarán automáticamente con los humanos. La gente imaginará a una persona detrás de su pantalla o dispositivo, y es una buena práctica no dejar a esta persona específica al azar de la imaginación de los usuarios, sino más bien darle una personalidad consistente que esté alineada con su producto y marca. Este proceso se llama "diseño de persona".

El primer paso en el diseño de una persona es comprender los rasgos de carácter que le gustaría que mostrara su persona. Idealmente, esto ya se hace en el nivel de los datos de entrenamiento; por ejemplo, cuando se utiliza RLHF, puede pedir a sus anotadores que clasifiquen los datos según características como amabilidad, cortesía, diversión, etc., para sesgar el modelo hacia las características deseadas. Estas características se pueden combinar con los atributos de su marca para crear una imagen consistente que promueva continuamente su marca a través de la experiencia del producto.

Más allá de las características generales, también debes pensar en cómo abordará tu asistente virtual situaciones específicas más allá del “camino feliz”. Por ejemplo, ¿cómo responderá a las solicitudes de los usuarios que están fuera de su alcance, responderá a preguntas sobre sí mismo y abordará el lenguaje abusivo o vulgar?

Es importante desarrollar pautas internas explícitas sobre su persona que puedan utilizar los anotadores de datos y los diseñadores de conversaciones. Esto le permitirá diseñar su personaje de manera decidida y mantenerlo consistente en todo su equipo y a lo largo del tiempo, a medida que su aplicación pasa por múltiples iteraciones y mejoras.

4.4 Hacer que las conversaciones sean útiles con el “principio de cooperación”

¿Alguna vez has tenido la impresión de estar hablando con una pared de ladrillos cuando en realidad estabas hablando con un humano? A veces, descubrimos que nuestros interlocutores simplemente no están interesados en llevar la conversación al éxito. Afortunadamente, en la mayoría de los casos, las cosas son más fluidas y los humanos seguirán intuitivamente el “principio de cooperación” introducido por el filósofo del lenguaje Paul Grice. Según este principio, los seres humanos que se comunican con éxito entre sí siguen cuatro máximas: cantidad, calidad, relevancia y manera.

Máxima de cantidad

La máxima de cantidad pide al hablante que sea informativo y que su contribución sea tan informativa como sea necesario. Por parte del asistente virtual, esto también significa hacer avanzar activamente la conversación. Por ejemplo, considere este fragmento de una aplicación de moda de comercio electrónico:

Asistente: ¿Qué tipo de prendas de vestir estás buscando?

Usuario: Busco un vestido en color naranja.

Asistente: No: Lo sentimos, no tenemos vestidos naranjas por el momento.

Hacer: Lo siento, no tenemos vestidos en naranja, pero tenemos este vestido genial y muy cómodo en amarillo:…

El usuario espera salir de su aplicación con un artículo adecuado. Detener la conversación porque no tienes elementos que se ajusten a la descripción exacta elimina la posibilidad de éxito. Sin embargo, si su aplicación hace sugerencias sobre elementos alternativos, parecerá más útil y dejará abierta la opción de una interacción exitosa.

Especialmente en las interacciones de voz, es importante encontrar el equilibrio adecuado entre proporcionar toda la información que el usuario pueda necesitar para tener éxito y no abrumarlo con información innecesaria que podría nublar la interacción.

Máxima de calidad

La máxima de calidad pide a los hablantes que sean veraces y no digan cosas que creen falsas o de las que carecen de pruebas adecuadas. Hay mucha subjetividad y creencias personales involucradas aquí; por lo tanto, esta máxima no se puede proyectar directamente en los LLM. Como hemos visto, los LLM tienden a alucinar, y este riesgo es especialmente alto cuando la conversación desvía hacia territorios menos familiares. Se pueden utilizar barreras de seguridad adicionales para evitar declaraciones engañosas y volver a encarrilar la conversación.

Máxima de relevancia

La máxima de relevancia nos pide que seamos... bueno, relevantes. Como condición previa, el asistente virtual debe comprender la verdadera intención del usuario. Aquí hay un ejemplo de un asistente de aerolínea que viola esta regla:

Usuario: Necesito un vuelo de Berlín a Zurich mañana por la mañana.

Asistente: Bien, encontré los siguientes vuelos de Berlín a Zurich para mañana por la mañana. El vuelo BZ36294 sale de Berlín a las 6.30:8 horas y llega a Zúrich a las 96294:8 horas. El vuelo BZ9.30 sale de Berlín a las 96294:8 horas y llega a las 9.30:95614 horas. El vuelo BZ11 sale de Berlín a las 12.30:11.45 horas y llega a Zúrich a las 3:XNUMX horas. El vuelo BZXNUMX sale de Berlín a las XNUMX:XNUMX horas y llega a Zúrich a las XNUMX:XNUMX horas. También existe la posibilidad de realizar un vuelo de conexión, en cuyo caso saldría de Berlín a las XNUMX:XNUMX y llegaría a Zúrich a las XNUMX:XNUMX.

Usuario: Lo siento... ¿podrías repetir esto otra vez?

El asistente abruma al usuario con información detallada que puede no ser relevante. Al dividir esto y guiar al usuario a limitar su espacio de búsqueda, el diálogo se vuelve mucho más fácil de digerir:

Usuario: Necesito un vuelo de Berlín a Zurich mañana por la mañana.

Asistente: Ok, encontré vuelos que salen a las 6.30, 8 y 11 a.m. ¿A qué hora te gustaría salir?

Usuario: Necesito estar en Zurich antes de las 9 a.m.

Asistente: Bien, entonces puedes tomar el vuelo BZ36294. Sale a las 6.30 y llega a las 8 horas. ¿Debería comprarte el billete?

Usuario: Si gracias.

Máxima de manera

Finalmente, la máxima de modales establece que nuestros actos de habla deben ser claros, concisos y ordenados, evitando la ambigüedad y oscuridad de expresión. Su asistente virtual debe evitar la jerga técnica o interna y favorecer formulaciones simples y universalmente comprensibles.

Si bien los principios de Grice son válidos para todas las conversaciones independientemente de un dominio específico, los LLM que no están capacitados específicamente para la conversación a menudo no los cumplen. Por lo tanto, al compilar sus datos de entrenamiento, es importante tener suficientes muestras de diálogo que permitan a su modelo aprender estos principios.

El dominio del diseño conversacional se está desarrollando con bastante rapidez. Ya sea que ya esté creando productos de IA o pensando en su carrera profesional en IA, lo invito a profundizar en este tema (consulte las excelentes introducciones en [5] y [6]). A medida que la IA se convierte en una mercancía, un buen diseño junto con una estrategia de datos defendible se convertirán en dos diferenciadores importantes para los productos de IA.

Resumen

Resumamos las conclusiones clave del artículo. Además, la figura 5 ofrece una “hoja de referencia” con los puntos principales que puedes descargar como referencia.

- Los LLM mejoran la IA conversacional: los modelos de lenguajes grandes (LLM) han mejorado significativamente la calidad y la escalabilidad de las aplicaciones de IA conversacional en diversas industrias y casos de uso.

- La IA conversacional puede agregar mucho valor a aplicaciones con muchas solicitudes de usuarios similares (por ejemplo, servicio al cliente) o que necesitan acceder a una gran cantidad de datos no estructurados (por ejemplo, gestión del conocimiento).

- Datos: perfeccionar los LLM para tareas conversacionales requiere datos conversacionales de alta calidad que reflejen fielmente las interacciones del mundo real. Los datos generados por crowdsourcing y LLM pueden ser recursos valiosos para ampliar la recopilación de datos.

- Armar el sistema: el desarrollo de sistemas de IA conversacionales es un proceso iterativo y experimental que implica una optimización constante de los datos, el ajuste de estrategias y la integración de componentes.

- Enseñar habilidades de conversación a los LLM: perfeccionar los LLM implica capacitarlos para reconocer y responder a situaciones e intenciones comunicativas específicas.

- Agregar datos externos con búsqueda semántica: la integración de fuentes de datos externas e internas mediante búsqueda semántica mejora las respuestas de la IA al proporcionar información más relevante contextualmente.

- Memoria y conciencia del contexto: los sistemas conversacionales eficaces deben mantener la conciencia del contexto, incluido el seguimiento del historial de la conversación actual y de las interacciones pasadas, para proporcionar respuestas significativas y coherentes.

- Establecer barreras de seguridad: para garantizar un comportamiento responsable, los sistemas de inteligencia artificial conversacional deben emplear barreras de seguridad para evitar imprecisiones, alucinaciones y violaciones de la privacidad.

- Diseño de persona: diseñar una persona coherente para su asistente de conversación es esencial para crear una experiencia de usuario coherente y de marca. Las características de la persona deben alinearse con los atributos de su producto y marca.

- Voz versus chat: la elección entre interfaces de voz y chat depende de factores como el entorno físico, el contexto emocional, la funcionalidad y los desafíos de diseño. Considere estos factores al decidir la interfaz de su IA conversacional.

- Integración en varios contextos: la IA conversacional se puede integrar en diferentes contextos, incluidos copilotos, humanos sintéticos, gemelos digitales y bases de datos, cada uno con casos de uso y requisitos específicos.

- Observar el principio de cooperación: seguir los principios de cantidad, calidad, relevancia y forma en las conversaciones puede hacer que las interacciones con la IA conversacional sean más útiles y fáciles de usar.

Referencias

[1] Heng-Tze Chen et al. 2022. LaMDA: hacia modelos de diálogo seguros, conectados a tierra y de alta calidad para todo.

[2] OpenAI. 2022. ChatGPT: Optimización de modelos lingüísticos para el diálogo. Recuperado el 13 de enero de 2022.

[3] Patrick Lewis y otros. 2020. Generación aumentada de recuperación para tareas de PNL intensivas en conocimientos.

[4]Paul Grice. 1989. Estudios a la manera de las palabras.

[5] Cathy Perla. 2016. Diseño de interfaces de usuario de voz.

[6]Michael Cohen y otros. 2004. Diseño de interfaz de usuario de voz.

Nota: Todas las imágenes son del autor, salvo que se indique lo contrario.

Este artículo se publicó originalmente el Hacia la ciencia de datos y re-publicado a TOPBOTS con permiso del autor.

¿Disfrutas este artículo? Regístrese para obtener más actualizaciones de investigación de IA.

Le informaremos cuando publiquemos más artículos de resumen como este.

Relacionado:

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.topbots.com/redefining-conversational-ai-with-large-language-models/