Introducción

ChatGPT es un poderoso modelo de lenguaje desarrollado por OpenAI que ha conquistado al mundo con su capacidad para comprender y responder conversacionalmente a la información humana. Una de las características más interesantes de ChatGPT es su capacidad para generar fragmentos de código en varios lenguajes de programación, incluidos Python, Java, JavaScript y C++. Esta característica ha hecho ChatGPT una opción popular entre los desarrolladores que desean crear prototipos o resolver un problema rápidamente sin tener que escribir ellos mismos todo el código base. Este artículo explorará cómo el intérprete de código de ChatGPT para el análisis de datos avanzado para científicos de datos. Además, veremos cómo funciona y cómo se puede utilizar para generar código de aprendizaje automático. También discutiremos algunos beneficios y limitaciones del uso de ChatGPT.

OBJETIVOS DE APRENDIZAJE

- Comprenda cómo funciona el análisis de datos avanzado de ChatGPT y cómo se puede utilizar para generar código de aprendizaje automático.

- Aprenda a utilizar el análisis de datos avanzado de ChatGPT para generar fragmentos de código para científicos de datos que utilizan Python.

- Comprenda los beneficios y limitaciones del análisis de datos avanzado de ChatGPT para generar código de aprendizaje automático.

- Aprenda a diseñar e implementar modelos de aprendizaje automático utilizando el análisis de datos avanzado de ChatGPT.

- Comprenda cómo preprocesar datos para el aprendizaje automático, incluido el manejo de valores faltantes, "codificar variables categóricas, normalizar datos y escalar características numéricas". codificar variables categóricas, normalizar datos y escalar características numéricas.

- Aprenda a dividir datos en conjuntos de entrenamiento y prueba y a evaluar el rendimiento de los modelos de aprendizaje automático utilizando métricas como exactitud, precisión, recuperación, puntuación F1, error cuadrático medio, error absoluto medio, valor R cuadrado, etc.

Al dominar estos objetivos de aprendizaje, uno debe comprender cómo utilizar el análisis de datos avanzado de ChatGPT para generar código de aprendizaje automático e implementar varios algoritmos de aprendizaje automático. También deberían poder aplicar estas habilidades a problemas y conjuntos de datos del mundo real, demostrando su competencia en el uso del análisis de datos avanzado de ChatGPT para tareas de aprendizaje automático.

Este artículo fue publicado como parte del Blogatón de ciencia de datos.

Tabla de contenidos.

¿Cómo funciona el análisis de datos avanzado de ChatGPT?

El análisis de datos avanzado de ChatGPT se basa en un deep learning modelo llamado transformador, entrenado en un gran corpus de datos de texto. El transformador utiliza mecanismos de autoatención para comprender el contexto y la relación entre las diferentes partes del texto de entrada. Cuando un usuario ingresa un mensaje o un fragmento de código, el modelo de ChatGPT genera una respuesta basada en los patrones y estructuras que ha aprendido de los datos de entrenamiento.

El análisis de datos avanzado en ChatGPT puede generar fragmentos de código aprovechando la gran cantidad de código en línea. El modelo de ChatGPT puede aprender la sintaxis, la semántica y los modismos de varios lenguajes de programación mediante el análisis de repositorios de código abierto y otras fuentes de código. El modelo de ChatGPT puede aprovechar este conocimiento cuando un usuario solicita un fragmento de código para generar un fragmento de código relevante y funcional.

Generando código de aprendizaje automático con ChatGPT

Aprendizaje automático es una de las aplicaciones más prometedoras del análisis de datos avanzado de ChatGPT. Con el auge de las aplicaciones de aprendizaje profundo y aprendizaje automático, se han convertido en áreas de investigación y desarrollo cada vez más importantes. Sin embargo, diseñar e implementar estos modelos puede ser complejo y llevar mucho tiempo, y requiere experiencia en álgebra lineal, cálculo, teoría de la probabilidad e informática.

El análisis de datos avanzado de ChatGPT puede ayudar a simplificar este proceso generando fragmentos de código de aprendizaje automático que los usuarios pueden integrar en sus proyectos. Por ejemplo, un usuario puede pedirle a ChatGPT que genere un fragmento de código utilizando una técnica de regresión lineal para predecir los precios de la vivienda en California basándose en un conjunto de datos de entrenamiento proporcionado como entrada en formato .csv. El modelo de ChatGPT puede generar un fragmento de código que incluye las importaciones necesarias, los pasos de preprocesamiento de datos, la arquitectura del modelo y los procedimientos de capacitación basados en la entrada del usuario.

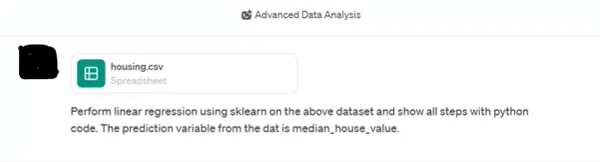

Cargue el conjunto de datos al intérprete de código en ChatGPT e ingrese el mensaje a continuación.

Rápido:

Realizar regresión lineal usando sklearn en el conjunto de datos anterior y muestre todos los pasos con código Python. La variable de predicción de los datos es mediana_house_value.

Respuesta:

Los pasos para la regresión lineal usando aprender en el conjunto de datos "housing.csv", utilizando "median_house_value" como variable de destino, son los siguientes:

- Exploración de datos: Cargue el conjunto de datos y examine rápidamente su estructura.

- Preprocesamiento de datos: Maneje valores faltantes, codifique variables categóricas (si las hay) y escale características numéricas.

- Dividiendo los datos: Divida los datos en conjuntos de prueba y entrenamiento.

- Entrenamiento modelo: Entrene un modelo de regresión en el conjunto de entrenamiento.

- Evaluación: Evalúe el modelo entrenado en el conjunto de prueba.

- Interpretación del modelo: Analizar la importancia de cada característica en la predicción.

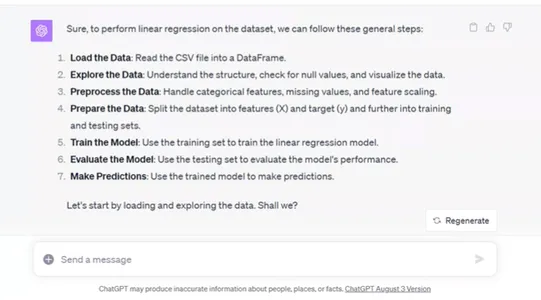

Cargando el conjunto de datos y explorando su estructura:

# Load the dataset

data = pd.read_csv('/mnt/data/housing.csv')

# Display the first few rows of the dataset to understand its structure

data.head()

#import csv

El conjunto de datos contiene las siguientes columnas:

- longitud: Longitud de la ubicación

- latitud: Latitud de la ubicación

- edad_mediana_vivienda: Edad media de las viviendas de la zona.

- total_habitaciones: Número total de habitaciones en el área.

- total_dormitorios: Número total de dormitorios en el área.

- población: Población de la zona

- hogares: Número de hogares en el área.

- ingreso medio: Ingreso medio de la población de la zona

- valor_casa_mediana: Valor medio de la vivienda en la zona (nuestra variable objetivo)

- proximidad_oceánica: Cercanía al océano (variable categórica)

A continuación, procedamos con el preprocesamiento de datos:

Preprocesamiento de datos:

- Compruebe si faltan valores y trátelos.

- Codifique la variable categórica ocean_proximity.

- Escale características numéricas para estandarizarlas.

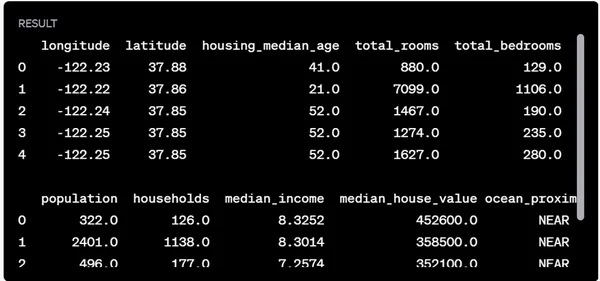

Comprobando valores faltantes en el conjunto de datos:

# Check for missing values in each column

missing_values = data.isnull().sum()

missing_values

Parece que la total_dormitorios La columna tiene 207 valores faltantes. Una estrategia común para manejar los valores faltantes de las columnas numéricas es reemplazarlos con el valor mediano de esa columna. Completemos los valores que faltan en total_dormitorios con su valor mediano.

Después de eso, codificaremos el proximidad_oceánica variable categórica utilizando codificación one-hot y escalar las características numéricas.

Pasos de preprocesamiento:

from sklearn.preprocessing import StandardScaler, OneHotEncoder

from sklearn.compose import ColumnTransformer

from sklearn.pipeline import Pipeline

# Fill missing values in total_bedrooms with its median value

data['total_bedrooms'].fillna(data['total_bedrooms'].median(), inplace=True)

# Define columns for preprocessing

numerical_features = ['longitude', 'latitude', 'housing_median_age', 'total_rooms',

'total_bedrooms', 'population', 'households', 'median_income']

categorical_feature = ['ocean_proximity']

# Create a column transformer for preprocessing

preprocessor = ColumnTransformer(

transformers=[

('num', StandardScaler(), numerical_features),

('cat', OneHotEncoder(), categorical_feature)

])

# Apply the transformations to the data (excluding the target variable)

X = data.drop('median_house_value', axis=1)

y = data['median_house_value']

X_transformed = preprocessor.fit_transform(X)

# Checking the transformed data's shape and first few rows to ensure preprocessing was successful

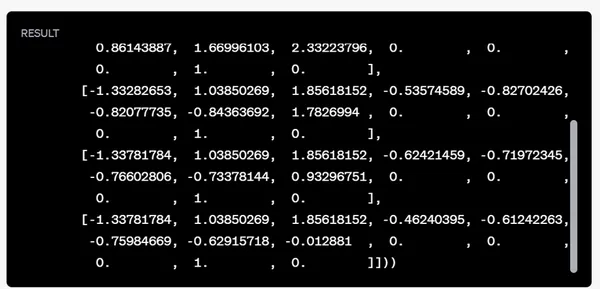

X_transformed.shape, X_transformed[:5]

Los pasos de preprocesamiento fueron exitosos:

- Compruebe si faltan valores y trátelos.

- Codifique la variable categórica ocean_proximity.

- Escale características numéricas para estandarizarlas.

El conjunto de datos transformado tiene 20,640 muestras y 13 características.

Dividiendo los datos:

A continuación, dividiremos los datos en conjuntos de entrenamiento y prueba. Esto nos permite entrenar nuestro modelo en un subconjunto y

Pruebe su rendimiento en otro subconjunto invisible. Normalmente, una proporción de división común es 80:20 o 70:30 para entrenamiento y pruebas. Para este ejercicio, usaremos una división 80:20.

Dividamos los datos.

from sklearn.model_selection

import train_test_split

# Splitting the data into training and test sets (80% training, 20% testing)

X_train, X_test, y_train, y_test = train_test_split(X_transformed, y, test_size=0.2,

random_state=42)

X_train.shape, X_test.shape

Los datos se han dividido con éxito en conjuntos de entrenamiento y prueba:

- Conjunto de entrenamiento: 16,512 muestras

- Equipo de prueba: 4,128 muestras

Entrenamiento modelo:

A continuación, entrenaremos un modelo de regresión utilizando los datos de entrenamiento. Para esta demostración, usaremos un simple

modelo de regresión lineal. Si es necesario, más adelante se pueden explorar modelos más complejos o métodos de conjunto.

Entrene el modelo de regresión lineal:

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error

# Initialize the Linear Regression model

model = LinearRegression()

# Train the model on the training data

model.fit(X_train, y_train)

# Predict on the training data to check in-sample performance

train_predictions = model.predict(X_train)

train_mse = mean_squared_error(y_train, train_predictions)

train_rmse = train_mse**0.5

train_rmse

El error cuadrático medio (RMSE) de las predicciones sobre los datos de entrenamiento es de aproximadamente 68,433.94 dólares.

El RMSE nos da una idea de la magnitud media de los errores de predicción. En este contexto, las predicciones de nuestro modelo están, en promedio, a unos $68,433.94 de distancia de los valores reales de la vivienda en el conjunto de entrenamiento.

Evaluación:

Predeciremos los datos de prueba y calcularemos el RMSE de estas predicciones para evaluar la capacidad de generalización del modelo.

Evaluemos el modelo en el conjunto de prueba.

# Predict on the test data

test_predictions = model.predict(X_test)

# Compute the RMSE for the test predictions

test_mse = mean_squared_error(y_test, test_predictions)

test_rmse = test_mse**0.5

test_rmse

El error cuadrático medio (RMSE) de las predicciones sobre los datos de prueba es de aproximadamente $70,060.52.

El RMSE de prueba es ligeramente superior al RMSE de entrenamiento, lo cual se esperaba ya que el modelo no fue entrenado con los datos de prueba. Sin embargo, los valores son relativamente cercanos, lo que sugiere que el modelo no sobreajusta demasiado los datos de entrenamiento.

Interpretación del modelo:

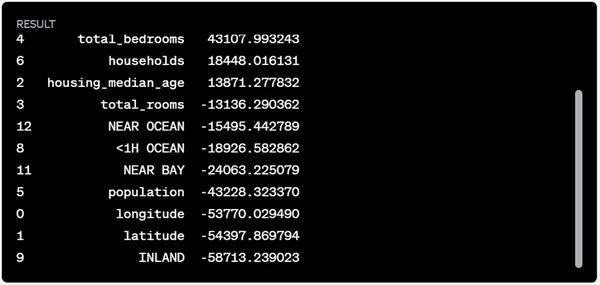

Para comprender mejor el modelo, podemos observar los coeficientes de cada característica. Estos coeficientes indican la importancia y el impacto de cada característica en la variable objetivo, valor_casa_mediana.

Echemos un vistazo a los coeficientes de características.

# Extract feature names after one-hot encoding

feature_names = numerical_features + list(preprocessor.named_transformers_['cat'].categories_[0])

# Retrieve the coefficients from the model

coefficients = model.coef_

# Create a DataFrame to display the feature coefficients

feature_importance = pd.DataFrame({

'Feature': feature_names,

'Coefficient': coefficients

}).sort_values(by='Coefficient', ascending=False)

feature_importance

Aquí están las interpretaciones de los coeficientes de características:

- Los coeficientes positivos indican que a medida que aumenta el valor de la característica, el valor_casa_mediano previsto también aumenta.

- Los coeficientes negativos indican que a medida que aumenta el valor de la característica, el valor_casa_mediano previsto disminuye.

Por ejemplo:

- ISLA tiene el coeficiente positivo más alto, lo que sugiere que las casas en las islas tienen un valor previsto más alto que en otras ubicaciones.

- mediana_ingreso también tiene un efecto positivo significativo en el valor previsto de la vivienda.

- Por otro lado, INLAND tiene el efecto más negativo, lo que indica que las casas ubicadas tierra adentro tienden a tener un valor previsto más bajo.

- Las características geográficas como la longitud y la latitud también desempeñan un papel en la determinación del valor de la vivienda, y ambas tienen coeficientes negativos en este modelo.

Si bien estos coeficientes brindan información sobre las relaciones entre las características y la variable objetivo, no necesariamente implican causalidad. Los factores externos y las interacciones entre características también podrían influir en el valor de la vivienda.

Beneficios de utilizar ChatGPT para la generación de código de aprendizaje automático

Existen varios beneficios al utilizar el análisis de datos avanzado de ChatGPT para generar código de aprendizaje automático:

- Ahorro de tiempo: Diseñar e implementar un modelo de aprendizaje automático puede llevar mucho tiempo, especialmente para los principiantes. El análisis de datos avanzado de ChatGPT puede ahorrarles a los usuarios mucho tiempo al generar fragmentos de código de trabajo que pueden usar como punto de partida para sus proyectos.

- Productividad mejorada: Con el análisis de datos avanzado de ChatGPT, los usuarios pueden centrarse en los conceptos de alto nivel de su proyecto de aprendizaje automático, como el preprocesamiento de datos, la ingeniería de características y la evaluación del modelo, sin atascarse en los detalles de la implementación de la arquitectura del modelo.

- Accesibilidad: El análisis de datos avanzado de ChatGPT hace que el aprendizaje automático sea más accesible para personas que quizás no tengan una sólida formación en informática o programación. Los usuarios pueden describir sus deseos y ChatGPT generará el código necesario.

- Personalización: El análisis de datos avanzado de ChatGPT permite a los usuarios personalizar el código generado para satisfacer sus necesidades. Los usuarios pueden modificar los hiperparámetros, ajustar la arquitectura del modelo o agregar funcionalidad adicional al fragmento de código.

Limitaciones del uso de ChatGPT para la generación de código de aprendizaje automático

Si bien el intérprete de código de ChatGPT es una herramienta poderosa para generar código de aprendizaje automático, existen algunas limitaciones a considerar:

- Calidad del código generado: Si bien el análisis de datos avanzado de ChatGPT puede generar fragmentos de código de trabajo, la calidad del código puede variar según la complejidad de la tarea y la calidad de los datos de entrenamiento. Es posible que los usuarios necesiten limpiar el código, corregir errores u optimizar el rendimiento antes de usarlo en producción.

- Falta de conocimiento del dominio: Es posible que el modelo de ChatGPT no siempre comprenda los matices de un dominio o área de aplicación en particular. Es posible que los usuarios necesiten proporcionar contexto u orientación adicional para ayudar a ChatGPT a generar código que cumpla con sus requisitos.

- Dependencia de los datos de entrenamiento: El análisis de datos avanzado de ChatGPT depende en gran medida de la calidad y diversidad de los datos de entrenamiento a los que ha estado expuesto. Si los datos de entrenamiento están sesgados o están incompletos, el código generado puede reflejar esas deficiencias.

- Consideraciones éticas: Existen preocupaciones éticas en torno al uso de código generado por IA en aplicaciones críticas, como la atención médica o las finanzas. Los usuarios deben evaluar cuidadosamente el código generado y asegurarse de que cumpla con los estándares y regulaciones requeridos.

Conclusión

El análisis de datos avanzado de ChatGPT es una poderosa herramienta para generar fragmentos de código. Con su capacidad para comprender indicaciones del lenguaje natural y generar código de trabajo, ChatGPT tiene el potencial de democratizar el acceso a la tecnología de aprendizaje automático y acelerar la innovación en el campo. Sin embargo, los usuarios deben ser conscientes de las limitaciones de la tecnología y evaluar cuidadosamente el código generado antes de utilizarlo en producción. A medida que las capacidades de ChatGPT continúan evolucionando, podemos esperar ver aplicaciones aún más interesantes de esta tecnología.

Puntos clave

- El análisis de datos avanzado de ChatGPT se basa en un modelo de aprendizaje profundo llamado transformador, entrenado en un gran corpus de datos de texto.

- El análisis de datos avanzado puede generar fragmentos de código en varios lenguajes de programación, incluidos Python, Java, JavaScript y C++, aprovechando la gran cantidad de código en línea.

- El análisis de datos avanzado de ChatGPT puede generar fragmentos de código de aprendizaje automático para regresión lineal, regresión logística, árboles de decisión, bosques aleatorios, máquinas de vectores de soporte, redes neuronales y aprendizaje profundo.

- Para utilizar el análisis de datos avanzado de ChatGPT para el aprendizaje automático, los usuarios pueden proporcionar un mensaje o un fragmento de código y solicitar una tarea específica, como generar un fragmento de código para un modelo de regresión lineal utilizando un conjunto de datos en particular.

- El modelo de ChatGPT puede generar fragmentos de código que incluyen las importaciones necesarias, pasos de preprocesamiento de datos, arquitectura del modelo y procedimientos de capacitación.

- El análisis de datos avanzado de ChatGPT puede ayudar a simplificar el diseño y la implementación de modelos de aprendizaje automático, lo que facilita a los desarrolladores y científicos de datos crear prototipos o resolver un problema rápidamente.

- Sin embargo, también existen limitaciones en el uso del análisis de datos avanzado de ChatGPT, como la posibilidad de que el código generado contenga errores o la falta de opciones de personalización.

- En general, el análisis de datos avanzado de ChatGPT es una herramienta poderosa que puede ayudar a agilizar el proceso de desarrollo para desarrolladores y científicos de datos, especialmente cuando se generan fragmentos de código de aprendizaje automático.

Preguntas frecuentes

R: Vaya al sitio web de ChatGPT y comience a escribir sus preguntas o indicaciones de codificación. Luego, el sistema responderá según su comprensión de su consulta. También puede consultar tutoriales y documentación en línea para ayudarle a comenzar.

R: El intérprete de código de ChatGPT admite varios lenguajes de programación populares, incluidos Python, Java, JavaScript y C++. También puede generar fragmentos de código en otros idiomas, aunque la calidad del resultado puede variar según la complejidad del código y la disponibilidad de ejemplos en los datos de entrenamiento.

R: Sí, el intérprete de código de ChatGPT puede manejar tareas de codificación complejas, incluidos algoritmos de aprendizaje automático, análisis de datos y desarrollo web. Sin embargo, la calidad del código generado puede depender de la complejidad de la tarea y del tamaño del conjunto de datos de entrenamiento disponible para el modelo.

R: Sí, el código generado por el intérprete de códigos de ChatGPT es de uso gratuito según los términos de la licencia MIT. Esto significa que puede modificar, distribuir y utilizar el código con fines comerciales sin pagar regalías ni obtener el permiso del autor.

Los medios que se muestran en este artículo no son propiedad de Analytics Vidhya y se utilizan a discreción del autor.

Relacionado:

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.analyticsvidhya.com/blog/2023/11/chatgpts-code-interpreter-gpt-4-advanced-data-analysis-for-data-scientists/