El equipo de Diseño y Construcción de Amazon EU (Amazon D&C) es el equipo de ingeniería que diseña y construye los almacenes de Amazon. El equipo navega por un gran volumen de documentos y localiza la información correcta para asegurarse de que el diseño del almacén cumpla con los más altos estándares. En el post Una solución generativa impulsada por IA en Amazon SageMaker para ayudar a Amazon EU Design and Construction, presentamos una solución de bot de respuesta a preguntas utilizando un Recuperación Generación Aumentada (RAG) tubería con un ajuste fino modelo de lenguaje grande (LLM) para que Amazon D&C recupere de manera eficiente información precisa de un gran volumen de documentos desorganizados y brinde servicios oportunos y de alta calidad en sus proyectos de construcción. El equipo de Amazon D&C implementó la solución en una prueba piloto para ingenieros de Amazon y recopiló comentarios de los usuarios.

En esta publicación, compartimos cómo analizamos los datos de retroalimentación e identificamos las limitaciones de precisión y las alucinaciones proporcionadas por RAG, y utilizamos la puntuación de evaluación humana para entrenar el modelo a través de aprendizaje reforzado. Para aumentar las muestras de capacitación para un mejor aprendizaje, también utilizamos otro LLM para generar puntuaciones de retroalimentación. Este método abordó la limitación de RAG y mejoró aún más la calidad de la respuesta del bot. Presentamos el proceso de aprendizaje por refuerzo y los resultados de la evaluación comparativa para demostrar la mejora del desempeño del LLM. La solución utiliza JumpStart de Amazon SageMaker como el servicio principal para la implementación, el ajuste y el aprendizaje de refuerzo del modelo.

Recopile comentarios de los ingenieros de Amazon en un proyecto piloto

Después de desarrollar la solución descrita en Una solución generativa impulsada por IA en Amazon SageMaker para ayudar a Amazon EU Design and Construction, el equipo de Amazon D&C implementó la solución y ejecutó un proyecto piloto con ingenieros de Amazon. Los ingenieros accedieron al sistema piloto a través de una aplicación web desarrollada por iluminado, conectado con el oleoducto RAG. En el proceso utilizamos Servicio Amazon OpenSearch para la base de datos de vectores e implementó un modelo Mistral-7B-Instruct ajustado en Amazon SageMaker.

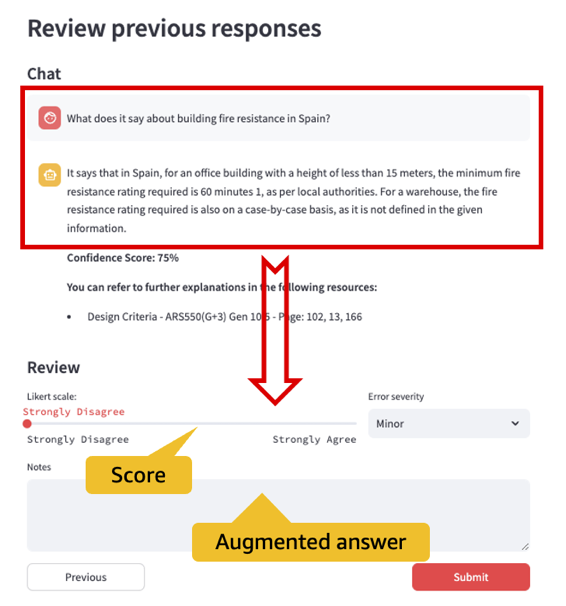

Uno de los objetivos clave del piloto es recopilar comentarios de los ingenieros de Amazon y utilizarlos para reducir aún más las alucinaciones LLM. Para lograr esto, desarrollamos un módulo de recopilación de comentarios en la interfaz de usuario, como se muestra en la siguiente figura, y almacenamos la información de la sesión web y los comentarios de los usuarios en Amazon DynamoDB. A través de la interfaz de usuario de recopilación de comentarios, los ingenieros de Amazon pueden seleccionar entre cinco niveles de satisfacción: totalmente en desacuerdo, en desacuerdo, neutral, de acuerdo y totalmente de acuerdo, correspondientes a las puntuaciones de comentarios del 1 al 5. También pueden proporcionar una mejor respuesta a la pregunta o comentar por qué la respuesta del LLM no es satisfactoria.

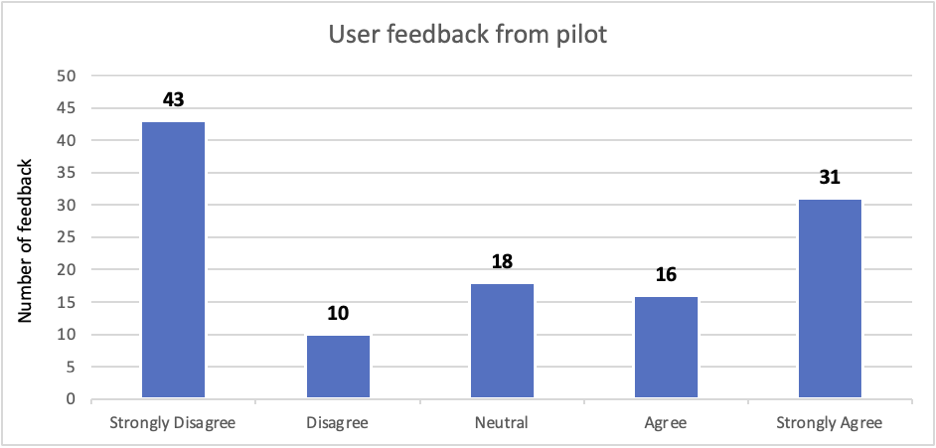

Durante el piloto, los usuarios proporcionaron 118 respuestas de retroalimentación. El siguiente gráfico muestra la distribución de negativo a positivo. Observamos que las respuestas incorrectas marcadas por la retroalimentación negativa (en desacuerdo y totalmente en desacuerdo) representan el 45% del total de retroalimentación (53 de 118). Algunos de los errores (alrededor del 10% de los comentarios negativos y el 7.5% de las respuestas generales) pueden solucionarse mediante educación del usuario e ingeniería rápida. Además, podemos abordar el problema con la solución de ajuste fino y aprendizaje por refuerzo de LLM, que se describe en la siguiente sección.

Algunos usuarios simplemente dejaron una nota como "¡Genial!" para las respuestas totalmente de acuerdo, o "No responde la pregunta", para las respuestas totalmente en desacuerdo. Otros usuarios proporcionaron puntuaciones y explicaron cómo justifican las respuestas del LLM en sus notas. En el siguiente ejemplo, el usuario proporcionó específicamente el documento y el contenido adecuados para corregir la alucinación LLM.

| Pregunta | ¿Cuántas plazas de aparcamiento tenemos? |

| Respuesta del robot |

Según el contexto dado, no tenemos suficiente información para determinar el número de plazas de aparcamiento. El contexto analiza el tamaño mínimo de las plazas de aparcamiento y los requisitos para los niveles de iluminación exterior, pero no proporciona un número específico de plazas de aparcamiento. **Puede consultar más explicaciones en los siguientes recursos:** *ARS GEN 10.0/05.01.02. Criterios de diseño y apéndices/Paquete de rendimiento AR Sortable Design Criteria v20.1.1.pdf – página: 10 *ARS GEN 10.0/05.01.02. Criterios de diseño y apéndices/Paquete de rendimiento AR Sortable Design Criteria v20.1.1.pdf – página: 79 |

| Puntuación del usuario | Muy en desacuerdo |

| Notas de usuario | Esto se especifica en la página 21 de la sección de criterios de diseño 01 13 10. |

Mejore la respuesta del bot con ajuste supervisado y aprendizaje de refuerzo

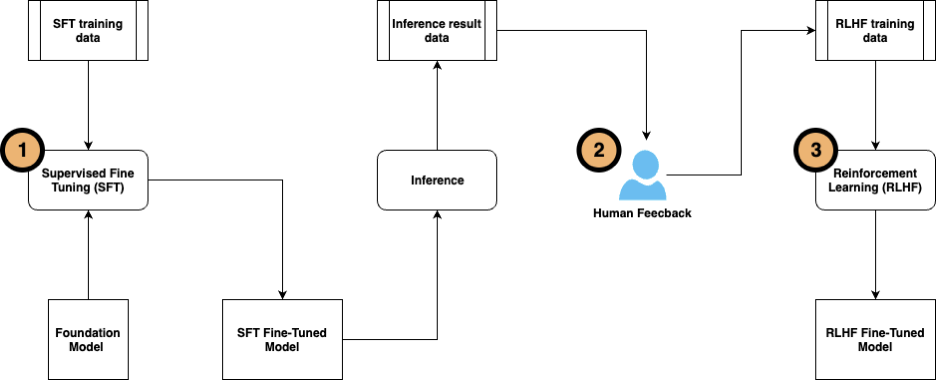

La solución consta de tres pasos de ajuste:

- Realice ajustes supervisados utilizando datos etiquetados. Este método fue descrito en Una solución generativa impulsada por IA en Amazon SageMaker para ayudar a Amazon EU Design and Construction.

- Recopile comentarios de los usuarios para etiquetar los pares de preguntas y respuestas para realizar más ajustes en el LLM.

- Cuando los datos de entrenamiento estén listos, ajuste aún más el modelo usando aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF).

RLHF se utiliza ampliamente en aplicaciones de inteligencia artificial generativa (IA) y LLM. Incorpora retroalimentación humana en la función de recompensas y entrena el modelo con un algoritmo de aprendizaje por refuerzo para maximizar las recompensas, lo que hace que el modelo realice tareas más alineadas con los objetivos humanos. El siguiente diagrama muestra el proceso de los pasos.

Probamos la metodología utilizando los documentos de Amazon D&C con un modelo Mistral-7B en SageMaker JumpStart.

Ajuste supervisado

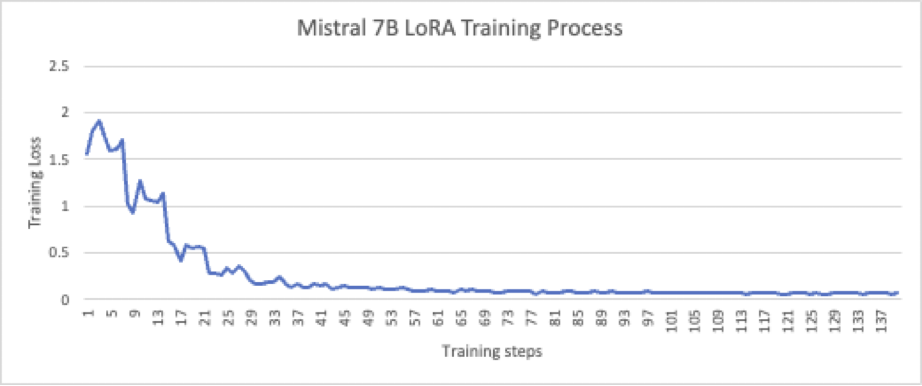

En la publicación anterior, demostramos cómo el modelo Falcon-7B optimizado supera al proceso RAG y mejora la calidad y precisión de la respuesta del bot de control de calidad. Para esta publicación, realizamos un ajuste supervisado en el modelo Mistral-7B. El ajuste fino supervisado utilizó la técnica PEFT/LoRA (LoRA_r = 512, LoRA_alpha = 1024) en 436,207,616 parámetros (5.68% del total de 7,677,964,288 parámetros). El entrenamiento se realizó en un nodo p3.8x con 137 muestras generadas sintéticamente por LLM y validadas por humanos; el proceso converge bien después de 20 épocas, como se muestra en la siguiente figura.

El modelo ajustado fue validado por 274 muestras y los resultados de la inferencia se compararon con las respuestas de referencia mediante la puntuación de similitud semántica. La puntuación es 0.8100, que es superior a la puntuación de 0.6419 del RAG tradicional.

Recopile comentarios humanos y de IA para el aprendizaje reforzado

Para RLHF, es esencial una cantidad suficiente de muestras de formación de alta calidad etiquetadas por expertos en la materia (PYME). Sin embargo, las etiquetas humanas de mala calidad probablemente provocarán un peor rendimiento del modelo que el modelo original después del entrenamiento RLHF. El momento de las PYMES es Un recurso escaso en cualquier organización.; revisar cientos o miles de respuestas de LLM y brindar comentarios requiere una inversión de tiempo significativa por parte de las PYME que pueden no tener un retorno de la inversión claro.

Para abordar este desafío, adoptamos la Aprendizaje reforzado a partir de la retroalimentación de la IA. (RLAIF) método. RLAIF emplea un asistente de IA (otro LLM) para proporcionar puntuaciones de evaluación, en lugar de humanos. En este enfoque de aprendizaje híbrido, el agente de aprendizaje refina las acciones no solo en función de la interacción con un ser humano sino también de la retroalimentación proporcionada por otro modelo de IA. Es mucho más escalable proporcionar suficientes datos de capacitación para el aprendizaje por refuerzo, y mucho menos subjetivo porque la capacitación no depende de preferencias particulares de un pequeño grupo de PYME. Es posible que las PYME sigan participando, pero sólo para supervisar el proceso y examinar la calidad de la retroalimentación de la IA. Esto reduce enormemente la carga de trabajo de las PYME, porque las puntuaciones y etiquetas generadas por IA son mucho menos complicadas de analizar, filtrar y clasificar para las PYME.

En este caso de uso, proporcionamos el siguiente mensaje a un modelo Anthropic Claude 2 para generar las puntuaciones de evaluación como muestras de entrenamiento para el paso de aprendizaje por refuerzo:

El modelo Claude 2 genera una puntuación de evaluación y un comentario sobre por qué se otorga la puntuación, como se muestra en el siguiente ejemplo.

| Pregunta | ¿Qué se entiende por "Fit Out Works" en este contexto? |

| Respuesta de referencia | Los trabajos de acondicionamiento se refieren a los trabajos realizados en virtud del contrato de construcción por o en nombre de Amazon a través del Desarrollador hasta la primera fecha de recepción desde una posición de construcción de base y estructura básica del Desarrollador ficticio. Estos trabajos incluyen los equipamientos requeridos por Amazon, instalaciones de grandes dimensiones y diseños personalizados. |

| Respuesta del robot de control de calidad | Los trabajos de acondicionamiento se refieren a los trabajos realizados en virtud del contrato de construcción por o en nombre de Amazon a través del Desarrollador hasta la primera fecha de recepción desde un puesto de construcción de base y estructura principal del Desarrollador ficticio. |

| puntuación de IA | 4.5 |

| comentario de IA | La respuesta automática proporciona la información clave de la respuesta estándar: que Fit Out Works se refiere a trabajos realizados en virtud del contrato de construcción por o en nombre de Amazon a través del Desarrollador hasta la primera fecha de recepción desde un puesto de construcción de base y carcasa de desarrollador nocional. . Los detalles adicionales sobre la inclusión de los ajustes, las instalaciones grandes y las personalizaciones requeridas por Amazon son relevantes y ayudan a proporcionar más contexto, por lo que califiqué la respuesta automática con 4.5 sobre 5. Capta la esencia de la respuesta estándar y proporciona algunas Detalles adicionales útiles. |

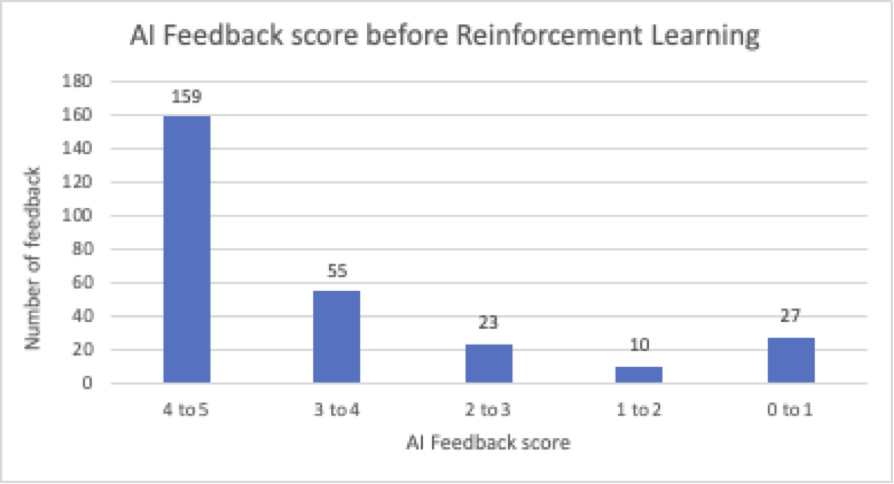

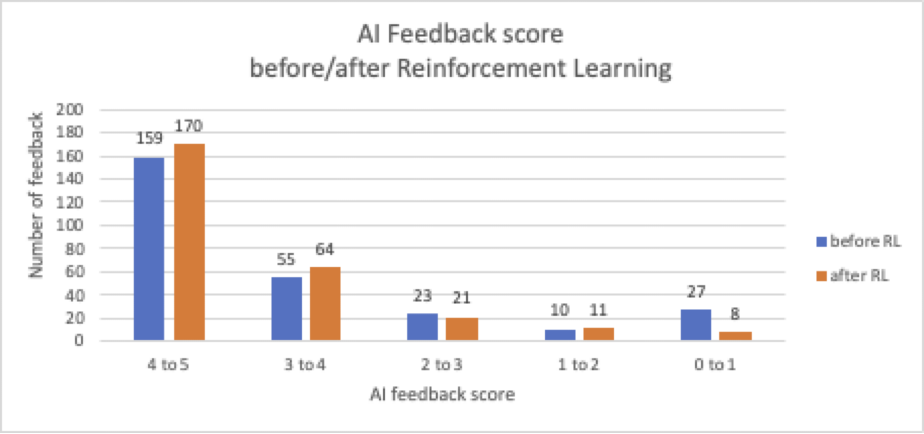

De las 274 preguntas de validación, el modelo supervisado y ajustado generó 159 respuestas con puntuaciones de IA superiores a 4. Observamos 60 respuestas con puntuaciones inferiores a 3; hay espacio para mejorar la calidad general de la respuesta.

Las pymes de ingeniería de Amazon validaron estos comentarios de IA y reconocieron los beneficios de utilizar puntuaciones de IA. Sin retroalimentación de IA, las PYMES necesitarían algo de tiempo para revisar y analizar cada respuesta del LLM para identificar las respuestas límite y las alucinaciones, y para juzgar si el LLM está devolviendo contenidos y conceptos clave correctos. La retroalimentación de IA proporciona puntuaciones de IA automáticamente y permite a las PYMES utilizar filtrado, clasificación y agrupación para validar las puntuaciones e identificar tendencias en las respuestas. Esto reduce el tiempo promedio de revisión de una PYME en un 80%.

Aprendizaje reforzado a partir de comentarios humanos y de IA

Cuando las muestras de entrenamiento estén listas, usamos el Algoritmo de optimización de políticas próximas (PPO) para realizar aprendizaje por refuerzo. PPO utiliza un método de gradiente de políticas, que toma pequeños pasos para actualizar la política en el proceso de aprendizaje, de modo que los agentes de aprendizaje puedan alcanzar de manera confiable la red de políticas óptima. Esto hace que el proceso de formación sea más estable y reduce la posibilidad de divergencia.

Durante el entrenamiento, primero utilizamos los datos etiquetados por humanos y por IA para construir un modelo de recompensa, que se utilizará para guiar la actualización de los pesos en el proceso de aprendizaje. Para este caso de uso, seleccionamos un modelo de recompensa basado en distilroberta y lo entrenamos con muestras en el siguiente formato:

[Instruction, Chosen_response, Rejected_response]

El siguiente es un ejemplo de un registro de capacitación.

| Instrucción | Según el contexto, ¿qué se especifica para un diseño inclusivo y accesible? |

| Respuesta_elegida | Crédito BREEAM HEA06 – diseño inclusivo y accesible – El edificio está diseñado para ser adecuado a su propósito, apropiado y accesible para todos los usuarios potenciales. Se desarrolla una estrategia de acceso de acuerdo con la lista de verificación A3 de BREEAM. |

| Respuesta_rechazada | El contexto afirma que |

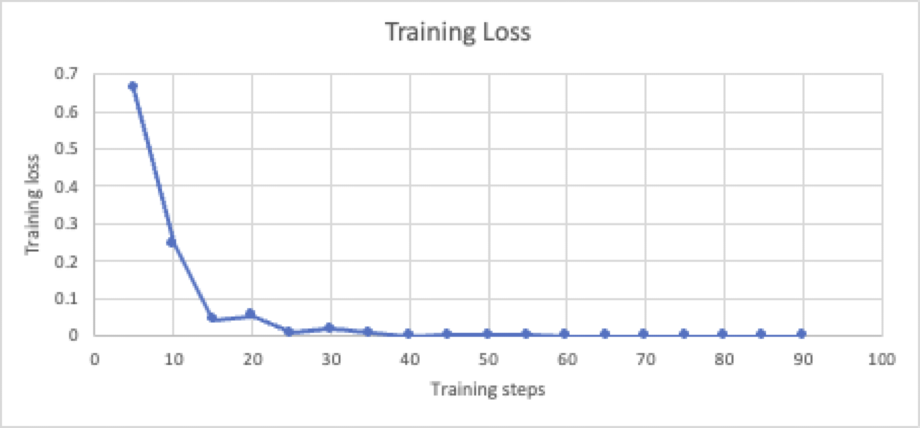

El modelo de recompensa se entrena con una tasa de aprendizaje de 1e-5. Como se muestra en el siguiente gráfico, el pozo de entrenamiento converge después de 10 épocas.

Luego, el modelo de recompensa se utiliza para el aprendizaje por refuerzo. Para este caso de uso, utilizamos PEFT/LoRA para acelerar el aprendizaje. LoRA_r es 32 y LoRA_alpha es 64. El aprendizaje basado en PPO tiene una tasa de 1.41e-5 en tres épocas. El entrenamiento de refuerzo es muy volátil y muy sensible a los datos de la etiqueta y los datos de retroalimentación. Usamos la métrica de recompensa_media, la recompensa promedio obtenida del entorno al monitorear específicamente el modelo de recompensa, para observar el proceso de aprendizaje.

Después de RLAIF, podemos ver que la cantidad de respuestas de bot con puntuaciones positivas (por encima de 3) aumenta del 78.1 % al 85.5 %, y aquellas con puntuaciones negativas (por debajo de 3) disminuyen del 21.9 % al 14.5 %. En total, la puntuación media de la retroalimentación de la IA aumenta hasta un 8%, de 3.9 a 4.2.

Puedes ver la mejora en el siguiente ejemplo.

| Pregunta | Para el revestimiento del suelo, ¿qué solera se necesita? |

| Referencia | Los pisos de solera de concreto se aplican solo en áreas con pisos embaldosados. Consulte la serie de dibujos A-32 para ver dónde se aplican las losas. |

| Respuesta del bot ante RLAIF | Los pisos de solera de concreto se aplican solo en |

| Puntuación de IA antes del RLAIF | 3 |

| Respuesta del bot después de RLAIF | Los pisos de solera de concreto se aplican solo en áreas que se van a revestir con baldosas. Consulte la serie de dibujos A-32 para ver dónde se pueden aplicar pisos de baldosas. |

| Puntuación de IA después de RLAIF | 4.5 |

Conclusión

Esta publicación es una continuación de nuestro trabajo con el equipo de diseño y construcción de Amazon UE como se analiza en Una solución generativa impulsada por IA en Amazon SageMaker para ayudar a Amazon EU Design and Construction. En esta publicación, mostramos cómo generamos datos de retroalimentación humana y de IA para ajustar el modelo Mistral-7B con aprendizaje por refuerzo. El modelo posterior a RLAIF proporcionó un mejor rendimiento para el robot de respuesta a preguntas de Amazon Engineering y mejoró la puntuación de comentarios de IA en un 8 %. En el proyecto piloto del equipo de Amazon D&C, el uso de RLAIF redujo la carga de trabajo de validación para las pymes en aproximadamente un 80 %. Como siguiente paso, ampliaremos esta solución conectándonos con la infraestructura de datos de Amazon Engineering y diseñaremos un marco para automatizar el proceso de aprendizaje continuo con un ser humano al tanto. También mejoraremos aún más la calidad de los comentarios de la IA ajustando la plantilla de mensajes.

A través de este proceso, aprendimos cómo mejorar aún más la calidad y el desempeño de las tareas de respuesta a preguntas a través de RLHF y RLAIF.

- La validación y el aumento humanos son esenciales para proporcionar resultados precisos y responsables de LLM. La retroalimentación humana se puede utilizar en RLHF para mejorar aún más la respuesta del modelo.

- RLAIF automatiza el ciclo de evaluación y aprendizaje. La retroalimentación generada por la IA es menos subjetiva porque no depende de una preferencia particular de un pequeño grupo de PYME.

- RLAIF es más escalable para mejorar la calidad del bot a través del aprendizaje de refuerzo continuo y al mismo tiempo minimizar los esfuerzos requeridos por parte de las PYME. Es especialmente útil para desarrollar soluciones de IA generativa de dominios específicos dentro de grandes organizaciones.

- Este proceso debe realizarse de forma regular, especialmente cuando hay nuevos datos de dominio disponibles para ser cubiertos por la solución.

En este caso de uso, utilizamos SageMaker JumpStart para probar varios LLM y experimentar con múltiples enfoques de capacitación de LLM. Acelera significativamente el ciclo de aprendizaje y retroalimentación de la IA con eficiencia y calidad maximizadas. Para su propio proyecto, puede introducir el enfoque humano en el circuito para recopilar los comentarios de sus usuarios o generar comentarios de IA utilizando otro LLM. Luego puede seguir el proceso de tres pasos definido en esta publicación para ajustar sus modelos usando RLHF y RLAIF. Recomendamos experimentar con los métodos que utilizan SageMaker JumpStart para acelerar el proceso.

Sobre la autora

Yunfeibai es arquitecto sénior de soluciones en AWS. Con experiencia en IA/ML, ciencia de datos y análisis, Yunfei ayuda a los clientes a adoptar los servicios de AWS para obtener resultados comerciales. Diseña soluciones de análisis de datos y AI/ML que superan desafíos técnicos complejos e impulsan objetivos estratégicos. Yunfei tiene un doctorado en Ingeniería Electrónica y Eléctrica. Fuera del trabajo, Yunfei disfruta de la lectura y la música.

Yunfeibai es arquitecto sénior de soluciones en AWS. Con experiencia en IA/ML, ciencia de datos y análisis, Yunfei ayuda a los clientes a adoptar los servicios de AWS para obtener resultados comerciales. Diseña soluciones de análisis de datos y AI/ML que superan desafíos técnicos complejos e impulsan objetivos estratégicos. Yunfei tiene un doctorado en Ingeniería Electrónica y Eléctrica. Fuera del trabajo, Yunfei disfruta de la lectura y la música.

Elad Dwek es gerente de tecnología de la construcción en Amazon. Con experiencia en construcción y gestión de proyectos, Elad ayuda a los equipos a adoptar nuevas tecnologías y procesos basados en datos para ejecutar proyectos de construcción. Identifica necesidades y soluciones, y facilita el desarrollo de atributos personalizados. Elad tiene un MBA y una licenciatura en Ingeniería Estructural. Fuera del trabajo, Elad disfruta del yoga, la carpintería y viajar con su familia.

Elad Dwek es gerente de tecnología de la construcción en Amazon. Con experiencia en construcción y gestión de proyectos, Elad ayuda a los equipos a adoptar nuevas tecnologías y procesos basados en datos para ejecutar proyectos de construcción. Identifica necesidades y soluciones, y facilita el desarrollo de atributos personalizados. Elad tiene un MBA y una licenciatura en Ingeniería Estructural. Fuera del trabajo, Elad disfruta del yoga, la carpintería y viajar con su familia.

Luca Cerabone es Ingeniero de Inteligencia de Negocios en Amazon. Partiendo de su experiencia en ciencia y análisis de datos, Luca crea soluciones técnicas personalizadas para satisfacer las necesidades únicas de sus clientes, impulsándolos hacia procesos más sostenibles y escalables. Armado con una Maestría en Ciencias de Datos, Luca disfruta participar en proyectos de bricolaje, jardinería y experimentar con delicias culinarias en sus momentos de ocio.

Luca Cerabone es Ingeniero de Inteligencia de Negocios en Amazon. Partiendo de su experiencia en ciencia y análisis de datos, Luca crea soluciones técnicas personalizadas para satisfacer las necesidades únicas de sus clientes, impulsándolos hacia procesos más sostenibles y escalables. Armado con una Maestría en Ciencias de Datos, Luca disfruta participar en proyectos de bricolaje, jardinería y experimentar con delicias culinarias en sus momentos de ocio.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://aws.amazon.com/blogs/machine-learning/improve-llm-performance-with-human-and-ai-feedback-on-amazon-sagemaker-for-amazon-engineering/